线性代数基础

编辑日期: 2024-07-14 文章阅读: 次

了解矩阵和向量运算

线性代数是神经网络和深度学习的基础。

理解矩阵和向量的运算对于构建和优化神经网络至关重要。

本节课将介绍矩阵和向量的基本概念及其运算。

矩阵和向量的基本概念

-

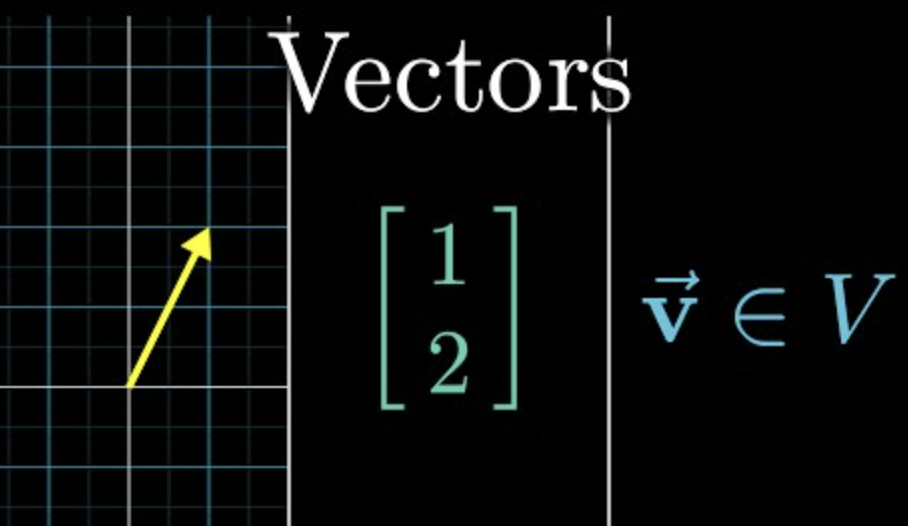

向量(Vector):向量是一个具有大小和方向的量,通常表示为一列或一行数。例如,二维向量可以表示为 \([x, y]\),三维向量表示为 \([x, y, z]\)。

-

矩阵(Matrix):矩阵是一个由行和列组成的二维数组,可以看作是多个向量的集合。例如,一个 \( m \times n \) 的矩阵有 \( m \) 行和 \( n \) 列。

矩阵和向量的运算

向量运算

-

加法和减法:向量的加法和减法是逐元素操作。例如,向量 \([a, b]\) 和向量 \([c, d]\) 的加法结果是 \([a+c, b+d]\)。

-

标量乘法:向量与标量的乘法是将向量的每个元素乘以该标量。例如,标量 \( k \) 和向量 \([a, b]\) 的乘法结果是 \([ka, kb]\)。

矩阵运算

-

矩阵加法和减法:与向量相似,矩阵的加法和减法也是逐元素操作。两个矩阵必须具有相同的维度。

-

矩阵乘法:矩阵乘法不是逐元素操作,而是行与列的内积。矩阵 \( A \) 的第 \( i \) 行与矩阵 \( B \) 的第 \( j \) 列的内积形成矩阵 \( C \) 的第 \( i, j \) 个元素。

-

转置矩阵:矩阵 \( A \) 的转置矩阵 \( A^T \) 是将 \( A \) 的行与列交换得到的矩阵。

-

单位矩阵:单位矩阵是一个对角线为 1,其余元素为 0 的方阵,在矩阵乘法中起到类似数字 1 的作用。

实际应用

-

神经网络中的权重矩阵:在神经网络中,输入与权重矩阵相乘生成输出,理解矩阵运算可以帮助我们优化和训练网络。

-

图像处理:在计算机视觉中,图像可以表示为矩阵,通过矩阵运算进行图像变换和滤波等处理。

参考资料

通过学习矩阵和向量的基本运算,我们为深入理解和应用神经网络奠定了坚实的数学基础。

下一节

点击下方卡片,继续学习: