腾讯推出开源的轻量级6G显存DiT文生图大模型,同时开放标注模型,仅提供中文回复。

编辑日期:2024年07月04日

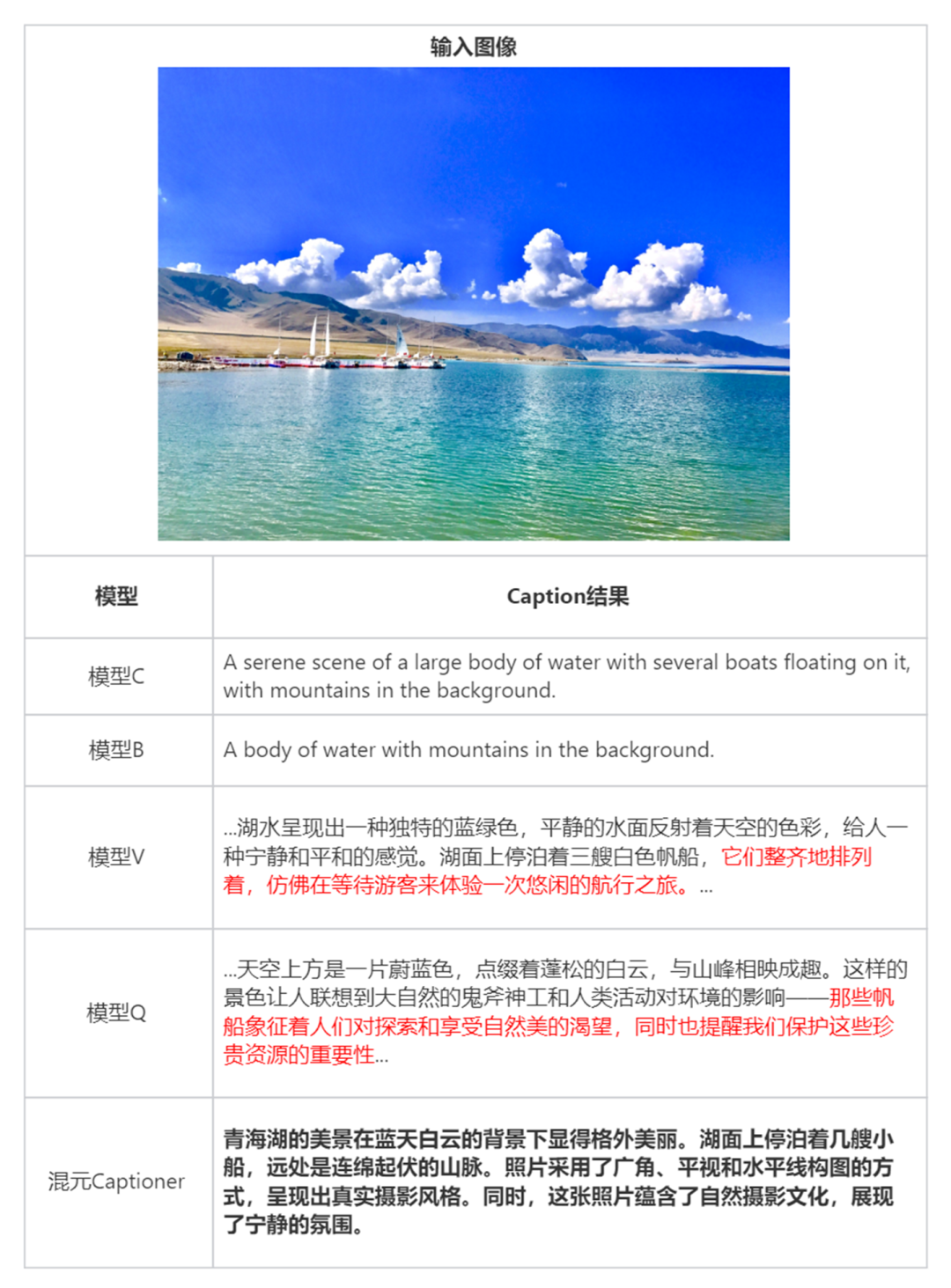

腾讯已公开其创新的双语图文标注模型“混元 Captioner”,该模型专注于提升文生图场景的表现,并对中文和英文都提供了支持。这一开源举措将助力开发者更高效地构建文生图数据集。

腾讯的混元 DiT 模型近日发布重要更新:包括推出内存优化的小型化版本和全新的Kohya训练界面,同时将模型升级到1.2版本。这些改进旨在简化使用流程,减少技术门槛,并显著提升图像处理的质量。

利用DiT架构构建的文生图模型能生成更高质量的图像,不过这需要庞大的显存支持。为此,混元DiT推出了低显存版本,仅需6G显存就能运行其优化的推理框架,这对于在个人电脑上进行本地部署的开发者来说十分便捷。

现已成功将小内存版、LoRA 和 ControlNet 插件整合到 Diffusers 库,通过与 Hugging Face 的协作。开发者无需接触源代码,仅需寥寥三行就能轻松调用,大大降低了使用难度。

此外,混元 DiT 还透露已整合 Kohya,这样一来,开发者能够轻松构建自己的 LoRA 模型,降低了入门难度。

Kohya是一款开源的轻量级模型微调平台,它配备了直观的图形用户界面,尤其在训练扩散模型和文生图模型领域中广泛应用。

用户能够借助图形化界面轻松地进行模型的全方位参数优化和 LoRA 训练,无需深入理解编程细节。完成训练的模型适应于 Kohya 生态体系,能够以低整合成本与 WebUI 等推断界面无缝配合,形成从“训练”到“生成图表”的完整工作流程。

腾讯混元团队近期推出了一款新开放源代码的标注模型——混元Captioner,它在优化用户体验的同时,也极大地提升了模型的易用性。

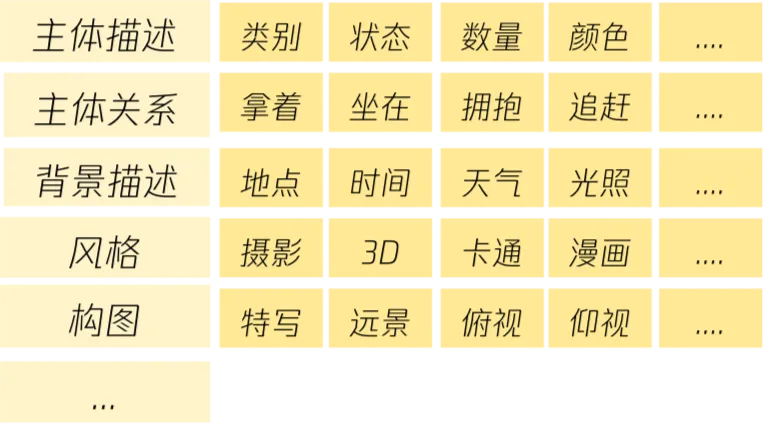

开发人员能够借助标注模型高效地创建数据集。具体而言,对于图文生成的开发者,他们能够把原始图像集合输入到混元 Captioner,该工具会自动生成相应的标注。此外,也可以上传图片及其初始描述,混元 Captioner 会智能地去除无关信息,同时改进和优化图像描述,以此提升数据的质量。

当前,图像解说文本的生成领域普遍依赖于通用的多模态Captioner模型,但这类模型常存在描述不恰当的问题,要么过于简洁,要么包含过多与图像主题不相关的细节。此外,它们往往缺乏足够的背景知识,因此无法准确识别出知名人物和地标。更重要的是,很多模型并非针对中文设计,导致中文描述的精确度不足。

Captioner 模型被特别设计和优化以适应文本生成图像的场景。

以下是关于腾讯混元开源文生图大模型的相关链接:

以上全文,欢迎继续阅读学习

大家在看