首度公开亮相!无问芯穹推出前所未有的千卡级异构芯片集成训练平台

编辑日期:2024年07月05日

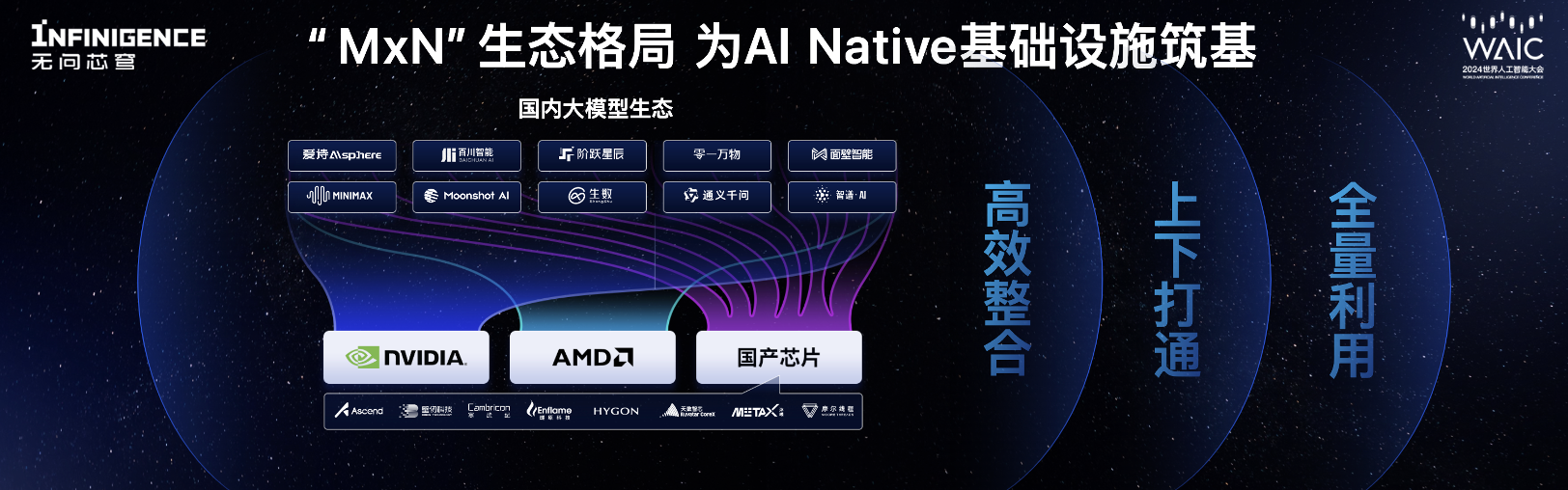

在2024年世界人工智能大会的AI基础设施研讨会上,无问芯穹的联合创始人及CEO夏立雪推出了创新的全球首例千卡级异构芯片混训系统,该系统能将异构混合训练集群的计算力利用率提升至97.6%。此外,夏立雪还宣布无问芯穹的Infini-AI云端平台已整合了大模型的千卡级异构混训功能,成为全球首个支持单一任务下千卡规模异构芯片混合训练的平台,并具有扩展至万卡的能力。该平台兼容AMD、华为昇腾、天数智芯、沐曦、摩尔线程和NVIDIA六种不同架构的芯片,用于大模型的混合训练。自7月起,经过试用申请的用户可以在Infini-AI平台上轻松启动包含700亿参数的大型模型训练。

四个月以前,无问芯穹的Infini-AI大模型开发与服务平台揭开公测序幕,吸引了智谱AI、月之暗面、生数科技等知名大模型企业在此稳定运用异构计算能力。此外,超过20家AI创新公司持续在Infini-AI上调用预设模型API,借助该平台的工具集构建自身的业务模型。此番推出全球首例支持千卡级别异构芯片混合训练的平台,彰显了无问芯穹在异构计算优化和集群系统设计领域的深厚技术和卓越能力,也是其践行“MxN”中间层生态理念的重要里程碑。

训练和推理作为大模型生命周期中的关键环节,都离不开强大的计算资源。中国在模型层和芯片层的态势呈现出更为“多样化”的特点,与国际上的集中趋势形成对比。然而,众多的异构芯片也制造了“生态隔阂”,不同的硬件生态系统各自封闭,互不相通,这给计算力使用者带来了严峻的技术难题。

据统计,中国的超大规模算力集群数量已超过一百,这些集群正逐步从同质化转向多元化,以减轻对单一硬件平台的过度依赖和应对供应链风险。国产芯片性能的迅速提升为集群提供了更多选择。然而,存在的“生态竖井”障碍使得多数企业和开发者难以充分利用这些算力资源,导致了算力的浪费。这种现象已成为建立AI原生基础设施的关键难题,并加剧了当前大型模型行业面临的“算力短缺”问题。

为了适应多样化的模型和芯片环境,一个理想的解决方案是构建一个能够高效整合异构算力资源的平台,并提供支持软硬件协同优化的中间件,以将异构芯片转化为强大的计算力。这一创新背后的驱动力源于无问芯穹研发团队在异构芯片计算优化和集群系统设计方面的深厚实力。最近,无问芯穹携手清华大学和上海交通大学的研究团队推出了HETHUB,这是一个开创性的异构分布式混合训练系统,适用于大规模模型,首次实现了六种不同品牌芯片的交叉混合训练,并具有高度的工程化成熟度。据夏立雪介绍,该技术的工程化目标是整合异构算力,不断提升大型模型的技术潜力,同时通过打破芯片生态壁垒,降低大型模型实际应用的成本。

当前,大型语言模型行业正迈入大规模产业应用的新阶段,多样化的应用场景催生了对模型训练的急切需求,广阔的市场潜力促使基础模型和计算芯片领域的竞争者迅速增加。建立适应大模型时代的人工智能原生基础设施,对于为AI开发者提供更普适、高效且易用的开发平台至关重要,同时也是整合计算资源、保障AI产业持续发展的基石。

无问芯穹凭借其卓越的AI计算优化能力和算力解决方案,以及对多模态模型和多种芯片行业趋势的洞察,率先打造了一个“MxN”架构的生态系统,实现了各种大模型算法在不同芯片上的高效一致部署。至今,Infini-AI已支持包括Qwen2、GLM4、Llama3、Gemma、Yi、Baichuan2、ChatGLM3系列等超过30个模型,以及AMD、华为昇腾、壁仞、寒武纪、燧原、海光、天数智芯、沐曦、摩尔线程、NVIDIA等十多种计算卡。

我们矢志成为AI原生基础设施的先锋,将持续挑战异构计算效率与集群系统架构的技术边界,不断强化在模型层和芯片层的生态系统合作,携手共创“MxN”深度融合、运用和协同的新格局。我们将打造一个真正适用于多元模型和芯片的AI原生基础设施,消除AI计算的使用难题,推动大模型在各个行业的创新应用。

技术的极限挑战与技术普及并不冲突,这完全取决于我们对技术的态度。正如夏立雪所言,如今谈论使大模型的成本降低一万倍,就如同三十年前设想每个家庭都能用上电一样具有革命性。优质的基础设施就像施展魔法一般,一旦其边际成本降至关键点,新技术将被更广泛地接纳和应用。

近期,《独立报》对苹果公司的三位高层管理人员进行了独家专访。

当前,传统芯片巨头如英特尔和英伟达正面临着来自特斯拉、依图等跨界竞争者的强劲挑战。

四年磨一剑,百度网盘迎来史无前例的全新升级!

清华与智谱人工智能联合发布

如今,就连人工智能的情感智商似乎都超越我了

真的能在两到三年内实现吗?

以上全文,欢迎继续阅读学习