智能慢思考演进至快速思考,Llama2已提升至与GPT4相当的层次,无需详述步骤,也能准确解答问题。

编辑日期:2024年07月12日

"慢思考"优化"快模型"的智慧借鉴

Meta巧妙地运用了《思考快与慢》中描绘的人类双模式思考。他们通过将AI的深思熟虑过程(慢思考)融入快速决策(快思考),使得Llama2的性能提升了257%,超越了GPT4,并降低了推理成本。

形象地说,这种快慢思考对应于丹尼尔·卡尼曼的系统1和系统2理论——系统1代表直观且快速的无意识反应,而系统2则涉及复杂、有意识的逻辑推理,确保更高的准确性。

Meta的“蒸馏”技术模拟了这一过程,利用系统2产生数据,然后调整基于系统1的模型。正如网友所观察到的,这种方式与人类的学习经验相似:一旦解决了复杂问题,处理类似问题就会变得相对容易。

在大型模型中,模拟系统2的方法多种多样,应用环节也各有不同。研究者探索了四种不同的途径。尽管具体方法各异,但核心都是在未标记的数据集上生成推理结果。模型在提供答案的同时,会记录详细的推理步骤,但最终只保存输出结果。由此形成的输入-系统2输出数据对,可被视为无监督学习的“伪标签”。收集这些数据对,就构成了初步的蒸馏数据集。

然而,这些数据并不能直接用于微调系统1模型,需先进行质量筛选。过滤标准基于一致性与鲁棒性,以确保数据的质量。

在一致性验证过程中,每个输入样本会触发系统2模型产生多个输出,接着通过多数决等策略对比这些输出,只有当大部分结果相同,才会认为该输出具备可靠性。而鲁棒性检验则是对输入样本施加轻微变化,如改动不相关细节或调整语序,以此观察系统2在变化前后的输出是否保持一致。

经过筛选的高质量精炼数据可用于无监督微调系统1模型。

微调过程可类比为知识蒸馏,但与传统方式有别,这里的两个系统共享同一基础模型。系统1旨在直接模仿系统2的输出行为,而非学习其复杂的推理过程,后续操作中可直接产生输出,无需执行系统2的推理步骤。

尽管如此,系统1的输出质量仍能逼近系统2,实现了系统2功能向系统1的迁移。

那么为何要特地获取数据来微调系统1,而不直接利用系统2推理?作者给出了理由。

答案其实显而易见,从系统2的“慢系统”别称即可看出:由于其速度缓慢,对于实时交互和移动设备部署等场景,其延迟可能无法容忍。

此外,系统2需提供完整的推理路径,导致其输出的token长度远超系统1,可能是后者的数百倍。

正如先前网友所述,系统2负责复杂推理,简化后的数据再交给系统1,问题对系统1而言就变得更为简单。

实践表明,这种模式显著提升了系统1的性能,甚至超越了原始的系统2模型。

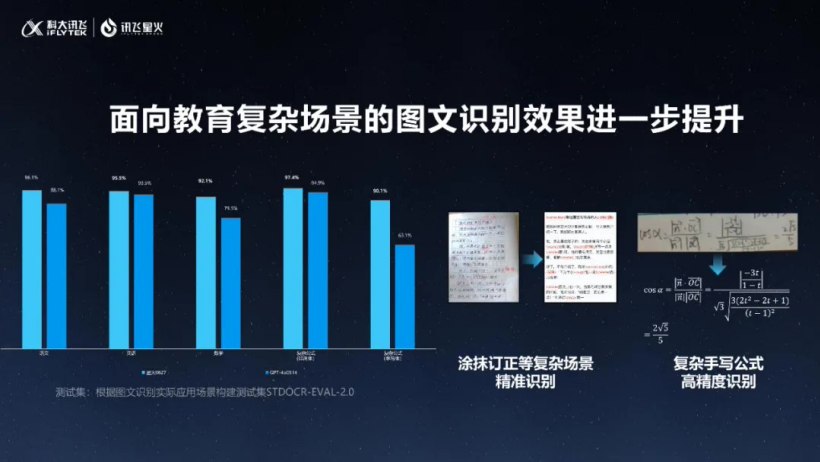

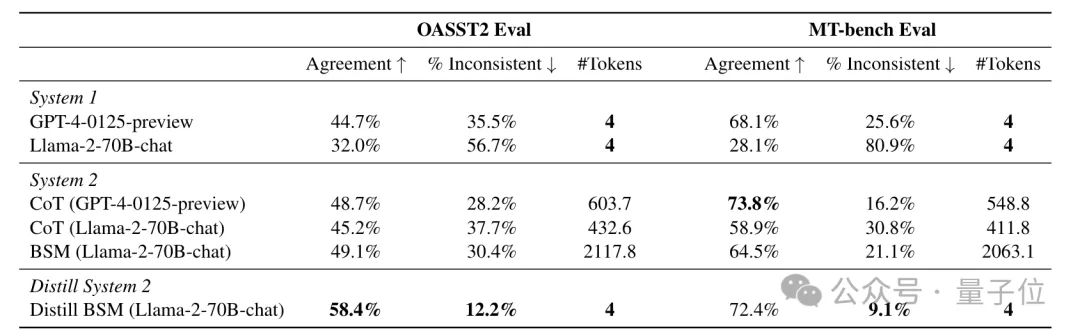

对于四种不同的系统2方法,研究者使用各自特定的数据集,在多种任务上进行了测试。以BSM方法为例,作者选取了Open Assistant 2和MT-bench数据集,评估了模型作为“评判者”的效能。

观察到的结果表明,Llama-2在两个数据集上的人类一致性显著提升,从原来的32.0%和28.1%跃升至58.4%和72.4%,增长幅度最高可达257%,表现出比CoT方法更强的效能。经过微调后,该模型超越了GPT-4的系统1版本,甚至堪比采用CoT的GPT-4。

同时,调整选项布局后,不一致性的现象显著减缓,而且与系统2对比,使用的Token数量微乎其微,几乎可以忽略。

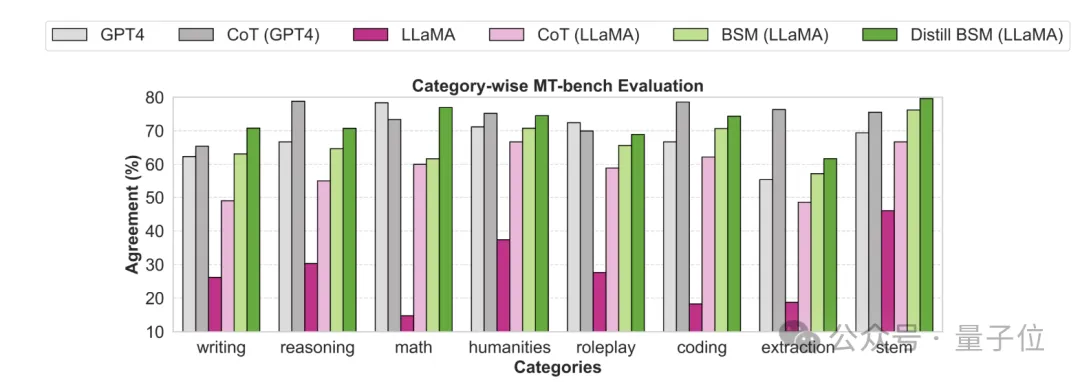

针对MT-Bench的不同子任务,作者还详细分析了各种方法下的人类一致性表现。

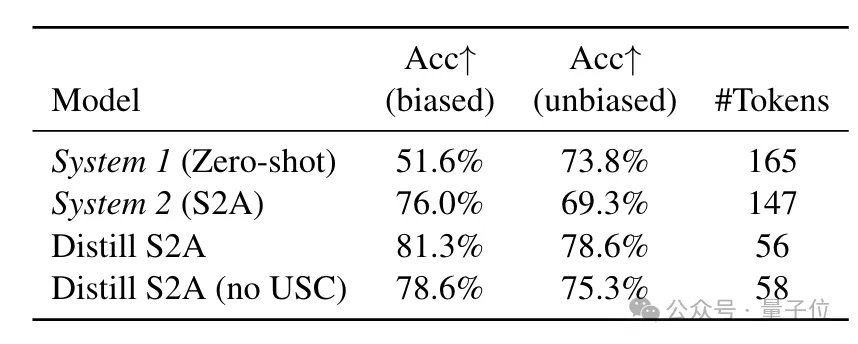

接着是S2A方法,专注于解决模型偏见问题。在有偏见的TriviaQA任务中,蒸馏后模型的准确率提升至81.3%,超过原始S2A的76%,Token数量也从147个缩减至56个。

最后,RaR方法的测试集中在推理任务上,包括Last letter concatenation和Coin flip。在Letter任务中,模型的准确率从30%激增到98%,优于自蒸馏的系统1(69.5%)和原始RaR方法。在Coin flip任务中,蒸馏后模型的准确率达到75.69%,接近2步原始RaR的77.2%,但Token数量显著减少。

研究发现,概念思维(CoT)的蒸馏过程在转换为快速思考模式时,与其它方法的效果显著不同。具体来说,CoT在数学推理任务上的表现未能有效地转移到直觉型的系统1中。在GSM8K数据集的评估中,经过蒸馏的模型在k=1时准确度仅为7.13%,即使在k=10时也仅提升到7.35%,这甚至不如同样未经过蒸馏的初始模型。

因此,研究者指出,未来的重点应在于深入探索适宜应用蒸馏技术的情境,并寻找更贴近人类学习方式的策略。论文详细信息可在此查阅:https://arxiv.org/abs/2407.06023。相关讨论可见:https://x.com/emollick/status/1810659417634869610。

此外,优化过程如采用中间填充功能和将大型模型视作创新引擎,被证明比从零开始训练更为高效。这一方法获得了广泛的认可,例如GitHub项目已有4.8k星。

利用Rust语言与JAX框架构建的先进技术,我们已实现从深思熟虑到敏捷决策的转变,Llama2项目引领这一革新。首批合作伙伴名单现已公布。

大家在看