训练模型的费用变得越来越亲民,前特斯拉人工智能部门总监在短短24小时内以672美元的低廉成本成功“复制”了GPT-2。

编辑日期:2024年07月13日

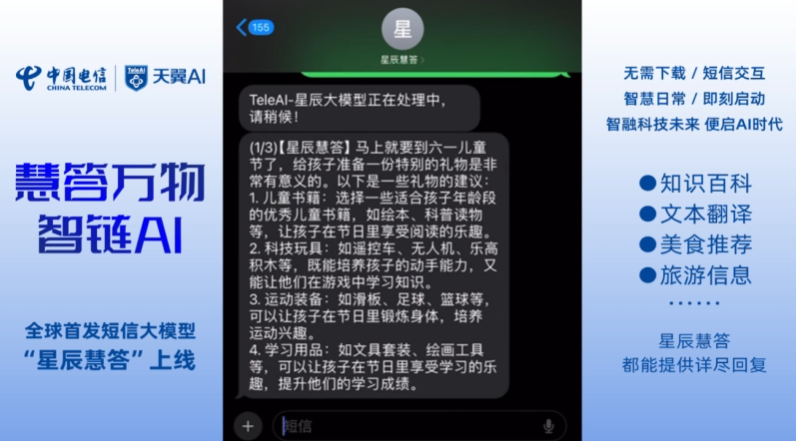

据最新消息,知名人工智能专家、曾任特斯拉AI总监和OpenAI联合创始人的Andrej Karpathy运用llm.c平台成功复刻了GPT-2模型,此举将成本降至每小时仅28美元,折合人民币约204元,相较于五年之前,成本下降幅度高达90%。

成本下降的关键在于采用了单一的 8XH100 节点进行训练。Andrej Karpathy 描述,llm.c 直接内置了 GPT 的训练功能。“因为 llm.c 是用 C/CUDA 语言直接编写的 GPT 训练程序,所以它的系统需求极低——不需要 conda 环境、Python 解释器或通过 pip 安装。你只需要启动一个云端 GPU 节点,酌情安装 NVIDIA cuDNN、NCCL 和 MPI,下载二进制数据切片,然后进行编译和运行,很快就可以开始训练过程。”

他进一步解释道:“经过整整24小时的计算(28天乘以24小时等于672小时),你将得到有关‘安第斯山脉中能说英语的独角兽’的样本内容。”

听说llm.c项目起源于一个教学视频的构思,但随后在Karpathy遇到PyTorch相关难题时,它演变成了一项独立的、从零开始建立的工程。

尽管硬件、软件和训练数据持续发展,但高端人工智能训练的费用并未显著降低。据报道, Anthropic 的首席执行官 Dario Amodei 描述道,目前研发中的 AI 模型可能需要耗资约 100 亿美金进行训练,预估到 2025 年,更昂贵的模型成本可能攀升至 1000 亿美金。

性能强大的硬件往往伴随着更高的成本。比如,英伟达的H100芯片单片价格达到了40,000美元,而即将推出的Blackwell AI芯片预期售价可能攀升至70,000美元。然而,尽管投入巨大,据谷歌Deepmind的CEO所述,目前的模型智慧程度仅相当于一只猫。

大家在看