iPhone 15 搭载 6GB RAM,流畅运行各类应用。近日,Hugging Face 发布了名为“SmolLM”的小型语言模型,专为 Python 编程设计,极大地优化了性能与效率。

编辑日期:2024年07月20日

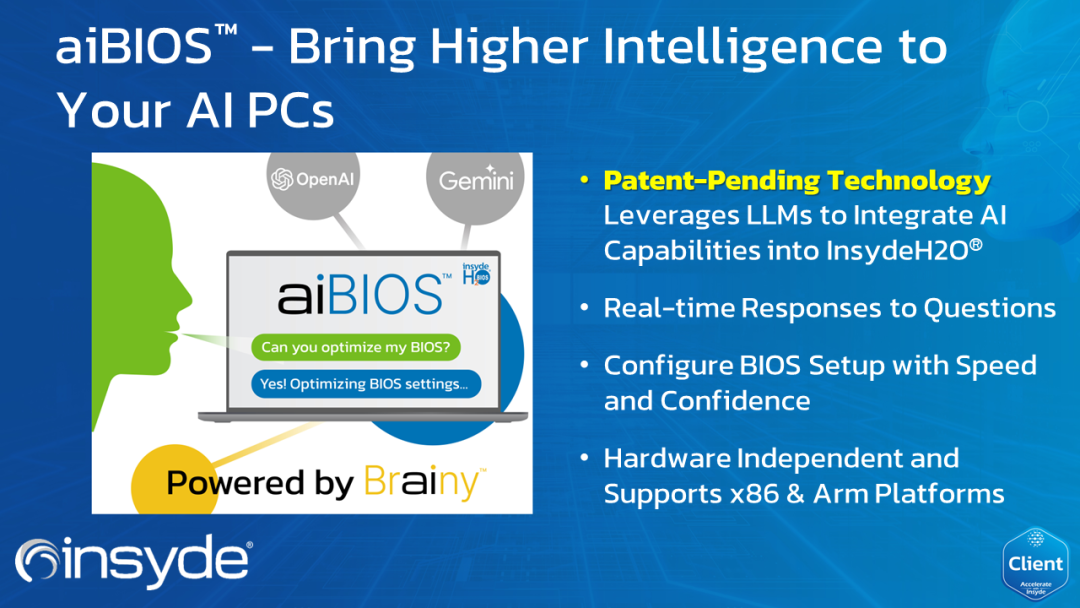

据悉,这些模型声称基于精心设计的高质训练数据集进行训练,具备出色的Python编程效能。研发团队强调,他们特别优化了模型对RAM的消耗,“甚至能在拥有6GB RAM的iPhone 15上顺利运行”。

在模型训练的征程中,Hugging Face 精英团队匠心独运,构建了一座名为 SmolLM-Corpus 的知识宝库。这座宝库汇集了Python编程教学精华——Python-Edu,网络教育领域的璀璨明珠——FineWeb-Edu,以及由Mixtral-8x7B-Instruct-v0.1与Cosmopedia v2双剑合璧所创生的广博常识,其蕴含的token总量达到了惊人的6000亿。以此为基石,Hugging Face团队倾力锻造,最终孕育出了小巧而强大的“SmolLM”语言模型,引领语言理解新风潮。

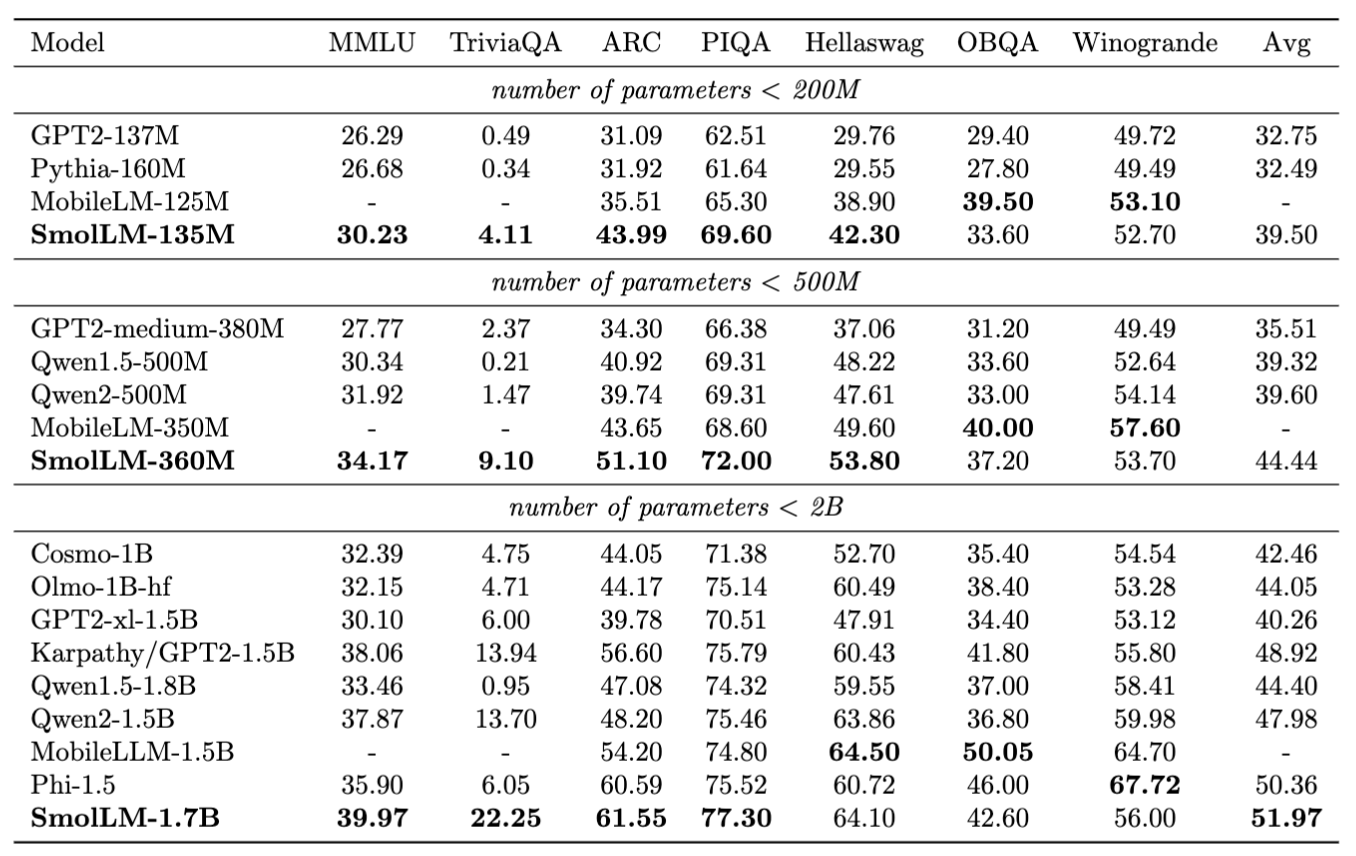

Hugging Face 团队对自家创建的 SmolLM 模型进行了广泛的性能评估,与具有相似参数量的模型对比。结果显示,SmolLM-135M 在一系列测试中表现出色,超过了所有参数少于 2 亿的模型。SmolLM-360M 的表现则在大部分情况下优于参数低于 5 亿的模型,尽管在某些特定任务上略逊于 Meta 的 MobileLLM-350M。更进一步,SmolLM-1.7B 模型在所有参数不超过 20 亿的模型中独占鳌头,成功超越了微软的 Phi-1.5、MobileLLM-1.5B 以及 Qwen2。

大家在看

AI安装教程

AI本地安装教程

微软AI大模型通识教程

微软AI大模型通识教程

AI大模型入门教程

AI大模型入门教程

Python入门教程

Python入门教程

Python进阶教程

Python进阶教程

Python小例子200道练习题

Python小例子200道练习题

Python练手项目

Python练手项目

Python从零在线练习题

Python从零到一60题