苹果公开了其7B巨模的源代码,并大方分享了完整的训练数据集,引发网友热议:这开放程度,真不像是苹果一贯作风。如此慷慨,让人眼前一亮。

编辑日期:2024年07月22日

苹果震撼登陆开源大模型领域,以更开放姿态超越同行。

全新7B模型震撼亮相,媲美Llama 3 8B效能,更慷慨公开完整训练流程及资源。

苹果大胆揭秘7B巨模源码,倾囊相授无保留。

Nature杂志曾刊文,Elizabeth Gibney针砭时弊:

标榜开源的AI模型,实则数据与训练手法欠透明,难符科研标准。

苹果今番动真格,震惊业界!

NLP专家、AutoAWQ缔造者惊呼:

Apple新作力压Mistral 7B,更胜一筹乃全程开源,连同预训练数据集!

网络热议,幽默调侃随之而来。

开源之举深意何在?网友解析:

欲重塑模型或精调现有,数据管理乃必修课。

OpenAI、苹果领航,Mistral AI联手英伟达上周推12B参数轻量级模型。

HuggingFace始创人预言:“小模型周”已至!

卷起来吧,持续创新!那么,苹果此次推出的小模型实力如何?暂且不谈实力,先来看看Hugging Face技术主管刚揭晓的模型基本规格。

简而言之,关键信息如下:

苹果慷慨地公布了其7B大型模型的源代码,共享于众。

更进一步,研发团队创立了一项崭新的语言模型数据评估标准——DCLM。这一标准应运而生,源于团队认识到:通过机器学习(ML)模型自动筛选大型数据集中的优质数据,是构建高效训练集的核心。为此,他们运用DCLM精心打造高质量数据集,旨在显著提升模型效能,特别是在多模态场景下。

其方法论简洁明了:采用统一框架进行实验,固定模型结构、训练脚本、超参数及评估流程,以确定最佳的数据优化策略,从而训练出高能模型。

遵循此法,团队构建了DCLM-BASELINE高质量数据集,以此为基,全新训练出7B参数规模的DCLM-7B模型。

那么,DCLM-7B的表现如何?

测试结果表明,在MMLU基准上,该模型5-shot精确度高达64%,与Mistral-7B-v0.3(63%)和Llama 3 8B(66%)不相上下;同时,在53项自然语言理解任务中,其平均表现与Llama 3 8B旗鼓相当,但计算需求仅为其六分之一。

相较于同级规模模型,DCLM-7B在MMLU评分中胜过Mistral-7B,其表现紧随Llama 3 8B之后。近期,苹果开源其7B模型代码之举,引发广泛关注。

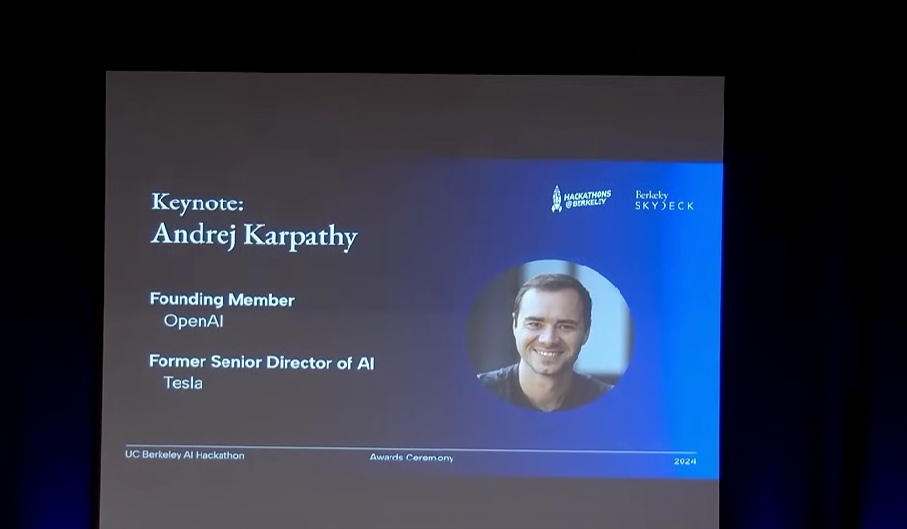

业内专家采用卡帕西的llm.c工具,对GPT-2 1.5B进行新数据集效能测试,对比DCLM-Baseline与FineWeb-Edu的表现。

测试结果表明,在多项任务如ARC(小学科学推理)、HellaSwag(常识推理)及MMLU中,DCLM-Baseline展现出更优的平均成绩。

话题回归至“小”模型的兴起,HuggingFace首推“SmolLM”系列小型模型,涵盖135M、360M及1.7B参数规模,于广泛推理与常识评估中,超越同类模型。

紧接着,OpenAI推出GPT-4o mini,性能逼近GPT-4,同时成本显著降低,引领“小”模型风潮。

就在GPT-4o mini亮相之际,Mistral AI携手英伟达推出了12B参数的紧凑型模型——Mistral NeMo。在一系列的性能较量中,Mistral NeMo力压Gemma 2 9B与Llama 3 8B,展现出卓越实力。

或许你已注意到,科技巨头苹果慷慨解囊,公开展示了自家7B巨模的源代码,共享创新成果。

为何近期小模型备受追捧?正如smol AI创始人所言,尽管体积瘦身,但小模型在保持相近效能的同时,显著削减了成本。

以GPT-4o mini为典型,这类精简版模型的性价比优势明显,正如以下图表所示:

对于这一趋势,围观群众或许会如此反应:

那么,你更青睐哪一家呢?

这是一个充满机遇与挑战并存的时代。

然而,有美国企业担忧,特定政策调整可能对其在中国市场的业务产生不利影响。

本期评测,价值连城,仅此一家! 注:原文中的图片链接已被去除,因为无法在纯文本环境中展示图片。

苹果已慷慨释出其庞大7B模型的原始码,对全球进行共享。

苹果已将其7B大型模型的源代码无私地公之于众。

全球超过15亿装置,无一不受到影响。

Docker、Homebrew、VSCode现已全面兼容,全力响应。

大家在看