MAIA 新系统发布:揭示AI模型内部运作,评估其安全性。

编辑日期:2024年07月25日

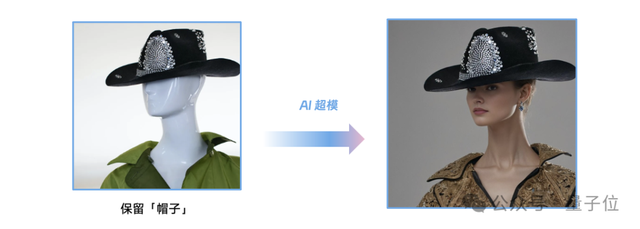

麻省理工学院(MIT)的计算机科学与人工智能实验室(CSAIL)最近开发了一项名为MAIA的技术。该系统运用视觉语言模型,能自动完成多种神经网络的可解释性任务。

MAIA,即“多模态自动化可解释性代理”,主要运用视觉语言模型,自动完成各类神经网络的可解释性任务,并提供了一套用于测试其它人工智能系统的工具。

来自 MIT CSAIL 的博士后、该研究论文的共同作者塔玛尔·罗特·沙哈姆表示:

另一方面,MAIA 能提出假设,规划实验来检验这些假设,并通过反复分析来精进其理解。

通过整合预训练的视觉语言模型与可解释性工具库,我们的多模态方法能在特定模型上设计并执行有针对性的实验,以回应用户的提问。持续优化方法,直到能给出全面准确的答案。

此自动代理已证实能执行三项核心任务:

MAIA 透过创建假设、规划实验验证假设,并经由迭代分析优化理解,揭示了人工智能模型的内部运作机制。这有助于我们洞察这些模型的工作原理、探讨其安全性及偏见问题。

请提供需要重写的原文本内容。