谷歌AI获得IMO银牌,仅以一分之差错过金牌!在第四题中仅用了19秒。

编辑日期:2024年07月26日

组委会亲自确认,就连号称最棘手的第六题也被正确解答。

白交 西风 报道自 凹非寺

就在刚才,大型模型再度取得重大突破!

谷歌DeepMind宣布其数学AI在国际数学奥林匹克竞赛(IMO)中荣获银牌,且与金牌仅一步之遥,相差仅一分!

没错,您没听错!这正是那类令绝大多数人头疼不已的奥林匹克数学难题。须知,在今年的IMO中,共有609名参赛者,但只有58人达到了金牌的标准。

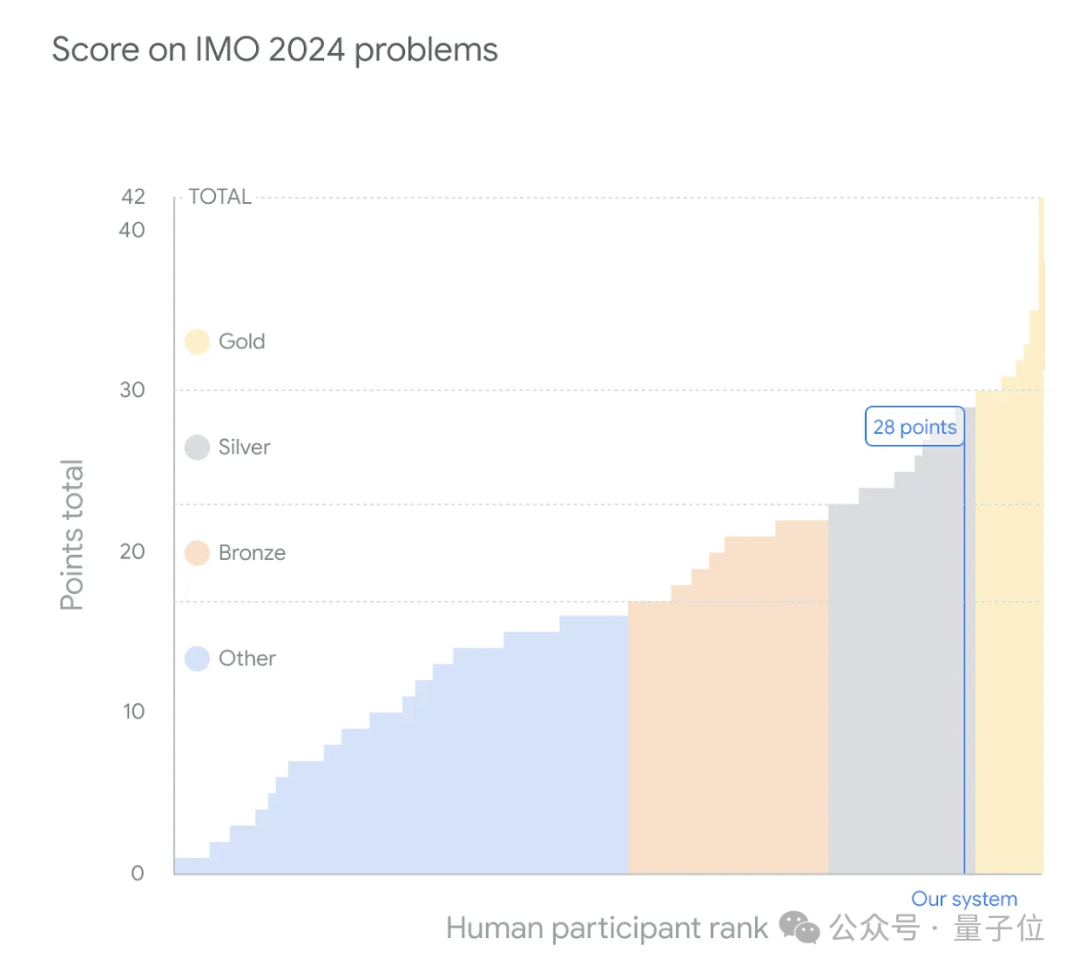

本次比赛中,谷歌AI成功解答了2024年IMO六道题目中的四题,每解一题即获满分,最终累计得分28分。(总分为42分,金牌分数线为29分)

其中,对于第四题几何问题,AI只用了短短19秒便给出答案!

而被誉为本届最难的第六题,仅有五名选手成功解答,AI同样完美作答。

本次成绩还获得了IMO组委会的专业认可——由IMO金牌得主、菲尔兹奖得主蒂莫西·高尔斯教授及两度IMO金牌得主、2024 IMO问题选拔委员会主席约瑟夫·迈尔斯博士共同评定。

蒂莫西·高尔斯教授赞叹道:“这一成就远超我的预期,达到了最先进的水平。”

让我们看看这一切是如何实现的?

此次赢得IMO银牌的,是来自谷歌Alpha家族的两位成员,它们各有所长。

首先介绍新成员——AlphaProof。

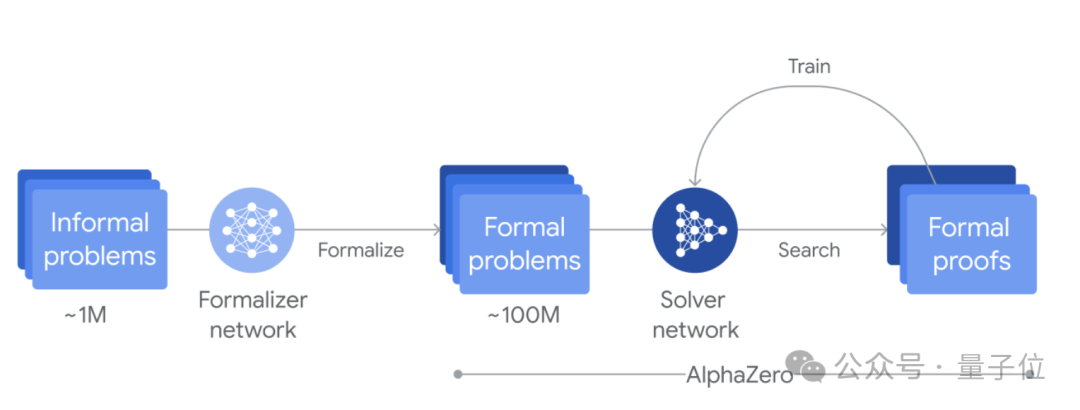

这是一个自我训练的系统,能够使用形式语言Lean来证明数学命题。它巧妙地将预训练的语言模型与AlphaZero强化学习算法相结合。

团队通过对 Gemini 进行微调,实现了将自然语言表述自动转换为 Lean 形式语言表述的功能,从而构建出一个庞大的数学问题数据库。面对这些问题时,AlphaProof 会生成潜在的解决方案,并通过探索 Lean 中可能的证明步骤来验证或推翻这些假设。

每找到并验证的一个证明都被用来增强 AlphaProof 的语言模型,进而提升它解决更为复杂问题的能力。

在竞赛开始前的几周内,系统便通过这种循环迭代的方式,利用数百万道国际数学奥林匹克(IMO)级别的题目进行了训练。

在竞赛期间,这一训练循环仍在持续运行,不断自我强化证明能力,直至找到完整解法。

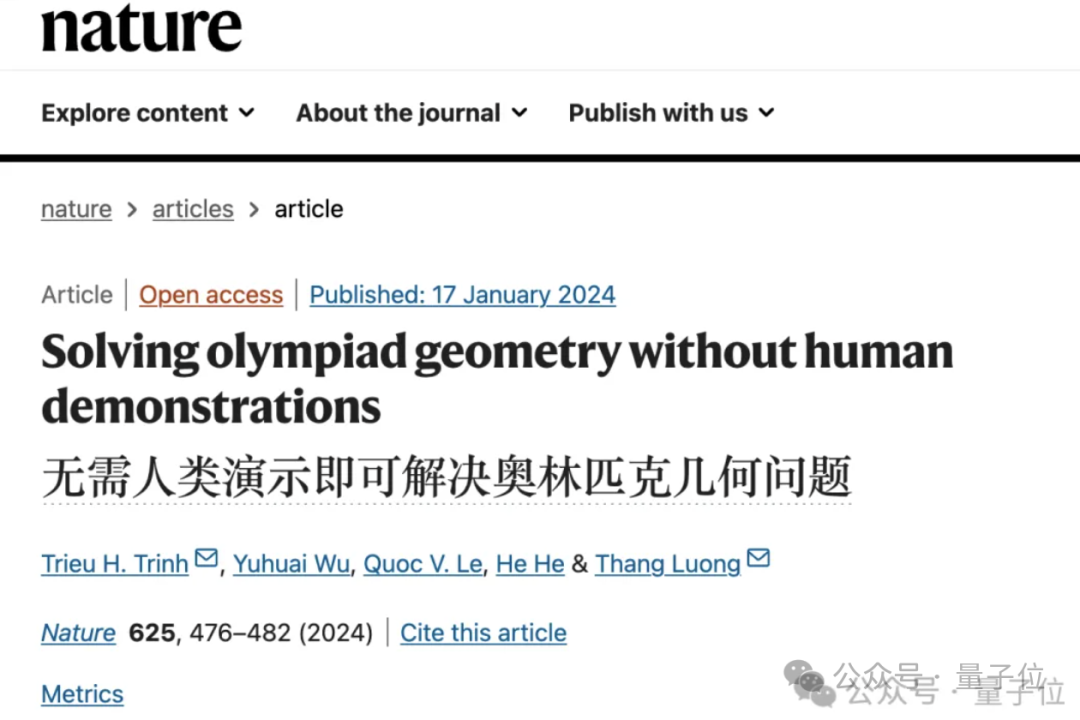

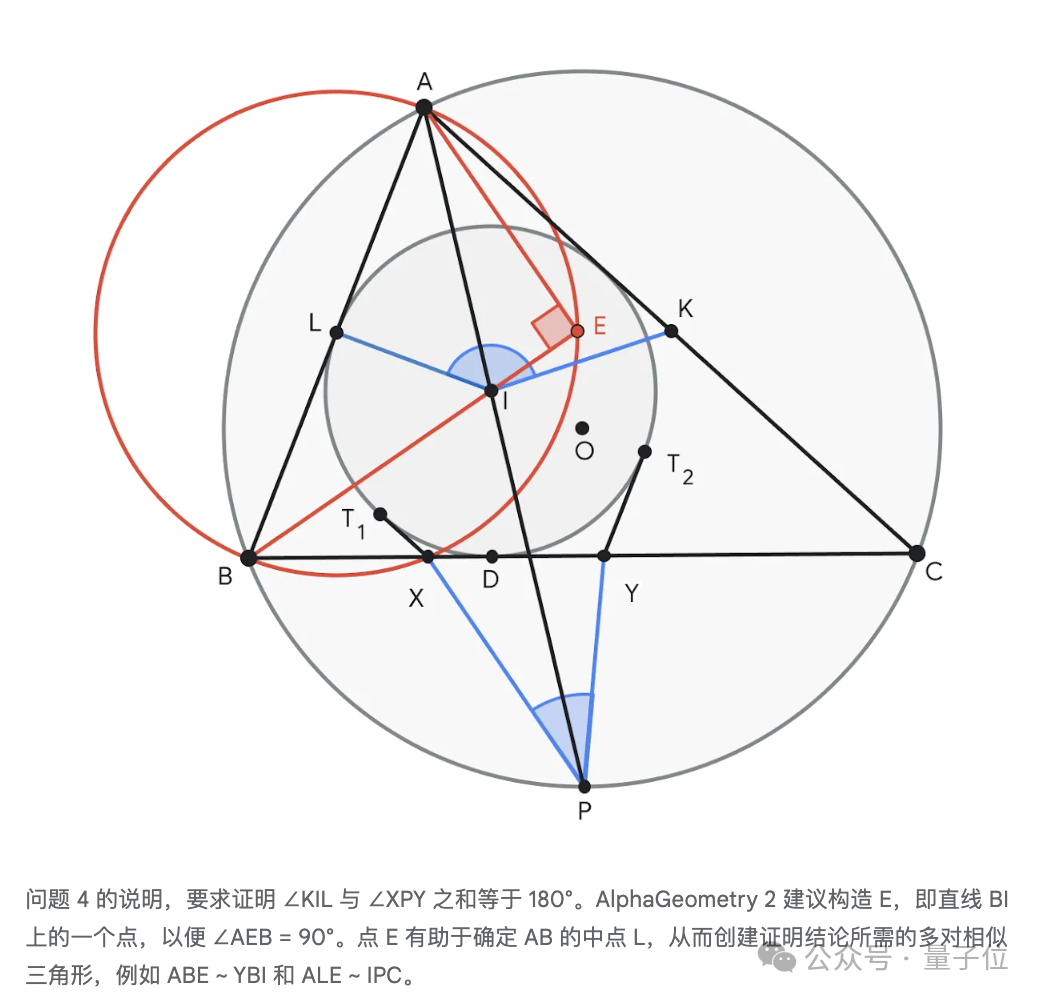

接下来,让我们深入了解进化的 AlphaGeometry 2。这是一个神经-符号混合系统,其语言模型基于 Gemini 构建。

其早期版本 1.0 已在今年登上《自然》杂志,无需人类示例指导即可达到 IMO 金牌得主的几何解题水平。

与前一版本相比,它使用了规模大一个数量级的合成数据进行初始训练,并且采用了比前辈快两个数量级的符号引擎。面对新问题时,它会采用一种全新的知识共享机制,实现不同搜索树之间的高级组合,以解决更为复杂的问题。

在正式竞赛前,它已经能够解决过去 25 年间所有 IMO 几何问题中的 83%,而其前身仅能达到 53% 的解题率。

在今年的 IMO 竞赛中,它仅用 19 秒便解决了第四题。

现在,让我们看看在这次 IMO 竞赛中,二者是如何协同工作的。

首先,问题需要手动翻译成正式的数学语言,以便系统能够理解。

我们知道,在人类参赛的情况下,比赛分为两个阶段提交答案,每阶段有4.5小时的时间。而谷歌的这两个系统,其中一个问题只用了几分钟就解决,其余的问题则耗时三天才完成。

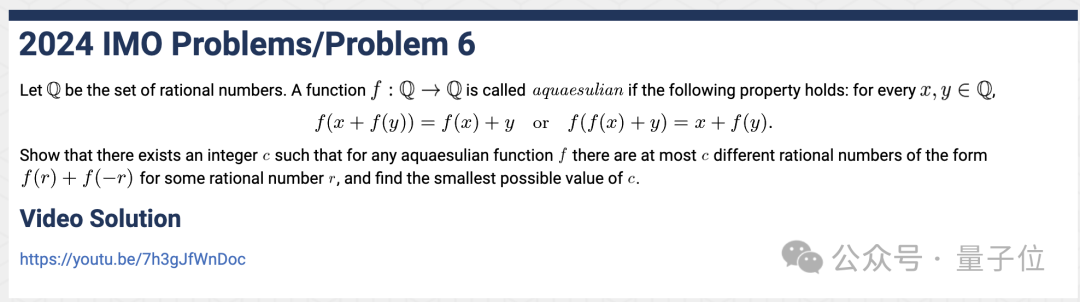

最终,AlphaProof成功解决了两道代数题目及一道数论题目,通过确定答案并证明其正确性。这其中包含的是比赛中最困难的一题——在今年的IMO比赛中,只有五位选手能够解答出来的第六题。

AlphaGeometry 2则解决了几何问题,而组合问题仍然未被解决。

此外,谷歌团队还尝试了一种基于Gemini的自然语言推理系统,这意味着无需将问题转化为形式语言,并且可以与其他AI系统协同工作。

该团队表示,他们将继续探索更多的AI方法来推动数学推理的进步。

至于AlphaProof的技术细节,预计也将很快公布。

目睹这两个系统的出色表现后,许多网友纷纷表示“虽然不懂数学,但却深受震撼”。

AI程序员、Cognition AI联合创始人Scott Wu表示:

这一成果真是令人震惊。我小时候,奥林匹克竞赛就是我的一切。我从未想过十年后这些问题会被人工智能解决。

OpenAI科学家Noam Brown也发推祝贺:

然而,也有网友指出,如果按照标准的比赛时间(比赛分为两天,每天4.5小时,每天需解答三题),这两个AI系统实际上只能在六个问题中解决一个。

关于谷歌AI获得国际数学奥林匹克(IMO)银牌、仅以一分之差未能夺金的说法,立即遭到了一些网友的质疑:

在这个情景下,速度并非关键因素。若浮点运算次数(FLOPS)保持恒定,则增加计算资源将缩短解决问题所需的时间。

对此,有网民提问:

两个AI系统未能解答组合题,是因为训练不足、计算资源不足或时间不够,还是存在其他限制?

Timothy Gowers教授在推特上分享了他的见解:

如果允许人类选手在每道题目上投入更多时间,他们的成绩无疑会更好。然而,对于AI系统而言,这已经大大超越了传统自动定理证明器的能力;此外,随着效率的提升,预期所需时间将进一步减少。

然而,不久前大模型还在为“9.11与9.9哪个数字更大”这样的基础问题苦恼,如今却能解决奥林匹克级别的数学难题,这是怎么回事?

似乎之前失去了应有的智能,而现在又突然灵光一闪,恢复了智能?

对此,英伟达的科学家Jim Fan解释称:这是由于训练数据分布的原因。

谷歌的这套系统是在形式证明和领域特定的符号引擎上进行训练的。可以说,在解决奥林匹克竞赛问题方面,它们有着高度的专业化,尽管这些系统基于通用的大模型之上。

如同GPT-4o这样的模型,在训练集里包含了大量来自GitHub的代码数据,这可能远超数学相关数据的数量。例如在软件版本标记“v9.11>v9.9”的情况下,这种偏差可能会导致数据分布产生严重偏斜。因此,出现这类错误也就在情理之中了。

对于这一奇特的现象,有人描述为:

我们发现了一片异常区域,就像是发现了一颗外观类似地球、但表面布满了奇异山谷的外星行星。

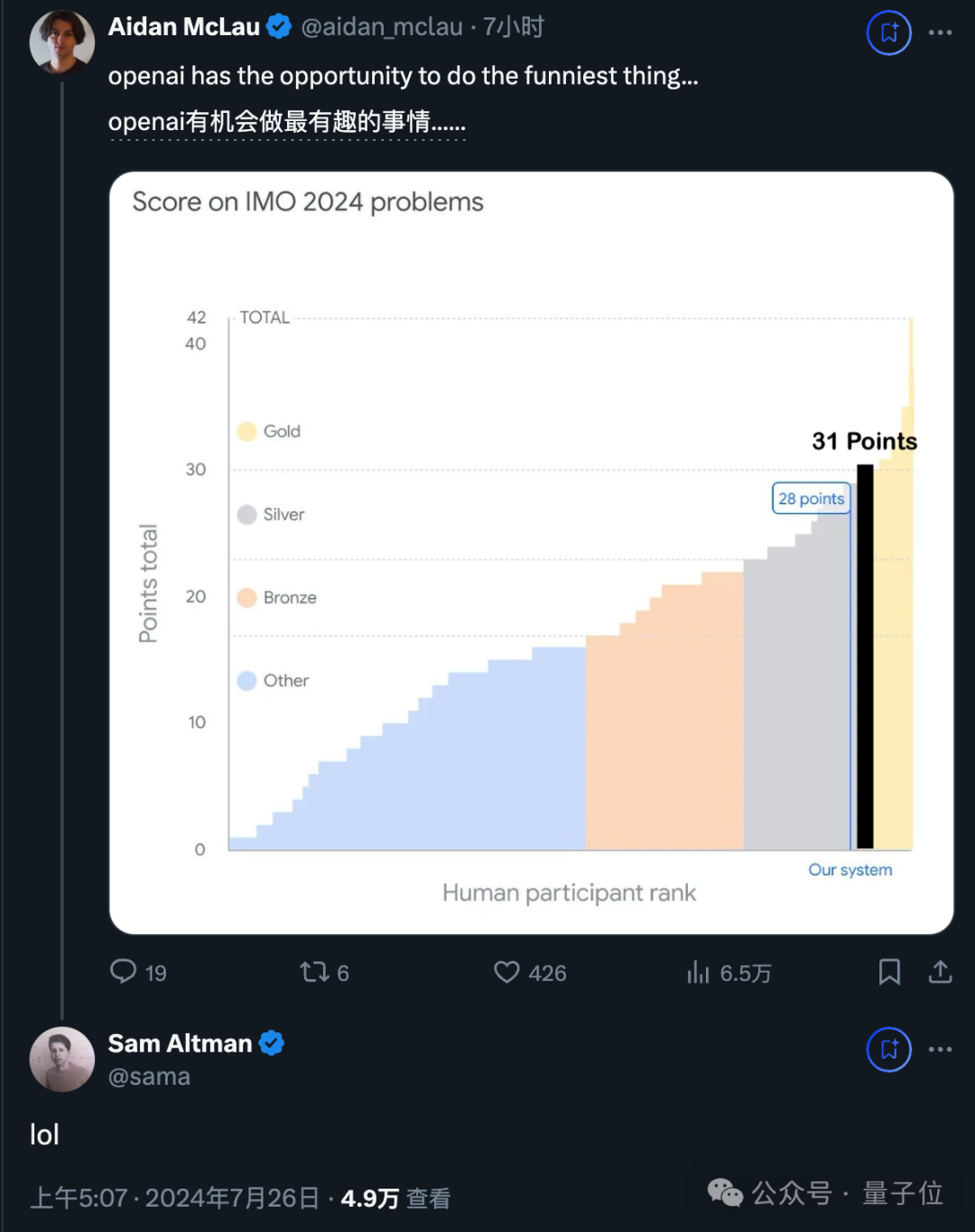

此外,一些网友还提到了OpenAI,建议他们也可以尝试一下。

而奥特曼的回应则是:

参考资料: [1] https://x.com/googledeepmind/status/1816498082860667086?s=46 [2] https://x.com/jeffdean/status/1816498336171753948?s=46 [3] https://x.com/quocleix/status/1816501362328494500?s=46 [4] https://x.com/drjimfan/status/1816521330298356181?s=46 [5] https://deepmind.google/discover/blog/ai-solves-imo-problems-at-silver-medal-level/

已经对7100万个错义突变进行了分类。

谷歌AI在国际数学奥林匹克(IMO)中获得了银牌,仅以一分之差与金牌失之交臂。

浙江选手史皓嘉连续两年获得满分成绩。

下一届即第67届国际数学奥林匹克比赛将在上海举行。

比赛中最难的一题被称为“北欧方阵”,参赛队员们几乎想要放弃。

中国人民大学附属中学成为了北方地区的唯一代表高中。

谷歌AI与人类数学天才们进行了激烈的竞争。