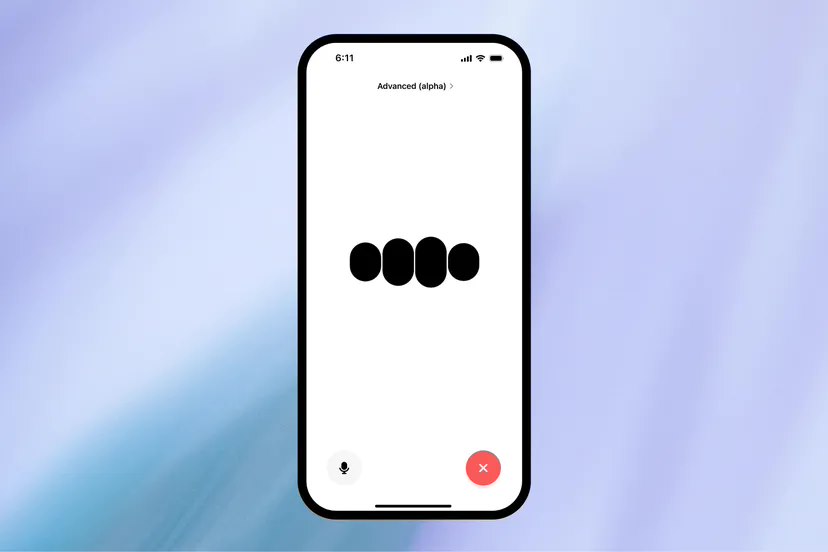

OpenAI 已向部分付费订阅用户开放了 GPT-4 的语音模式,能够实现更加自然流畅的实时对话。

编辑日期:2024年07月31日

在今年5月,OpenAI的首席技术官米拉·穆拉蒂(Mira Murati)在一次演讲中提到:

由于GPT-4是我们首个整合所有这些模式的模型,因此我们在探索这个模型的能力及其限制方面仍处于初级阶段。 注意:原文中的"GPT-4o"可能是输入错误,正确的应为"GPT-4"。

OpenAI原定于今年6月底邀请一部分ChatGPT Plus用户测试GPT-4的语音功能,但公司在6月宣布推迟这一计划,表示他们需要更多的时间来完善这个模型,提升其识别和拒绝某些内容的能力。

根据之前公布的信息,GPT-3.5模型的平均语音反馈延迟时间为2.8秒,而GPT-4模型的延迟时间为5.4秒,因此在语音交互方面的表现不尽如人意。即将推出的GPT-4o将大幅度减少延迟时间,实现近乎无缝的对话体验。

GPT-4o 的语音模式具有快速响应和接近真人的声音等特点。OpenAI 还表示,GPT-4o 的语音模式能够识别语音中的情感语调,包括悲伤、兴奋或是唱歌的声音。

OpenAI 的发言人林赛・麦卡勒姆(Lindsay McCallum)表示:“ChatGPT 无法模仿他人的声音,包括个人和公众人物的声音,并且会阻止与预设声音不同的输出。”

大家在看

AI安装教程

AI本地安装教程

微软AI大模型通识教程

微软AI大模型通识教程

AI大模型入门教程

AI大模型入门教程

Python入门教程

Python入门教程

Python进阶教程

Python进阶教程

Python小例子200道练习题

Python小例子200道练习题

Python练手项目

Python练手项目

Python从零在线练习题

Python从零到一60题