iPhone变身2B小钢炮:谷歌Gemma 2小模型登场,性能评分超越GPT-3.5

编辑日期:2024年08月01日

就在刚才,谷歌 DeepMind 发布了 Gemma 2 2B。

它是从Gemma 2 27B中蒸馏出来的。

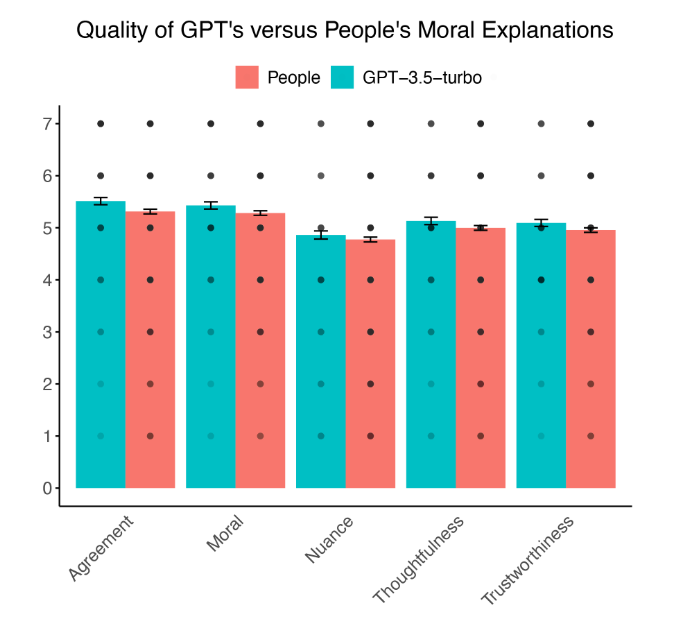

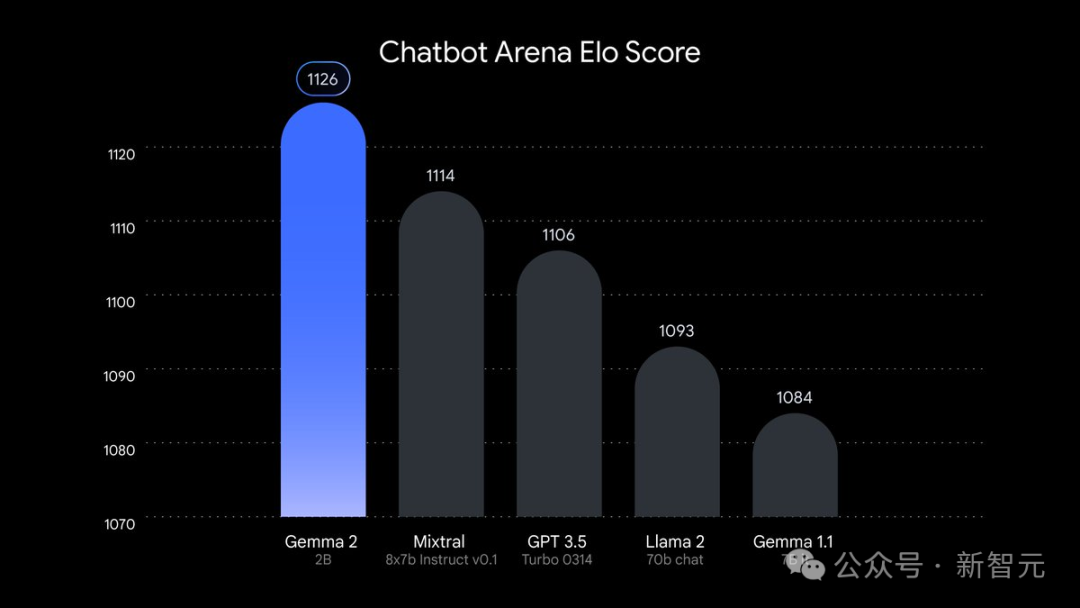

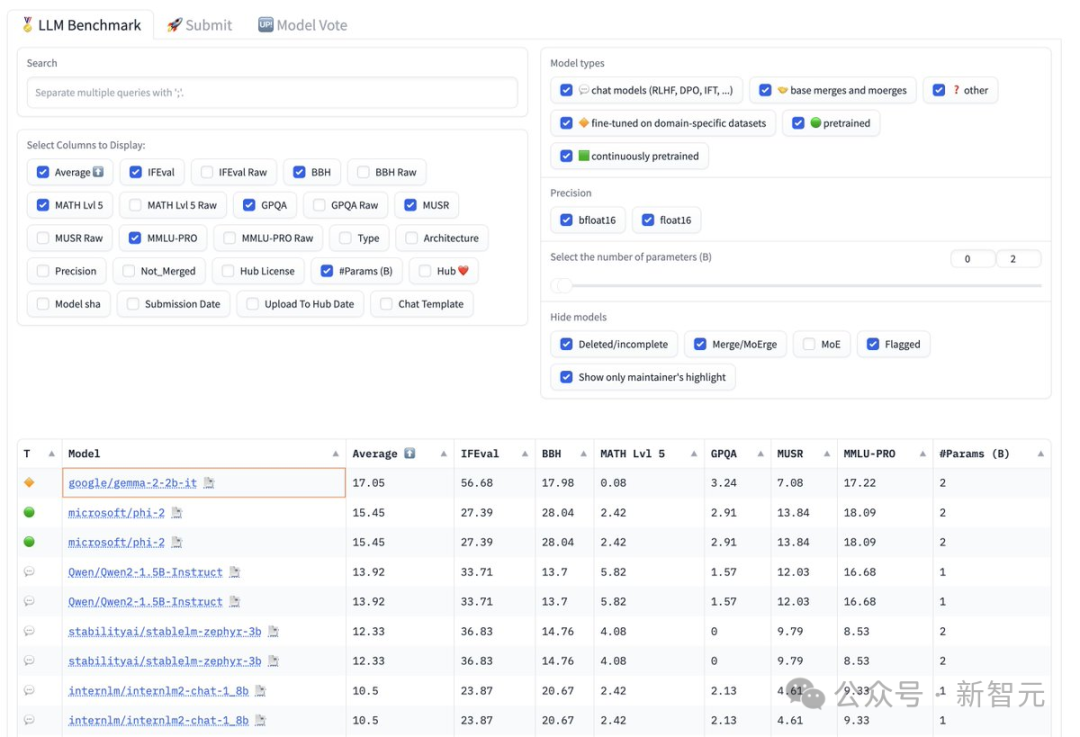

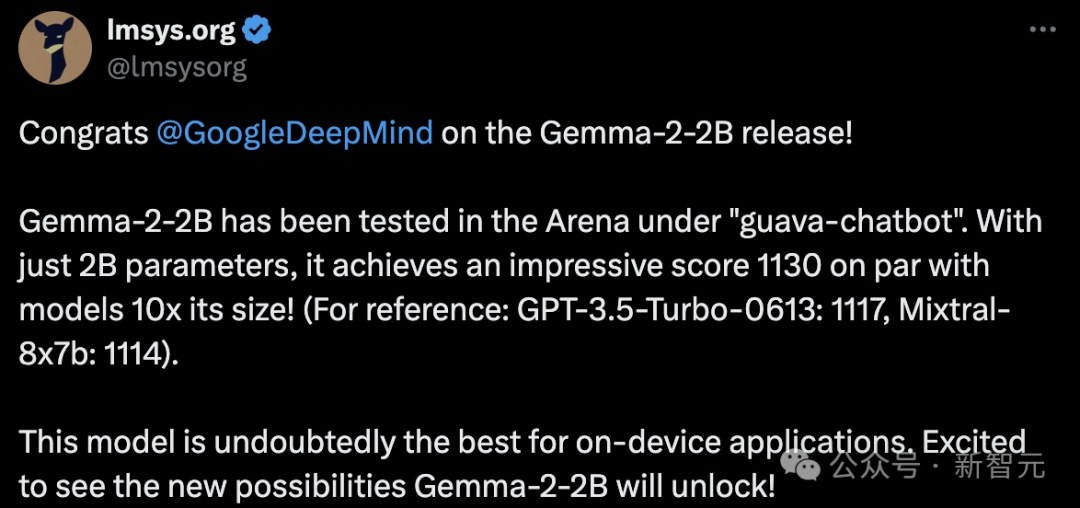

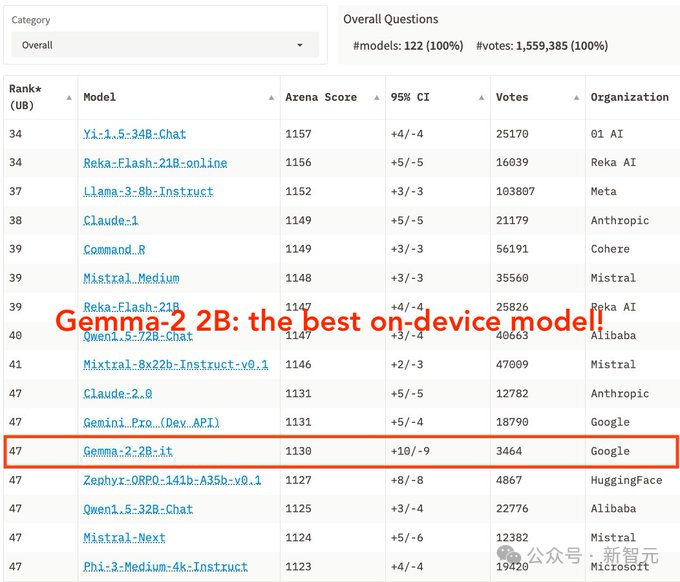

虽然它的参数仅为2.6B,但在LMSYS竞技场上的得分已经超过了GPT-3.5和Mixtral 8x7B!

在MMLU和MBPP基准测试中,它分别获得了56.1和36.6的出色成绩;相较于前一代的Gemma 1 2B模型,其性能提升了超过10%。

小规模的模型击败了大规模几个数量级的大型模型,再次证明了近期业界非常看好小模型的发展方向。

今天,谷歌共发布了Gemma 2家族的三款新产品:

6月,27B和9B Gemma 2模型问世。

自发布以来,27B模型迅速跻身为大型模型排行榜上前几名的开源模型之一,并且在实际对话中的表现甚至超越了参数数量为其两倍的流行模型。

轻量级的小模型 Gemma 2 2B 是从大型模型中蒸馏出来的,其性能毫不逊色。

在LMSYS的大模型竞技场上,新的模型获得了令人印象深刻的1130分,其表现与参数量为其10倍的模型不相上下。

GPT-3.5-Turbo-0613的得分是1117分,而Mixtral-8x7b的得分是1114分。

由此可见,Gemma 2 2B 是最优秀的端侧模型。

有网民在iPhone 15 Pro上运行了量化后的Gemma 2 2B模型于MLX Swift上,其速度令人惊叹。

具体而言,它可以在各种终端设备上进行部署,包括手机、笔记本电脑,甚至利用Vertex AI和Google Kubernetes Engine(GKE)的强大云端能力也是如此。

为了加速模型运行,它已经通过NVIDIA TensorRT-LLM进行了优化,并且也可以在NVIDIA NIM平台上使用。

优化后的模型可适用于多种平台的部署,包括数据中心、云端、本地工作站、个人电脑及边缘设备。

它还可以支持 RTX 和 RTX GPU,以及 Jetson 模块,实现边缘化的 AI 部署。

此外,Gemma 2 2B 实现了与 Keras、JAX、Hugging Face、NVIDIA NeMo、Ollama、Gemma.cpp 等的无缝集成,并且即将实现与 MediaPipe 的集成,以简化开发流程。

当然,与Gemma 2一样,2B模型同样可以用于研究和商业用途。

甚至,由于其参数量足够小,它可以在Google Colab的免费T4 GPU层级上运行,从而降低了开发的门槛。

目前,每位开发者都可以从Kaggle、Hugging Face、Vertex AI Model Garden下载Gemma 2的模型权重,也可以在Google AI Studio中试用其功能。

仓库地址:

(注:似乎提供的文本不完整,实际应用中应包含完整的地址信息。)

链接:https://huggingface.co/collections/google/gemma-2-2b-release-66a20f3796a2ff2a7c76f98f

这是指向一个位于Hugging Face模型库的链接,该链接指向的是Google的GEMMA-2-2B模型的发布版本。

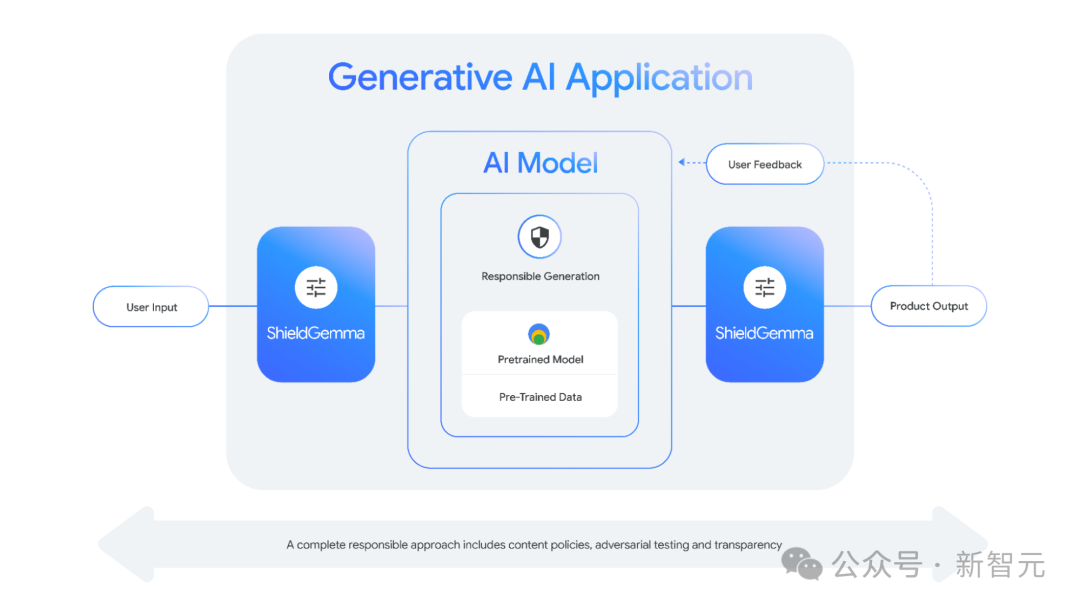

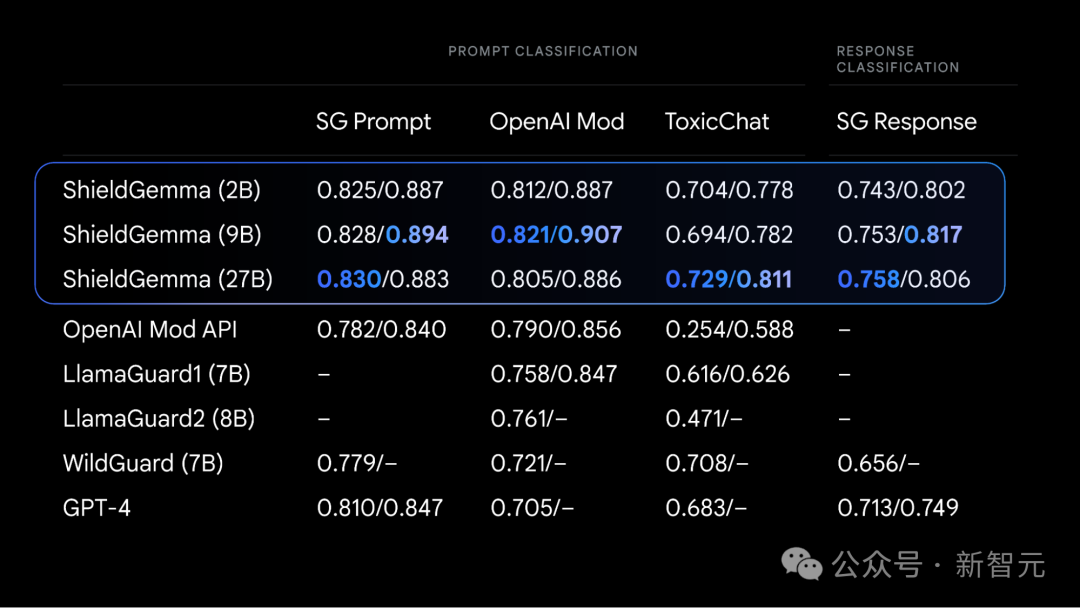

正如其名称所示,ShieldGemma是最先进的安全分类器,它确保AI生成的内容既吸引人又安全且具包容性,同时还能检测并减少有害内容的输出。

ShieldGemma的设计专门针对四个关键的有害领域:

这些开源分类器是对谷歌现有负责AI工具包中安全性分类器套件的一种补充。

该工具包含一种方法,用于根据有限的数据点来构建针对特定策略的分类器,同时还通过API提供了现成的Google Cloud分类器。

ShieldGemma基于Gemma 2构建,是一款业界领先的安全分类器。

它提供了多种模型参数规模的选择,包括 20 亿、90 亿和 270 亿参数的模型,这些模型都经过英伟达的速度优化处理,能够在各种硬件上高效运行。

其中,2B 版本非常适合在线分类任务,而 9B 和 27B 版本则为对延迟要求较低的离线应用提供了更高性能。

此次发布的另一个重大亮点是开源的稀疏自编码器——Gemma Scope。

语言模型的内部到底发生了什么呢?这个问题长期以来一直让研究者和开发者感到困惑。即便对于训练这些模型的研究人员来说,语言模型的内部运作也常常像是个谜。

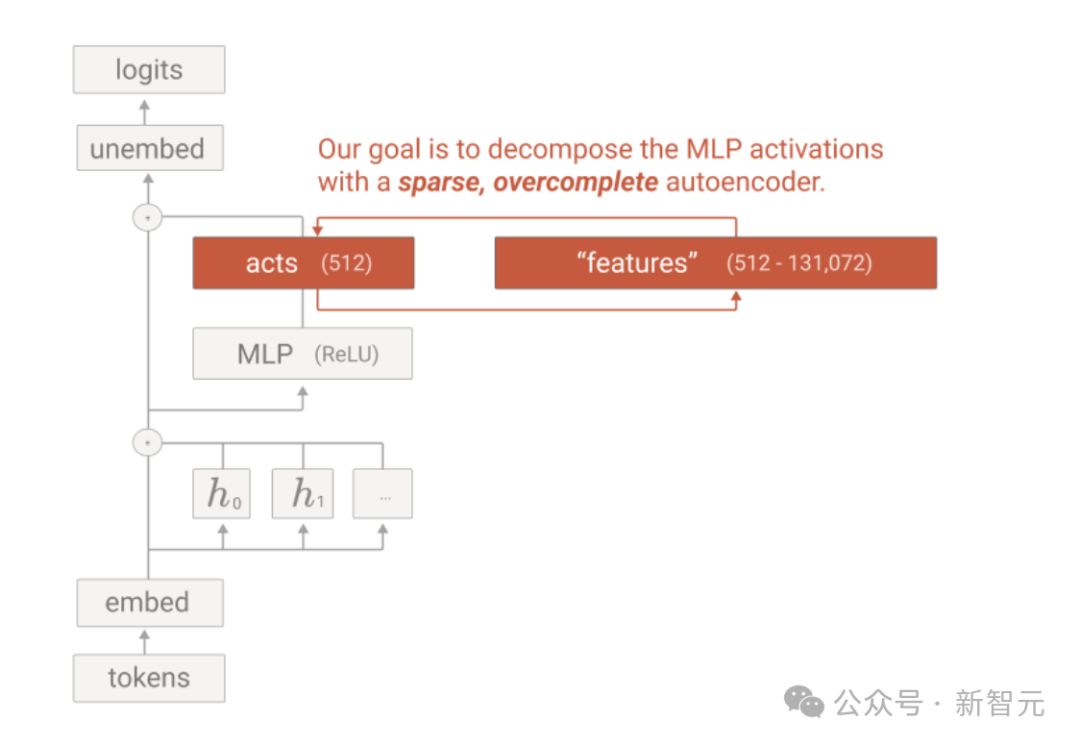

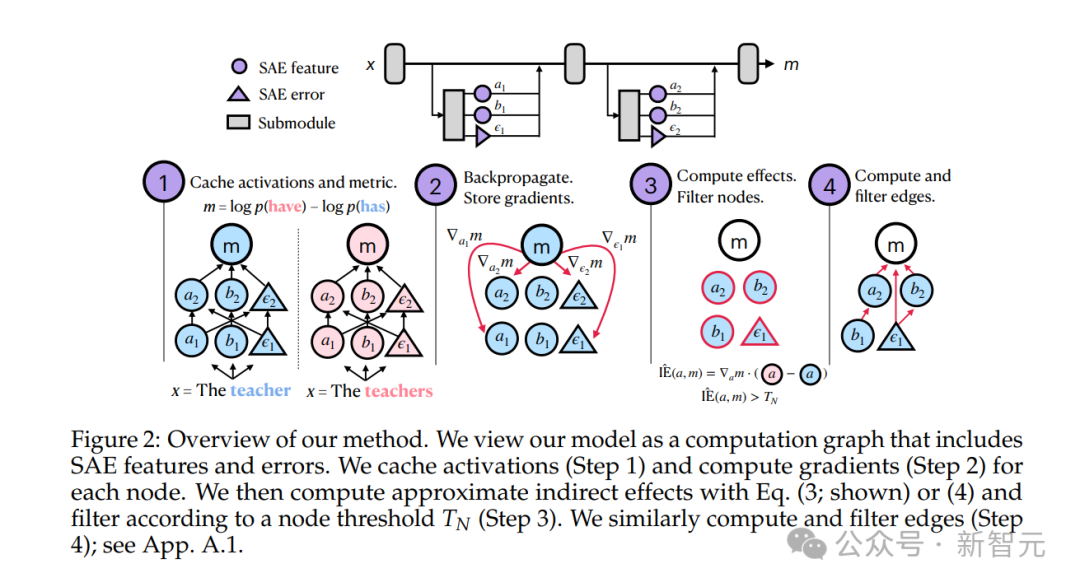

而 Gemma Scope 就像一个强力的显微镜,通过稀疏自编码器(SAEs)来放大模型中的特定部分,这使得模型的内部运作更易于解释。

通过使用 Gemma Scope,研究人员和开发者获得了前所未有的透明度,能够深入理解Gemma 2模型的决策过程。

Gemma Scope 是一个集合,包含了数百个适用于 Gemma 2 9B 和 Gemma 2 2B 的免费开源稀疏自动编码器(SAE)。

这些SAEs是专门为神经网络设计的,它们能够帮助我们将由Gemma 2处理过的密集且复杂的信息进行解读,并将其转换成更容易分析和理解的形式。

通过研究这些扩展视图,研究人员能够获得宝贵的信息,了解到Gemma 2如何进行模式识别、信息处理及预测作出的过程。

通过使用 Gemma Scope,AI 社区可以更轻松地构建出更易理解、负责任和可靠的 AI 系统。

同时,谷歌 DeepMind 还发布了一份 20 页的技术报告。

技术报告:https://storage.googleapis.com/gemma-scope/gemma-scope-report.pdf (点击链接查看报告)

总的来说,Gemma Scope具有以下三个创新点:

为什么语言模型的可解释性问题如此困难?

这得从LLM的运行原理开始讲起。

当你向LLM提出问题时,它会将你的文本输入转化为一系列的「激活」信号。这些激活信号描绘出了你输入文本中词语之间的关联性,帮助模型建立起词语间的联系,并据此生成相应的答案。

在处理文本输入的过程中,模型神经网络中不同层次的激活代表了多个逐步抽象的高级概念,这些概念被称为“特征”。

例如,模型的早期层可能学会如迈克尔·乔丹打篮球这样的事实,而后期层则可能辨识出更复杂的概念,如文本的真实性。

然而,可解释性研究者一直面临一个关键问题:模型的激活是许多不同特征的混合。

在研究初期,研究人员希望神经网络中的特征激活能与单一神经元(即信息节点)对齐。

但不幸的是,在实践中,神经元往往对许多不相关的特征活跃。这意味着,没有明显的方法可以辨别哪些特征是激活的一部分。

而这,正是稀疏自编码器发挥作用的地方。

需要了解的是,一次特定的激活通常只涉及少量特征的组合,尽管语言模型可能有能力检测到数百万甚至数十亿种特征(也就是说,模型对特征的利用是稀疏的)。

例如,语言模型在回答有关爱因斯坦的问题时会联想到相对论,而在描述煎蛋卷时会联想到鸡蛋,但在撰写关于煎蛋卷的内容时,可能就不会联想到相对论了。

稀疏自动编码器正是利用了这一事实来发现一组潜在的特征,并将每个激活分解为仅包含少数几个特征的部分。

研究人员希望,稀疏自编码器能找到语言模型实际上使用的基本特征,以此作为完成这项任务的最佳方式。

重要的是,在这个过程中,研究人员并不会告诉稀疏自编码器去寻找哪些特征。因此,他们能够发现之前未曾预料到的丰富结构。

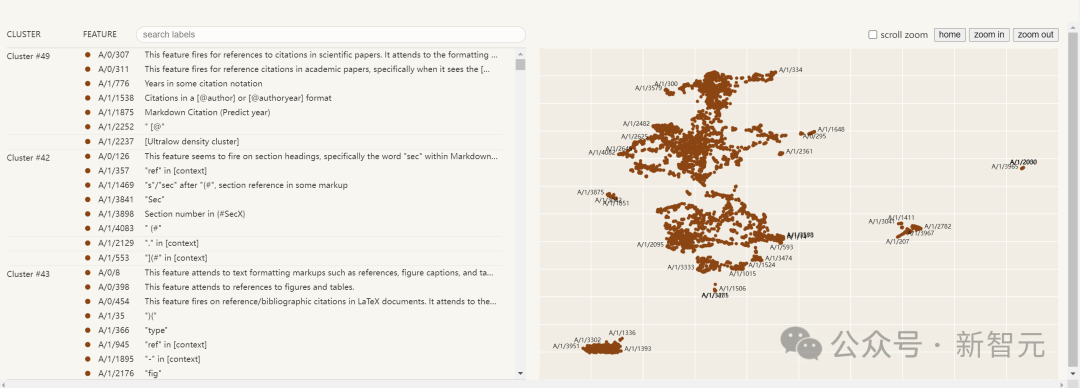

然而,由于他们无法立即了解这些发现的特征的确切含义,因此他们会寻找在稀疏自编码器认为特征被“触发”的文本示例中有意义的模式。

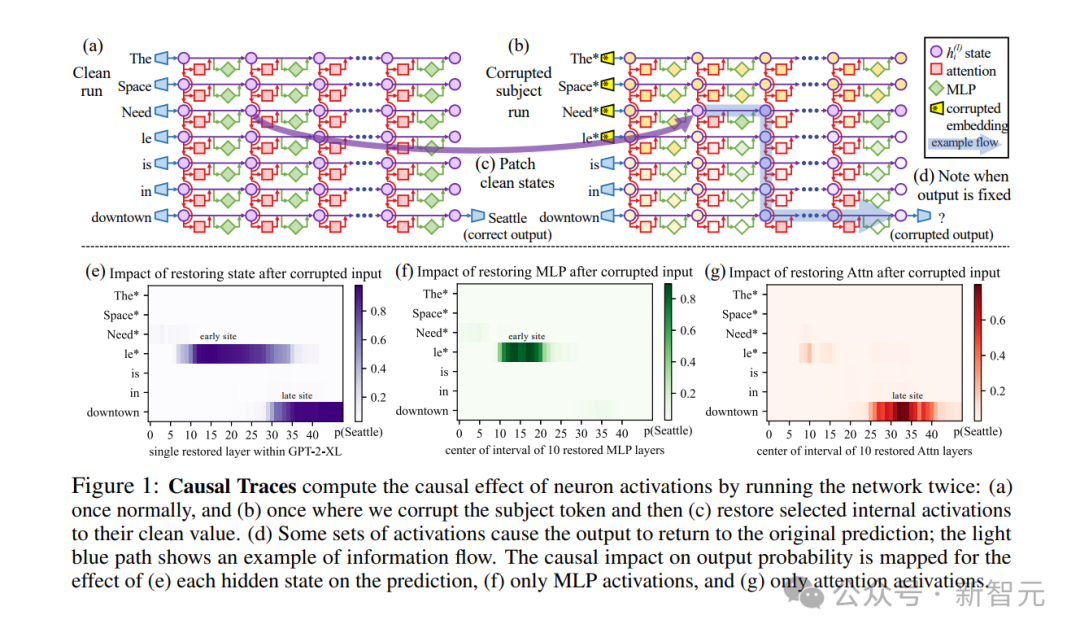

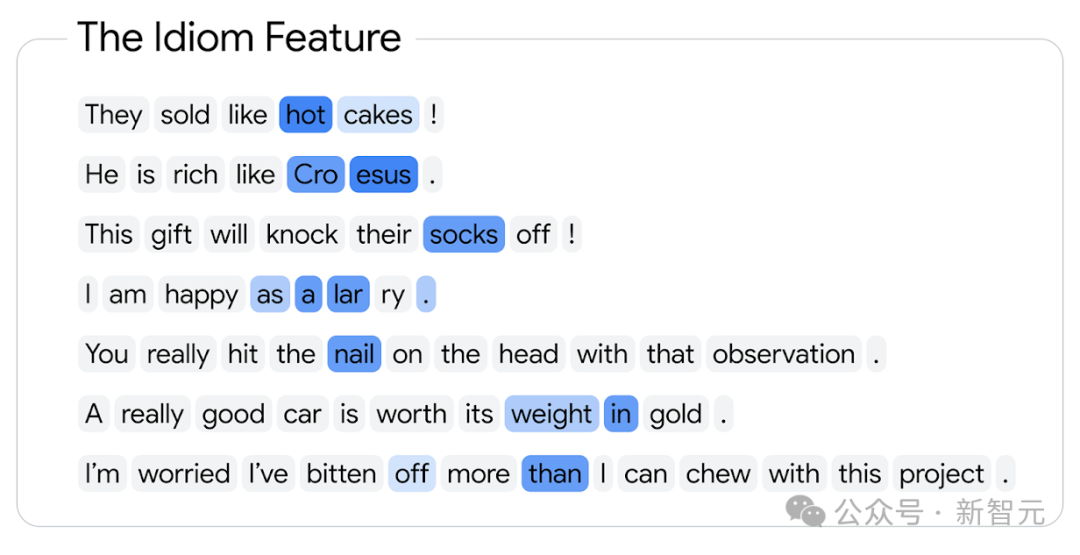

以下是一个示例,其中根据特征触发的强度,使用蓝色渐变高亮显示了特征触发的令牌:

使用稀疏自动编码器发现特征激活的示例。每个气泡代表一个Token(单词或词素),变化的蓝色表示该特征的存在强度。在这个例子中,该特征明显与成语相关。

与之前的稀疏自编码器相比,Gemma Scope 有许多独特之处。

前者主要集中在研究小型模型的内部运作原理或大型模型的单一层次。

但如果要对可解释性的研究进行更深入的探索,就需要涉及到解析大型模型中复杂的分层算法。

这一次,谷歌 DeepMind 的研究人员在 Gemma 2 2B 和 9B 的每一层及子层的输出上,均训练了稀疏自编码器。

这样构建出的 Gemma Scope,总共创建了超过 400 个稀疏自编码器,提取了超过 3000 万个特征(尽管许多特征可能存在重叠)。

这样,研究人员就可以研究特征在整个模型中的变化方式,以及它们如何相互作用,如何组合成更复杂的特征。

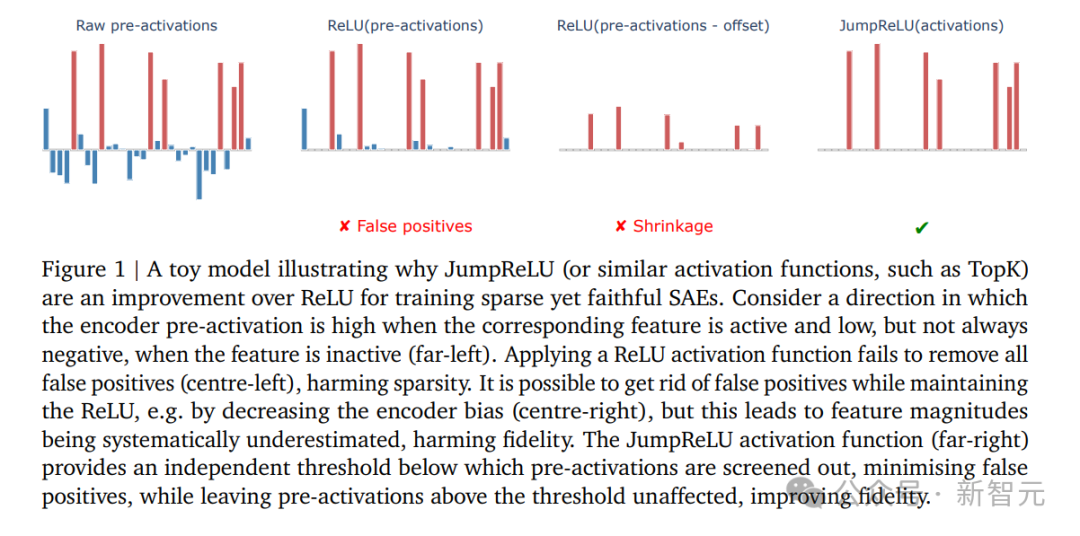

此外,Gemma Scope 使用了最新且最前沿的 JumpReLU SAE 架构进行训练。

原始的稀疏自编码器架构常难以在检测特征和估计强度这两个目标之间达到平衡,而JumpReLU架构则能更轻松地实现这种平衡,并且显著降低误差。

当然,训练如此众多的稀疏自动编码器也是一个重大的工程挑战,需要大量的计算资源。

在这个过程中,研究人员使用了 Gemma 2 9B 进行训练,计算量大约占总量的15%(不包括生成蒸馏标签所需的计算)。他们将大约20 PiB的激活数据保存到磁盘上(这大约等于一百万份英文维基百科的内容),并总共生成了数千亿个稀疏自编码器参数。

参考来源:

本文转载自微信公众号:微信公众号(ID:null),作者为新智元,原标题为《iPhone也能跑2B小钢炮!谷歌Gemma 2来袭,最强显微镜剖析LLM大脑》。

大家在看