图灵奖得主 LeCun 加入 AI 芯片新秀 Groq,该公司估值 28 亿美元,正向英伟达发起挑战。

编辑日期:2024年08月06日

成立于2016年的初创企业Groq,在最近一轮的融资活动中筹集了6.4亿美元。本次融资由BlackRock Inc.旗下的基金领投,并获得了来自思科及三星投资部门的支持。

目前,Groq的市场估值已达到28亿美元。公司的创始人Jonathan Ross曾在谷歌负责TPU芯片的研发工作。而现在,Groq的核心产品LPU主要用于加速AI基础模型,特别是大型语言模型(LLM)的运行。

Ross 表示,一旦人们体验到在Groq的高速引擎上使用大型语言模型是多么便捷,大型语言模型的应用将会进一步普及。

以更低的价格和能耗实现与英伟达芯片相同甚至更快的速度,这让Groq有足够的信心与英伟达竞争。值得一提的是,Groq还宣布图灵奖得主LeCun即将担任其技术顾问。LeCun的正式加入,将成为Groq在这个竞争激烈的芯片领域中一个强大的盟友。

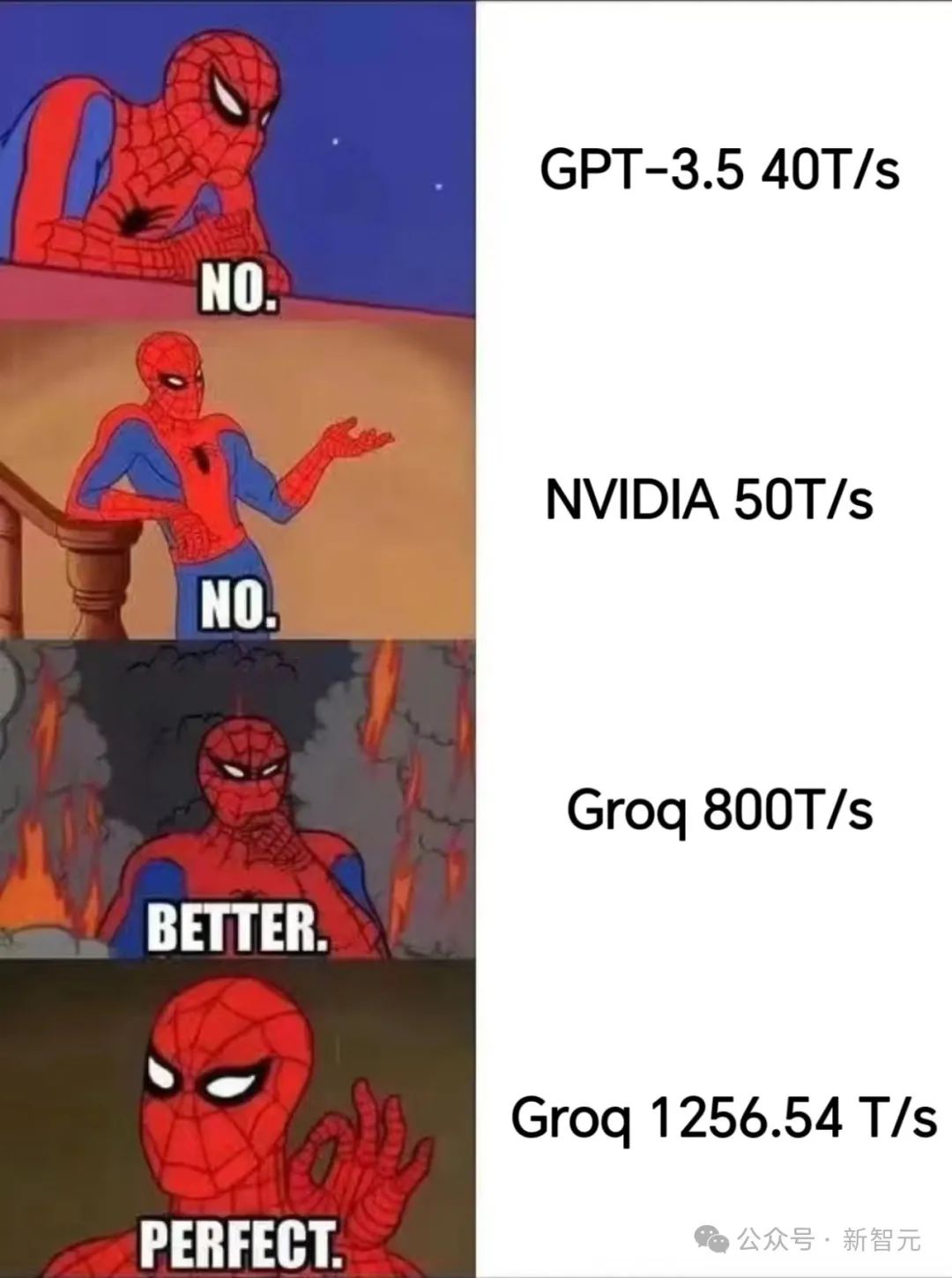

天下武功,唯速不破。而能够超越每秒处理800个token的Groq的,唯有下一代的Groq。

从每秒处理 500 个令牌到 800 个,再到 1256.54 个令牌,Groq 的速度之快使得许多 GPU 都望尘莫及。

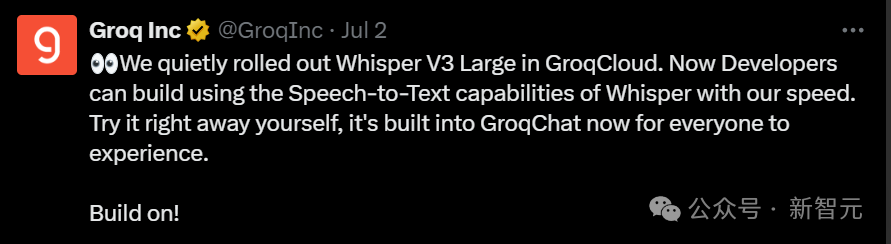

随着7月初的新功能低调推出,Groq现在的表现比之前的演示快了很多,也更智能化了。现在不仅支持文本查询,还可以通过语音命令来进行查询。

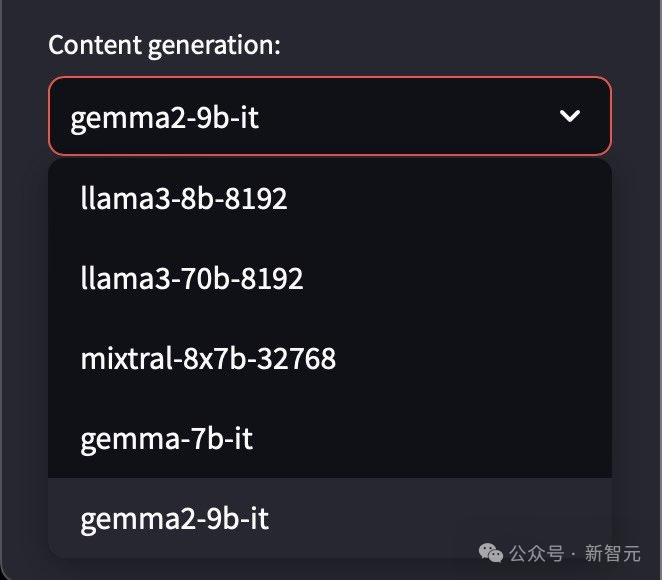

默认情况下,Groq的网站引擎采用的是Meta的开源Llama3-8b-8192大型语言模型。

用户还可以选择更大的Llama3-70b,以及来自Google的Gemma和Mistral模型,同时很快也将支持其他模型。

这种快速且灵活的体验对开发者来说非常重要。在传统的AGI处理数据时,往往需要习惯等待,因为通常要观察字符逐一输出后才能进行下一步操作。

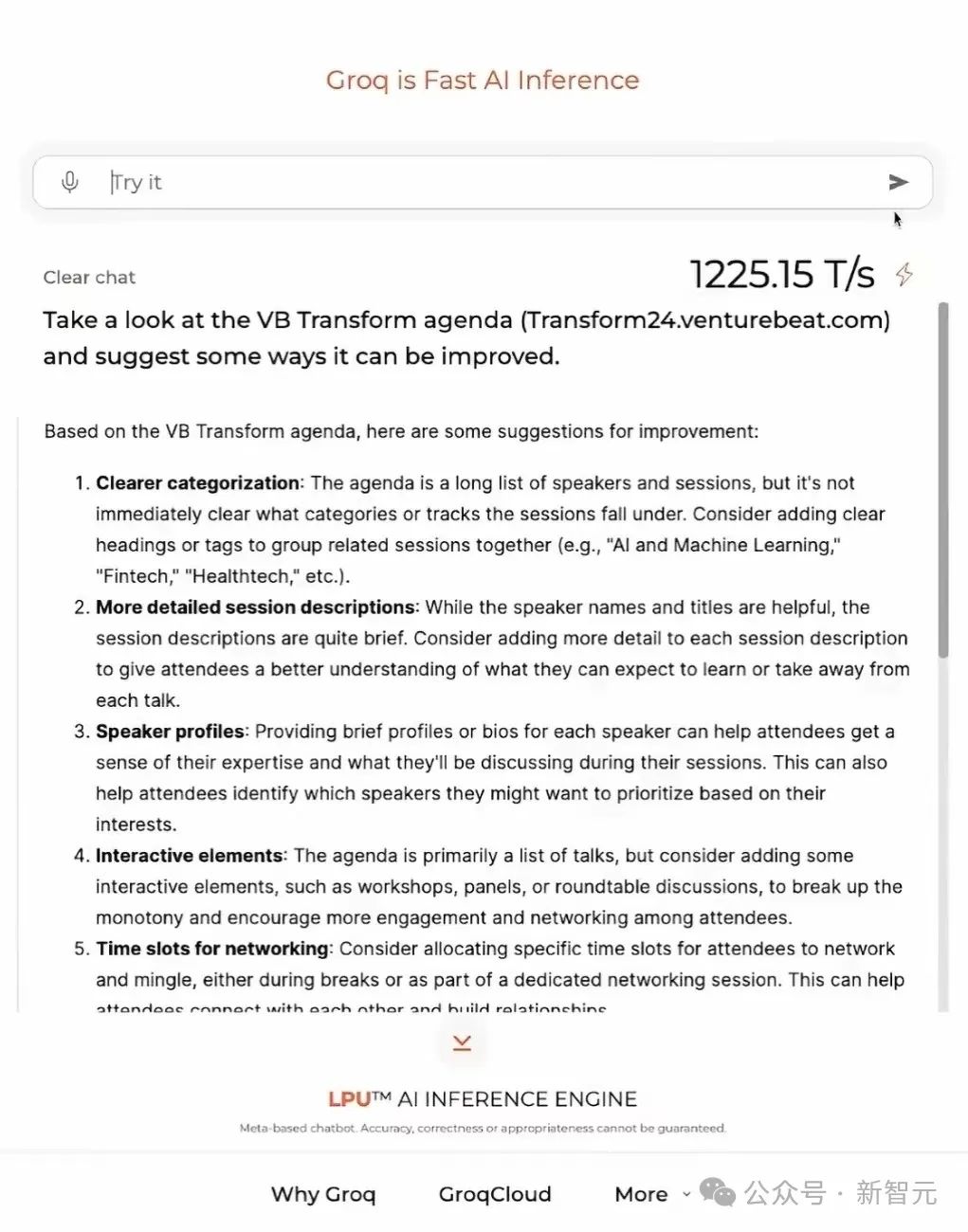

在Groq的最新版本中,上述任务几乎都能得到瞬时响应,速度极快。来举个例子。比如,在Groq上让它评价VB Transform活动议程有哪些可以改进的地方。

以1225.15令牌/秒的速度,几乎瞬间就弹出了回答。

并且内容非常具体明确,包含了十项改进建议,如建议更清晰的分类、提供更详细的会议描述和更完善的演讲者简介等。

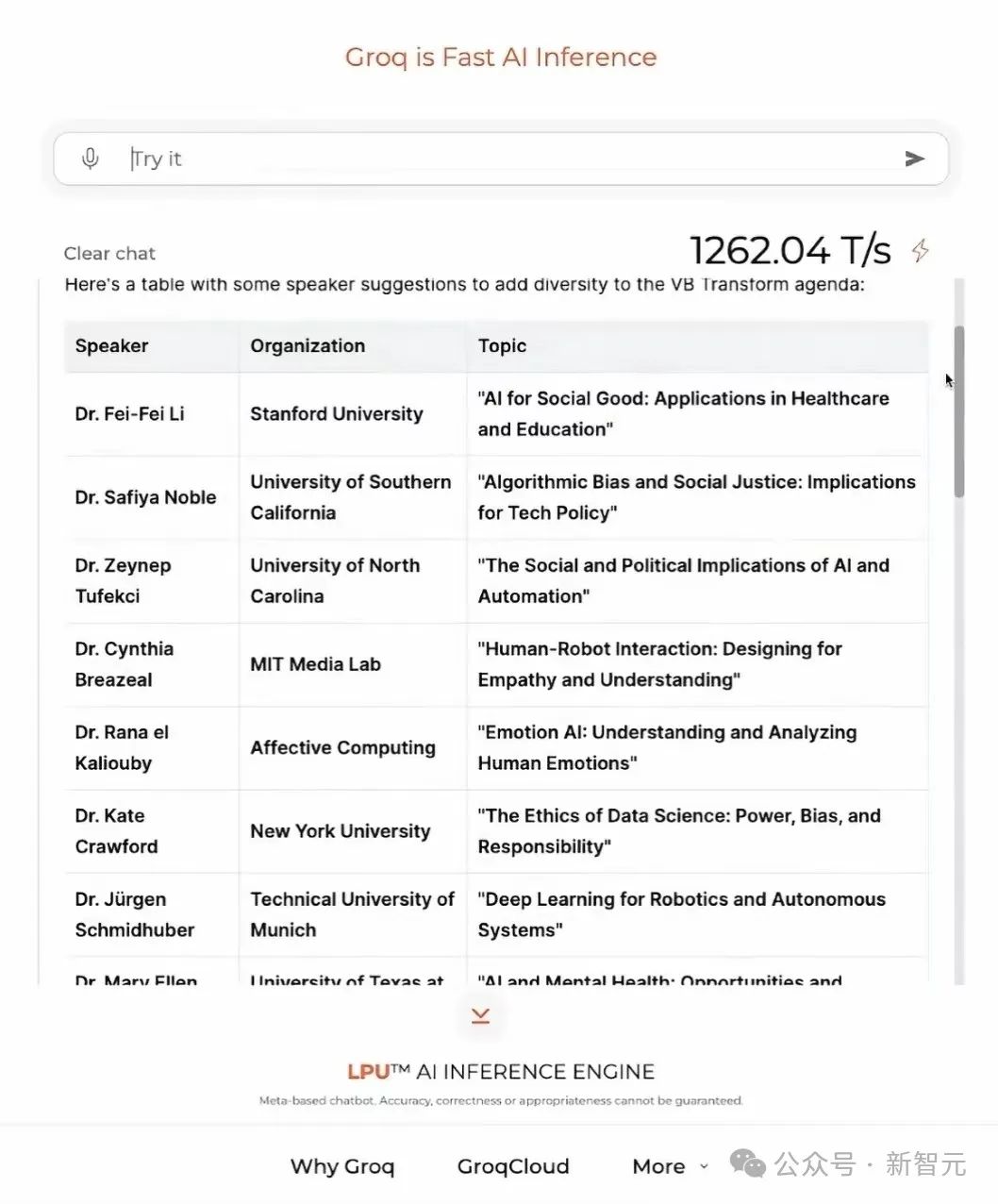

当语音输入请求推荐一些出色的演讲人以使阵容更多元化时,它会立即生成一个列表,包括姓名、所属机构及可选的演讲主题,并清楚地以表格形式呈现给您。

要求它添加一列联系方式,它也能立刻补充好邮箱地址和推特账号,完全不成问题。

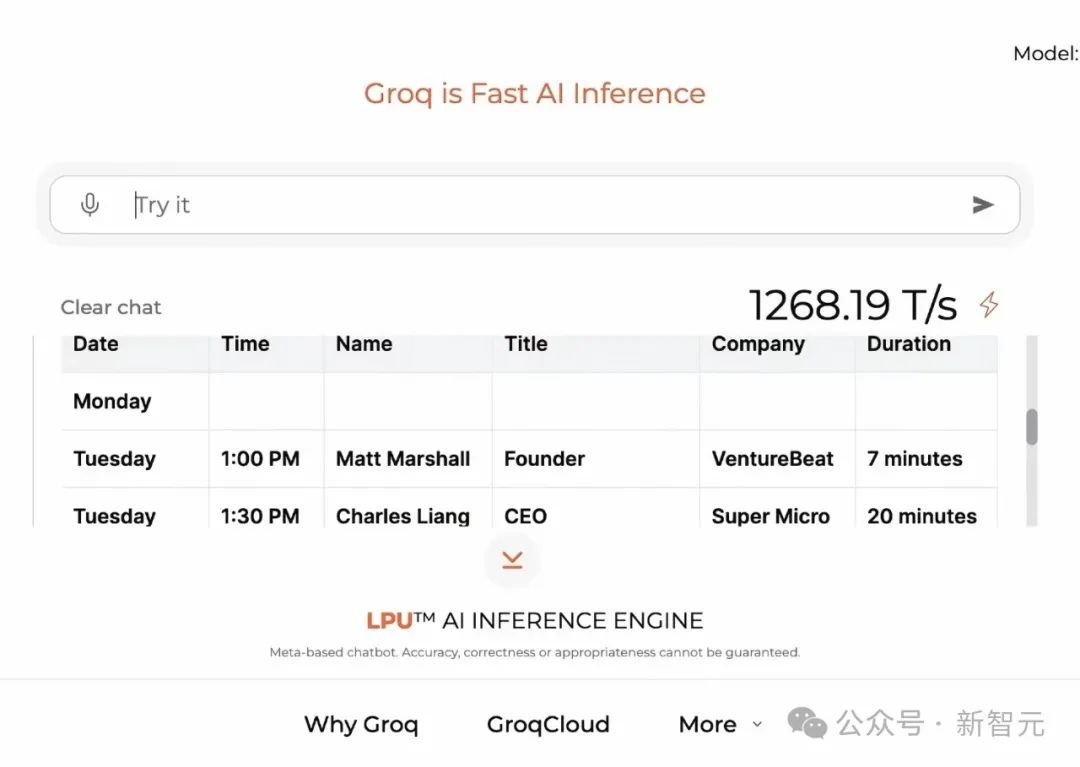

再举个例子。在视频中,巴拉巴拉说了一分多钟,要求Groq为下周的演讲课程创建一个日程安排表。

Groq不仅耐心地理解并创建了所需的表格,还允许快速简便地进行修改,包括拼写纠正。

还可以选择变更要求,让对方为我忘记请求的内容增设额外的栏目,始终保持着耐心、高效与细致的态度。在甲方眼中,这样的乙方简直就是完美的存在。

还可以将其翻译成不同的语言。有时可能会出现需要发出多次请求才能进行修正的情况,但这类错误通常出现在LLM层面上,而非处理层面上。

可以说,从每秒500个令牌到每秒800个令牌,而现在直接提升到每秒数千个令牌的生成速度,这让GPT-4和Nvidia的表现更加突出。

当然,除了“快速”之外,这次更新的另一个亮点是在引擎内直接输入查询之外,还允许用户通过语音命令进行查询。

Groq 使用了 OpenAI 最新的开源自动语音识别与翻译模型 Whisper Large v3,将语音转录为文本,随后将此文本作为大型语言模型(LLM)的提示输入。

通过提速和增强多模态输入,实现了流畅操作且无需打字,这种创新的使用方式极大地便利了用户。

7月17日,Groq的研究科学家Rick Lamers在推特上公布了一个“秘密项目”——微调后的Llama3 Groq合成工具使用模型8B和70B版本,旨在增强AI在工具使用和函数调用方面的能力。

团队采用了全量微调和直接偏好优化(DPO)的结合方法,并且完全使用了合乎道德规范的生成数据,过程中未涉及任何用户数据。

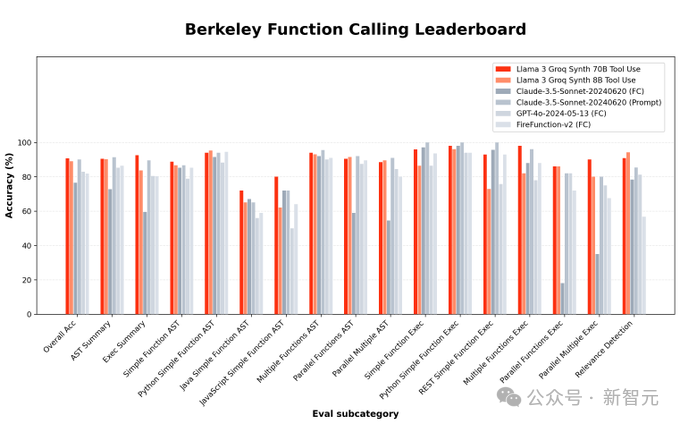

伯克利函数调用排行榜(Berkeley Function-Calling Leaderboard, BFCL)中的所有数据均源自现实世界,专门用于评估LLM在调用工具或函数方面的能力。

Groq本次发布的微调版Llama3 8B和70B,在BFCL上都取得了相当亮眼的成绩,总体准确率分别达到了90.76%和89.06%。

其中,70B版本的得分超越了Claude Sonnet 3.5、GPT-4 Turbo、GPT-4o和Gemini 1.5 Pro等专有模型,位居BFCL排行榜榜首。

两个版本的模型均已开源,用户可以从HuggingFace上下载模型权重,或者通过GroqCloud进行访问。

HugggingFace 的地址:https://huggingface.co/ Groq

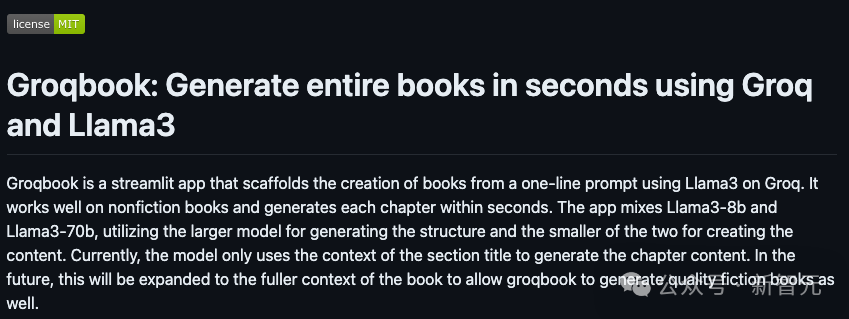

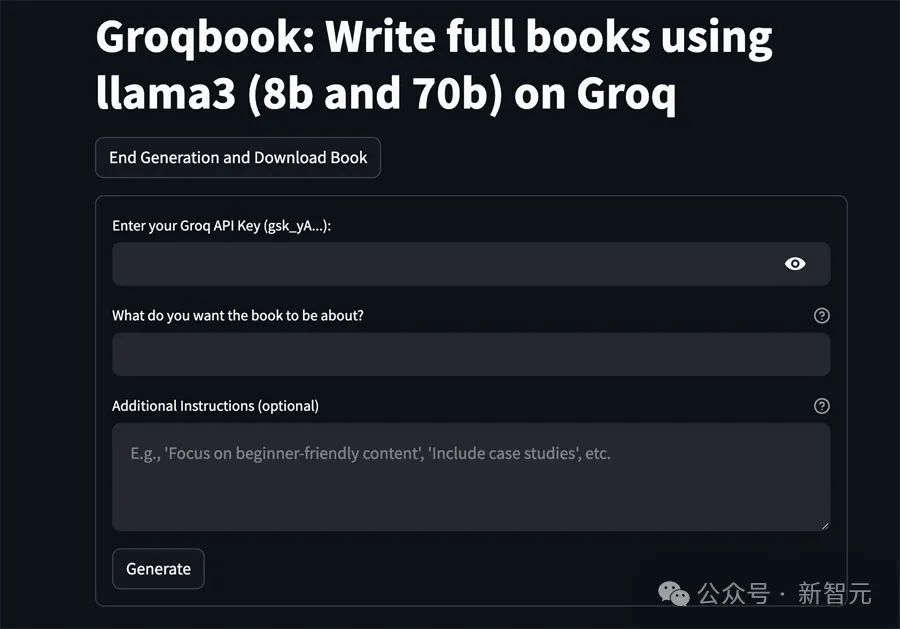

此外,Groq 在 Llama 3 的基础上进一步发挥了其「速度至上」的理念,推出了一款名为 Groqbook 的应用程式,能够实现在 1 分钟内生成一整本书的功能。

根据GitHub主页上的介绍,Groqbook结合使用了Llama3-8B和70B两个模型,先利用较大模型生成结构,然后由较小的模型来创作具体细节内容。

目前,此程序仅适用于非虚构类书籍,并需要用户输入每章节的标题以提供上下文信息。

Groq表示,未来会让Groqbook生成整本书的内容,并且扩展到虚构类书籍领域,以创作出高质量的小说。

解决了用户使用的核心痛点,Groq 自然受到了使用者的欢迎。

在上线4个月后,Groq已经开始免费提供处理大型语言模型工作负载的服务,这已经吸引了超过28.2万开发者使用。

Groq 提供了一个平台,供开发者构建他们的应用程序,这与其它推理服务提供商类似。

然而,Groq 的独特之处在于它让在 OpenAI 上开发应用的开发者能够通过简单的几步,在几秒之内将他们的应用迁移到 Groq。

Ross 表示他将很快转向需求巨大的企业市场。大型企业正在广泛部署 AI 应用,因此需要更强大的处理能力来应对他们的工作负载。

Groq表示,其技术在最坏的情况下的功耗大约仅为GPU的三分之一,而对于大部分的工作负载来说,功耗则仅有GPU的十分之一。

在LLM工作负载持续扩展和能源需求不断增加的背景下,Groq的高效能表现对GPU主导的计算领域提出了挑战。

尽管Nvidia在AI训练方面表现出色,但在推理领域存在局限性。相比之下,Groq的芯片在推理速度和成本上具有数倍的优势。预计未来推理市场的份额将从目前的5%增长到90%-95%。

Ross 自信地宣称,到明年年底,将会部署150万个LPU,占据全球推理需求的半壁江山。

目前,虽然模型训练首选GPU,但在部署AI应用程序时,更高的效率和更低的延迟同样至关重要。

正如 Groq 当初首次进入公众视线时仅凭一个字,“快”,Groq 这次的速度提升仍在速度的竞技场上疾驰飞奔。

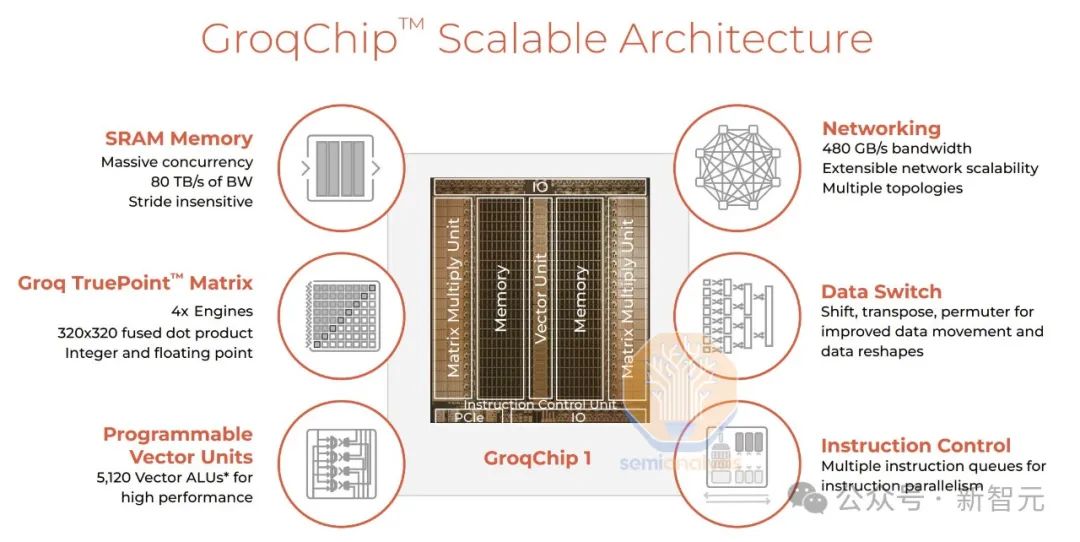

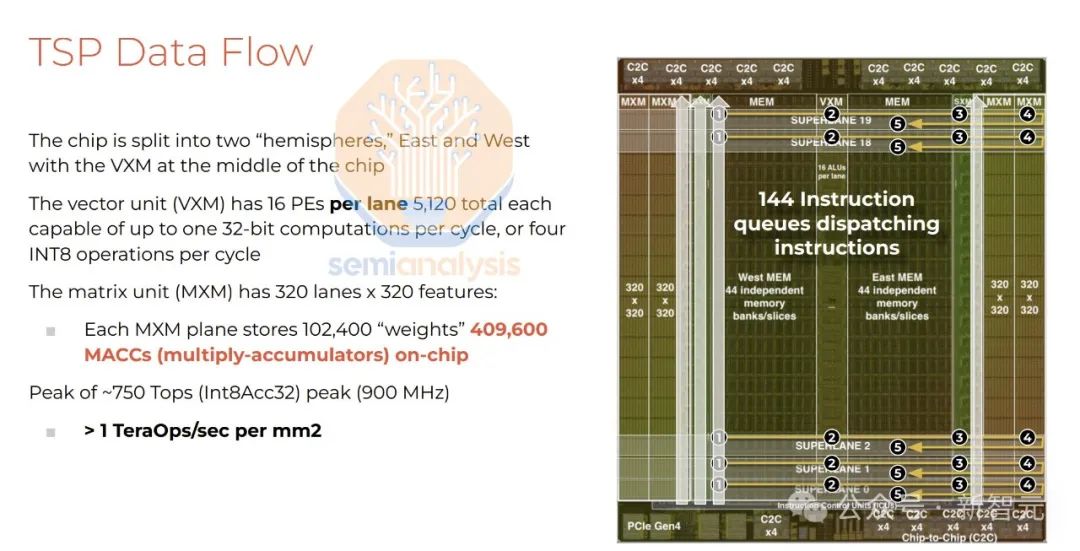

Groq承诺能以更快的速度和更低的成本完成任务,部分原因在于其语言处理单元(LPU)。

与GPU相比,LPU减少了管理多个线程的开销,并且避免了核心利用率不足的问题。此外,Groq的芯片设计还能够实现多个专用核心的连接,而又不会出现传统上的GPU集群中的瓶颈问题。

LPU的工作原理与GPU有显著区别。具体而言,LPU采用了时序指令集计算机(TISC)架构。这种架构的特点是不需要像GPU那样频繁地从内存中调取数据,因此不必依赖高带宽存储器(HBM)。

LPU不依赖于外部内存,其权重、键值缓存(KV Cache)及激活函数等数据在处理过程中全部存储在芯片内部。这种方法不仅能巧妙地避开因HBM短缺带来的问题,还能实际有效地降低生产成本。

与Nvidia GPU对高速数据传输的依赖不同,Groq的LPU在其系统架构中未采用HBM,而是选择了SRAM。

由于每块芯片只配置了 230MB 的 SRAM,因此没有复杂的模型能够通过单一芯片单独运行。需要指出的是,SRAM 的速度大约比 GPU 使用的内存快 20 倍。

鉴于AI的推理计算所需的数据量比模型训练大幅减少,Groq的LPU展现出了更加出色的节能优势。

在执行推理任务时,它从外部内存读取的数据量显著减少,且相比GPU,其电力消耗也明显降低。

遗憾的是,NVIDIA的GPU可以同时用于训练和推理,但LPU仅被设计用于模型推理。

参考来源:

本文出自微信公众号:微信公众号(ID:null),作者为新智元。