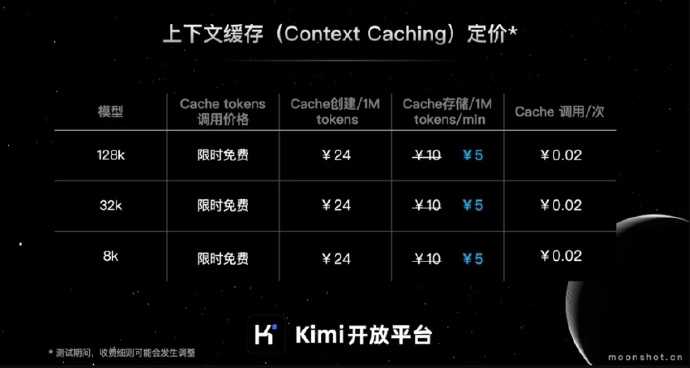

月之暗面 Kimi 开放平台的上下文缓存 Cache 存储费用降低了50%:现在的价格是每分钟每1M tokens 5元。

编辑日期:2024年08月07日

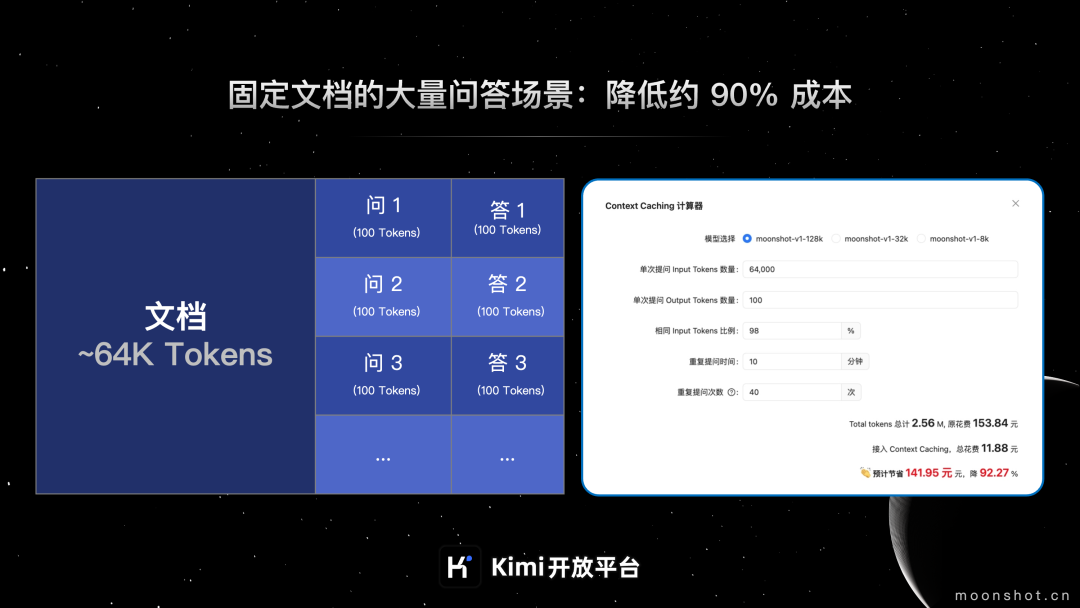

7月1日,Kimi开放平台启动了上下文缓存(Context Caching)功能的公测。据官方介绍,在API价格保持不变的情况下,这项技术能够帮助开发者减少高达90%的长文本旗舰大模型使用成本,并同时提高模型的响应速度。

以下是Kimi开放平台上下文缓存功能公测的详细信息:

据介绍,上下文缓存是一项数据管理技术,它可以让系统预存大量经常被请求的数据或信息。当用户请求相同信息时,系统能直接从缓存中提供,无需再次计算或从原始数据源中检索。

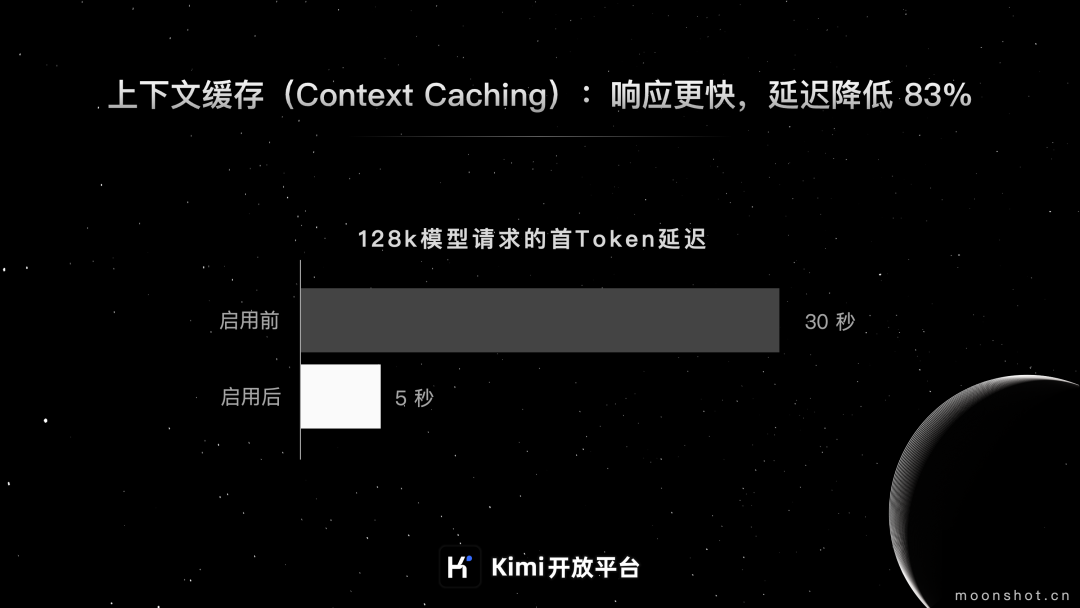

上下文缓存适用于那些经常需要处理大量初始上下文的频繁请求场景,它可以有效减少处理长文本模型的成本并提升效率。据官方介绍,采用这种方法最高可以减少90%的费用,并且将首个Token的延迟时间降低83%。以下是适用这种技术的业务场景:

上下文缓存的收费模式主要分为以下三个部分: