AI美女全面失败:在网络真伪鉴别下集体变成“妖怪”,AI代码揭露AI生成图像的真相。

编辑日期:2024年08月12日

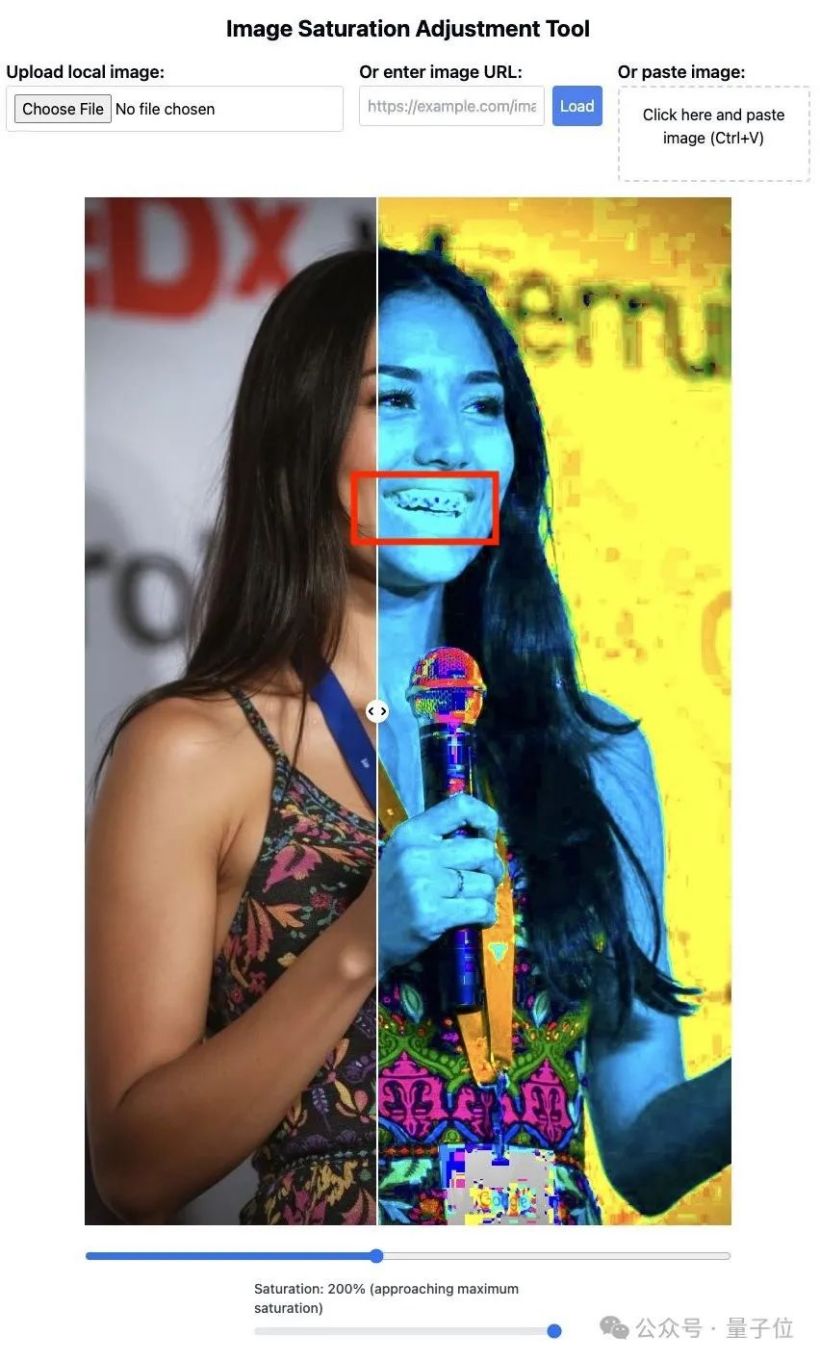

来看它的牙齿。

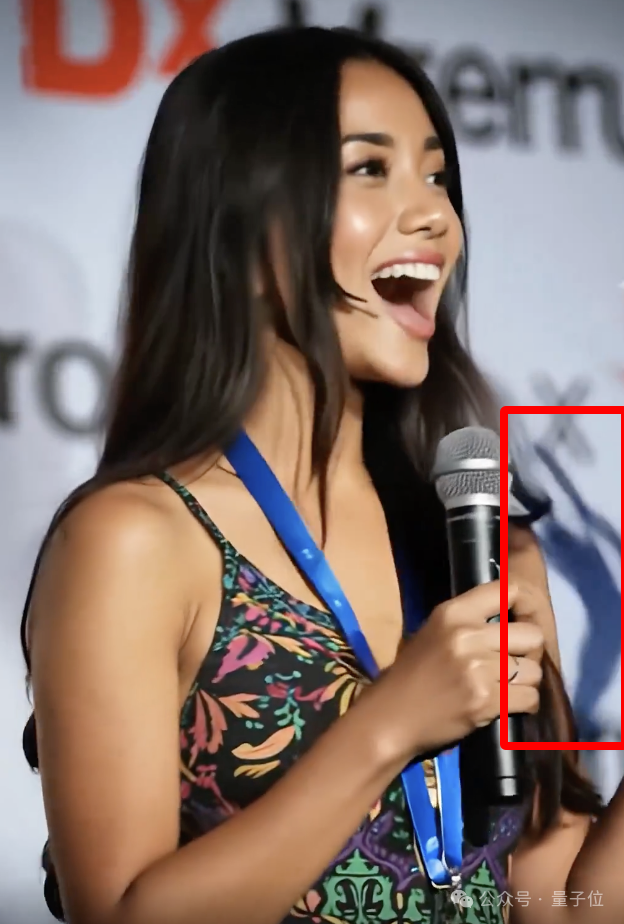

将图像的饱和度调到最大,AI人像的牙齿会变得异常诡异且边界模糊不清。此外,整张图片的颜色也不自然,尤其是麦克风部分显得格外奇怪。

与真实的人类照片对比,应该是这样的:牙齿清晰可见,图片中的色块均匀一致。

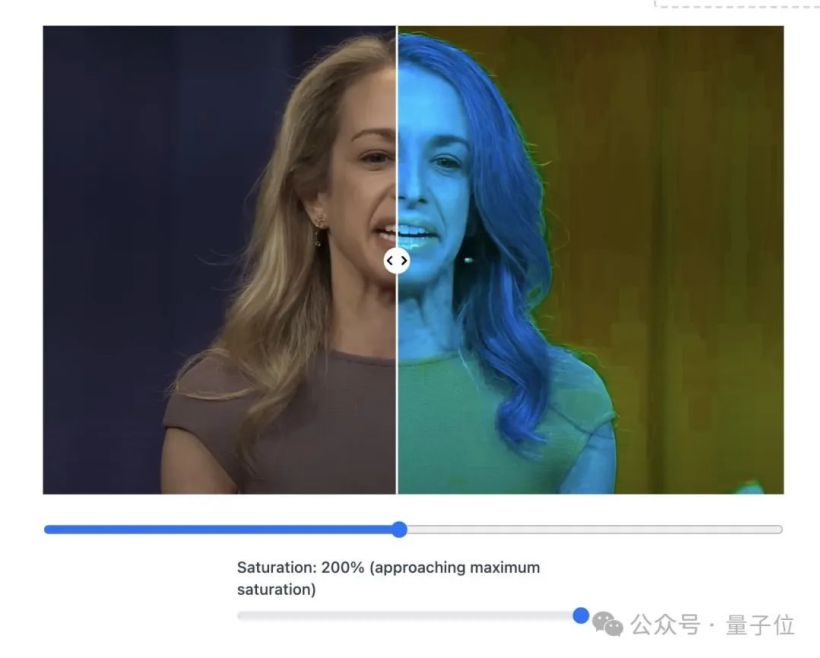

这个工具现在已经公开,任何人都可以拿自己的照片去尝试。即使是 AI 生成的视频中的一帧画面,也难以逃脱这种方法的应用。

即使不露出牙齿的照片也会暴露问题。

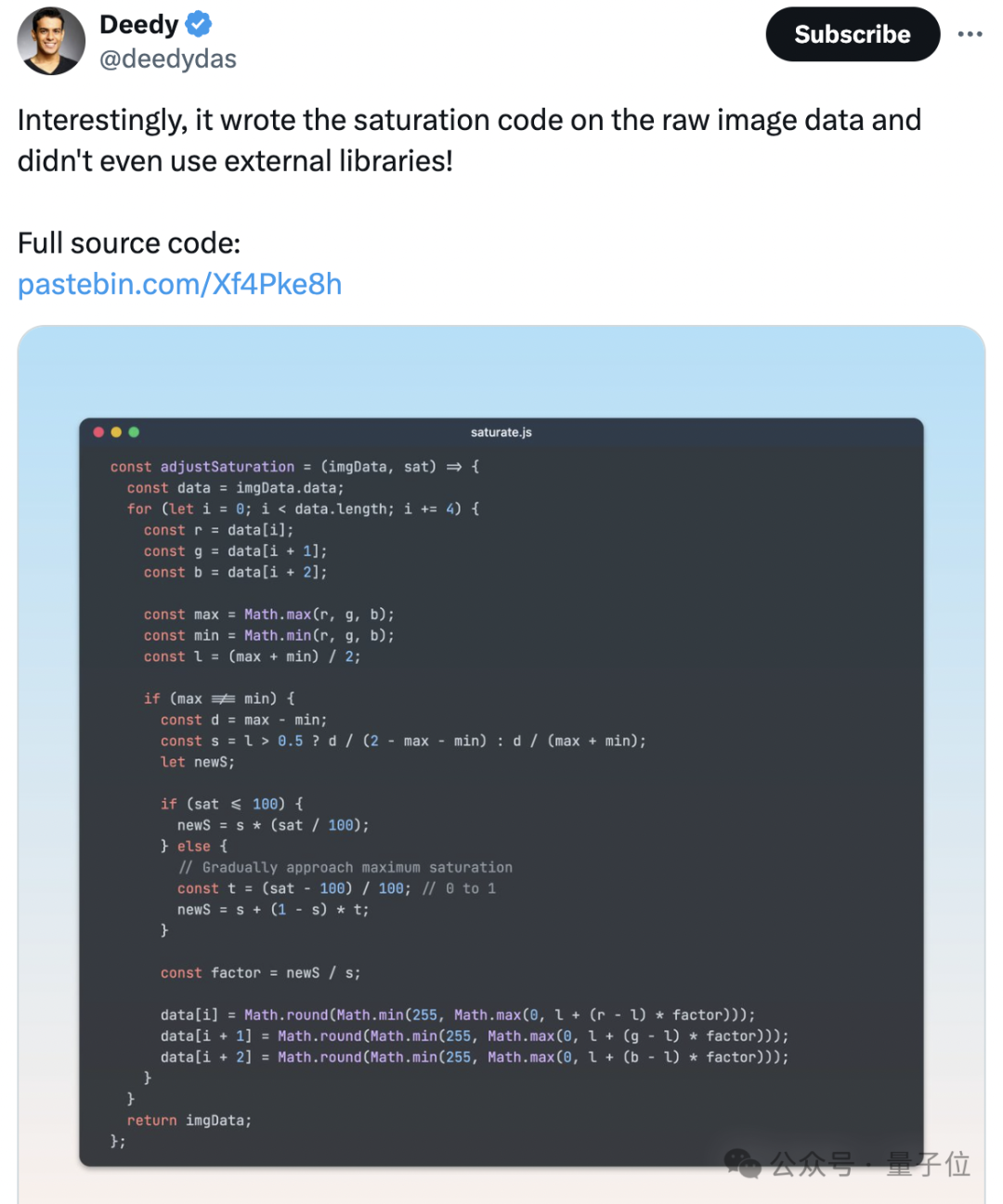

不过话说,这个工具是克劳德制作的。用AI来破解AI,真是个有趣的循环。

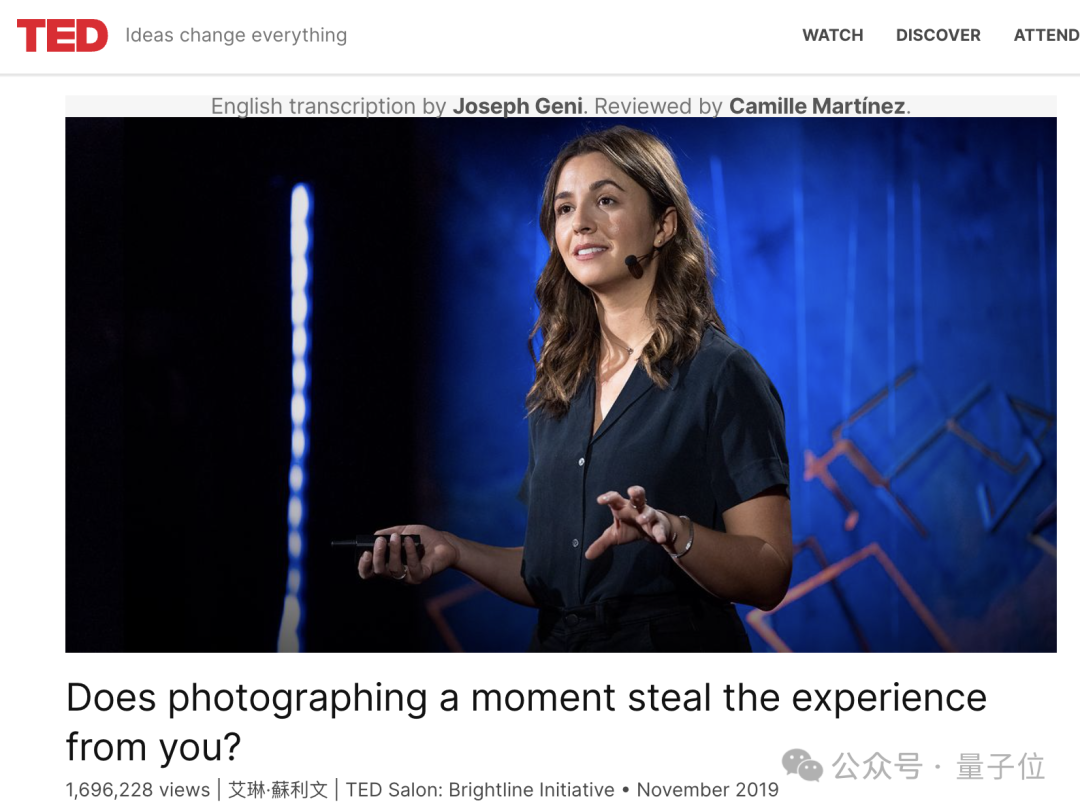

说实话,最近的AI生成的人像非常逼真,这也引发了不少讨论。例如,有一组非常热门的"TED演讲者视频",实际上那些演讲者没有一个是真人。

不仅人脸难以分辨,就连之前AI的弱点——书写文字,现在也能做到几乎真假难辨。

更重要的是,创建这类 AI 人像的成本并不高。只需短短5分钟,每20秒1.5美元(大约人民币10元)即可完成。

这下网友们可坐不住了,纷纷发起了一场AI辨真伪的大赛。近5千人参与讨论,争论这两张图中哪一张是真实人物。

给出的理由多种多样。有的人认为文字和花纹细节过于抽象,而有的人则觉得人物的眼神显得空洞……

最先进的AI生成人像的规律,正逐渐被人们摸索出来。

综上所述,调整饱和度可能已经成为目前最便捷的识别手段。在这种方法的作用下,AI合成图像是其弊端展现得更为明显。

不过,它存在一个问题。如果图像经过JPEG算法压缩后,这种方法可能会失效。

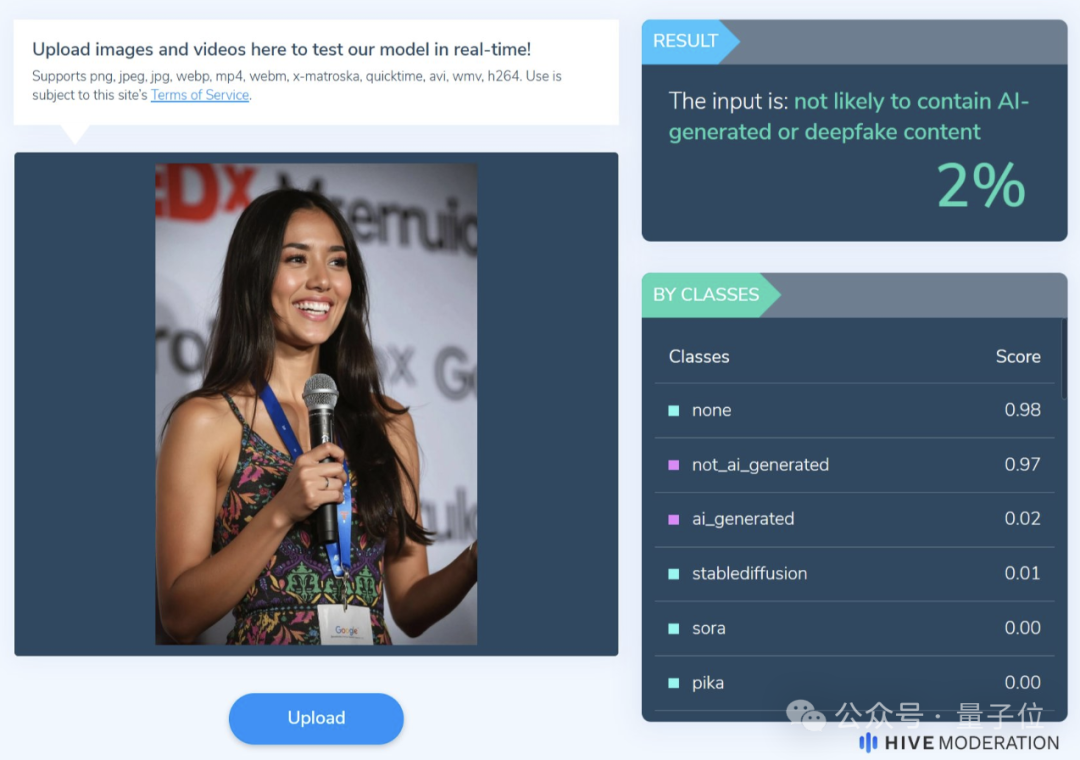

例如,确认这张照片是真实的人像照片。

但由于图像压缩和光线等问题,人物的牙齿部分有些模糊。

因此,网友们还列出了更多辨别图像是否为AI合成的方法。

第一种方法,简单来说就是依赖人类的知识和判断。

由于人工智能在学习图像时采用的方法与人类不同,因此在理解所有人类视角下的视觉信息方面可能存在局限性,并不能完全掌握。这种差异导致了人工智能生成的图片往往会出现与现实世界不相符的情况,这为人们识别和判断这些图片的真实性提供了一个切入点。

以开头的这张图片作为例子。

从整体来看,人物的皮肤显得过于光滑,没有任何毛孔的痕迹,这种过于完美的特征反而增添了不真实感。

当然,这种“不真实感”并不完全等于“造假”,毕竟经过磨皮处理的图片也同样无法看到毛孔。但这并不是唯一的评判因素,AI在图片中留下的不符常识的地方也不一定只有一处。

实际上,只要仔细观察这张图的一些细节,就可以发现一个比较明显的特征——胸牌上方挂钩的连接方式十分独特。

还有在高饱和度模式下会暴露问题的麦克风,放大后可以直接用肉眼看出其中的破绽。

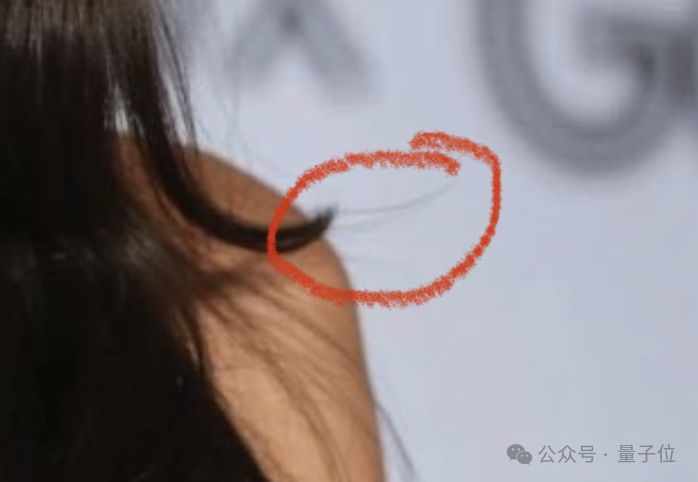

更为隐秘的是,有几根头发位于发梢处的位置实在不太合理,但要发现这种特征,恐怕得具备列文虎克那样的视力才行。

然而,随着生成技术的不断发展,可以找到的特征正变得越来越隐秘,这已成为无法避免的发展趋势。

还有一种方法是通过文字来辨认,虽然AI在字体刻画上正在逐步克服“鬼画符”的问题,但在准确地呈现出具有实际正确意义的文字上仍存在一些挑战。

例如,有网民发现,照片中人物佩戴的胸牌上,Google标志下方的最后一行字里有两个字母是“CA”,代表美国加州,而前面的那一长串字符可能代表的是城市名称。

但实际上,加州并没有任何城市的名字有这么长。

除了这些物品本身的细节外,还可以利用光线和阴影等信息来判断真伪。

这张图片是从一个视频中截取的,在其原始视频中还存在这样一帧画面。在麦克风右侧,出现了一块非常奇怪的阴影,这部分阴影实际上代表人物的一只手。显然,这里的AI处理存在一些不足之处。

说到视频,由于涉及前后内容的一致性,AI相较于在静态图像中更容易暴露破绽。

还有一些特点并不算是“常识性的错误”,但它们反映出了AI在生成图像时的一些偏好。

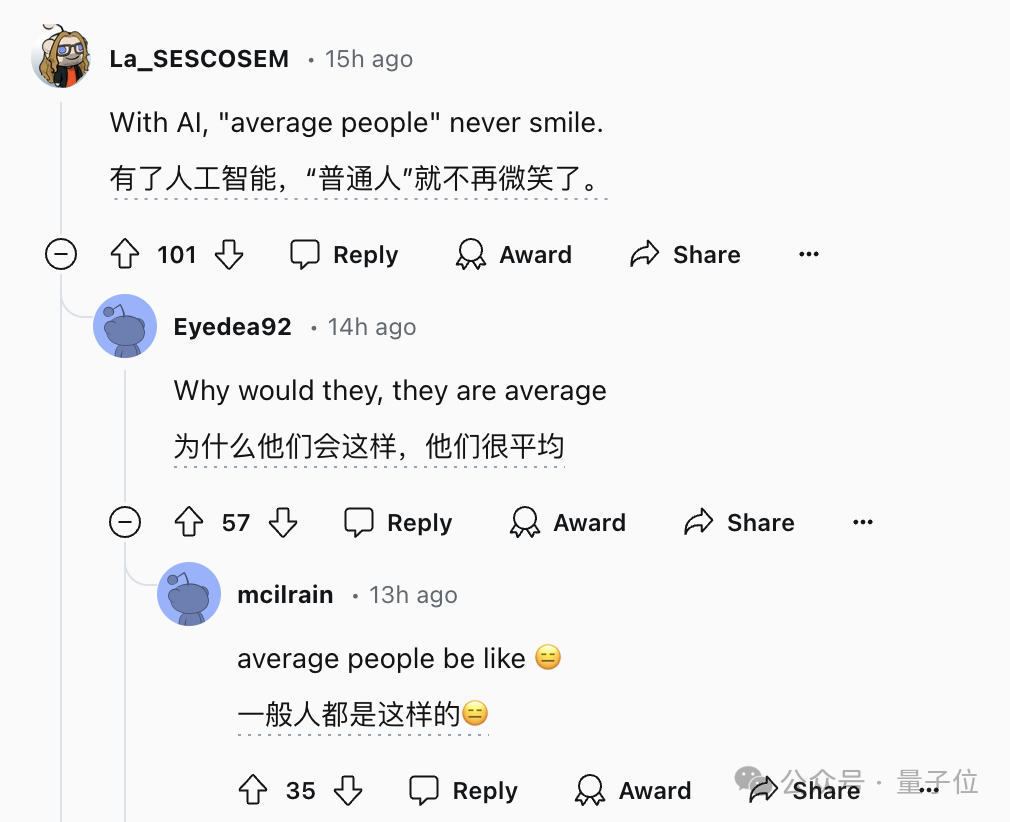

比如这四张图片,都是由AI合成的“普通人物”(average people),有没有发现什么共通之处?

一些网友指出,在这四张图片中,没有一个人是笑面迎人的,这似乎反映出了AI生成图像的某个特点。

对于这几张图来说确实如此,但这种评价方法很难形成一个系统性的标准,因为不同的AI绘图工具都有其各自的特点。

总之,为了应对不断进步的AI,我们可以一方面加强“列文虎克”式的观察力度,另一方面引入如提高图像饱和度等图像处理技术。

但如果这种“量变”的积累越来越多,用肉眼来进行判断就会变得越来越困难,图像的饱和度也可能有一天会被AI技术突破。因此,人们正在转变思考方式,采用“以模制模”的策略,利用AI生成的图像来训练检测模型,从而能够从图像中分析出更多的特征。

例如,AI生成的图像在频谱和噪声分布等方面有许多独特特征。这些特征无法通过肉眼辨识,但AI却能够清晰地识别它们。

当然,这也不能排除检测方法可能落后、无法跟上模型的变化,甚至模型开发者专门进行对抗性开发的情况。例如,前面提到的那张图片,某个AI检测工具判断其为AI合成的概率仅有2%。

但人工智能在伪造与检测之间的博弈过程,本质上就是一场“猫鼠游戏”。

因此,在依赖检测技术的同时,模型的开发者也应该承担起相应的责任,比如为AI生成的图片添加隐形水印,以此来防止AI进行伪造行为,确保其无法逍遥法外。

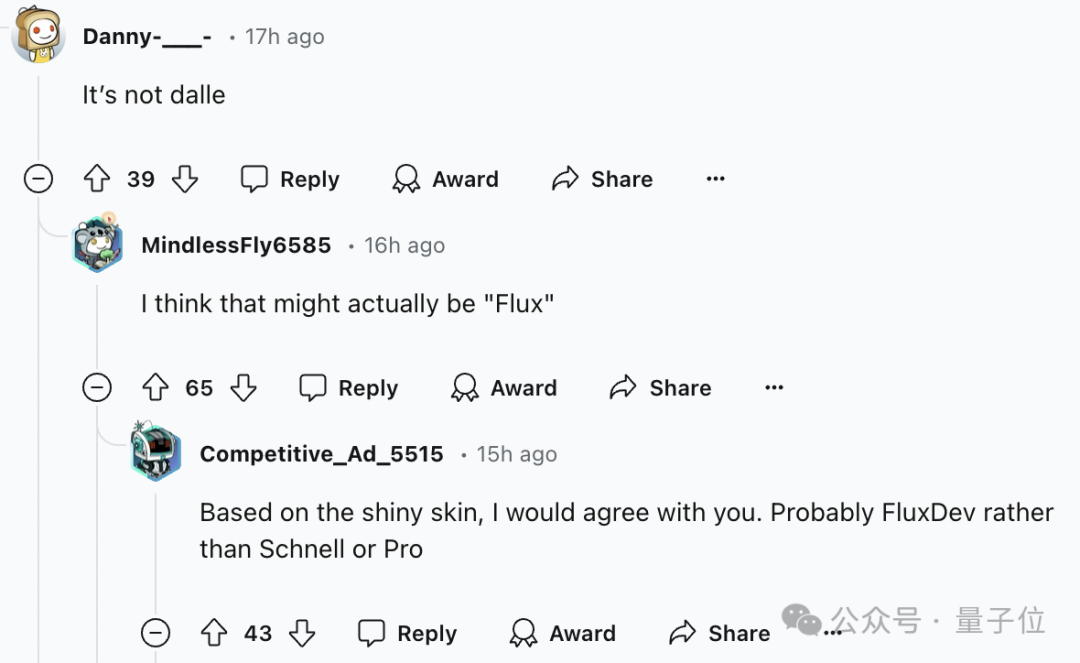

值得一提的是,许多上述引起恐慌的AI人像都由最近大热的Flux生成或参与制作。甚至大家已经开始默认,如果效果好到难以分辨真假的人像,大概率就是Flux的作品。

它是由Stable Diffusion的原团队制作的,发布仅10天就在网络上引起了巨大的轰动。

这些精美的假TED演讲的照片都出自它之手。

还有人使用 Flux 和 Gen-3 制作了精美的护肤品广告。

以及多种从不同角度的合成效果。

它很好地解决了AI绘制图像、AI生成图片中的文字等问题。

这直接导致现在人们在区分AI绘制的图像时,不能再直接看手部和文字来判断,而是必须仔细寻找细微的线索来进行猜测。

Flux主要针对手部动作和文字这类特定指标进行了强化训练。这表明,如果当前的AI系统继续专注于提高纹理细节、色彩还原等方面的训练水平,那么在未来的AI绘图模型出现后,人类对于图像的识别方式可能会再次面临挑战……

而且,Flux 是开源的,可以在笔记本电脑上运行。现在许多人已经开始忘记 Midjourney 了。

从Stable Diffusion到Flux耗时2年。而从“威尔史密斯吃面条”到“Tedx演讲者”则用时1年。

真不知道未来为了辨别由AI生成的内容,人们会想出什么奇招怪法......

参考链接:

注意:您提供的文本内容似乎不完整或者没有明确的原始文本,"参考链接"后面通常应跟着具体的网址或链接。如果需要重写某个具体句子或段落,请提供完整的原始文本信息。

本文转载自微信公众号:量子位(ID:QbitAI),作者:明敏、克雷西,原题目为《AI美女全面失守!在赛博照妖镜下集体变“鬼”,AI代码揭露AI生成图像的背后》。