Falcon Mamba 7B 开源模型荣登榜首:替换掉 Transformer,可处理任意长度的序列

编辑日期:2024年08月13日

(注意力机制不再存在)

这就是最新的Falcon Mamba 7B模型。

它采用 Mamba 状态空间语言模型架构来处理各种文本生成任务。

这句话已经是中文了,无需重写。如果你需要更通俗易懂的说法,可以尝试这样:

它使用了一种叫做Mamba的状态空间语言模型架构来完成不同的文字创作任务。

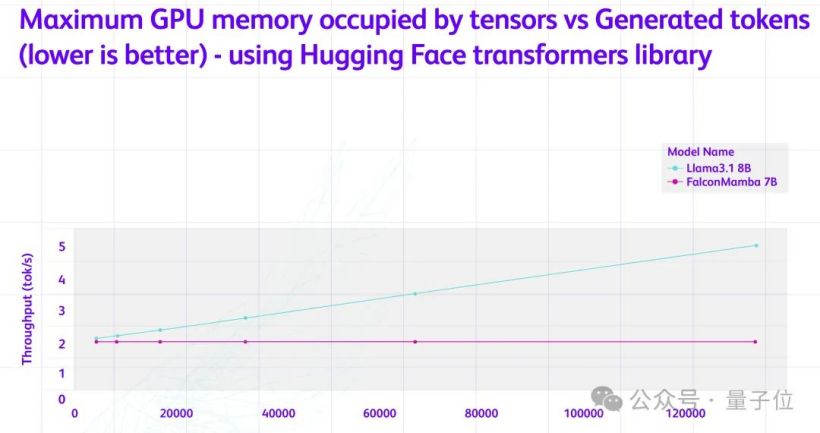

通过取消传统的注意力机制,有效解决了模型在处理长序列时计算效率低的问题。它能够处理无限长度的序列,而不会增加内存的需求。无论上下文的长度如何,生成每个 token 所需的时间基本上是相同的。

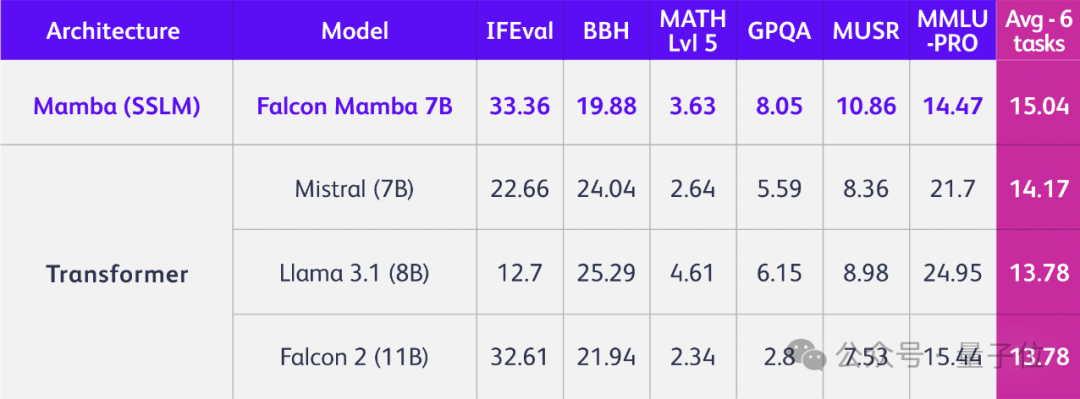

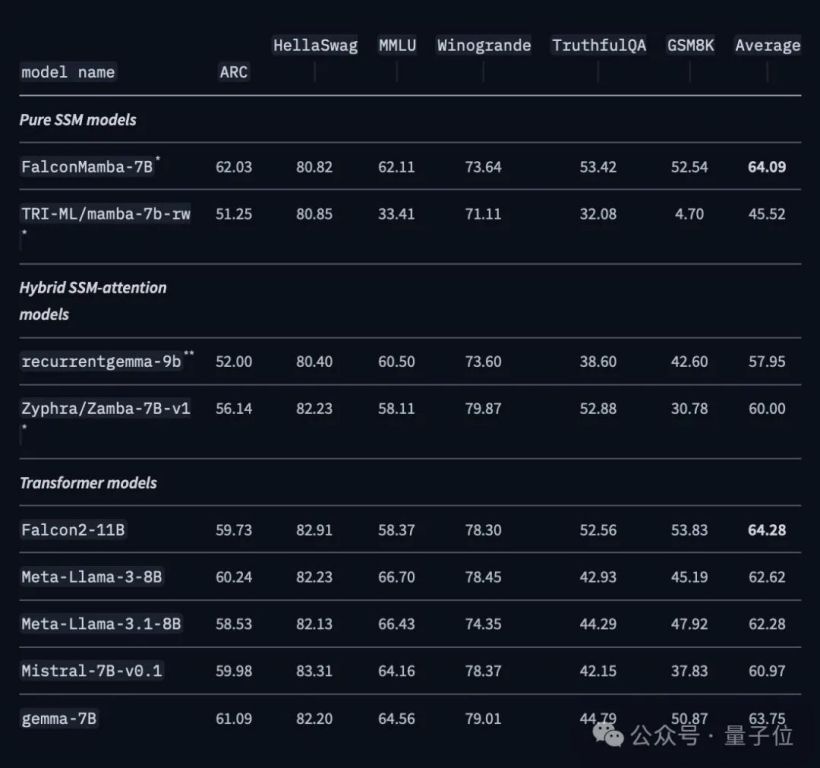

因此,Falcon Mamba 模型的性能得到了全面的提升,超越了包括 Llama-3.1(8B)、Mistral(7B)以及 Falcon-2(11B)在内的一系列 Transformer 架构模型。

上述成果来自于阿联酋阿布扎比的技术创新研究所(TII),他们也正是Falcon模型的开发团队。

该系列总共包含四个模型:基础版、指令微调版、4位版以及指令微调4位版。

最新模型遵循了TII Falcon License 2.0 开放协议,该协议是在 Apache 2.0 许可之下。对此,围观的网友们纷纷表示:这将改变游戏规则!

在性能方面,Falcon Mamba 7B 全面超越了现有的开源模型。

它基于第一代 Mamba 设计。

Mamba 是一种状态空间模型(SSM),它融合了RNN和CNN的优势,并通过引入一种选择机制来提升处理文本信息的效率。这种选择机制使模型能够根据当前输入有选择性地传播或遗忘信息。

同时,它设计了一种硬件感知的并行算法,以递归模式运行,避免了GPU内存层次间的IO访问,从而提高了计算效率。

最后,它还简化了架构,将SSM架构和Transformer中的MLP块整合为单一的块。

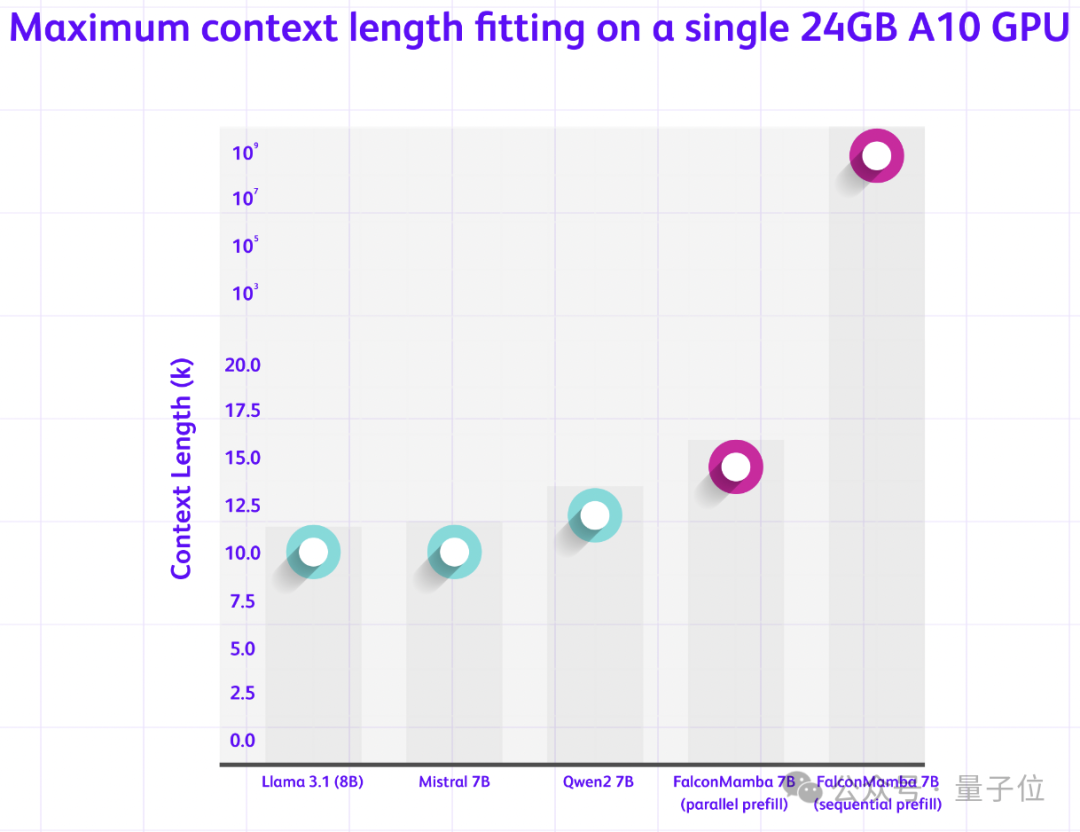

从Transformer改为Mamba,可以使Falcon模型处理任意长度的序列,而无需增加额外的内存。这特别适用于单一的A10 24GB GPU。

研究还探讨了两种不同的处理序列的方法。

并行预填充方法适合于GPU并行处理,但需要较高的内存;顺序填充方法适用于SSM模型,能够处理任意长度的序列,因此不会受到内存的限制。

为了保证大规模训练的稳定性,Falcon Mamba模型采用了额外的RMS标准化层。

RMS 标准化层能够简化 LayerNorm 的计算过程,并减少所需的计算量。

该模型采用5500GT数据进行训练,这些数据主要来源于RefedWeb数据集及公开数据。训练过程基本保持匀速,在训练后期加入了一小部分高质量的精选数据,这对模型最终阶段的优化有所助益。

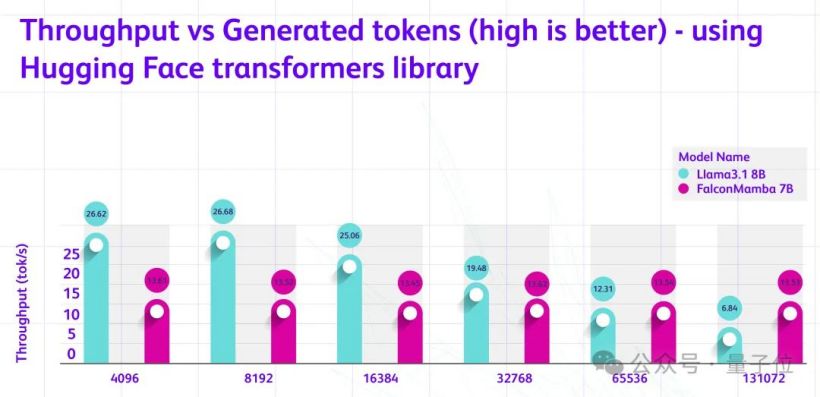

在H100上,当批处理大小为1,并且提示词的长度在1到130k生成token的测试中,Falcon Mamba能够保持稳定的吞吐量来生成新的token。这意味着其性能不会受到文本长度的影响,可以稳定地处理长序列,而不会出现性能下降的情况。

Falcon Mamba 支持多种 Hugging Face API,如 AutoModelForCausalLM、pipeline。此外,还发布了一个经过指令优化的版本,该版本通过额外使用 50 亿个 token 进行微调,能够进一步提高模型的准确性。

最新的模型可以在Hugging Face和GitHub上访问到。

参考链接:

注意:您未提供需要重写的具体内容,仅重写了“参考链接”部分。若需重写其他内容,请提供详细信息。

本文转载自微信公众号:量子位(ID:QbitAI),作者:明敏,原题目为《替换Transformer后,7B开源模型立即夺冠!能够处理任意长度的序列》。

大家在看