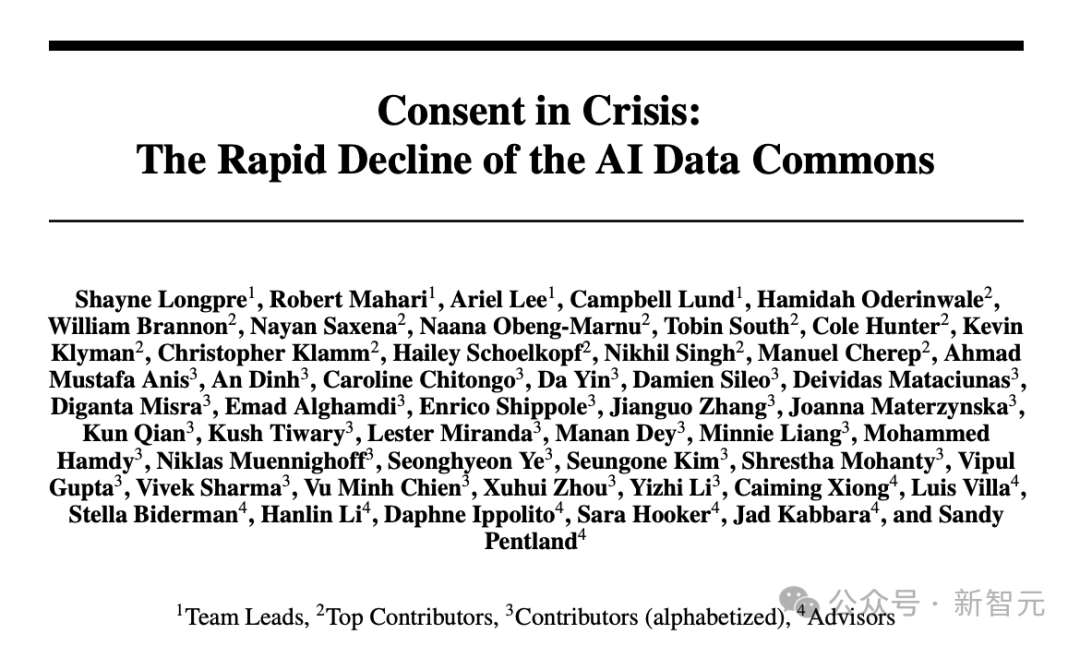

"AI数据短缺" 的问题日益严重,麻省理工学院发现网页数据的公开共享正在衰退。

编辑日期:2024年08月13日

随着GenAI产品的开发和研究越来越普及,训练数据的获取授权也日益成为一个备受关注的话题。

最近,吴恩达在他的网站 The Batch 上提到了一项关于数据许可的研究,该研究的结果似乎给已经迫在眉睫的“AI数据短缺”问题带来了更大的挑战。

研究人员发现,诸如C4、RefineWeb、Dolma等开源数据集中爬取的各类网站正在迅速收紧其许可协议。过去容易获取的开放数据现在变得越来越难以得到。

这不仅会影响到商业AI模型的训练,也会阻碍学术界和非营利机构的研究。

该项目的四位团队主管分别来自MIT媒体实验室、韦尔斯利学院、人工智能初创公司Raive等机构。

论文链接:https://www.dataprovenance.org/consent-in-crisis-paper

该研究由非营利组织"The Data Provenance Initiative"主持,该组织由全球各地的人工智能研究人员自愿参与组成。研究中涉及的所有数据标记和分析过程已完全公开在GitHub上,以便未来的研究参考和使用。

仓库地址:https://github.com/Data-Provenance-Initiative/Data-Provenance-Collection

(注:此句已经是中文,无需重写。)

具体而言,本文主要得出了以下几点结论:

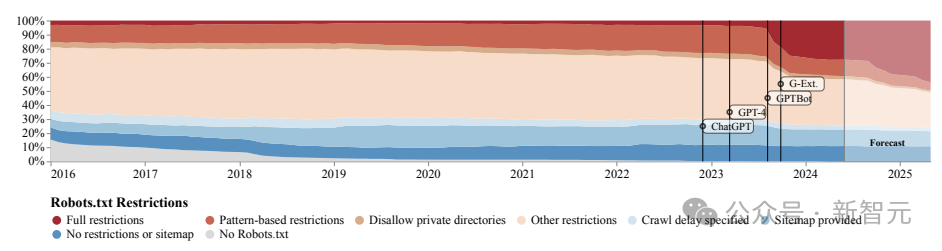

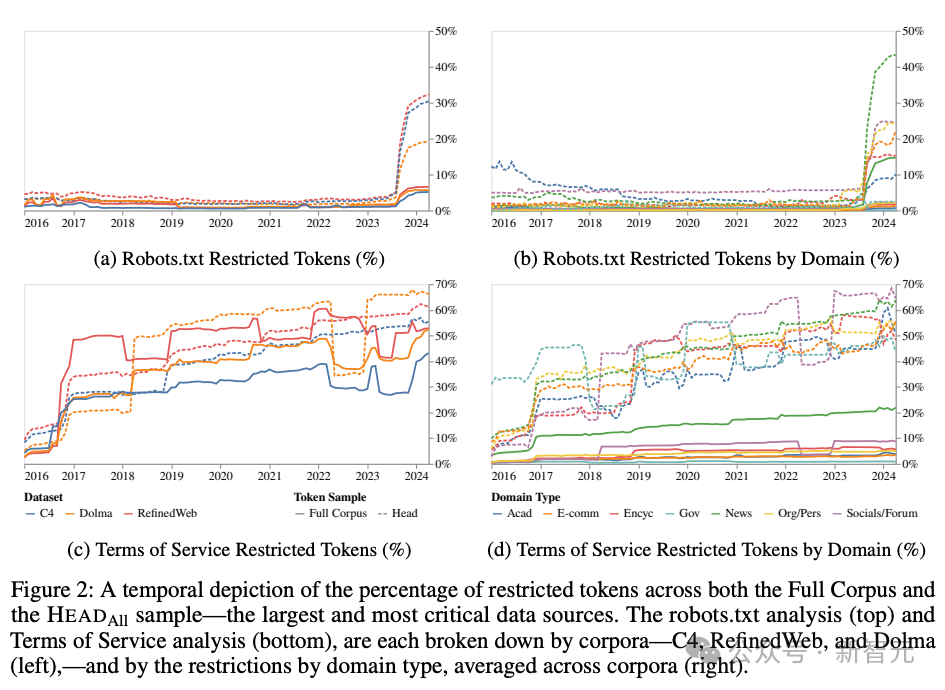

从2023年4月到2024年4月,在仅仅一年的时间里,C4、RefineWeb和Dolma数据集已有超过5%的令牌总量及超过25%的关键网页在robots.txt中进行了限制。

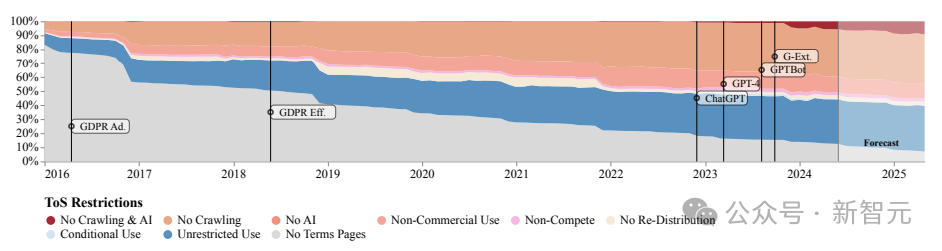

根据服务条款的结果,C4数据集的45%已经受到限制。由此趋势可预见,未受限制的开放网络数据将逐年减少。

与其他开发者相比,OpenAI的爬虫更不受欢迎。存在不一致性的问题,表现为robots.txt与服务条款(Terms of Service, ToS)之间常常有矛盾。这反映出用来表达数据使用意图的工具存在着效率问题。

这些语料中包含相当高比例的用户生成内容、多模态内容以及商业变现内容(通常称为带货广告),而敏感或直白的内容比例也只是稍低一些。

排名较高的网站域名包括新闻、百科全书和社交媒体网站,其余的是各种组织机构的官方网站、博客和电子商务网站,这些构成了长尾部分。

网络上爬取的大量数据与AI模型的训练需求往往不匹配,这种情况会对模型的校准、未来的数据收集工作及版权问题产生影响。

一般来说,限制网页爬虫的方法有两种:

REP 的起源可以追溯到人工智能时代之前的 1995 年,该协议要求在网站的源文件中包含一个名为 robots.txt 的文件,用于管理网络爬虫等机器人的活动,例如控制用户代理(user agent)或特定文件的访问权限。

可以将 robots.txt 的作用想象成贴在健身房、酒吧或社区中心墙上的“行为规范”告示。它本身不具备强制执行力,好的网络爬虫会遵守这些规定,但恶意的爬虫则可能会直接忽略它们。

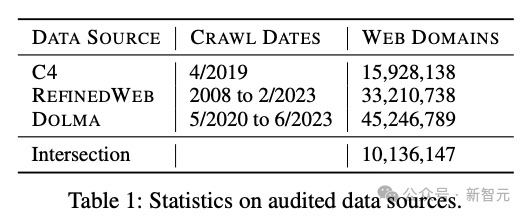

本论文共调查了3个数据集的网站来源,具体详情如表1所示。这些均是有广泛影响力的开源数据集,其下载量各不相同,范围从10万至100万以上不等。

每个数据来源中,我们选取了代币总量排名前2,000的网站域名,并将这些列表合并,最终整理出了共计3,950个网站域名,我们将这个集合命名为HEADAll。其中,仅来源于C4数据集的部分被称为HEADC4,这部分可以被视为规模最大、更新最频繁以及对于AI训练最为关键的数据来源。

从三个数据集的域名交集中随机抽取10,000个域名(简称RANDOM10k),并从中进一步随机挑选2,000个域名进行人工标注(简称RANDOM2k)。由于RANDOM10k仅从这三个数据集的交集中选取,因此这些域名更有可能指向质量较高的网页。

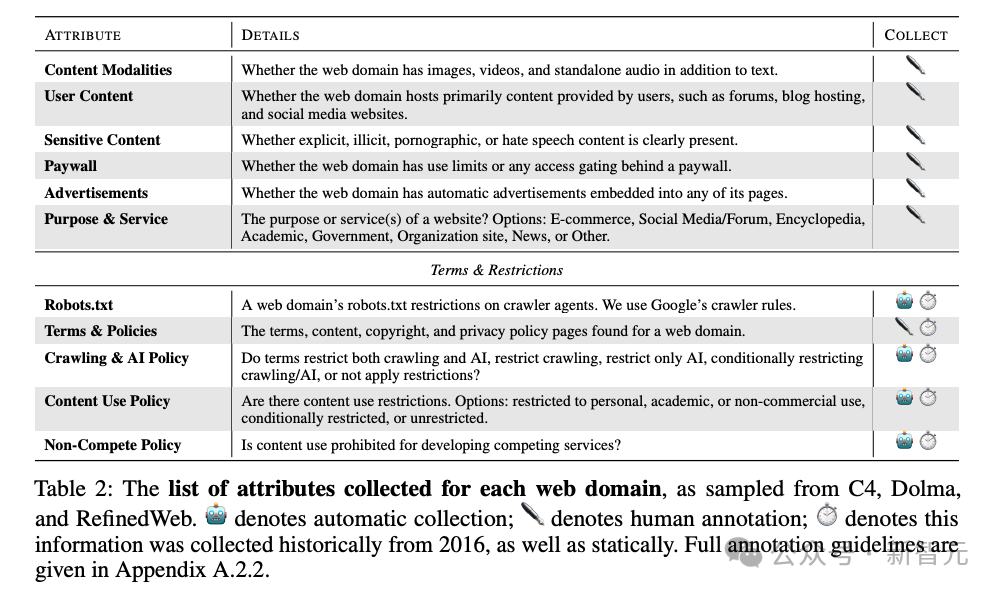

如表2所示,对RANDOM2k进行人工标注涵盖了多个方面,包括内容的不同属性及访问权限等。为了实现时间上的纵向对比,作者参照了Wayback Machine存档的网页历史数据。

研究所使用的人工标注内容均已公开,以便于未来的研究工作能够进行复现。

除了搜集历史数据外,该论文还运用了季节性自回归移动平均模型(SARIMA,Seasonal Autoregressive Integrated Moving Average)来预测未来的趋势。

从 robots.txt 的限制来看,自 GPTBot 在 2023 年中期出现后,完全限制该工具的网站数量急剧增加。然而,服务条款方面的限制数量增长则相对稳定和均衡,这些限制更多地集中在商业用途上。

根据 SARIMA 模型的预测,对于 robots.txt 和 ToS,这种限制数量增长的趋势将持续下去。

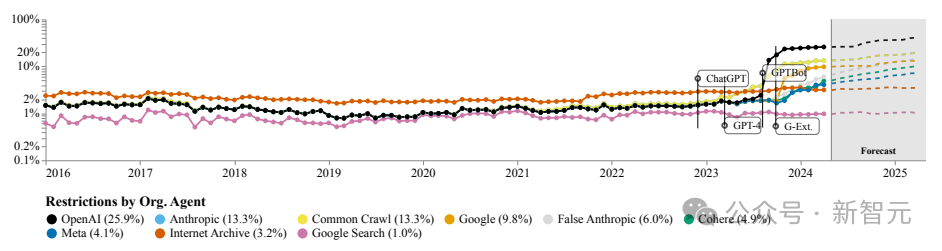

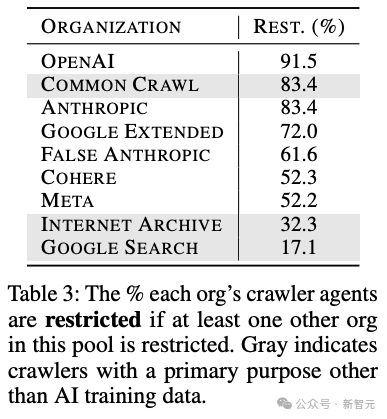

下图计算了特定组织或公司在网站限制的代理比例,可以看出OpenAI的机器人遥遥领先,其次是Anthropic、谷歌以及开源数据集Common Crawl的爬虫。

从令牌(token)数量的角度来看,也能观察到类似的趋势。

不同组织的AI代理在各个网站上获得的许可程度存在相当大的差异。

OpenAI、Anthropic 和 Common Crawl 的限制性抓取比例位居前三,均超过 80%。而网站所有者通常对于Internet Archive或谷歌搜索这类非AI领域的爬虫持较为宽容开放的态度。

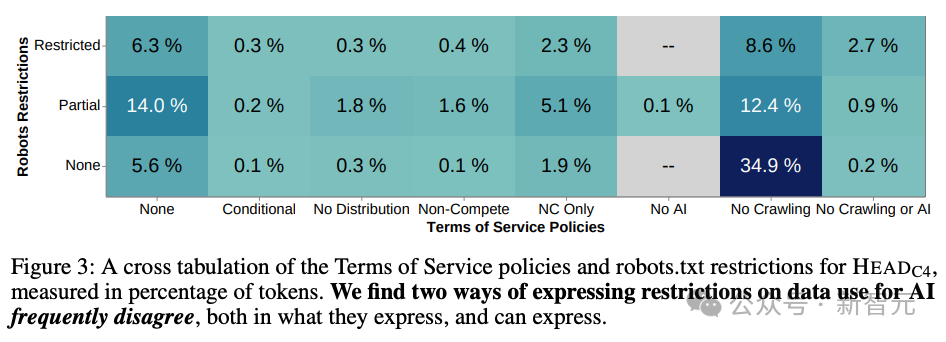

robots.txt 主要用于规范网络爬虫的行为,而网站的服务条款则是与用户间的法律协议。前者较为机械化和结构化,但具备高度可执行性;后者能够表达更为丰富和细致的政策策略。

两者本应相互补充,但在实际中,robots.txt往往无法准确反映出服务条款的意图,甚至经常出现含义相矛盾的情况(如图3所示)。

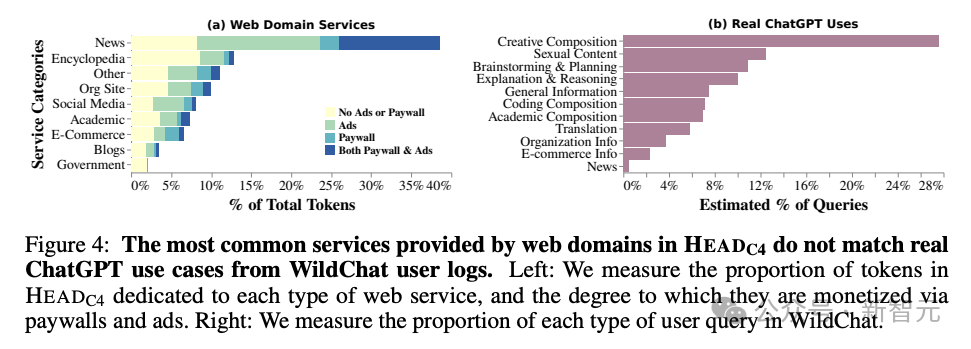

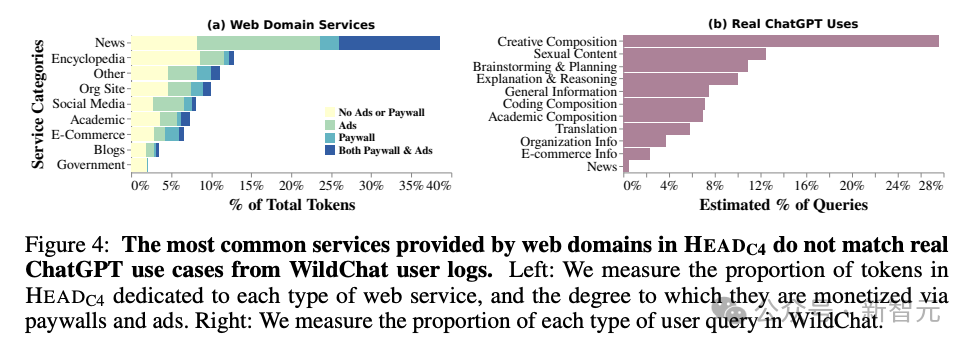

该论文将网页内容与WildChat数据集中的问题分布进行了比较,WildChat是最近收集的ChatGPT用户数据,包含了大约100万份对话。

从图4中可以看出,两者之间的差异非常明显。在网页数据中占最大比例的新闻和百科,在用户数据中的影响几乎可以忽略不计;而用户经常使用的虚构写作功能,在网页数据中却很难找到。

近期,许多人工智能公司被指控绕过robots.txt来获取网页数据。虽然难以证实,但看起来AI系统难以区分用于训练的数据和在推理阶段用于回答用户问题的数据。

REP 协议的复杂性给网页创建者带来了巨大的压力,因为他们很难对所有可能的 agent 及其下游用例做出详细规定。这导致了实际上的 robots.txt 文件内容很难准确反映出其真实意图。

我们需要进一步对与用例相关的术语进行分类和标准化,例如,专门用于搜索引擎的情况,或者非商业用途的AI,或者仅在AI明确标注数据来源时才适用的情形。

总之,这种新的协议需要更加灵活地反映网站所有者的意愿,能够清晰地区分许可和不允许的使用情况,并更好地与服务条款协调一致。

最重要的是,从网站数据使用限制的增加中,我们可以清楚地看到数据创建者与AI科技公司之间的紧张关系,而无辜受到牵连的是非营利组织和学术研究人员。

《Batch》在转述这篇文章时表达了这样的愿望:

我们期望AI开发人员能利用开放网络上的数据来进行训练。我们亦期望未来的法院判决及立法能对此加以确认。

参考资料:

(注:您提供的文本内容非常短,如果是要求重写某个具体的文本内容,请提供完整的内容以便我能够更好地帮助您。)

本文来源于微信公众号:微信公众号(ID:null),作者:乔杨,原题目为《「AI 数据荒」雪上加霜!MIT:网页数据的公开共享正走向衰落》。

大家在看