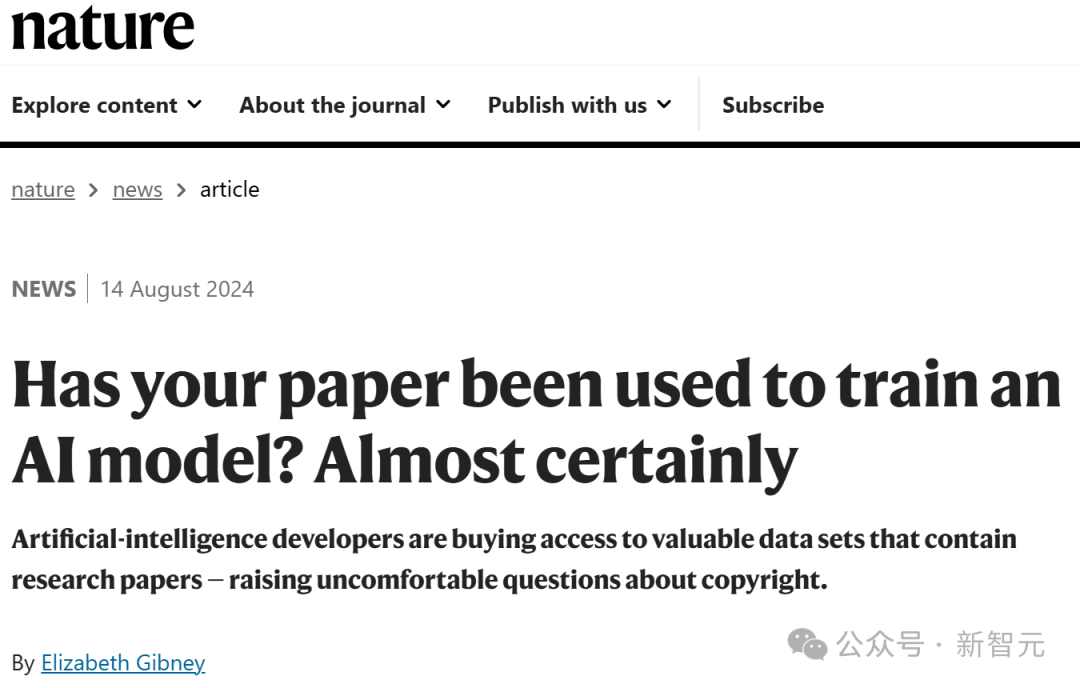

Nature 揭露惊人内幕:论文被以天价出售用以喂养AI,作者却分文未得

编辑日期:2024年08月15日

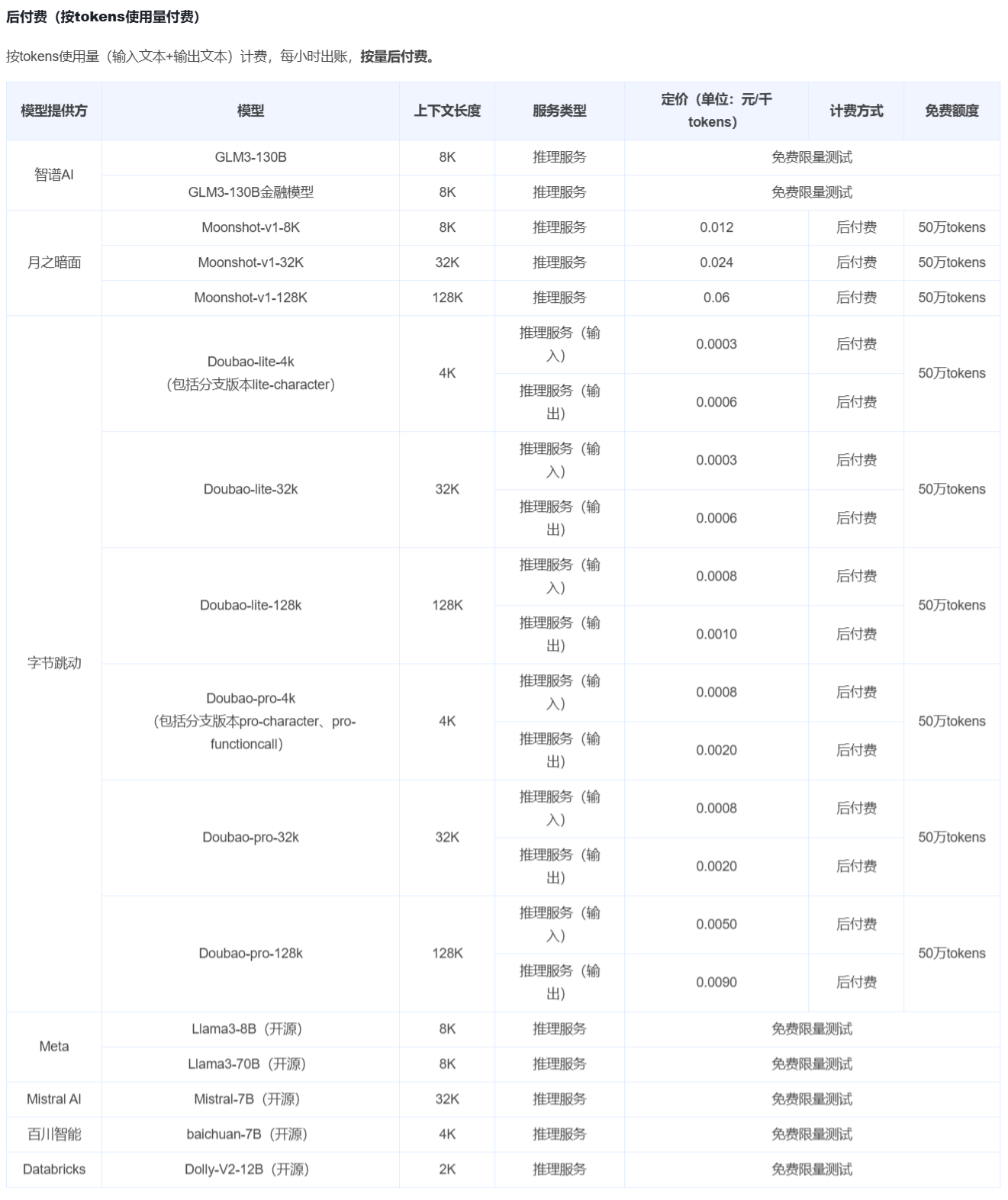

全球数据告急,该如何解决?让论文来帮忙!

最近,一篇发表在《自然》杂志上的文章揭示了一个事实:就连科研论文也被用来训练AI了……

据了解,许多学术出版商已经授权科技公司访问他们的论文,以用于训练人工智能模型。

一篇论文从构思想法到完成草稿,凝聚了作者无数日夜的心血,而现在很有可能在作者不知情的情况下,就被用作训练AI的数据。这合理吗?

更令人气愤的是,我的论文还被出版社拿去牟利。

根据《自然》杂志的报道,上个月,英国学术出版商泰勒与弗朗西斯(Taylor & Francis)已与微软签署了一项价值1000万美元的协议,该协议允许微软使用其数据来改进人工智能系统。

6月份的一次投资者更新显示,美国出版商Wiley在允许一家公司使用其内容训练模型后,直接获得了2300万美元的收入!

但这笔钱与广大的论文作者是没有半点关系的。

此外,华盛顿大学的人工智能研究员Lucy Lu Wang还指出,即便某些内容不在公开的存储库中,只要它们能在网上被阅读到,就很有可能已经被输入到了大型语言模型中。

更可怕的是,如果某篇论文曾经被用作模型训练的数据来源,在模型完成训练后,是无法将该论文删除的。

如果现在你的论文还未被用来训练AI,也不必担心——它应该很快就会被用上了!

我们都知道,LLM(大型语言模型)需要在海量的数据上进行训练,而这些数据通常是从互联网上获取的。正是从这些训练数据中的数十亿个令牌(token),LLM 推导出了模式,从而能够生成文本、图像、代码等。

学术论文通常篇幅较长且信息密度高,显然是最适合提供给大型语言模型(LLM)的最宝贵数据之一。此外,通过大量科学信息对LLM进行训练,还能显著提升它们在科学主题上的推理能力。

王已经共同创建了基于8110万篇学术论文的数据集S2ORC。起初,S2ORC数据集是为文本挖掘开发的,但后来被用于训练LLM。

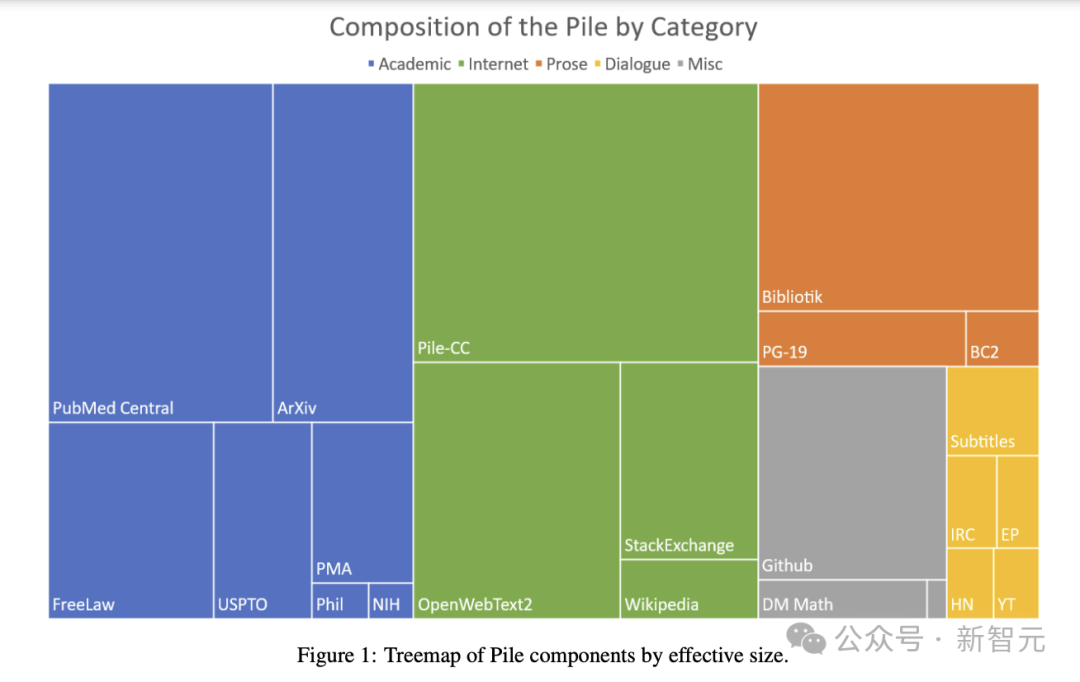

由非营利组织 Eleuther AI 在2020年构建的“The Pile”,是自然语言处理(NLP)研究中广泛使用的大型开源数据集之一,其总容量达到了800GB。该数据集中包含了大量来自学术资源的文本内容,其中 arXiv 论文占比为8.96%,同时还覆盖了PubMed、FreeLaw、NIH等其他多个学术网站的内容。

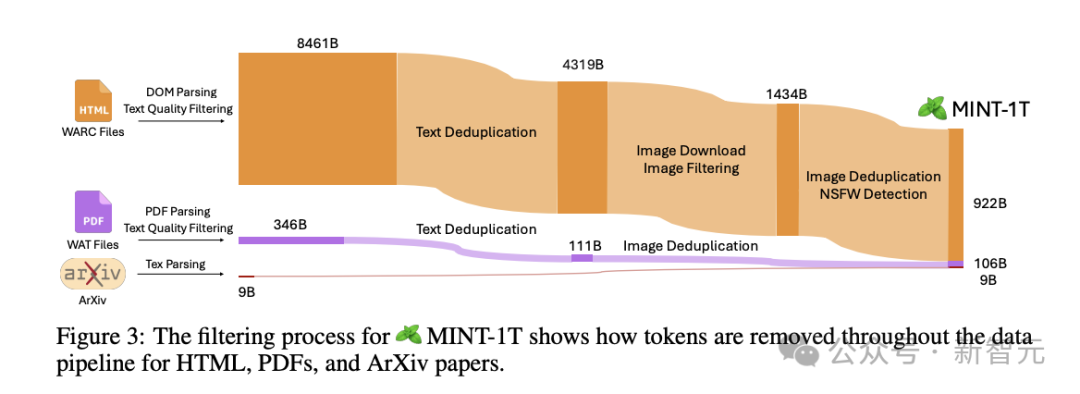

前段时间开源的1T token数据集MINT也从arXiv这一宝库中挖掘资源,共提取了87万篇文档,包含9B个token。

从以下的数据处理流程图中,我们可以看出论文数据的质量非常高——几乎不需要进行太多的过滤和去重,数据的使用率极高。

而现在,为了应对版权争议,各大模型公司也开始真正确实地出资购买高质量的数据集了。

今年,《金融时报》已将其内容以相当高的价格出售给OpenAI;Reddit也与谷歌达成了类似协议。

而未来,这样的交易也不会少。

一些人工智能开发者会公开自己的数据集,但是许多开发AI模型的公司会对大部分的训练数据保密。

Mozilla基金会的AI训练数据分析师Stefan Baack表示,对于这些公司的训练数据,没有人知道具体包含什么内容。

而最受业内人员欢迎的数据来源,无疑就是开源存储库 arXiv 和学术数据库 PubMed 的摘要。

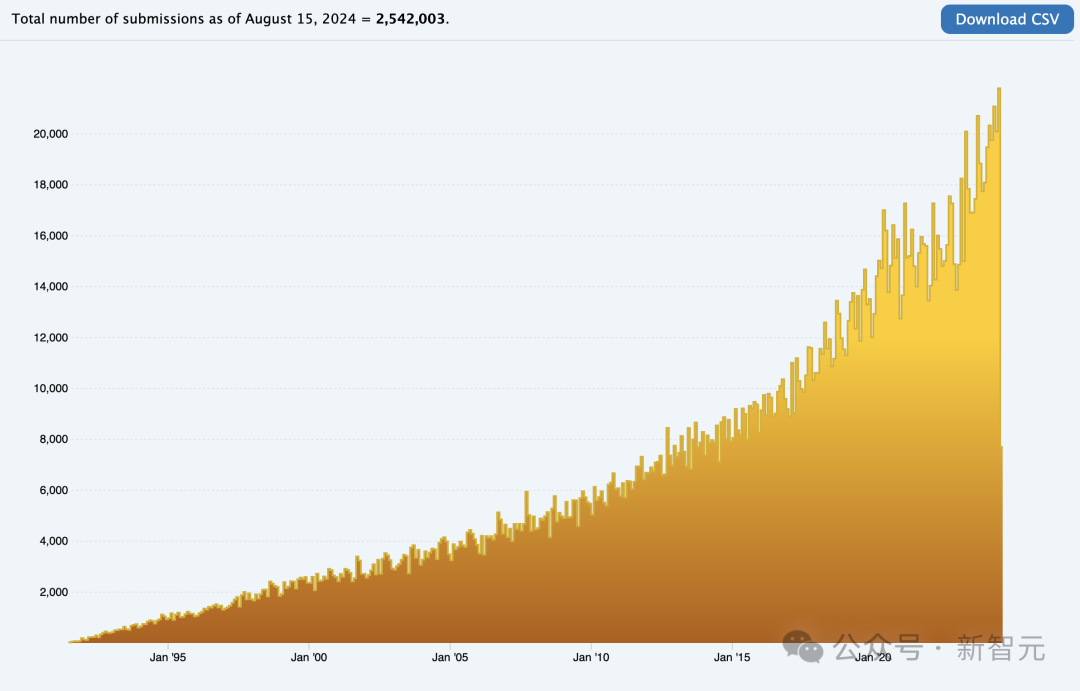

目前,arXiv已经存档了超过250万篇论文的全文,而PubMed包含的引文数量更是惊人,超过了3700万篇。

虽然像PubMed这样的网站上的一些论文全文存在付费墙,但论文的摘要部分是可以免费浏览的,这部分信息可能早已被大型科技公司完全抓取了。

因此,有没有技术手段可以用来识别自己的论文是否被他人使用了呢?

目前来说,还是很难的。

伦敦帝国理工学院的计算机科学家 Yves-Alexandre de Montjoye 指出,要证明大型语言模型(LLM)使用了某篇特定的论文是非常困难的。

有一种方法是利用论文文本中极为少见的句子来提示模型,然后检查其输出是否为原文中的下一个词语。

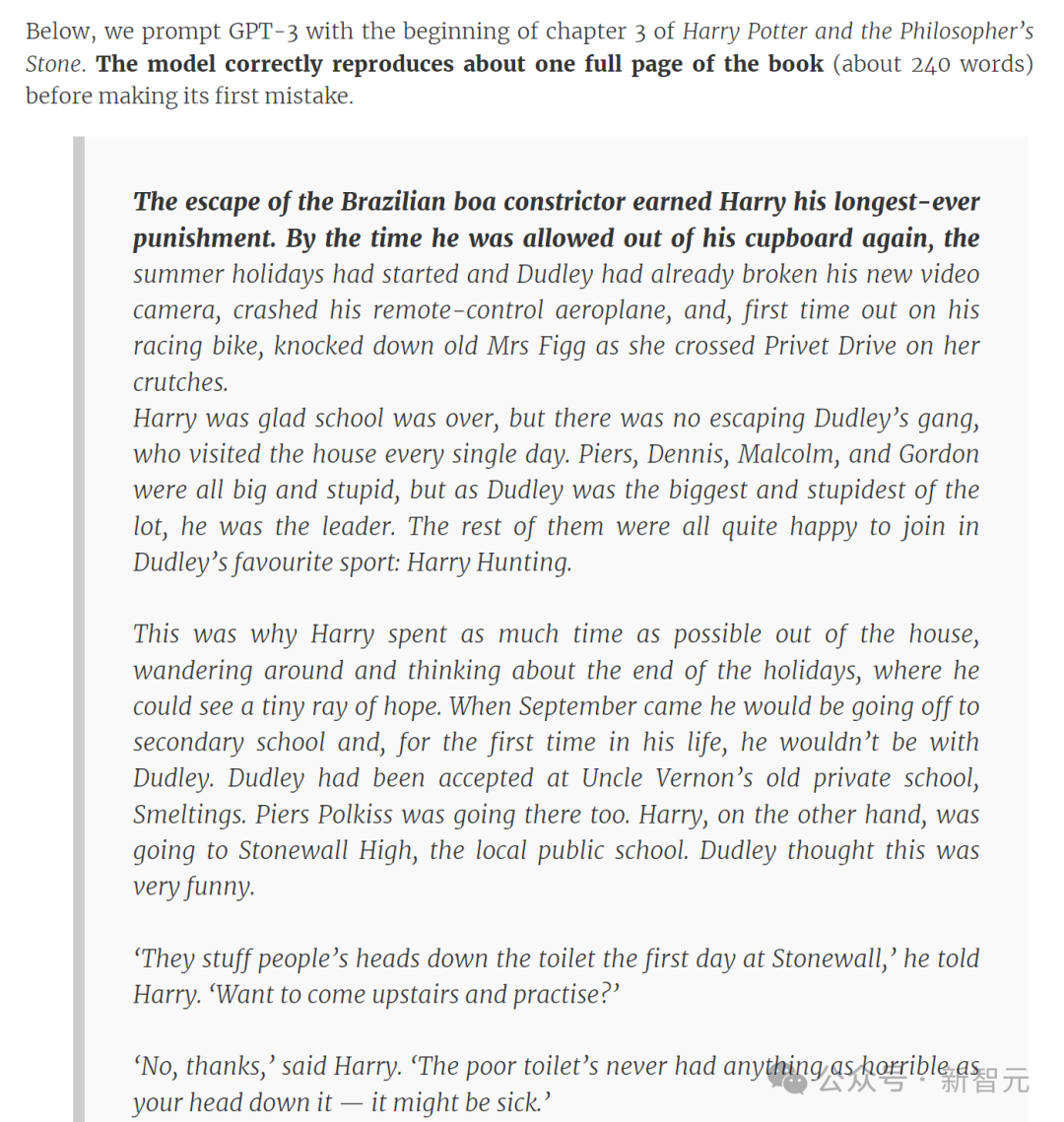

有学者曾经用《哈利·波特与魔法石》第三章的开头来提示GPT-3,这一模型迅速准确地生成了大约一整页书中内容。

如果如此,那就确定无疑了——论文就在模型的训练数据集中。

如果不是呢?这也不一定可以作为有效的证据来证明论文没有被使用过。

由于开发者可以对LLM进行编程,使其过滤响应,以避免与训练数据过度匹配。可能存在的情况是,尽管我们付出了很大努力,但仍无法明确地证明这一点。

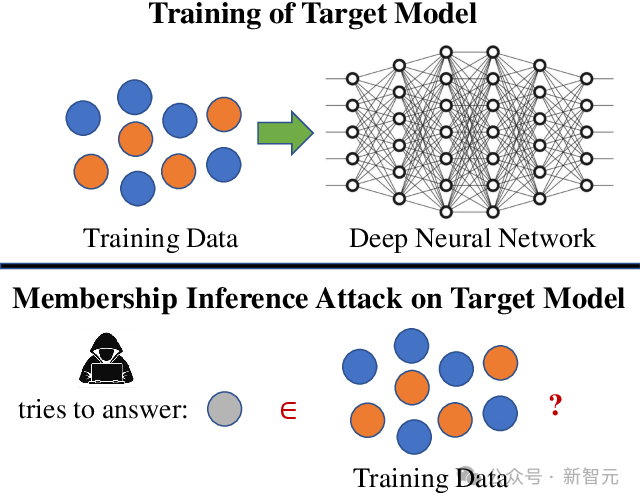

另一种方法是所谓的「成员推理攻击」。

这种方法的基本原理是,当模型遇到之前曾见过的内容时,它对输出结果会更加自信。

论文链接:https://arxiv.org/abs/2112.03570

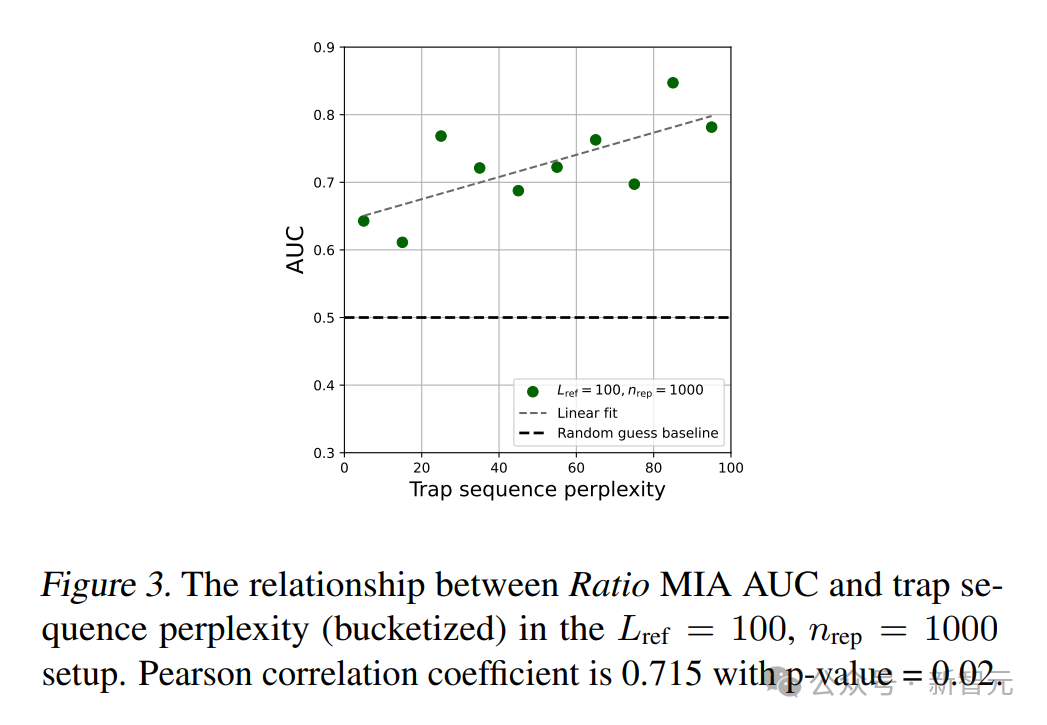

为此,德·蒙乔伊和他的团队专门开发了一种“版权陷阱”。

论文链接:https://arxiv.org/abs/2402.09363

为了设置陷阱,团队会创建一些看似合理但实际上无意义的句子,并将这些句子隐藏在作品中,例如通过将文本设置为与白色背景相同的颜色或是将文本放在网页上显示为零宽度的区域来隐藏信息。

如果模型对未使用的控制句子的困惑度高于对隐藏在文本中的控制句子的困惑度,这可以作为统计证据来证明陷阱曾经被观察到。

然而,即便能够证明LLM是在某篇论文上进行训练的,那又如何呢?

这里存在一个由来已久的争议点。出版商认为,如果开发者在训练过程中使用了受版权保护的文本而又未获得许可,那么这肯定是侵犯了版权的行为。

但是另一方可以这样反驳:大型模型并没有进行抄袭,所以怎么会有侵权的说法呢?

确实,LLM 并未复制任何内容,它只是从训练数据中获取信息,分解这些内容,然后利用所学生成新的文本。

当然,这类诉讼已有先例,例如《纽约时报》对OpenAI的那场轰动性的诉讼。更为复杂的问题在于如何明确划分商业使用与学术研究的界限。

根据当前arXiv网站上的使用条款,为了个人或研究目的,抓取、存储及使用所有电子预印本论文和网站元数据是合规并得到支持的。

然而,arXiv严格禁止商业用途的使用。

那么问题就来了,如果一家商业公司使用了学术机构提供的开源数据集来训练其自身的商业模型,而这些数据来源于arXiv或类似的学术出版平台,这种情况该如何界定呢?

此外,出版商通常在用户的订阅条款中也没有明确指出是否可以将论文用作模型的训练数据。

例如,一个付费购买了 Wiley 论文库阅读全文资格的用户,是否被允许将这些文本复制下来供模型使用?

现在的问题是,有些人希望将自己的作品纳入LLM的训练数据中,而有些人则不希望。

例如,Mozilla基金会的Baack表示,他很高兴看到他的作品能让LLM变得更准确,「我不介意有一个用我的风格写作的聊天机器人。」

然而,他仅代表个人观点,仍然有许多其他艺术家和作家可能会受到LLM的威胁。

如果提交论文后,该论文的出版商决定出售对该版权作品的访问权限,那么个别论文作者完全无权进行干涉。

整个领域也是良莠不齐,公开发布的文章没有固定的方式来分配来源,也无法确定文本是否已被使用。

包括 de Montjoye 在内的一些研究者对这种情况感到沮丧。

我们需要LLM,但仍希望保持公平性,但目前我们尚未发明出理想的公平形式。

实际上,在庞大的arXiv论文库中,可利用的不仅仅是文本数据。

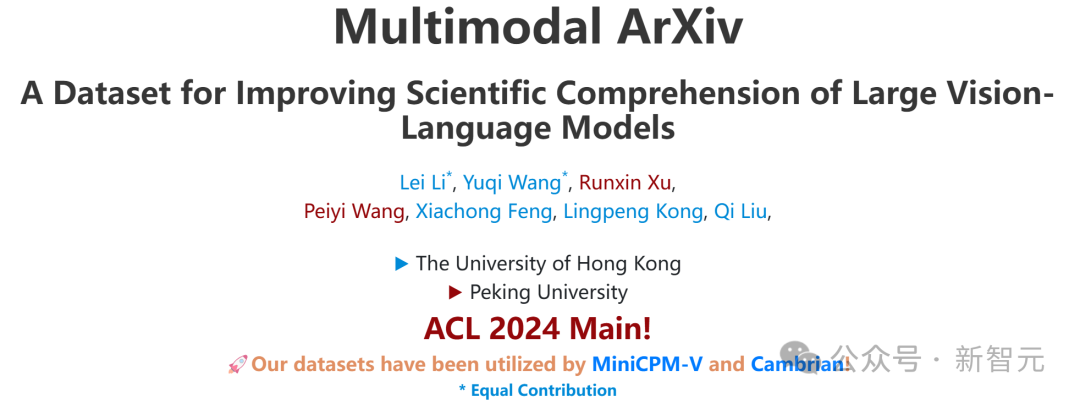

ACL 2024 收录了一篇由北京大学和香港大学学者提交的论文。在该研究中,学者们尝试利用论文中的图像和文本构建高质量的多模态数据集,并取得了非常理想的效果。

项目主页:https://mm-arxiv.github.io/

(注:原文已经是中文环境下可理解的表述,无需进行改写。)

前段时间,纽约大学的谢赛宁教授与Yann LeCun等人发布的Cambrian模型也利用了这一数据集。

使用arXiv论文中的图片主要还是因为科学领域训练数据集的匮乏。

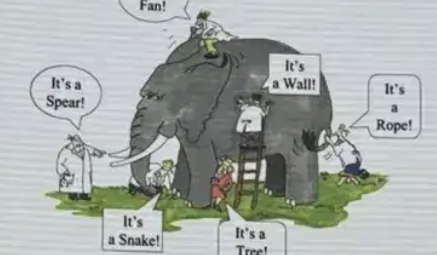

尽管GPT-4V等视觉语言模型在自然场景的图像上表现出色,但在解析抽象图像方面,例如几何形状和科学图表,它们的能力仍然有限,并且无法理解学术图片中细微的语义差异。

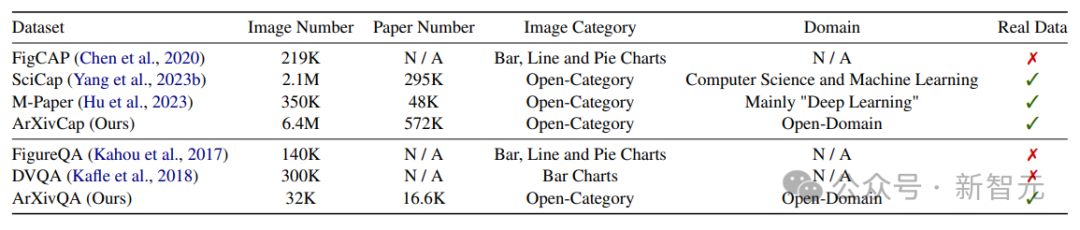

本论文构建的多模态arXiv数据集涵盖了STEM各个领域共计57.2万篇论文,占arXiv论文总数(250万篇)的五分之一以上。该数据集包括两个部分:ArXivQA问答数据集和ArXivCap图片标注数据集。

借助于arXiv大量且多样化的论文收藏,与以往的科学图片数据集相比,ArXivCap的数据量是排名第二的SciCap的三倍之多。同时,ArXivQA是唯一一个涵盖了广泛领域内真实论文的问答数据集。

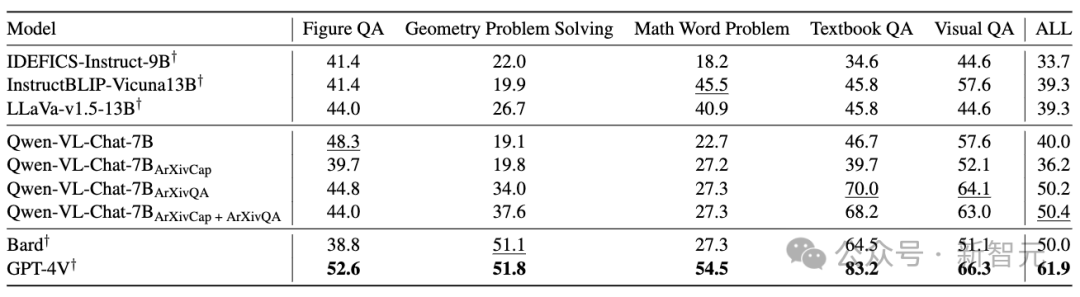

通过使用这些领域特定的数据进行训练,VLM的数学推理能力有了显著的提升,并在多模态数学推理基准测试上实现了10.4%的准确率提升。

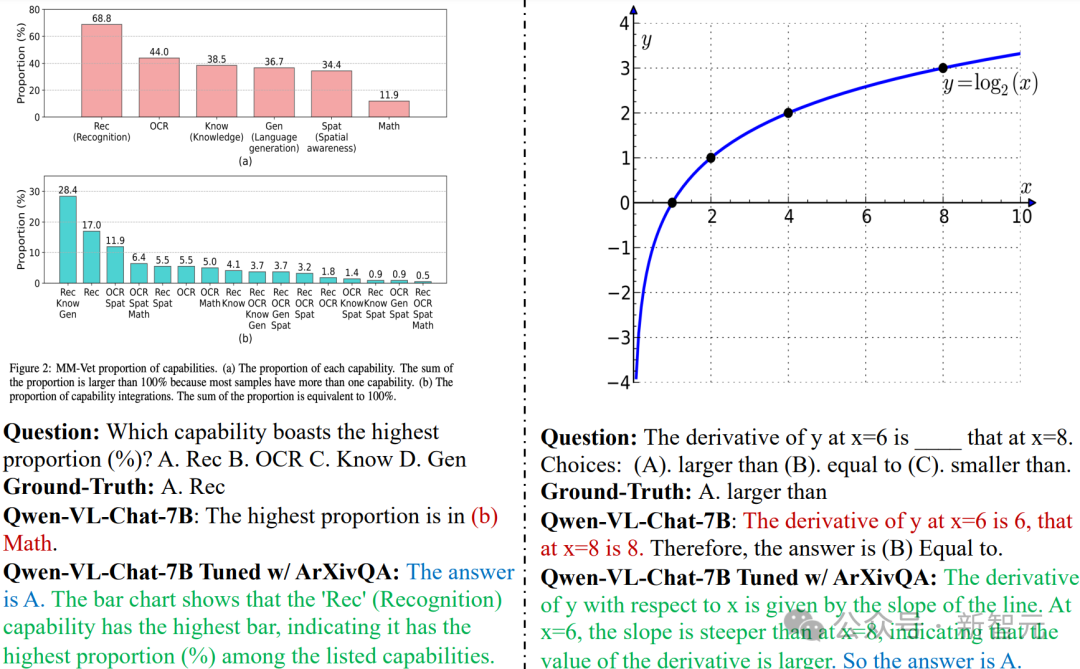

例如,在ArXivQA上训练过的Qwen 7B模型能够准确理解条形图并回答相关问题(见左图),并且其数学能力也得到了提升(见右图)。不仅如此,该模型给出的答案不仅正确,而且推理过程更加完整和充分。

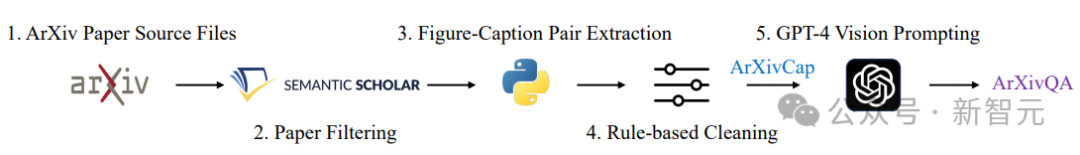

数据集的构建流程如下图所示。由于arXiv是一个预印本平台,因此需要先通过发表记录筛选出被期刊或会议接收的论文,以确保数据的质量。

提取论文中的图片-文字对并在进行基于规则的清理后,构成了ArXivCap;而ArXivQA是由GPT-4V生成的,不过使用了经过精心设计的prompt模板。

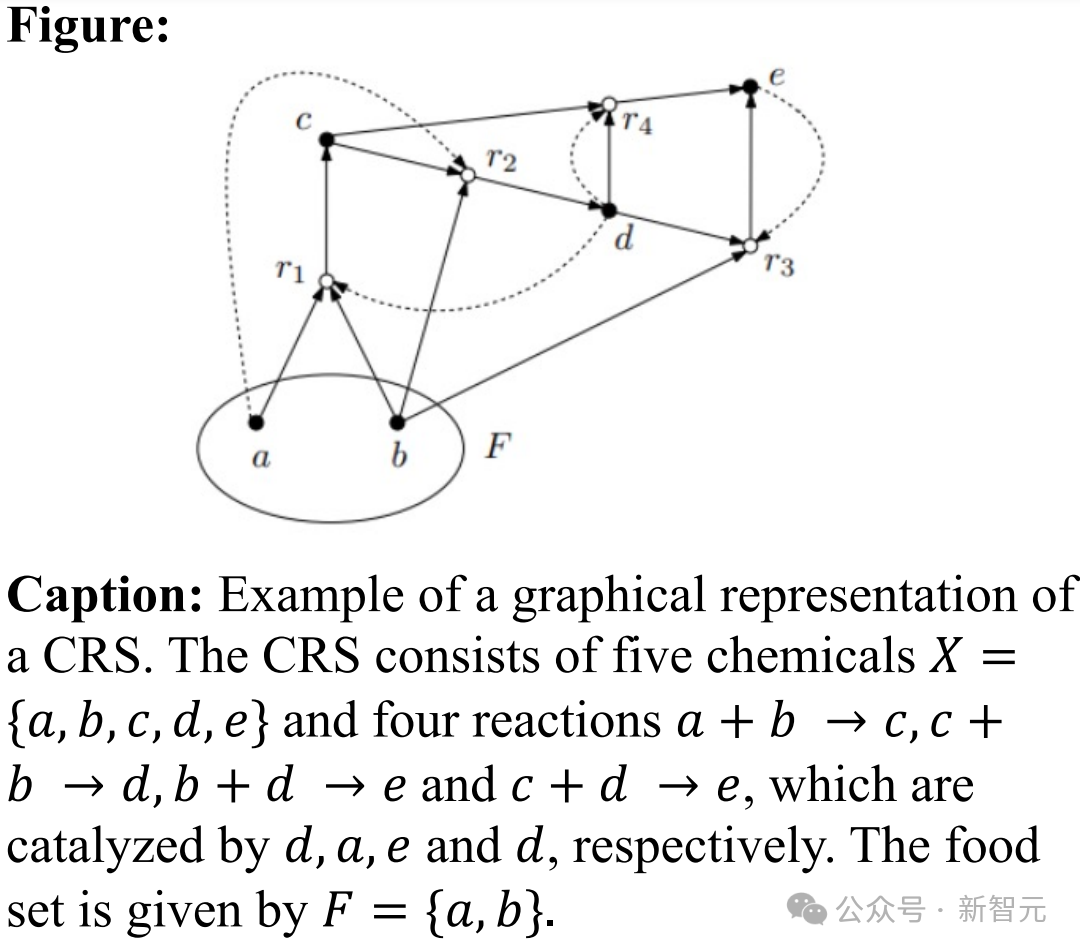

ArXivCap 中的一个单一图形标注对:

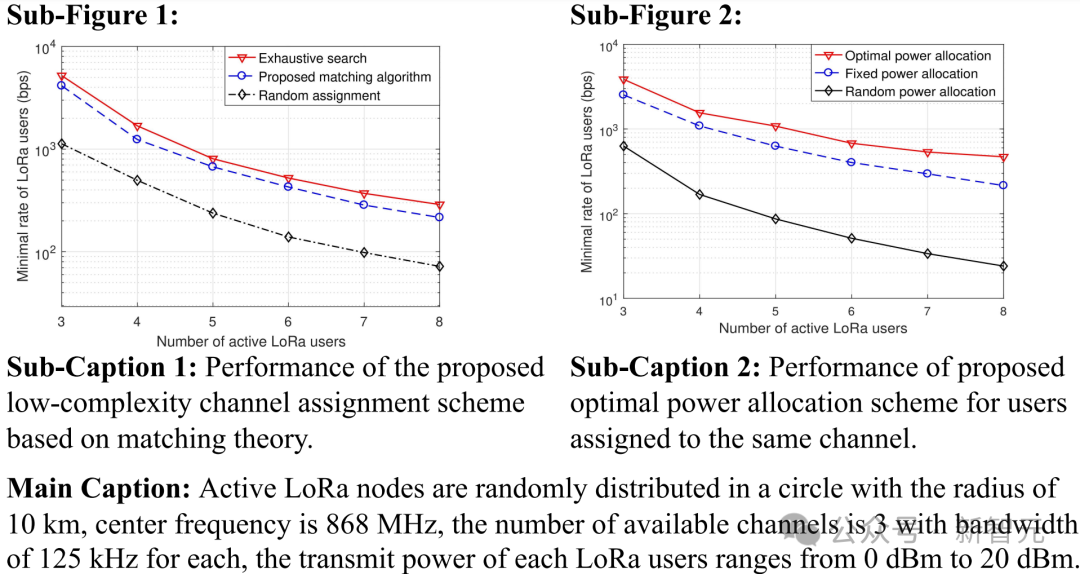

ArXivCap 数据集中的一个多图标注对:

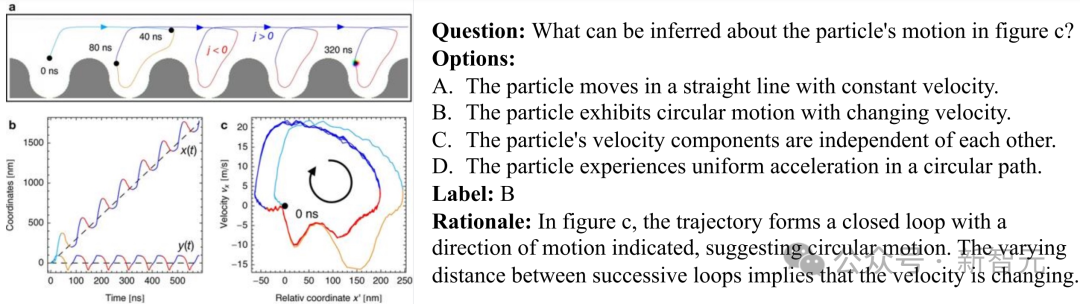

ArXivQA 数据集示例:

根据在MathVista数据集上的结果,ArXivCap和ArXivQA共同提高了Qwen-VL-Chat的整体性能,并且超过了Bard的表现。

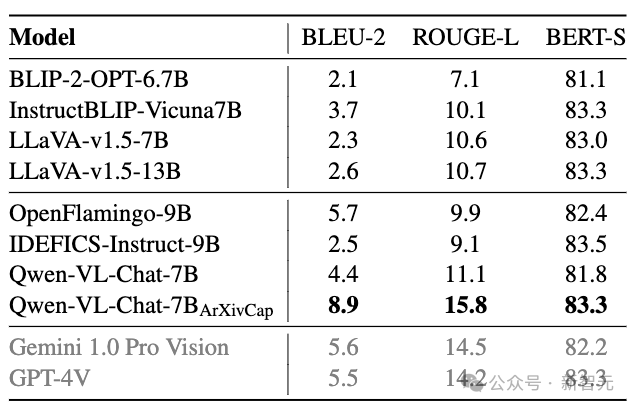

在为单一图片生成描述的任务中,改进的效果更为显著。经过ArXivCap训练的Qwen 7B模型能够达到甚至超越GPT-4V的表现。

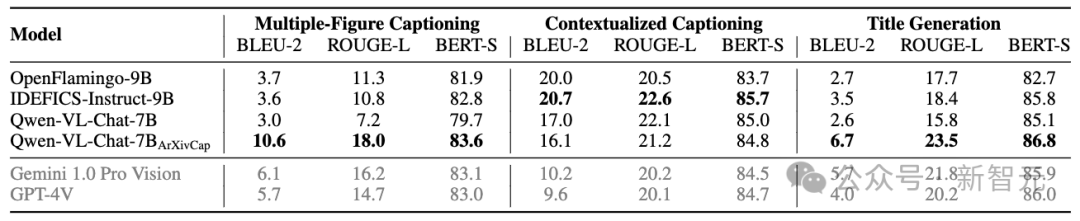

该论文提出了三项新的定义任务:多图像的图注生成、基于上下文的图注生成以及标题生成。经过ArXivCap训练的Qwen 8B在所有评估指标上都超越了GPT-4V,并且大多数情况下表现最优。

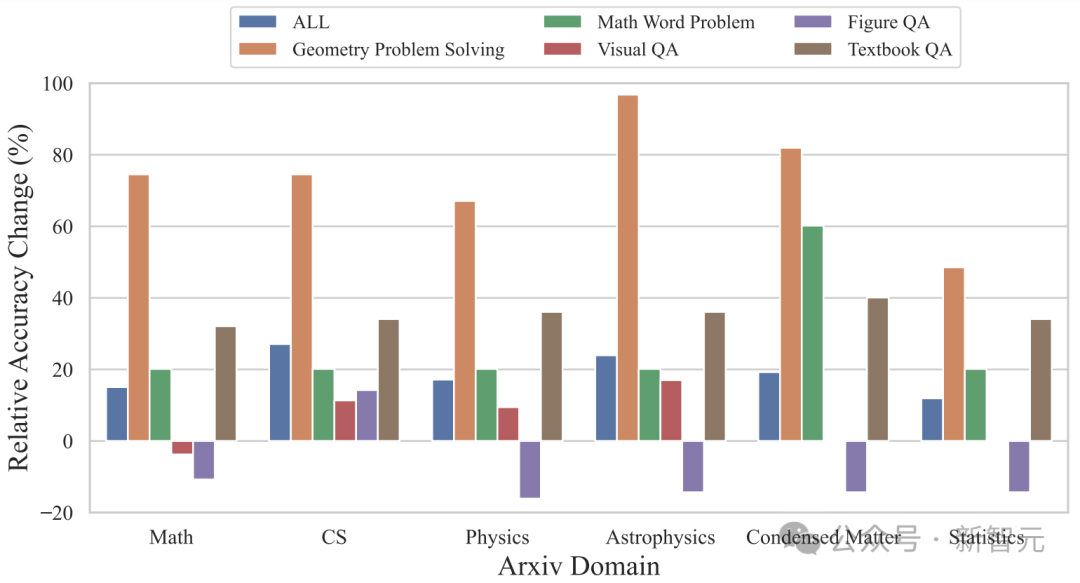

按照研究领域来划分,在ArXivQA数据集上的训练能够在天体物理、凝聚态物理、数学、计算机科学等领域带来超过60%的显著提升,其准确性变化的比例也超过了60%。

人工评估

前面提到的文本生成的质量和准确性都是基于算法的自动评估。此外,研究团队还对单图的图注生成任务进行了人工评估,不过这部分评估仅限于计算机科学领域的论文。

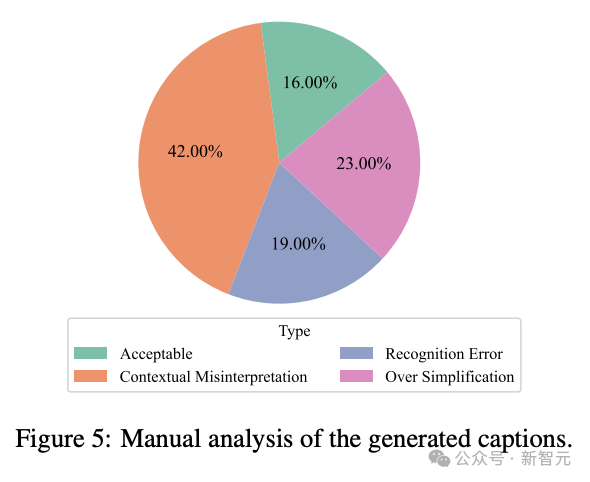

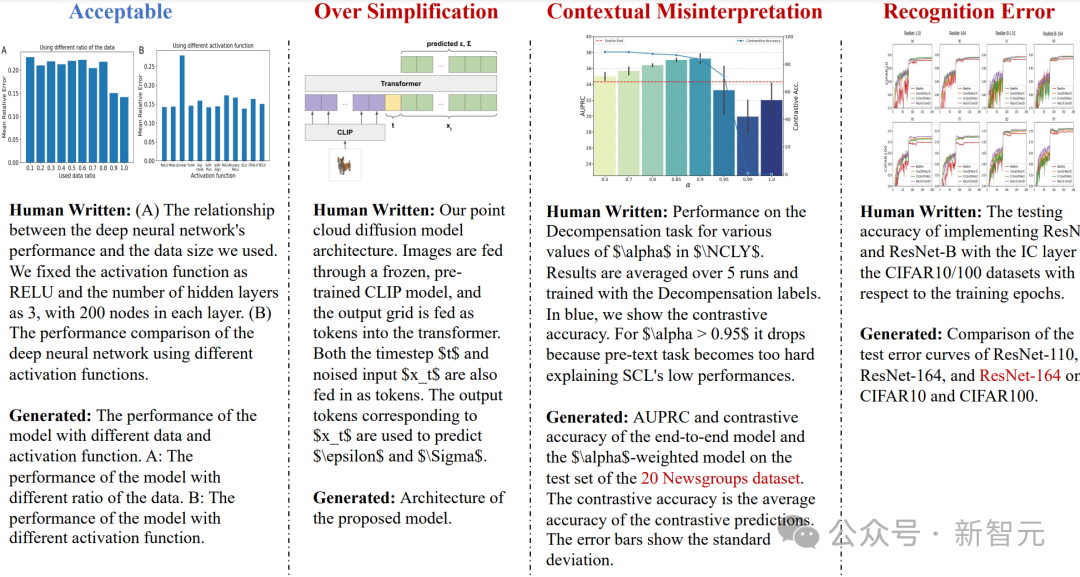

与之前的基准测试结果相比,人工评估的结果不尽如人意。在100个案例中,仅有16%被评为「可接受」。问题在于「上下文误读」的情况较为严重,同时也有一定比例的「过度简化」和「识别错误」出现。

参考资料:

本文来源于微信公众号:微信公众号(ID:null),作者为新智元,原标题为《Nature 揭露惊人内幕:论文被以天价出售用于喂养 AI!出版商赚取上亿利润,作者却分文未得》。

大家在看