不需花费一分钱!GPT-4微调服务限时免费开放,并每日赠送百万训练token。

编辑日期:2024年08月21日

免费期限截至9月23日。

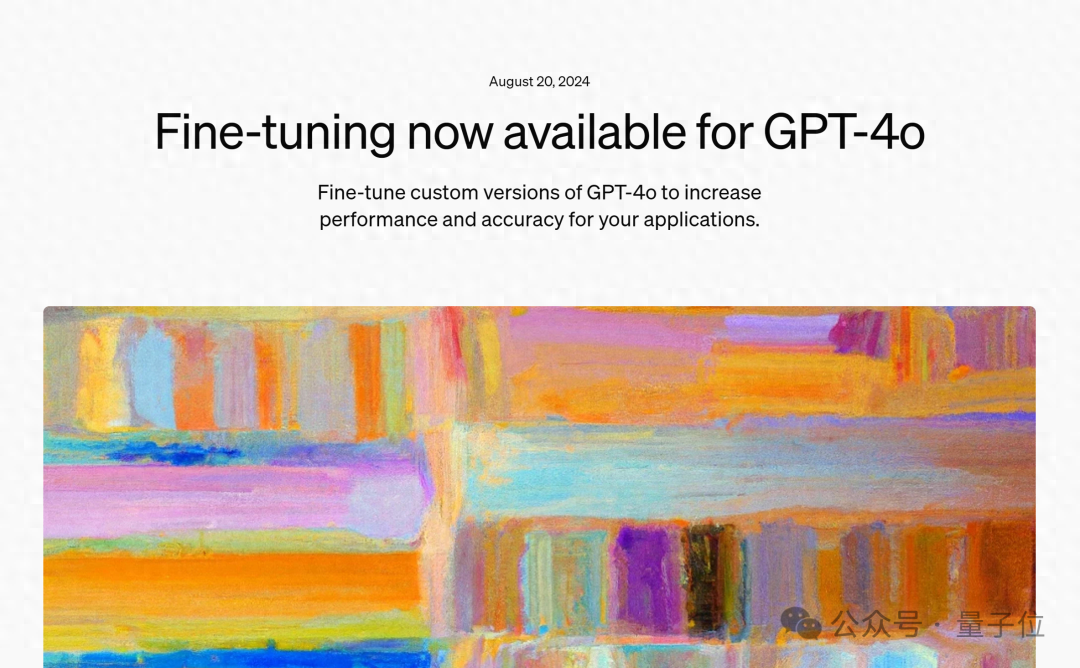

一觉醒来,OpenAI推出了新功能:

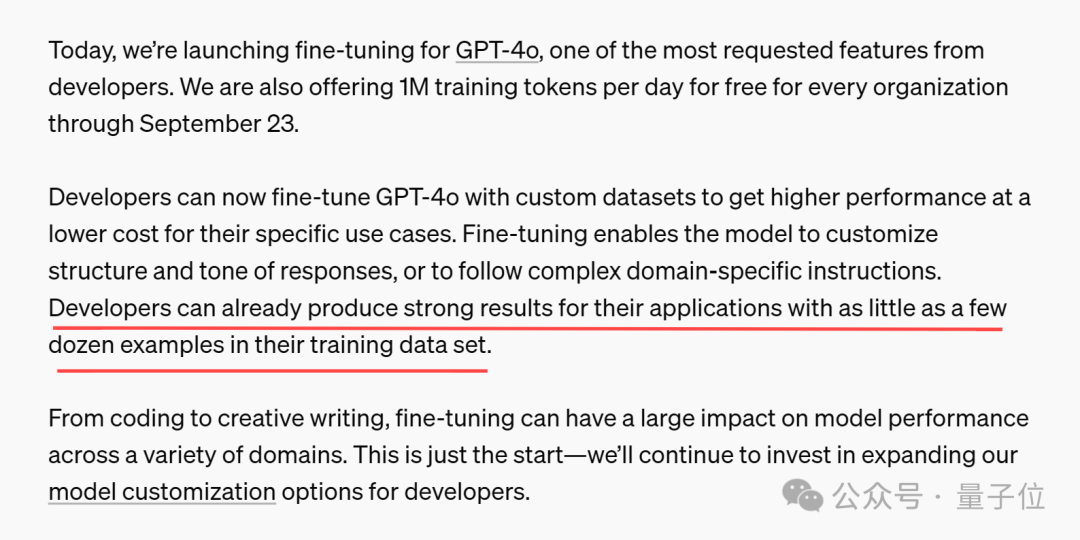

GPT-4o现已正式支持微调功能。

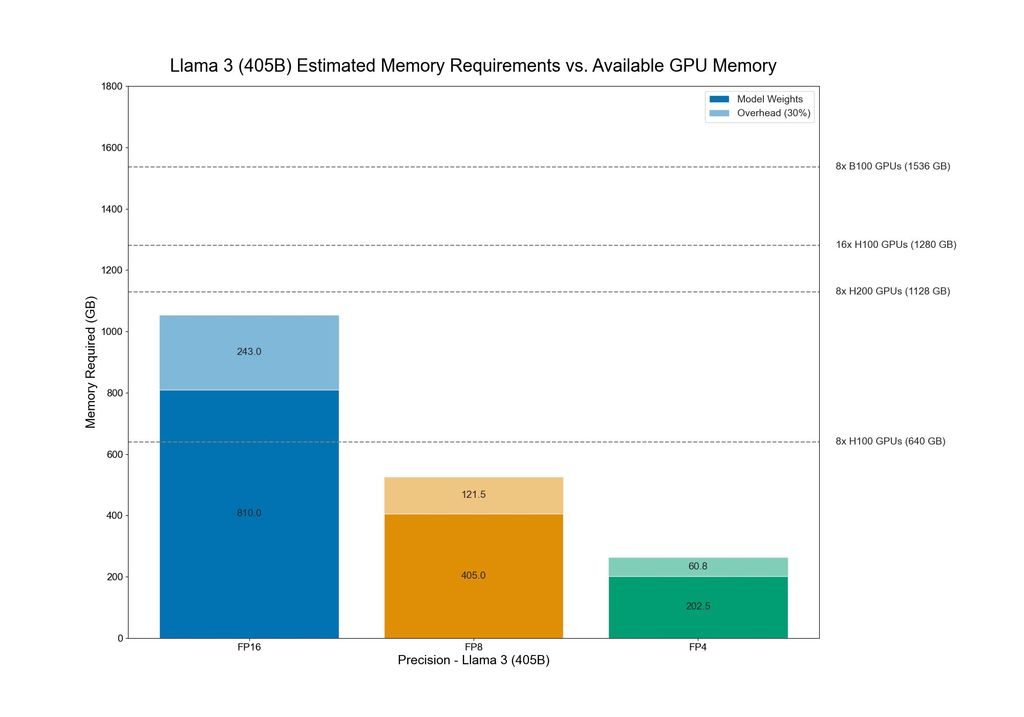

此外,官方还提供了一项福利:每个组织每天可免费获得100万个训练令牌,有效期至9月23日。

这意味着开发人员现在能够利用自定义数据集对GPT-4o进行微调,以低成本构建自己的应用。

根据OpenAI的公告,

GPT-4o微调训练的成本为每100万令牌25美元(意味着每天节省25美元)。

收到邮件的开发者们兴奋地互相告知,如此优惠必须赶紧利用起来。

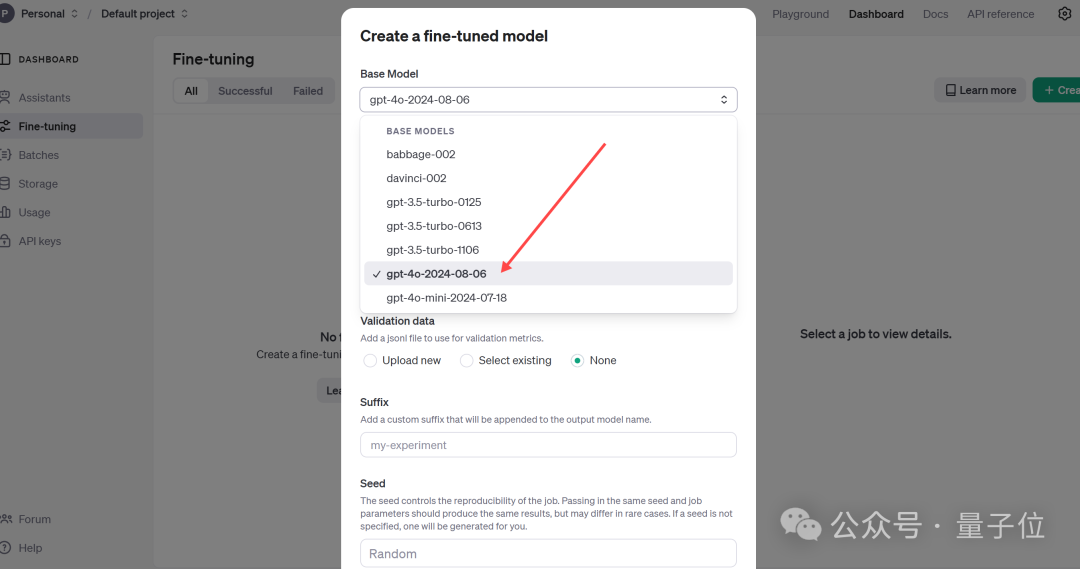

使用方法很简单,只需访问微调仪表板,点击“创建”,然后从基础模型下拉列表中选择gpt-4o-2024-08-06即可。

值得一提的是,OpenAI指出,仅需训练数据集中的几十个示例就能产生良好的效果。

消息发布后,许多网友纷纷表示想要尝试,并对微调后的实际效果充满好奇。

对此,OpenAI早已有所准备,在公告中同步分享了合作伙伴使用GPT-4o微调的实际案例。

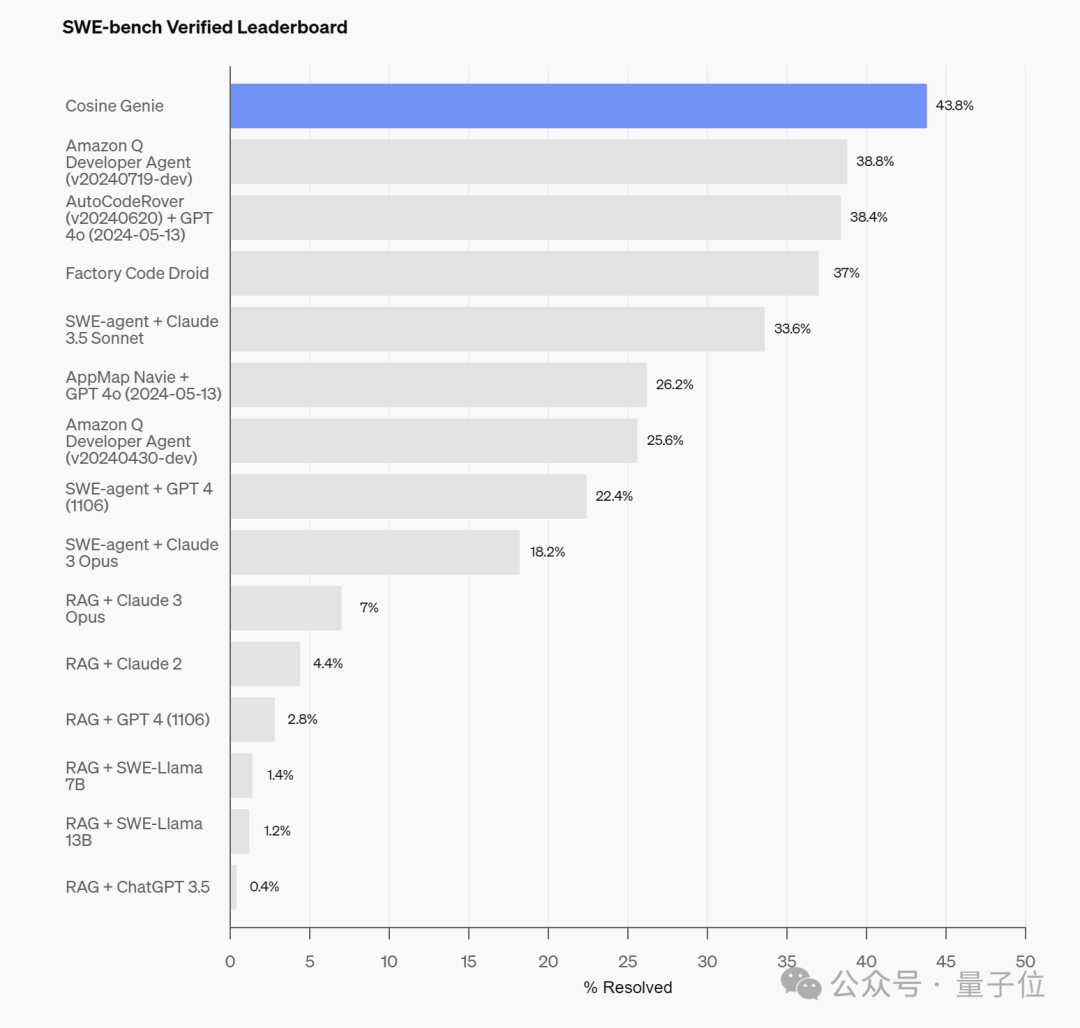

首先介绍的是由AI初创企业Cosine开发的一款名为Genie的代码辅助工具,专门为了支持软件开发者而设计。根据Cosine的官方说明,Genie通过一种专有流程开发而成,利用大量高质量数据对一个非公开版本的GPT-4变体进行了训练与优化。

这些训练数据中有21%来自JavaScript和Python,14%来自TypeScript和TSX,另有3%来自其他语言,包括Java、C++和Ruby等。

经过优化后,Genie在OpenAI最新发布的代码能力基准测试SWE-Bench Verified中获得了43.8%的状态最优(SOTA, State-of-the-Art)得分。

此外,在SWE-Bench Full的SOTA得分中,Genie达到了30.08%,打破了先前19.27%的记录。

相比之下,Cognition的Devin在同一基准测试中的部分测试仅获得了13.8%的成绩。

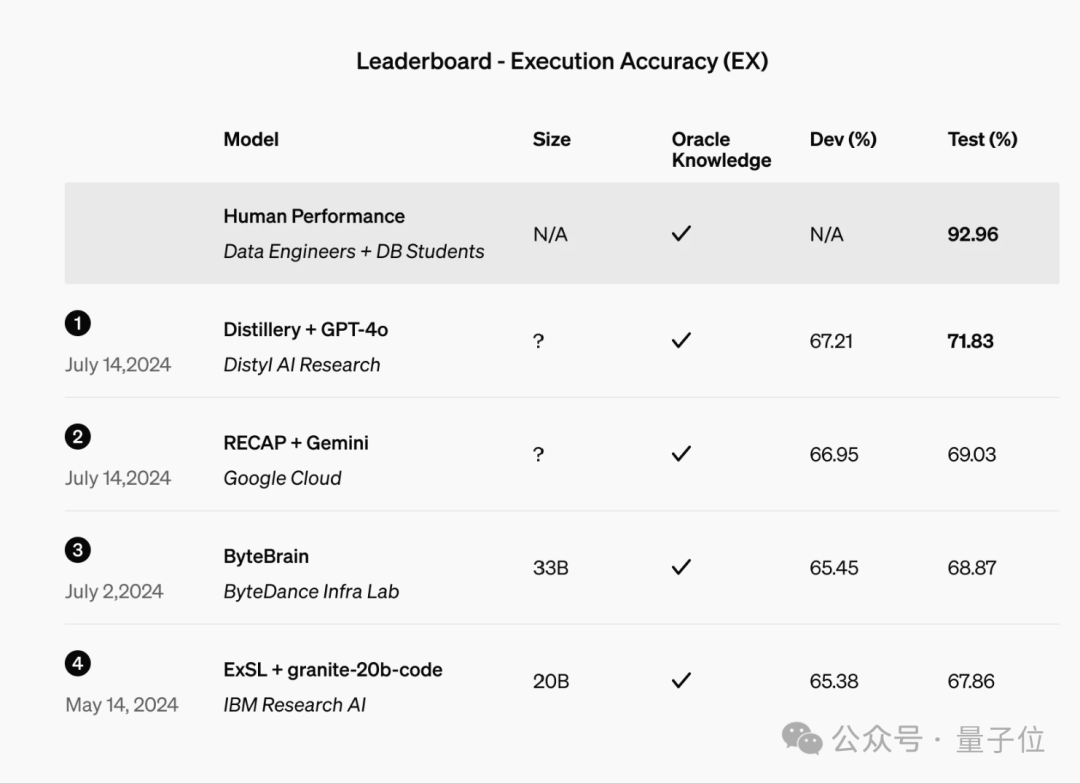

另一例子来自于Distyl,这是一家为《财富》世界500强企业提供AI解决方案的公司,最近在顶级的文本转SQL基准测试BIRD-SQL中位列第一。

经过优化后,其模型在排行榜上实现了71.83%的执行准确率,在查询重构、意图分类、思维链和自我修正等任务中表现出色,特别是在SQL生成方面表现尤其突出。

除了提供这些案例,OpenAI在其公告中还特别强调了数据隐私和安全问题,主要概括为:

开发者的业务数据(包括输入和输出)不会被共享或用于训练其他模型。对于微调模型采取了多层次的安全缓解措施,比如持续运行自动安全评估并对使用情况进行监控。

尽管微调备受瞩目,一些网友指出它可能还不如提示词缓存。

微调虽好,却似乎比不上提示词缓存……

早在今年5月,谷歌的Gemini已支持提示词缓存功能,Claude也在上周新增了该功能。

提示词缓存的优点在于避免了重复输入相同的脚本,因此运行更快且成本更低。

有观点认为,提示词缓存对开发者更为友好(无需进行异步微调),同时几乎能带来与微调同样的效果。

提示词缓存仅需你投入1%的努力,即可获得99%的效果。

然而,也有支持者为微调发声,认为它在定制响应方面更为有效。比如确保JSON格式无误、回复更精炼或加入表情符号等。

随着OpenAI的竞争对手纷纷采用提示词缓存,一些网友提出了疑问:

OpenAI是否会继续沿用微调,还是转向提示词缓存(或者两者并行)?

对于这个问题,有细心的网友发现了线索。

OpenAI在其延迟优化指南中提及了缓存技术。

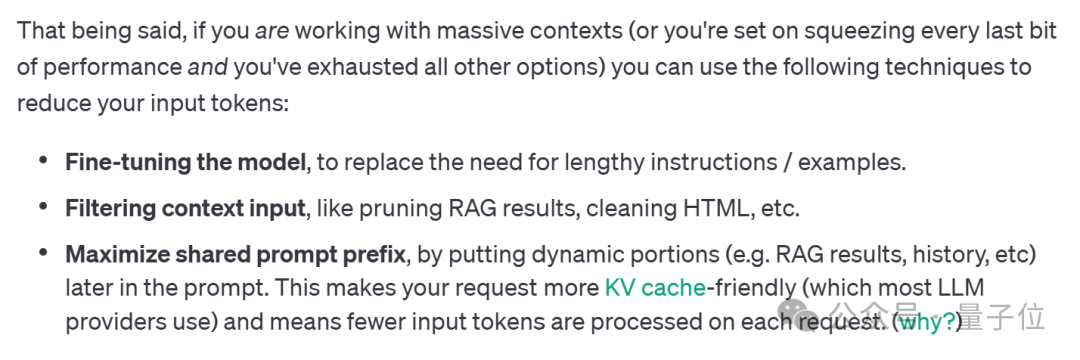

我们查阅了指南原文,其中关于减少输入token的部分提到:

通过将动态部分(如RAG结果、历史记录等)置于提示的较后位置,以最大化共享提示前缀。这样能让请求更易于KV缓存处理,从而减少每个请求所需的输入token数量。

但是有些网友认为,仅凭这段描述,不能直接证明OpenAI采用了提示缓存技术。

但是有些网友认为,仅凭这段描述,不能直接证明OpenAI采用了提示缓存技术。

话说回来,不论争议如何,OpenAI的福利还是要好好利用的。

除了GPT-4o之外,GPT-4o mini也可以享受免费微调服务,直到9月23日,OpenAI每天会提供200万训练token的服务完全免费。

这是去年全年的46倍之多。

奥特曼表示:没有他,就没有今天的OpenAI。

“现在是时候把研究愿景变成现实了。”

相关调查报告预计很快会提交给董事会。

在扩散模型方面也做出了早期贡献。

奥特曼强调:确保用户获得良好体验。

大家在看