大模型时代的ASR确实不同凡响!现场评估豆包的“听力”水平,轻松掌握方言及儿童口音!

编辑日期:2024年08月22日

2024年火山引擎AI创新巡展上海站近日成功举办,活动中不仅展示了豆包大模型在综合评分、语音识别等方面的显著提升,还推出了对话式AI实时交互解决方案。豆包大模型团队的研发成果——Seed-ASR,为语音识别提供了强有力的支持。

Seed-ASR是一款先进的ASR(自动语音识别)技术,能够精确地转录各种语音信号,包括不同语言、方言和口音。即使面对人名或生僻词汇,Seed-ASR也能通过上下文信息如文本语音等,实现更为准确的转录效果。目前,该技术已被整合到豆包APP及火山引擎的相关服务模块中。

本文特别介绍了Seed-ASR的技术亮点:高精度识别、大容量模型、多语言支持、上下文感知以及分阶段训练方法。项目团队还分享了项目启动的初衷、研发过程中的心得与总结,并展望了大模型Scaling Laws对ASR技术的推动作用及其深远影响。

8月21日,在2024年火山引擎AI创新巡展上海站上,豆包大模型的最新进展得到了展示。根据公开及内部评估数据,相较于5月15日发布的版本,最新版豆包大模型的综合能力提升了20.3%,其中包括角色扮演能力提高了38.3%,语言理解能力提升了33.3%,数学能力提升了13.5%。据QuestMobile报告,基于豆包大模型开发的豆包APP月活跃用户数已达到2752万,在同类应用中排名第一,是排名第二的应用的2.43倍。

语音识别能力成为本次发布活动的重点之一。其中,语音识别与语音合成模型均实现了重要升级,同时对话式AI实时交互功能也已全新推出。

具体而言,豆包·语音合成模型提升了流式语音合成的能力,能够实现实时响应与精确断句,支持“边想边说”的功能。而豆包·语音识别模型则通过增强的上下文感知能力,推导出更加准确的识别结果,并且支持一个模型同时识别普通话以及粤语、上海话、四川话、西安话、闽南语等多种中国方言。

借助语音合成与语音识别等技术成果,火山引擎集成了云端实时音视频技术,实现了AI语音交互功能,其表现如同人类对话般可以进行打断与插话,并且端到端的延迟可降低至1秒之内。即便在网络条件不佳的情况下,即便数据包丢失率达到80%,仍能确保语音的清晰流畅。此次发布中,语音合成技术基于Seed-TTS实现;而语音识别技术则依赖于豆包大模型团队的另一项成果——Seed-ASR。

Seed-ASR基于大型语言模型构建,能将各式各样的语音转换为文本信息,从而使机器能够理解用户的语音输入,并智能地识别多种信息。

(2)专业术语的上下文推理

模型可以根据用户对字幕的历史编辑记录,关联并自动识别后续语音中的专业术语,例如滑雪中的“立刃”、“雪板”、“搓雪”等词汇。

(3)方言识别

即使是混合五种方言的语音交流,该模型也能准确识别并展示结果。如果预先提供相关的聊天背景信息作为提示,识别准确性将进一步提高。

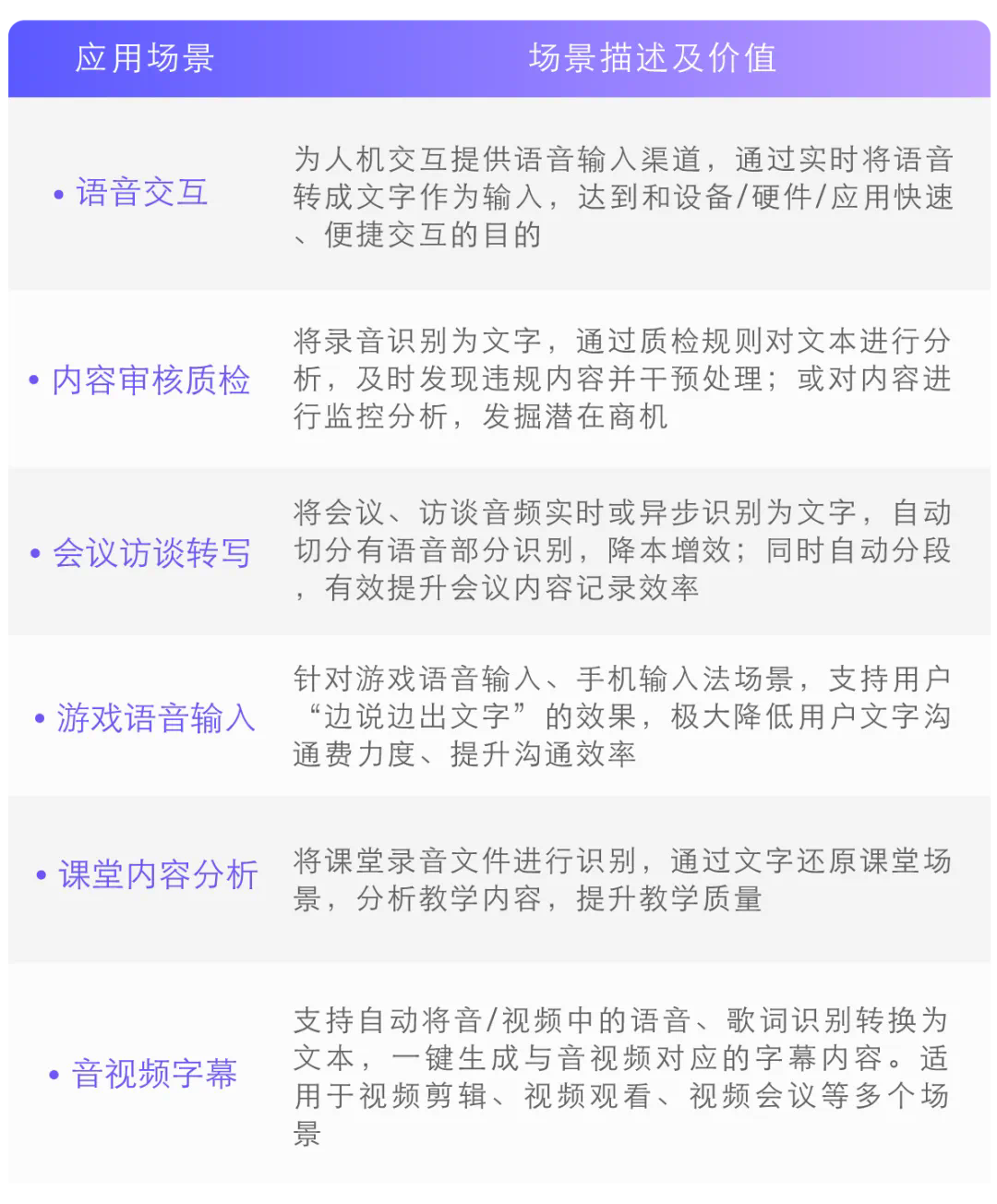

目前,Seed-ASR已应用于豆包APP中,被广泛用于英语口语练习、虚拟聊天伴侣、复制亲朋好友的声音等多种应用场景。针对更多的企业客户,Seed-ASR依托火山引擎,在语音交互、内容审查、会议采访转录以及音视频字幕等领域也得到了实际应用。

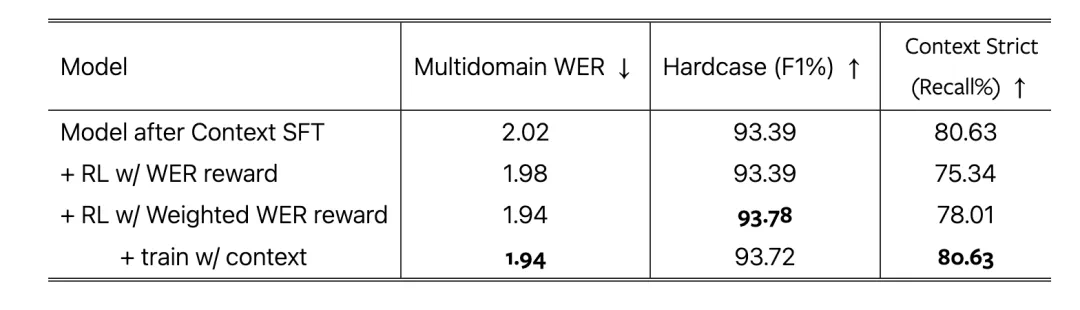

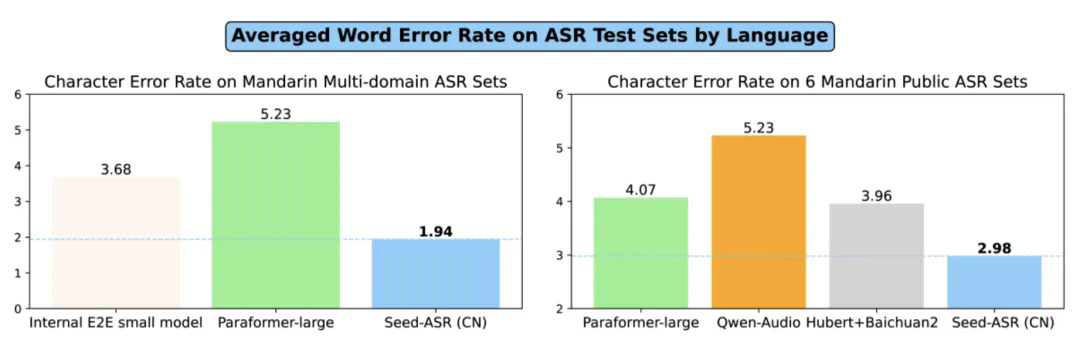

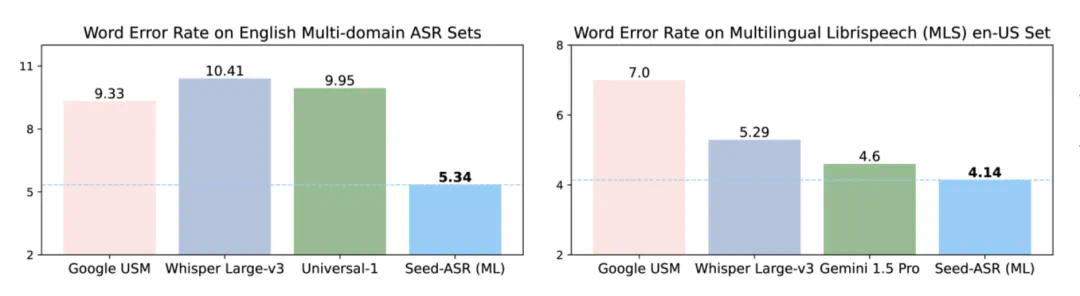

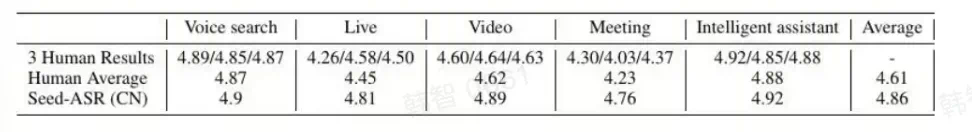

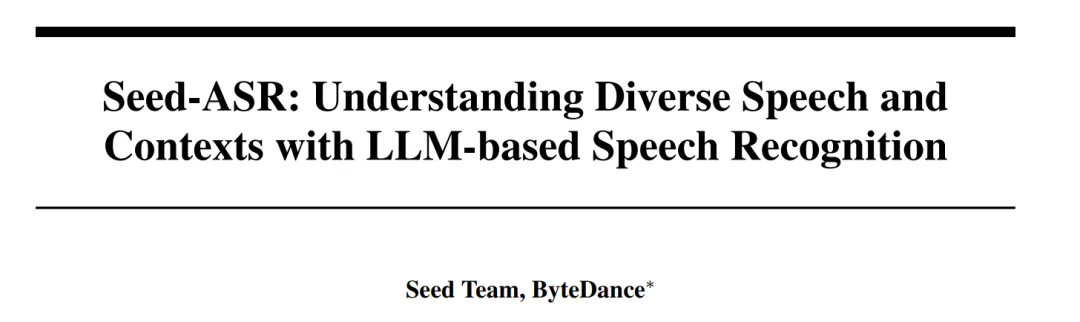

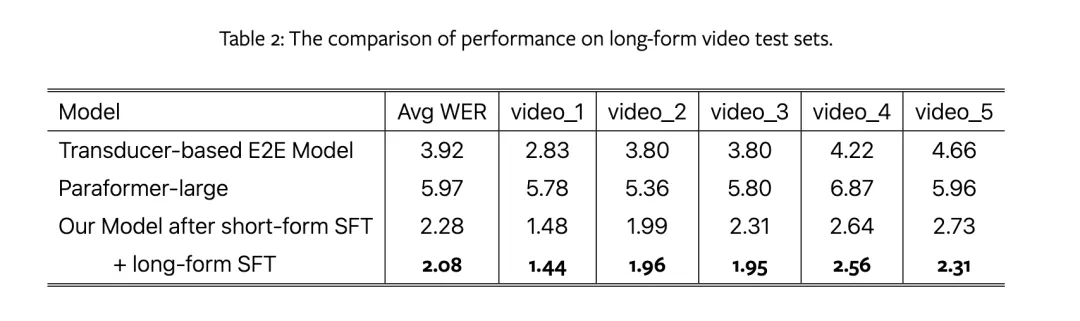

目前,技术报告《Seed-ASR: 通过LLM-based语音识别理解多样化的语音与语境》已公开发布。在多种语言、方言以及不同口音的综合评估集合中,相较于其他端到端模型,Seed-ASR展现出了显著的优势。与之前发布的大型ASR模型相比,Seed-ASR在中文和英文公开测试集上的单词错误率(中文按单字计算)降低了10%-40%,显示出了其独特的优势。

一些用户试用后反馈,该模型的实际表现超出了他们的预期,甚至能识别小孩子的话语。

欲了解更多技术细节和演示,请访问以下链接:

- 论文标题:Seed-ASR: Understanding Diverse Speech and Contexts with LLM-based Speech Recognition

- 论文链接:https://team.doubao.com/zh/publication/seed-asr-understanding-diverse-speech-and-contexts-with-llm-based-speech-recognition?view_from=research

- Demo展示:https://bytedancespeech.github.io/seedasr_tech_report/

项目Seed-ASR始于2023年初。随着ChatGPT的问世,大规模扩展法则成为了热门话题,各个领域的研究者们逐渐认识到,参数量和数据量的大幅增加使得模型具备了强大的理解和生成能力。

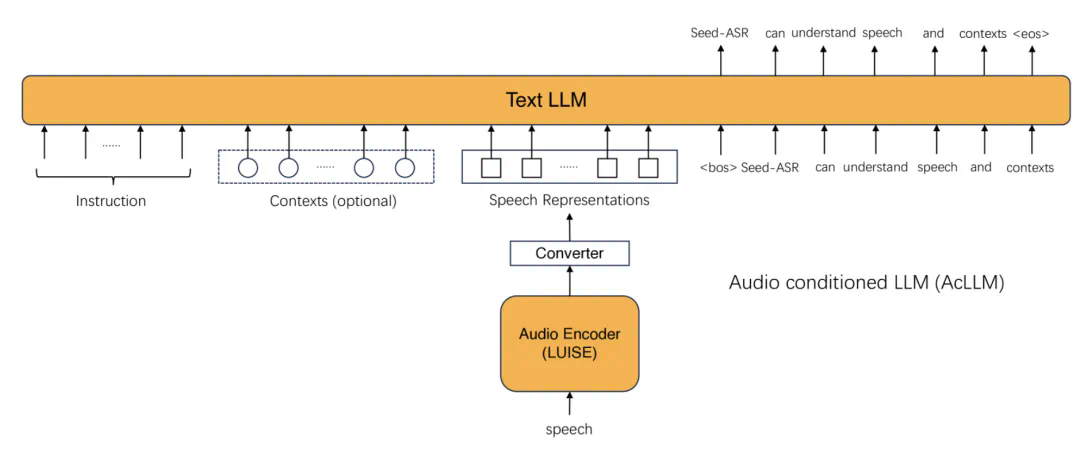

在此之前,语音识别与自然语言处理(NLP)一直紧密结合,因为语音到文本的转换在人类大脑中几乎是本能般的任务,对于机器来说也是如此。基于这样的背景,研究团队希望增强自动语音识别(ASR)模型,使其能够利用大型语言模型(LLM)的丰富知识库来提高识别准确度。这项工作促成了 Seed-ASR 的诞生。

从技术角度来看,Seed-ASR 的核心优势体现在两个方面:

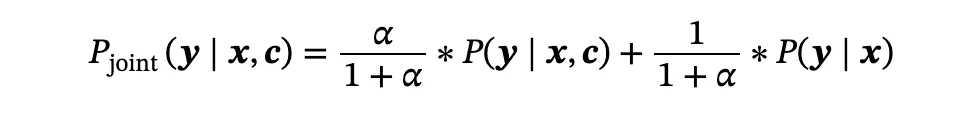

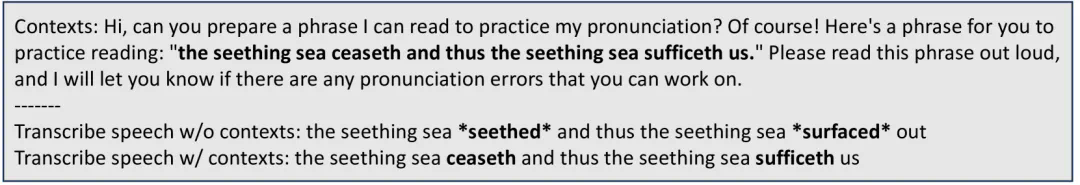

- 引入上下文理解能力:借助大型模型的支持,Seed-ASR 能够更好地理解语音信号中的上下文。具体来说,研究团队构建了多样化和有效的训练数据集,这激发了模型的语音识别能力,使得模型可以结合文本内容来捕捉语音中的关键信息。在实际应用中,团队还设计了解码策略来减轻上下文引入可能导致的问题,如幻觉或错误转写。

这项工作意味着,在与 AI 对话时,模型不仅能够理解专业术语,还能在会议记录中“听懂”新加入的参与者的名字。随着对话的进行,上下文信息逐渐积累,后续的转录准确率也会随之提高。

- All-in-One 设计带来的广泛适用性:传统的 ASR 模型往往针对特定领域,需要特定模型来解决细分问题,并且通常配备专门的方法来融合不同领域的数据。一旦离开特定场景,其性能往往会下降。相比之下,Seed-ASR 采用了 All-in-One 的设计理念,具有强大的泛化能力,适用于各种不同的场景,更加灵活简便。

除了以上两点,Seed-ASR 还具备高准确度的识别能力和多语言支持的特点。其中,中文版本支持 13 种方言,多语言版本支持英语和其他 7 种语言,并且正在扩展支持 40 种语言。

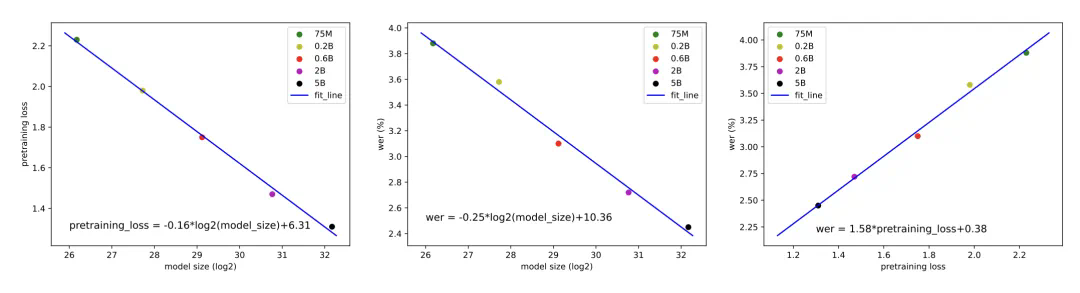

这些强大的功能主要得益于“规模化法则”(Scaling Laws)的理念。随着模型规模的扩大以及更多样化的数据引入,模型的泛化能力和功能显著增强。这一过程类似于 GPT 系列的发展历程。此外,分阶段的训练方法不仅提升了模型的识别准确度,还增强了模型利用上下文进行推理的能力。

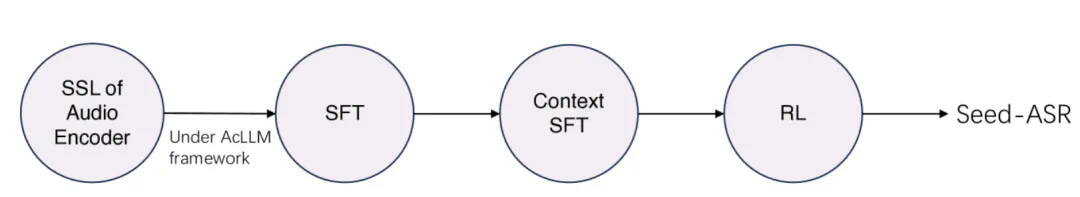

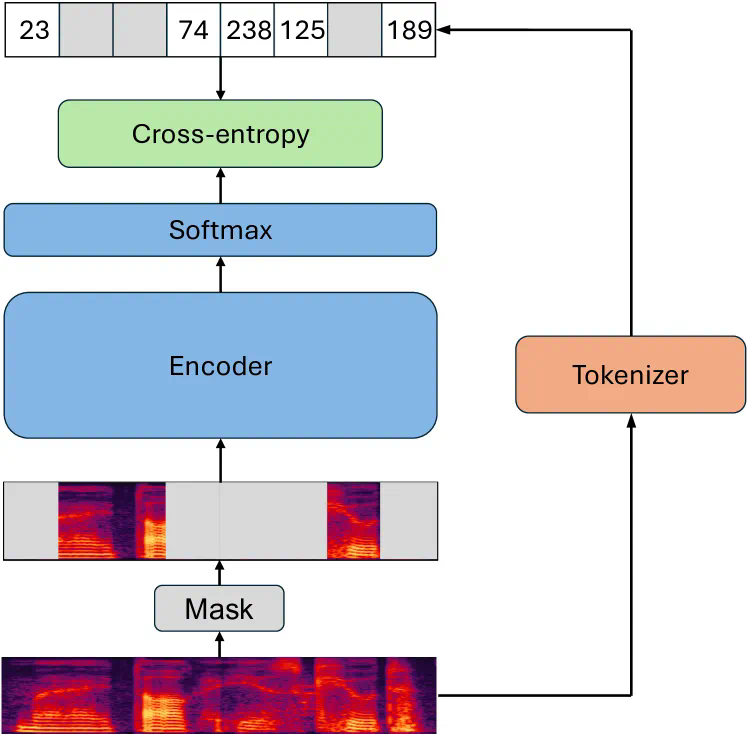

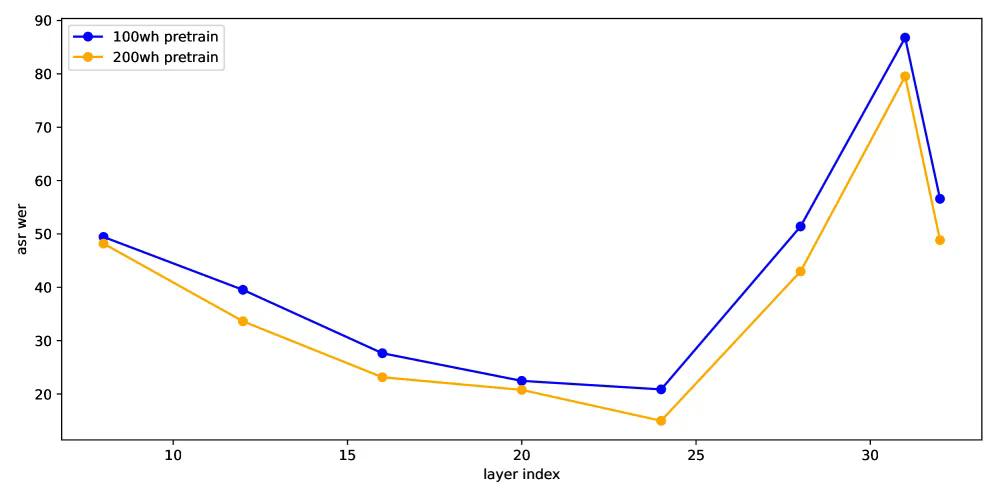

在开发Seed-ASR的过程中,我们引入了分阶段训练方法,并在此基础上构建了一个基于音频条件的大型语言模型框架,我们称之为AcLLM。

以下是一系列展示大模型时代下的自动语音识别(ASR)技术卓越表现的现场评估图片:

大模型时代的ASR确实不同凡响!现场评估

大家在看