仅用10行代码就能使大型模型的数学能力提高20%,这种非传统的研究方法连谷歌也开始测试了。

编辑日期:2024年08月24日

重写如下:

只需短短十行代码,即可显著提升大型模型在数学问题解决方面的能力高达20%!

几位独立研究者提出了一种优化大型模型采样过程的方法,此提议已引起开源社区的高度关注。

该方法已在Mistral-7B模型上验证了其有效性,并且在Llama-70B模型上的实验也正在进行中。

这一方法被命名为最小p采样(min-p sampling),其核心目标在于平衡生成文本内容的连贯性和多样性。

简而言之,就是在面对事实性问题时确保模型的表现稳定性,在需要创意表达如写作等场景下又能展现出多样化的创造性。

目前,该方法已经在Mistral-7B模型上取得了成功,并将在Llama-70B模型上进一步测试。

据论文作者介绍,这一方法已经受到了开源社区的广泛采纳和应用。

此外,作者还透露,包括Anthropic和谷歌在内的闭源模型制造商也已经开始或将要对min-p采样方法进行测试。

这一消息也得到了来自谷歌的确认。此前从OpenAI转投谷歌的开发者社区负责人Logan Kilpatrick已回应称:“正在着手处理。”(On it)

微软的Copilot研究人员Abram Jackson对此表示,这是他所见到的第一个关于改进推理过程中token采样的方法,并认为这一领域仍有巨大的发展空间。

值得注意的是,这项备受瞩目的研究的主要作者Minh Nhat Nguyen实际上并没有接受过系统的计算机科学教育,他是通过自学成为专家的。

在一家名为Apart Research的人工智能安全研究机构的支持下,Minh和他的团队共同完成了这个项目。

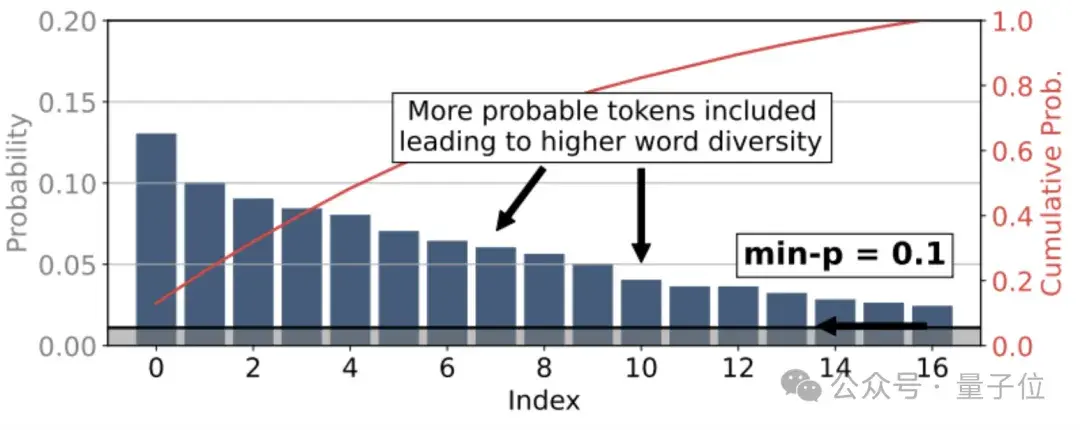

min-p是一种动态截断抽样技术,其核心思想是根据每一步中token分布的最大概率来调整最小概率阈值。

这种方法的主要目标是在保证生成文本的连贯性的同时增加多样性,尤其是在温度参数(temperature)较高的情况下尤为重要。

具体而言,min-p引入了一个基础概率阈值p_base,作为进入采样池的最低概率标准。

在每一步生成token的过程中,min-p会将p_base与当前概率分布中的最大token概率p_max相乘,以获得一个缩放后的绝对阈值p_scaled。

只有那些概率大于或等于p_scaled的token才能被选入采样池。

当模型对某个特定token的预测概率非常高(即p_max非常大)时,p_scaled的值也会相应提高,从而大幅度缩小采样池,排除大多数低概率的token,只保留那些最有可能的选择,以此确保输出内容的一致性和连贯性。

当模型对所有词汇单元的预测概率较为接近(即较低的\( p_{max} \)值)时,\( p_{scaled} \)值也会相应降低,从而放宽了对采样池的限制,允许更多中等概率的词汇单元进入,为模型提供更大的发挥空间,生成更多样化的输出内容。

确定采样池后,min-p方法会依据temperature参数对词汇单元的概率分布进行缩放处理。

具体来说,通过将每个词汇单元的对数概率除以温度参数\( \tau \),并进行归一化,得到temperature缩放后的概率分布。

当\( \tau > 1 \)时,概率分布变得更加平滑,增加了低概率词汇单元被选中的可能性;

而当\( \tau < 1 \)时,则使得分布更为集中,进一步突显高概率词汇单元的优势。

最终,min-p方法会根据调整后的概率分布,从缩放后的采样池中随机选取下一个词汇单元。

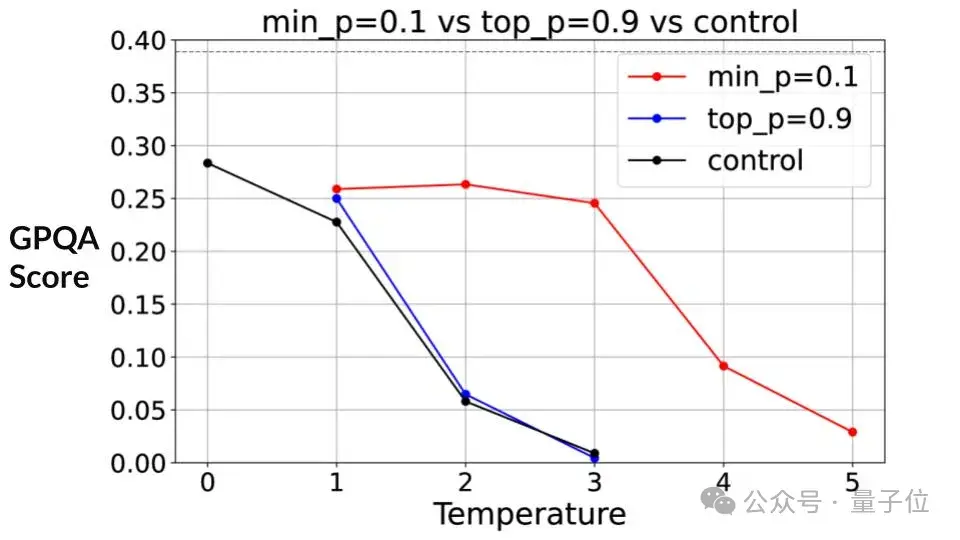

那么min-p方法的实际效果如何呢?作者使用了Mistral-7B作为基准模型进行了测试,让我们来看看不同情况下的结果。

在推理任务方面,作者采用GPQA数据集进行了评估。当temperature设置为1时,min-p方法相较于传统的top-p方法显示出了一定的优势。

随着temperature的提高,GPQA得分总体呈现出下降趋势,但是min-p方法的得分下降速度明显慢于top-p方法。

直至temperature达到3时,min-p方法的得分下降趋势才变得明显,而此时top-p方法的得分已经接近0。

这意味着,在推理任务中,与top-p方法相比,min-p方法能够更好地维持所需的稳定性。

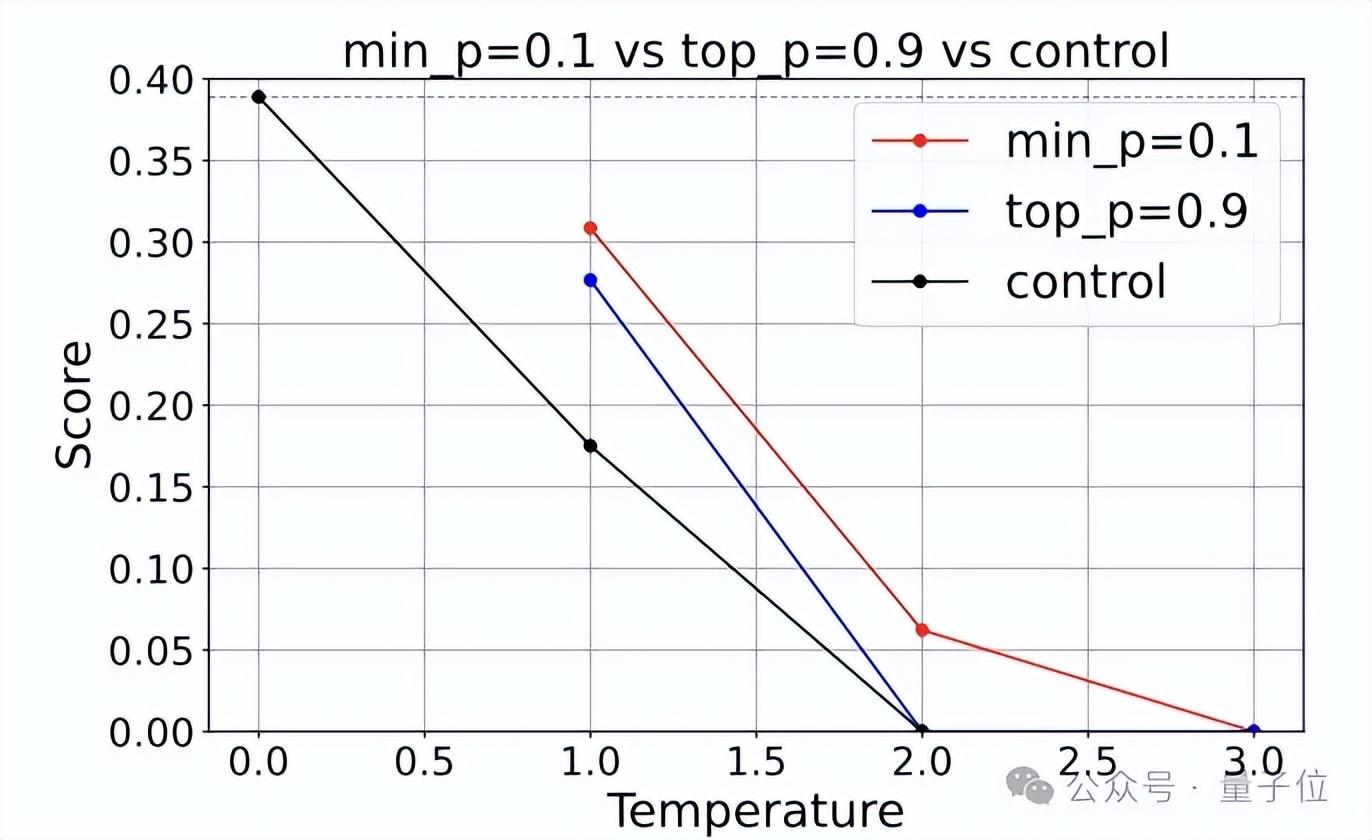

对于需要保持稳定性的数学类任务,作者使用了GSM8K数据集进行了测试。

min-P对应的得分随着温度降低而减少的速度比在GPQA中更快,但仍慢于top-P方法。

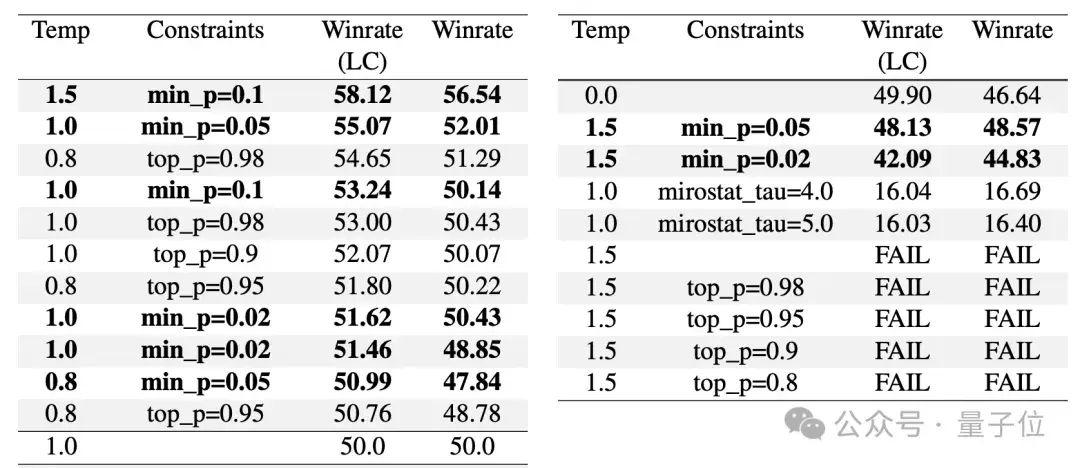

第三类任务涉及创意写作,在这种情况下,稳定性的重要性降低,而模型需要展现更高的创造力。

此测试采用AlpacaEval数据集进行,并从开源社区的一位独立评估员处获取了实验数据。

实验结果表明,在温度设为1.5、min-P设为0.1的情况下,min-P的表现尤为显著,能产生top-P方法难以创造的创意写作内容。

在此设定下,min-P方法生成的文本获得了58.12%的人类评分优选率,显著高于其他方法在相似设置下的表现。

论文链接:https://arxiv.org/abs/2407.01082

GitHub仓库:https://github.com/menhguin/minp_paper/

参考链接:https://x.com/menhguin/status/1826132708508213629

但对于Claude似乎不适用。

提供全面的端到端实时3D虚拟人服务。

使用仅仅10行代码就能大幅提升大型模型的数学处理能力。

这些大型模型的背后,隐藏着“新小米”成功的关键因素。

此外,还有一个开放的服务平台支持着这一切。

(注:原文中的图片链接并未给出实际内容,因此在重写时根据语境进行了推测性的翻译。)

大家在看