复旦和港大团队开发出受大脑启发的动态神经网络,实现了超强大的2D和3D视觉功能,同时降低了93.3%的能耗。

编辑日期:2024年08月26日

由复旦大学、香港大学与中国科学院等机构的研究人员组成的一个联合团队,开发了一种受大脑启发的动态神经网络设计方案,采用基于忆阻器的技术实现语义记忆。此方案旨在模仿人脑的动态特性、联想记忆功能及高效性,具体而言,就是通过将新输入数据与以往经验(以语义向量形式存储)相联系来实现信息处理。

在这一系统中,网络和语义存储部分被分别部署在基于噪声容限三元忆阻器的计算内存(CIM)电路和内容寻址存储器(CAM)电路上。研究人员通过使用40纳米级的忆阻器宏,在ResNet和PointNet++架构上进行了验证,分别对MNIST和ModelNet数据集中的图像及三维点云进行了分类。实验结果表明,该设计不仅能够达到与纯软件处理相当的精度,同时显著降低了计算成本(分别减少48.1%和15.9%),并大幅削减了能耗(分别降低77.6%和93.3%)。

这项研究以“基于忆阻器的语义记忆动态神经网络在二维和三维视觉中的应用”为题,发表在2024年8月14日的《Science Advances》杂志上。

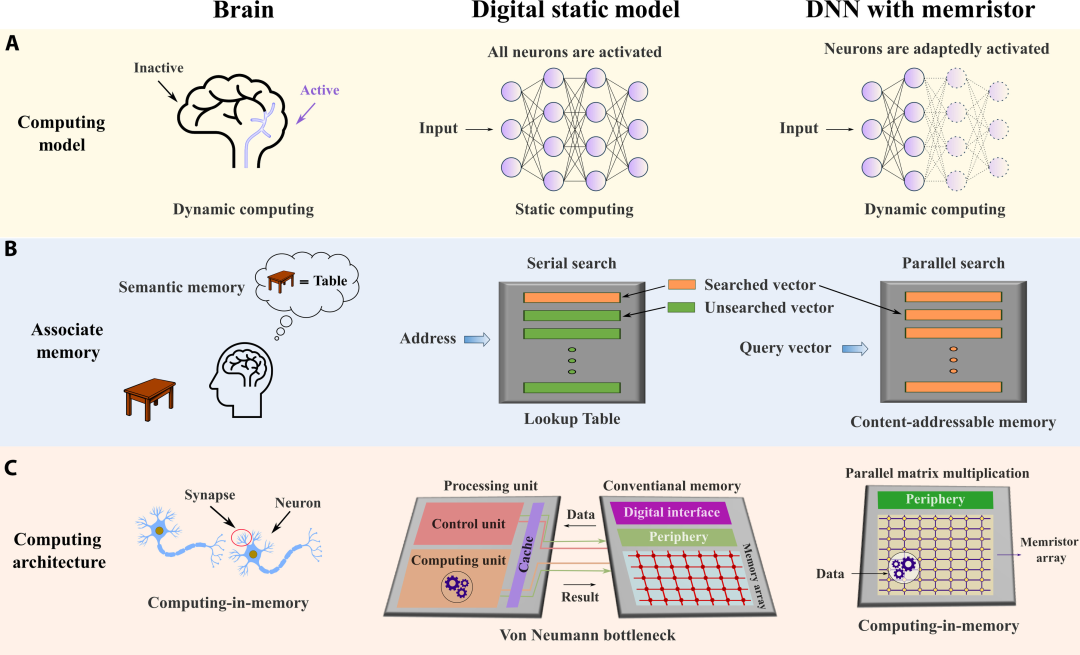

人脑能够在较低的能量消耗下高效地执行复杂的任务,这得益于其动态重组的能力、与过往经历相关的联想记忆机制,以及记忆与信息处理紧密结合的方式。这些特点为人造智能系统的改进提供了重要启示。

大脑处理信息的方式是动态且适应性强的。大脑的神经网络不会保持静态的计算模型,而是对各种刺激和任务展现出复杂的动态激活与连接模式。这些动态连接主要由结构可塑性驱动。此外,大脑还能表现出另一层面的动态行为:面对不同复杂度的对象或任务时,大脑的不同区域会被激活。

大脑中的神经活动模式在不同的区域各不相同,并且随时间变化,使得大脑能够整合感官信息、作出决策并适应新情况。大脑的这种动态特性让它能高效处理任务,同时消耗最少的能量。

相比之下,多数神经网络是静态的,具有固定拓扑结构,缺乏这种适应性,导致资源分配效率不高,在处理变化多端的信息或任务时受限。

大脑能够将新信息与过往经验联系起来,如在语义和高级视觉处理领域。生物学实验表明,大脑可以通过神经元内记忆的编码与检索过程来加速对熟悉对象的识别,充当语义缓存,实现过往经历的快速检索。

然而,传统计算机依赖基于地址的信息存储与查找方式,而非根据相似性来关联观察结果。

此外,大脑不仅利用化学突触存储信息,还能在存储信息的同时进行信息处理,具备低功耗和高并行性特点。

这与当前冯·诺依曼架构下的数字计算机面临的高能耗及延时挑战形成鲜明对比,后者因计算单元与存储单元分离,需要频繁的数据传输。

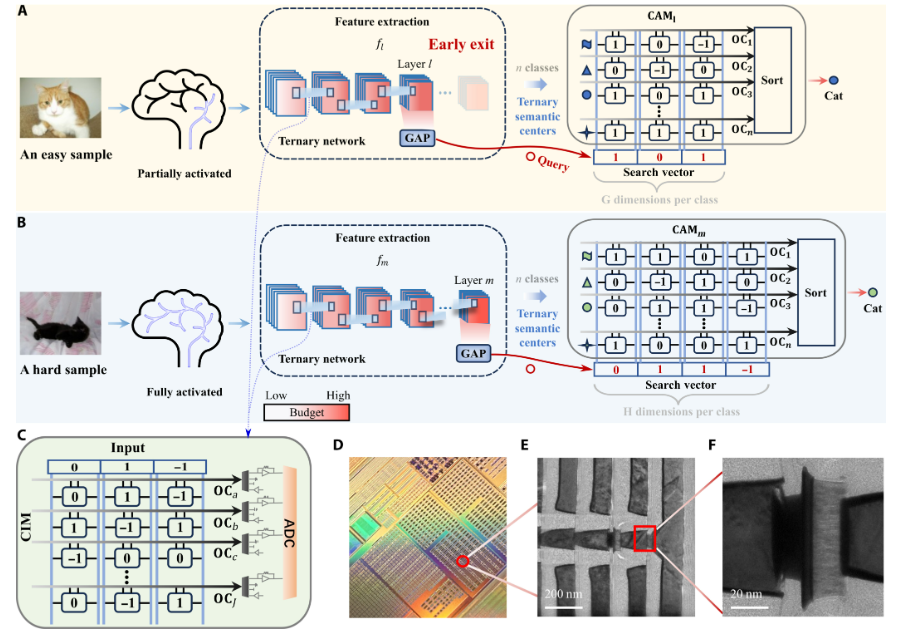

在最新研究中,来自复旦大学、香港大学等机构的研究团队提出了一种硬件-软件协同设计方法,即采用忆阻器的基于语义记忆的动态神经网络(DNN),旨在体现大脑计算范式的三大特征。

从软件的角度来看,基于语义记忆的深度神经网络(DNN)旨在为人工神经网络赋予类似大脑的动态可重构性。这种网络将新信息与过往经验相关联,并按需分配计算资源,在多种应用场景中展现出比静态网络更高的效率和效能。此外,其适应性允许网络通过实时调整不同的计算预算来平衡准确度和效率,非常适合计算预算可能波动的场景,如资源受限的设备或分布式计算环境。

在硬件层面,研究者利用忆阻器(一种物理特性与大脑突触相似的新颖器件),借助内存计算(CIM)和内容寻址存储器(CAM)电路来物理实现具有噪声抵抗能力的DNN和三值权重的联想语义记忆。

基于忆阻器的CIM电路采用简单的物理定律执行矩阵向量乘法。由于矩阵权重物理存储在忆阻器阵列中,且乘法运算直接在权重存储位置执行,这些电路整合了计算和存储元素,不仅能克服冯·诺依曼瓶颈,还能实现高度并行化。

基于忆阻器的CAM电路作为一种受大脑启发的联想存储器,可在DNN中充当语义缓存存储器。与依赖地址检索信息的传统电子存储器不同,大脑和CAM具备并行的内容基础搜索功能。具体而言,CAM测量输入向量与存储在内存中的向量之间的距离,从而避免了像CIM那样的数据移动。

图示:硬件-软件协同设计:使用CIM和CAM的基于语义记忆的动态神经网络。(来源:论文)

动态ResNet应用于二维视觉

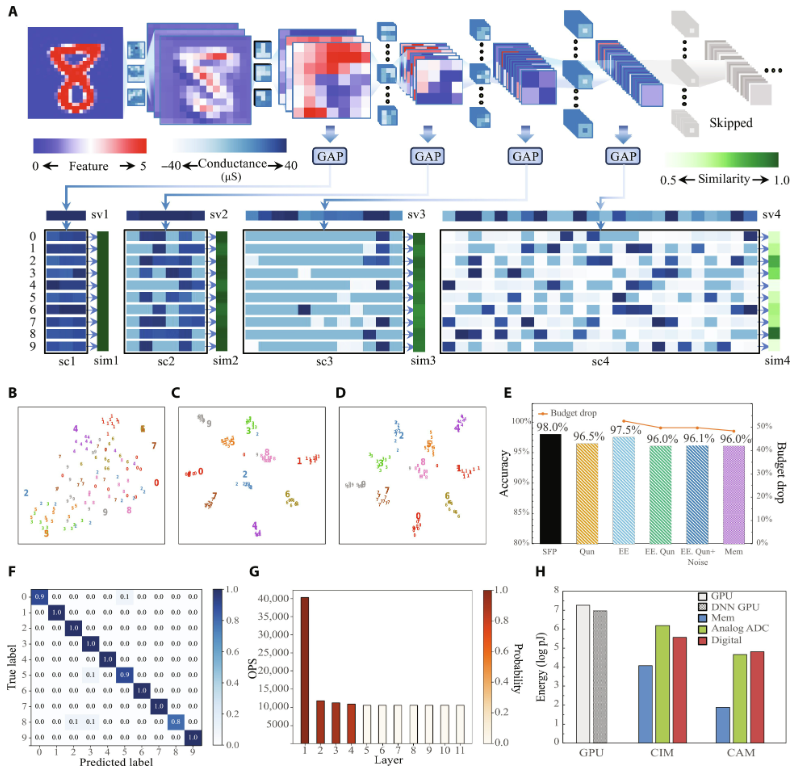

研究者将协同设计应用于使用ResNet模型对MNIST数据集进行分类的任务。他们展示了基于忆阻器的混合模拟-数字系统的前向推理实验实例。

首先对模型和语义记忆进行原位训练,之后进行量化并物理映射到基于忆阻器的CIM和CAM中。

在推理流程中,手写图像(如数字 8)被转换为电压信号,CIM 进行物理计算以得出每个残差块的特征图。这些特征图经过全局平均池化 (GAP) 后产生每个残差块的关联搜索向量,并通过计算余弦相似度与 CAM 中对应区块的语义中心进行对比。当正向传播到达第四个块时,计算出的第八类别的相似度超过了设定阈值,这表明系统有足够的信心将输入的手写数字分类为 8。因此,正向传播在此处终止,并跳过后续的所有残差块。

图示:针对 MNIST 数据集分类的硬件与软件共同设计的动态 ResNet 结构。(来源:论文)

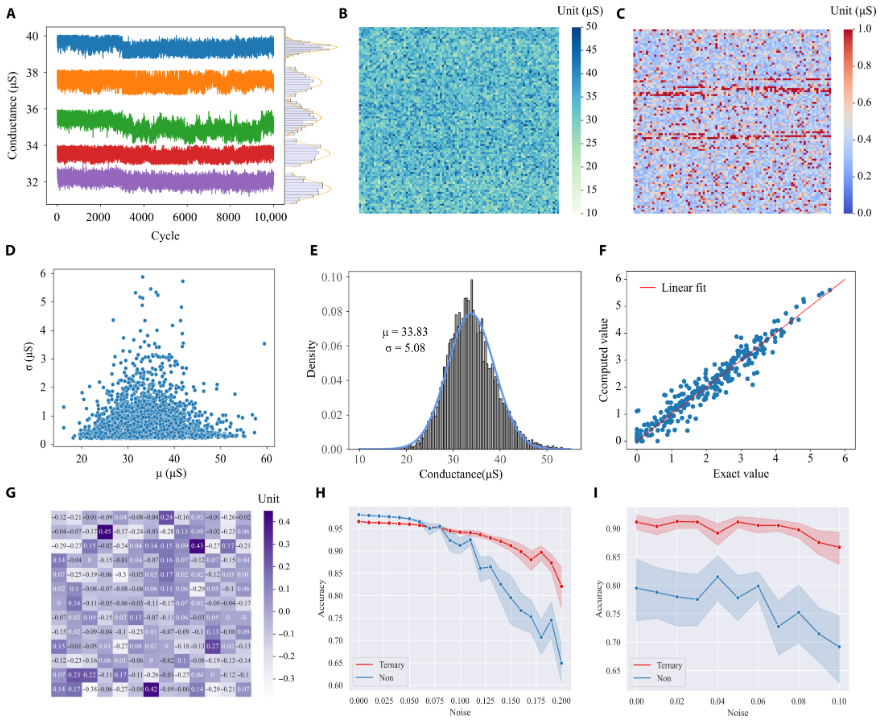

采用三元量化模拟噪音抑制

噪音抑制对于基于忆阻器的模拟计算至关重要。

研究团队在协同设计中面临两种主要噪音类型:写入噪音和读取噪音。写入噪音源自于忆阻器编程过程中的随机性,而读取噪音则源于电导随时间波动的问题,这是由编程不稳定性及其他电子噪音共同造成的。

图示:忆阻器固有的物理噪音及利用三元量化网络的缓解措施。(来源:论文)

为了减轻写入和读取噪音对基于忆阻器的 CIM 和 CAM 的影响,研究人员采用了权重和语义中心的三元量化技术,这种方法的表现优于受到写入和读取噪音影响的全精度映射模型。研究团队还模拟了写入噪音对有无三元量化动态 ResNet 分类准确性的影响。

三元量化网络对增加的写入噪音表现出较强的韧性,而全精度映射网络的性能则随着编程噪音的增加而迅速下降。

此外,研究人员在固定 15% 的写入噪音条件下模拟读取噪音的影响。与直接将全精度权重映射到忆阻器相比,三元量化网络的准确性提高了 10%。

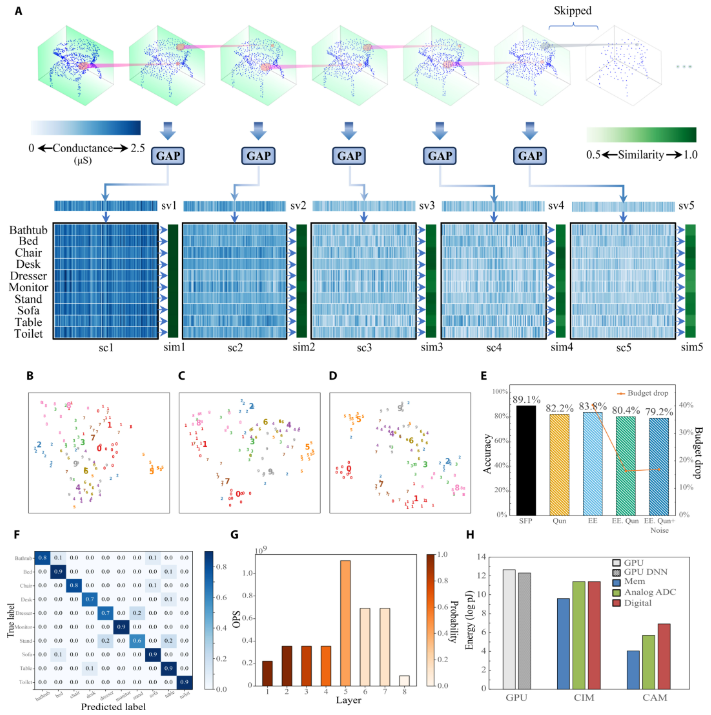

应用于 3D 视觉的动态 PointNet++

尽管是二维图像,但随着三维传感技术的发展,三维点云在捕捉及解析三维物体空间特性方面的价值愈发凸显。三维点云的分类对于自动驾驶、机器人学和增强现实技术至关重要。研究团队采用PointNet++模型来模拟他们的协同设计方案,并对ModelNet数据集进行分类。PointNet++包含多个集合抽象(SA)层,这些层以层级方式运作,每一层选择代表性点,变换邻近所有点的特征,并聚合邻近点特征以更新代表性点的特征。

这样,PointNet++能够捕捉不同层次的局部与全局特征,广泛应用于三维点云的分类与分割。

使用TPE解决预算与精度间的折衷优化问题

每一层的阈值扮演着关键角色,它决定输入样本是否能提前退出以降低计算成本,或继续前向传播以提高精度,从而在精度与效率间达到平衡。

目标是寻找一个帕累托最优解,实现DNN计算预算与精度之间的平衡。

首先,研究者采用网格搜索来探究计算预算与精度之间的关系。接着,他们设计了一个同时考虑计算预算与精度的目标函数,并运用TPE方法优化各层阈值。目标函数的最优解即为一个能在计算预算与精度之间取得平衡的DNN。

计算预算显著降低,在基于语义记忆的DNN对MNIST数据集进行分类时减少了48.1%,对ModelNet数据集进行分类时减少了15.9%。

此外,能源效率大幅提高,与顶级GPU相比,对各数据集分类的能耗分别降低了77.6%和93.3%。

这些成果为未来研究如何模仿大脑对计算资源的自适应分配、联想回忆过往经验以及记忆与处理的协同提供了新的路径。

相关报道:https://www.science.org/doi/10.1126/sciadv.ado1058

(这只是一个链接翻译,实际上并没有重写文本的内容。您需要我重写具体的文本内容吗?)