三位程序员连续努力三天,对推理堆栈进行了重写,使得Grok-2 mini的运行速度直接提升了两倍。对此,马斯克还亲自发来了祝贺的信息。

编辑日期:2024年08月26日

持续使用Grok-2的用户可能会发现,最近这两天它的响应速度似乎有所提升:

上周,xAI推出了Grok-2聊天机器人,并在X平台上以每月8美元的价格提供服务。

用户的感受并非错觉——无论是Grok-2还是其速度更快但功能较简化的版本Grok-2 mini,在处理信息和生成回复方面确实变得更快了。

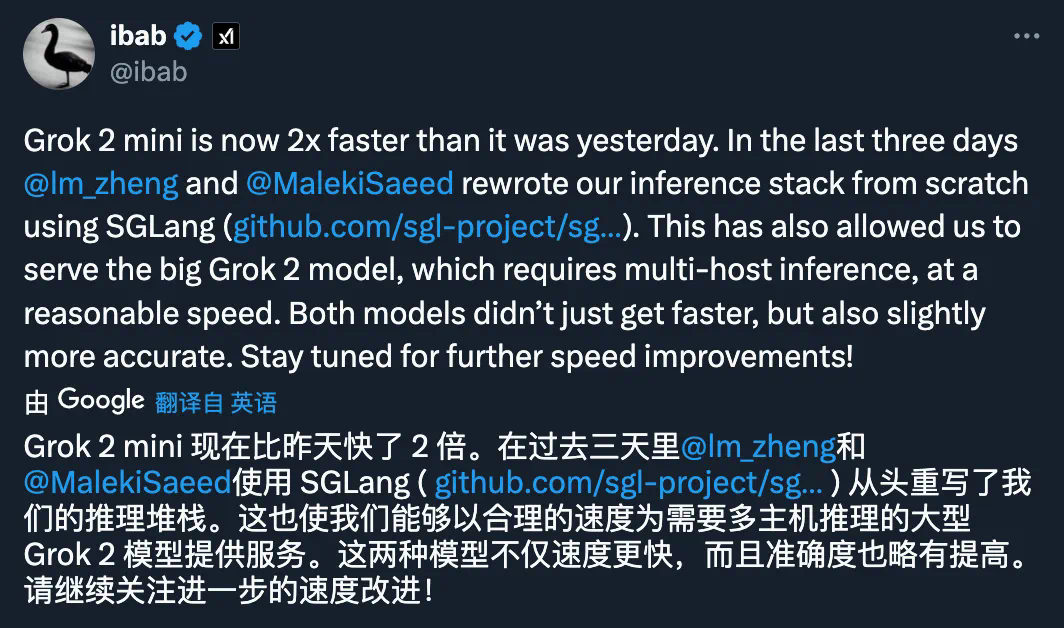

这一加速的背后,是xAI的开发人员Igor Babuschkin发布的一则更新,揭秘了这一变化的原因:

正如他所言,他与xAI的另外两位开发者Lianmin Zheng和Saeed Maleki共同努力了三天时间,使用SGLang对推理技术栈进行了重写。

这次的努力取得了显著成果:根据评估AI模型性能的第三方平台Lmsys Chatbot Arena最新的排行榜更新显示,Grok-2主模型在6686次投票中获得了1293分,这意味着Grok-2与Google的Gemini-1.5 Pro模型并列成为全球第二强的人工智能模型,仅次于OpenAI的最新版ChatGPT-4o,且超过了GPT-4o(2024年5月版)。

图片来源:https://x.com/lmsysorg/status/1827041269534879784

Grok-2-mini 也因此次改进而获益,其排名跃升至第五位,在7266票中获得了1268分的Arena分数,仅位于GPT-4o mini和Claude 3.5 Sonnet之后。

他们的辛勤工作得到了回报,老板马斯克也发来了表扬:

根据Babuschkin在X平台上的回应,相较于完整的Grok-2模型,使用Grok-2-mini的主要优势在于更快的速度。

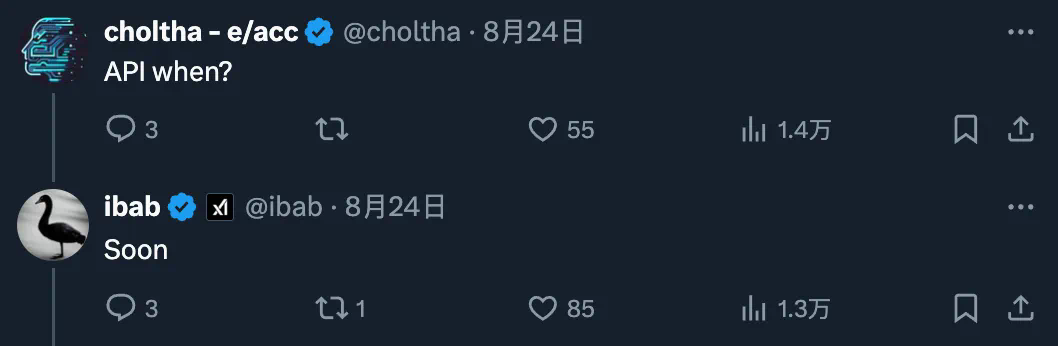

Babuschkin还承诺,xAI将进一步提升Grok-2-mini的处理速度,这将使其成为追求高性能且低计算成本用户的更优选择。此外,他还透露了一些关于API的信息:

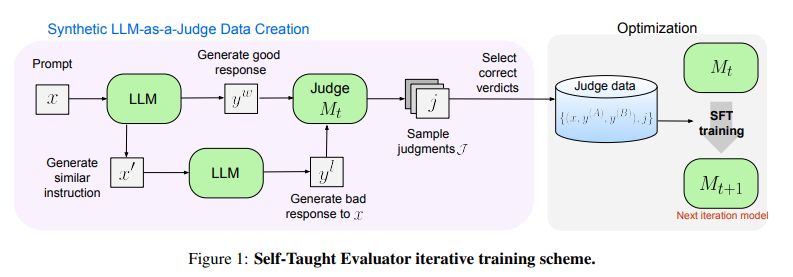

这也让人不禁好奇,SGLang为何能有如此显著的效果?

SGLang是由来自加州大学伯克利分校、加州大学圣地亚哥分校以及卡内基梅隆大学的研究人员共同开发的。

目前,SGLang支持Llama、Mistral和LLaVA等多种模型,并与OpenAI的GPT-4等基于API的开放模型兼容。SGLang能够通过自动缓存重用和并行处理在单一程序中优化执行流程,这使得它成为了开发者处理大规模语言模型的强大工具。

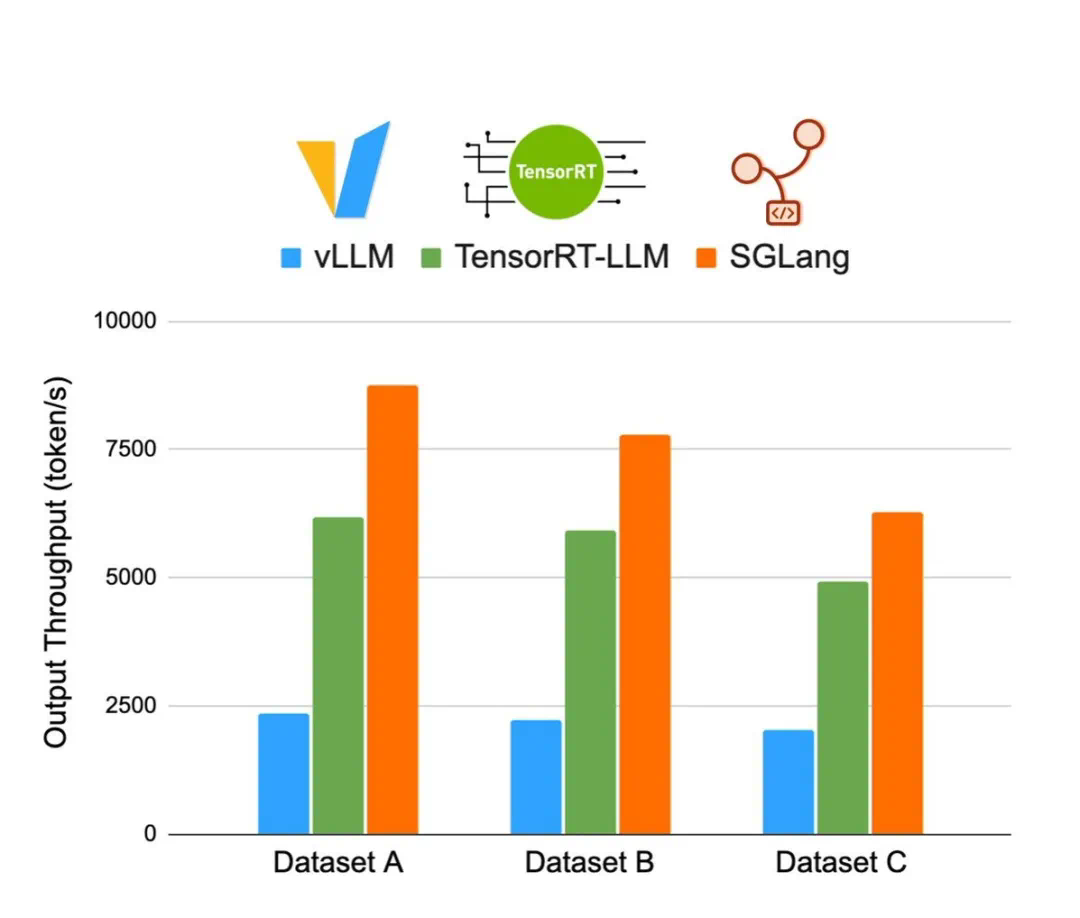

7月底,团队发布了全新的SGLang Runtime v0.2版本。这款服务引擎适用于大型语言模型(LLM)与视觉语言模型(VLM)。在运行Llama 3.1 405B模型时,相较于vLLM及TensorRT-LLM,SGLang Runtime v0.2展现了更优的吞吐量与更低的延迟。特别是在运行Llama系列模型时,其吞吐量可达到TensorRT-LLM的2.1倍,vLLM的3.8倍。

更多信息,请参考:《获贾扬清好评:SGLang更新至3K stars,加速Llama 405B推理超越vLLM、TensorRT-LLM》

大家在看