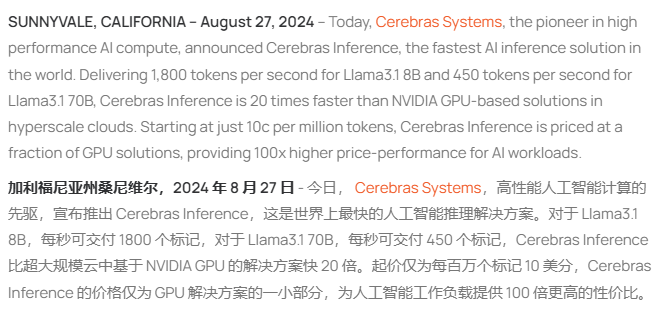

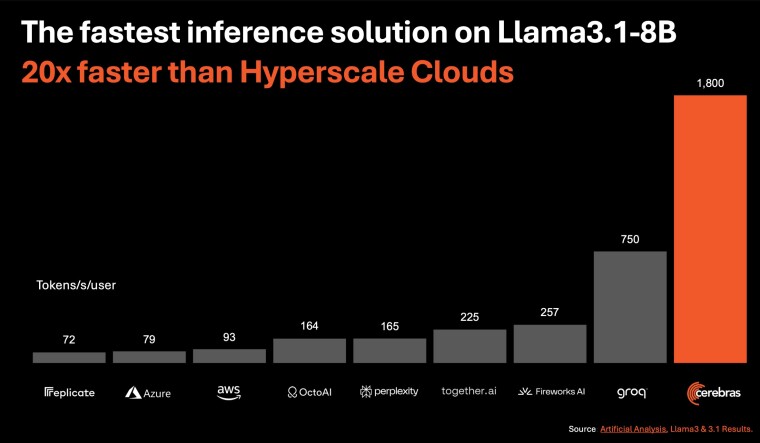

Cerebras 发布全球最快的人工智能推理解决方案,其速度是 NVIDIA 方案的 20 倍。

编辑日期:2024年08月28日

除了令人难以置信的性能外,这款新型推理解决方案的定价也远低于流行的GPU云服务,起价仅为每百万个token 10美分,从而为AI工作负载提供了高达100倍的性价比。

该方案将使人工智能应用程序开发人员能够构建下一代人工智能应用程序,而无需牺牲速度或增加成本。该方案采用了 Cerebras CS-3 系统及其晶圆级引擎3(WSE-3)人工智能处理器,其中 CS-3 的内存带宽是 Nvidia H100 的 7000 倍,从而解决了生成式人工智能的内存带宽技术难题。

据了解,Cerebras Inference 提供了以下三个层级:

(注:原文本语句已经很简洁明确,未做过多改动。如果需要更详细的重写,请告知具体要求。)

Cerebras 囨隊表示:“憑藉創紀錄的性能、業界領先的定價以及開放的 API 訪問,Cerebras Inference 為開放的大型語言模型(LLM)開發和部署設定了新的標準。作為唯一能夠同時提供高速訓練和推理的解決方案,Cerebras 開啟了人工智能的全新可能性。”

人工智能领域正在迅速发展,尽管英伟达目前在AI市场占据主导地位,但Cerebras和Groq等公司的崛起预示着行业格局可能发生变化。随着对更快、更具成本效益的AI推理解决方案需求不断增长,这些新兴企业正试图颠覆英伟达的领导地位,特别是在推理领域。