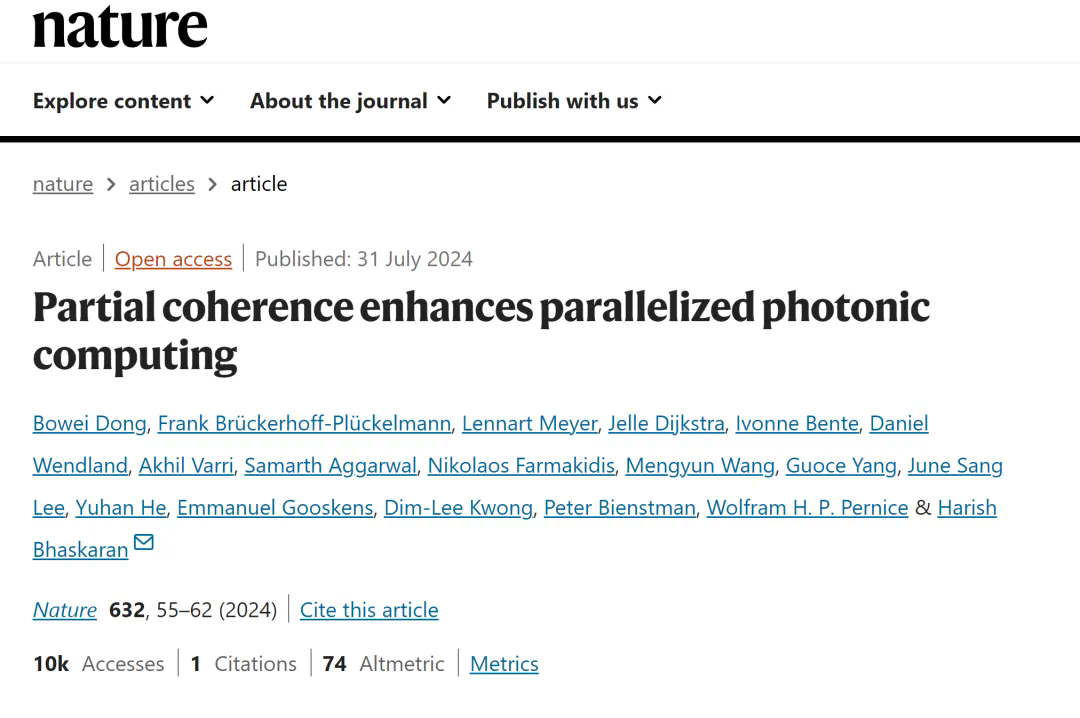

牛津大学关于光计算的研究论文登上《自然》杂志正刊,对帕金森病患者步态的分析准确率达到了92.2%。

编辑日期:2024年08月28日

该论文的第一作者是牛津大学的董博维博士,他来自 Harish Bhaskaran 院士的课题组。2022年,Harish Bhaskaran 院士课题组的多名科研人员在中国联合创立了光计算芯片公司——光本位科技。今年7月,在世界人工智能大会上,该公司宣布其研发的128×128矩阵规模的光计算芯片在算力密度和精度方面达到了商用标准。目前,董博维博士已与该公司合作,共同推动光源、相变材料及硅光互联架构等多个方面的光子存算技术在人工智能领域的商业化应用。

光计算的时代或许正在加速到来。

随着人工智能等技术对算力需求的不断增长,传统电子计算在算力供给能力上逐渐难以满足这些需求,因此寻找新的算力增长点变得至关重要。

光计算具备高并行度、高能效比和高速度等特点,在构建大规模矩阵-矩阵并行计算系统时展现出显著优势。近年来,光计算领域取得了诸多重要的研究成果和进展。

近日,牛津大学 Harish Bhaskaran 院士课题组的研究人员,包括董博维博士,在《Nature》期刊上发表了题为“部分相干光可增强并行光计算”的论文。

论文链接:https://www.nature.com/articles/s41586-024-07590-y

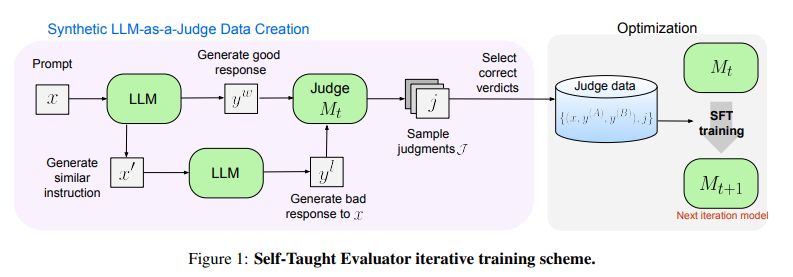

论文标题:Partial coherence enhances parallelized photonic computing

在他们的论文中,研究人员证明了降低光学相干性可以增强光子卷积处理的效果。他们提出了一种利用降低时间相干性的光子卷积处理系统(即部分相干系统),从而在不明显损失精度的情况下提升处理的并行性,并有望实现大规模的光子张量核。这种方法避免了对大量移相器或微环谐振器(MRR)进行精确控制的需求,并通过使用部分相干光源减轻了对严格反馈控制和热管理的要求。

研究团队还在两个用于计算应用的光子平台上展示了部分相干处理的广泛适用性:首先,他们使用相变材料光子存储器,通过 3×3 的光子张量核进行并行卷积处理,成功分类了十名帕金森病患者的步态,准确率达到 92.2%。其次,他们利用带有嵌入式电吸收调制器(EAM)的 9×3 硅光子张量核实现了高速 0.108 TOPS 的卷积处理器,用于矢量编码和权重设置,并结合片上光电探测器对 MNIST 手写数字数据集进行分类,准确率达到 92.4%。

光计算将引领人工智能的新变革

光计算主要通过芯片来实现,这种芯片被称为光芯片。光芯片是在成熟的 CMOS 电芯片工艺节点(如 180nm、130nm、90nm)基础上改造而成的硅基光电子工艺芯片,可应用于通信、传感和计算等领域。在光通信领域,各大光通信厂商已经开始全面将设备芯片化,例如将光开关集成到硅光芯片上,使面积和功耗降低了 10-100 倍。在传感领域,激光雷达厂商正积极推动用硅光芯片替代固态雷达设备,以缩小体积和降低成本。而在计算领域,由于对硅光芯片工艺要求更高且调制更为复杂,技术上集成了通信和传感的先进工程经验,同时也面向更广阔的的人工智能市场。

光计算芯片专为人工智能设计。从理论上讲,光计算芯片非常适合进行并行的大规模线性运算,而这正是当前所有主流人工智能算法的基础。从产业角度来看,人工智能需要依赖大规模、高性能、安全且可控的计算集群来推动生产力的提升。在这个过程中,随着算力的增长,能耗控制直接关系到集群的效率和成本。光计算芯片则提供了一种超高算力、超低能耗的计算集群发展路径。在众多的人工智能新兴领域中,光计算芯片特别适用于大型模型训练、自动驾驶以及具身智能等领域。对于大型模型的训练和推理,光计算芯片可以显著降低所需的硬件固定成本和使用成本。具体而言,其制造成本较低,并且无需采用先进的制程技术。在使用成本方面,光计算芯片具有极高的能效比,在相同算力条件下,其能耗仅为电子芯片的百分之一。因此,光计算芯片可以说是未来大型模型发展的理想核心硬件。

在自动驾驶技术从L3级向L5级演进的过程中,每辆车所需的算力将从300 TOPS激增至2000 TOPS。在现有的自动驾驶电子芯片能耗水平下,达到L5级所需的算力将会导致超过一千瓦的电力消耗,这对当前的电池技术来说是一个难以持续支持的挑战。光计算芯片提供了一种在保持高算力的同时不会产生高能耗的解决方案,从而确保新能源汽车在实现完全自动驾驶时仍能保持出色的续航能力。

为了实现与人类互动并执行多样化的任务,具身智能系统必须具备多模态处理的能力。作为具身智能的一种实体体现,智能机器人在强化学习和模型训练方面需要强大的算力支持。光计算芯片以其高速率、低延迟、高并行处理能力、低能耗以及抗干扰能力强的特点,能够为具身智能系统的技术进步和产业化应用提供重要的基础支撑。

然而,大规模光计算芯片的调控成本较高,这是因为光的波动特性需要复杂的调控机制,这也使得实现大规模的光计算芯片成为一项挑战。

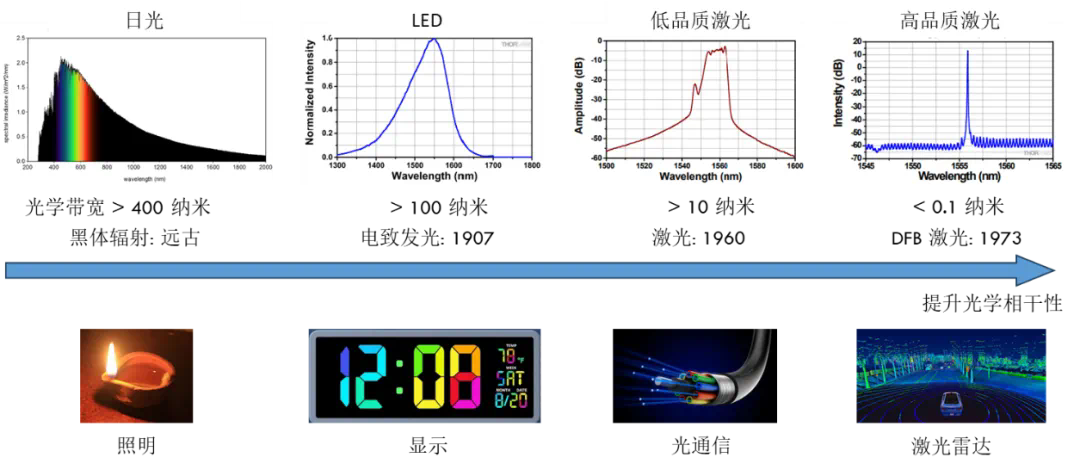

大规模光计算芯片通常需要多个激光光源,每个激光的波长和相位必须精确调控。同时,光信号处理硬件也需要具备精确调控波长和相位的能力。这类似于在水池的不同位置同时投入多块石头,并要求在特定观察点看到固定的波纹。尽管这种精确调控在理论上是可行的,但由于其复杂性和高昂的调控成本,限制了光计算芯片的大规模发展。在过去的一个世纪中,科学家们一直致力于实现光源波长和相位的精确控制,以提高光学相干性(见图1)。高相干性激光被认为是实现新型光应用的基础,包括光计算。目前展示的所有光计算系统都使用了高品质激光作为光源。

图1:高光学相干性推动新兴光应用的发展。图源:董博维。

部分相干光增强并行光计算

最近发表在《Nature》杂志上的研究打破了使用高品质相干光的传统思维,探索了降低光源相干性对光计算芯片的影响,展示了低品质光源可以提高光计算性能。牛津大学Harish Bhaskaran教授(英国皇家工程院院士)课题组的董博维博士等人,展示了使用单一光源即可运行大规模光计算芯片,无需复杂的光源及片上波长和相位调控。

研究发现,通过降低光源的品质,破坏光源的相干性,可以有效地消除光计算芯片中的相位噪声问题,避免复杂的系统相位调控,同时通过提高带宽利用率显著提升系统算力。

研究人员在存内光计算芯片和电吸收调制器阵列光计算芯片两个平台上展示了这种方法的优越性。与现有技术相比,这项新技术有望将光芯片算力提升两个数量级,并通过降低系统控制复杂度大幅减少系统能耗。

打破光源相干性,消除相位敏感性

通过降低光源相干性,使用部分相干光源,相位敏感性可以完全消除,一个窄带的部分相干光可以应对多个输入通道。这种方法解除了波长数量与输入通道数量之间的关联性。

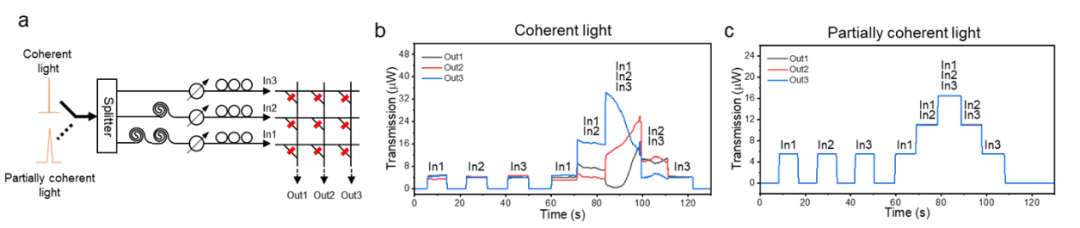

假设光计算芯片的工作带宽为 80 nm,部分相干光的线宽为 0.8 nm,在这种情况下,输入通道数可以是任意大小,并且计算并行度可以固定为 100,从而提供比传统相干光源光计算系统高 100 倍的算力。研究人员通过实验验证了这一假设。如图 2 所示,在光计算系统中,如果在多输入通道中使用单一激光,会出现明显的由干涉引起的强度扰动,影响计算结果(图 2b)。而使用单一部分相干光时,强度扰动被彻底消除,从而获得稳定的计算结果(图 2c)。

图 2: 部分相干光彻底消除干涉引起的光强扰动,使单一光源适用于任意大小的光计算芯片成为可能。图源:Nature.

更多细节,请参考原论文。