最强端侧开源AI模型Zamba2-mini正式发布:拥有12亿参数,在4位量化下内存占用不到700MB。

编辑日期:2024年08月29日

注:SOTA(state-of-the-art)并非特指某个具体模型,而是指在某一研究任务中当前最先进、性能最好的模型。

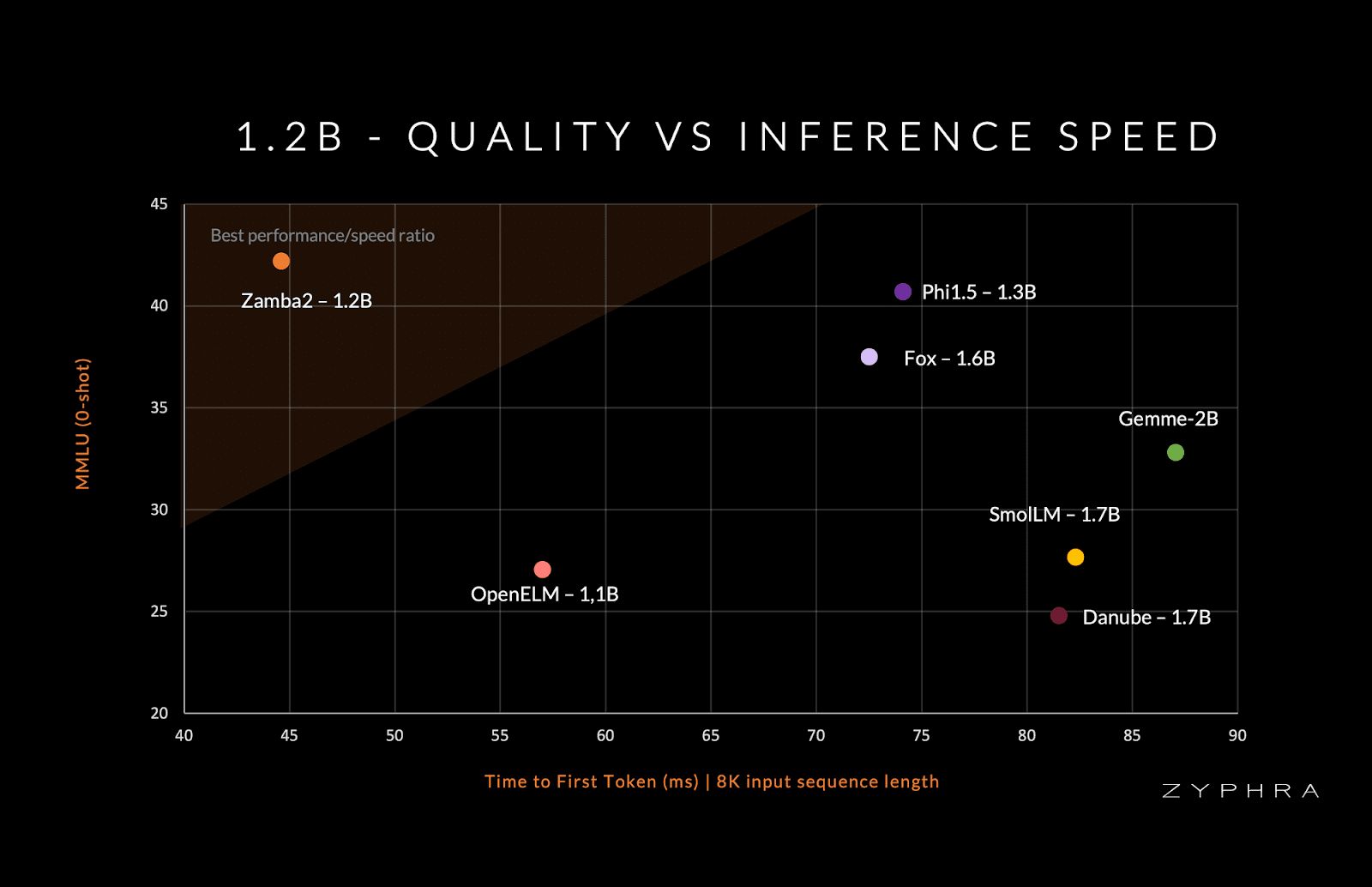

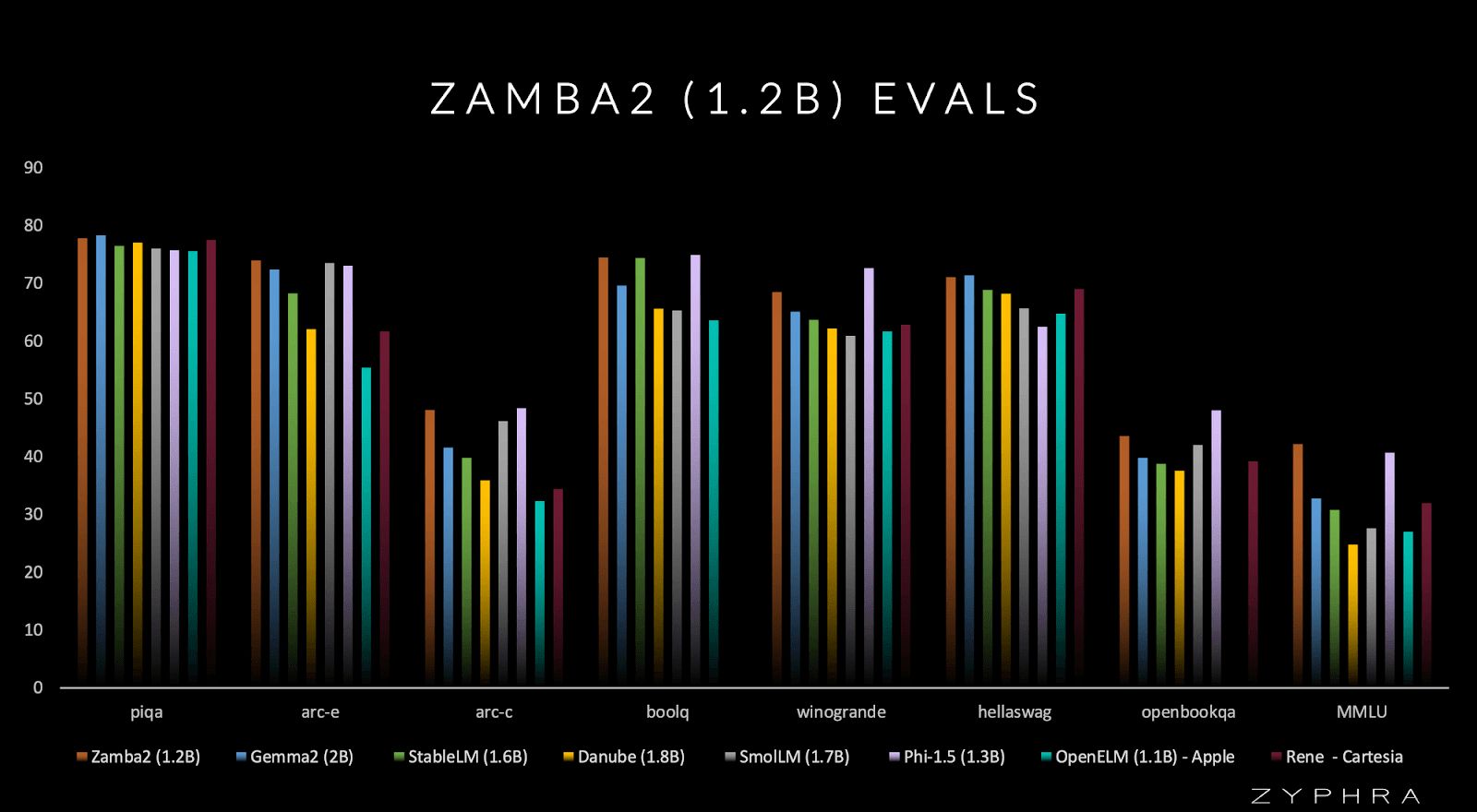

Zamba2-mini 1.2B 尺寸虽小,但其性能可与包括谷歌的 Gemma-2B、Huggingface 的 SmolLM-1.7B、苹果的 OpenELM-1.1B 以及微软的 Phi-1.5 在内的较大模型相媲美。

在推理任务中,Zamba2-mini 的出色表现尤为突出。与 Phi3-3.8B 等模型相比,Zamba2-mini 的首次令牌时间(即从输入到输出第一个 token 的延迟)缩短到了之前的一半,内存占用也减少了 27%。

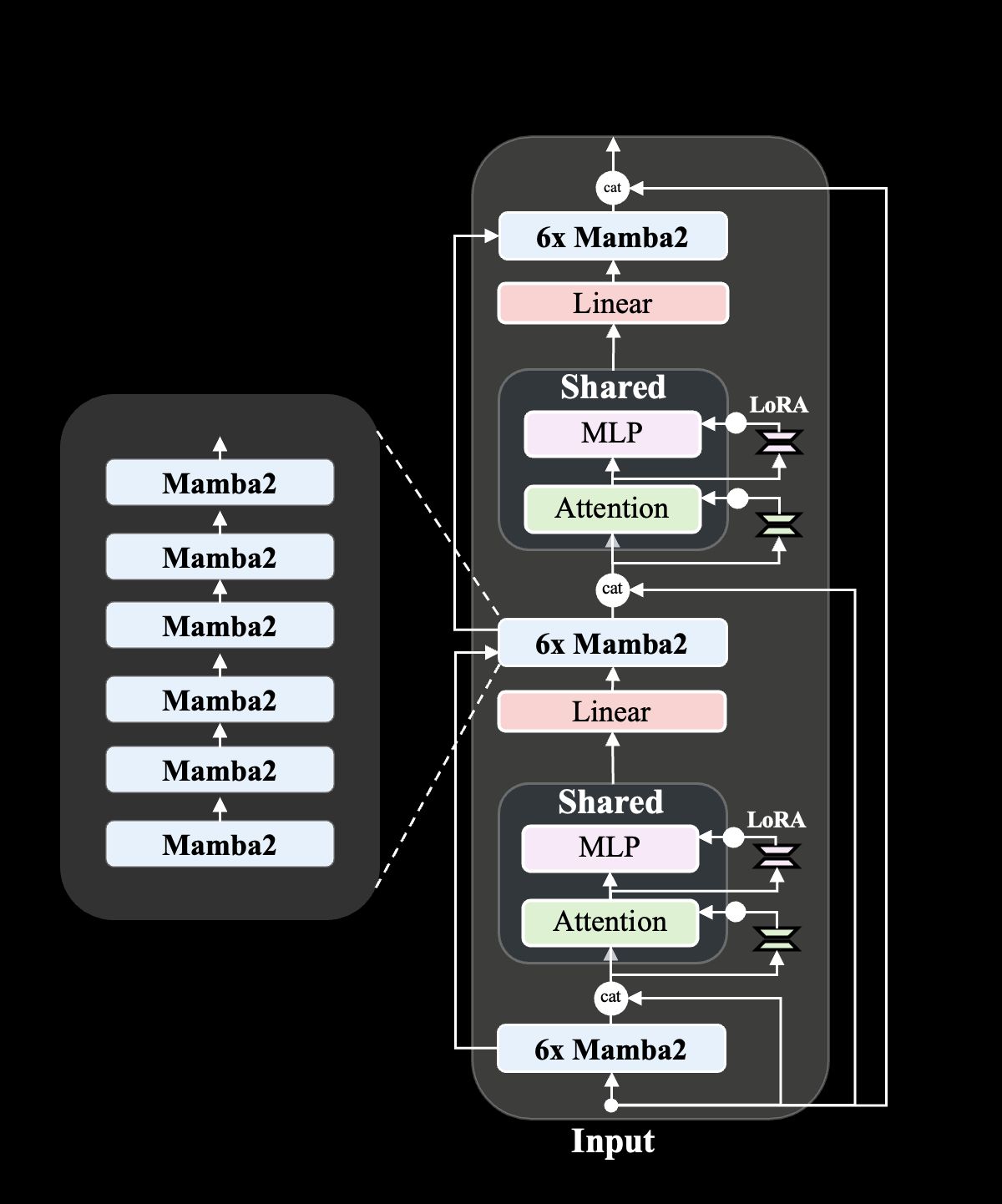

Zamba2-mini 1.2B 主要通过高度优化的架构实现,融合了不同神经网络设计的优势,不仅能够保持大型密集变压器的高质量输出,还能够以更小模型的计算和内存效率运行。

与前代Zamba1相比,Zamba2-mini的关键改进之一是集成了两个共享注意力层(attention layers)。

这种双层方法增强了模型在不同深度保持信息的能力,从而提升了整体性能。在共享注意力层中引入旋转位置嵌入也小幅提高了性能,这表明Zyphra致力于通过渐进且有影响力的方法来改进模型设计。

Zamba2-mini 是在包含三万亿个 token 的大规模数据集上进行预训练的,该数据集来源于 Zyda 以及其他公开来源。

这个庞大的数据集经过了严格的过滤和去重处理,以确保训练数据的质量达到最高标准,并在退火阶段进行了进一步优化,其中包括在1000亿个高质量的tokens上进行训练。

Zyphra 已承诺将 Zamba2-mini 作为开源模型发布,并采用 Apache 2.0 许可。

请提供参考地址。 (如果需要更准确的回答,请提供更多信息或上下文)