韩国N号房事件再现:这次是Deepfake技术,影响超过200所学校

编辑日期:2024年08月30日

这一次,网友们直呼利用这项AI技术进行的犯罪行为堪比“韩国N号房2.0”,甚至连许多未成年人也成为了受害者!

事件的影响如此巨大,直接登上了各大热门搜索和排行榜。

早在今年5月,《韩联社》就曾报道过一则消息,内容是:

仅是这位朴某便用 Deepfake 合成了大约 400 个色情视频和照片,并与同伙一起分发了 1700 个露骨的内容。

然而,这件事只是深伪技术(Deepfake)在韩国泛滥的冰山一角。

最近,更多与此相关的令人细思极恐的内幕陆续被曝光。

例如,韩国妇女人权研究所公布的一组数据显示:

而这个所谓的“N号房2.0”也是一个非常可怕的存在。

根据《阿里郎》的进一步报道:

不仅是受害者中有未成年人,甚至加害者中也有大量青少年。

不仅如此,这次舆论的形成过程也非常戏剧化。

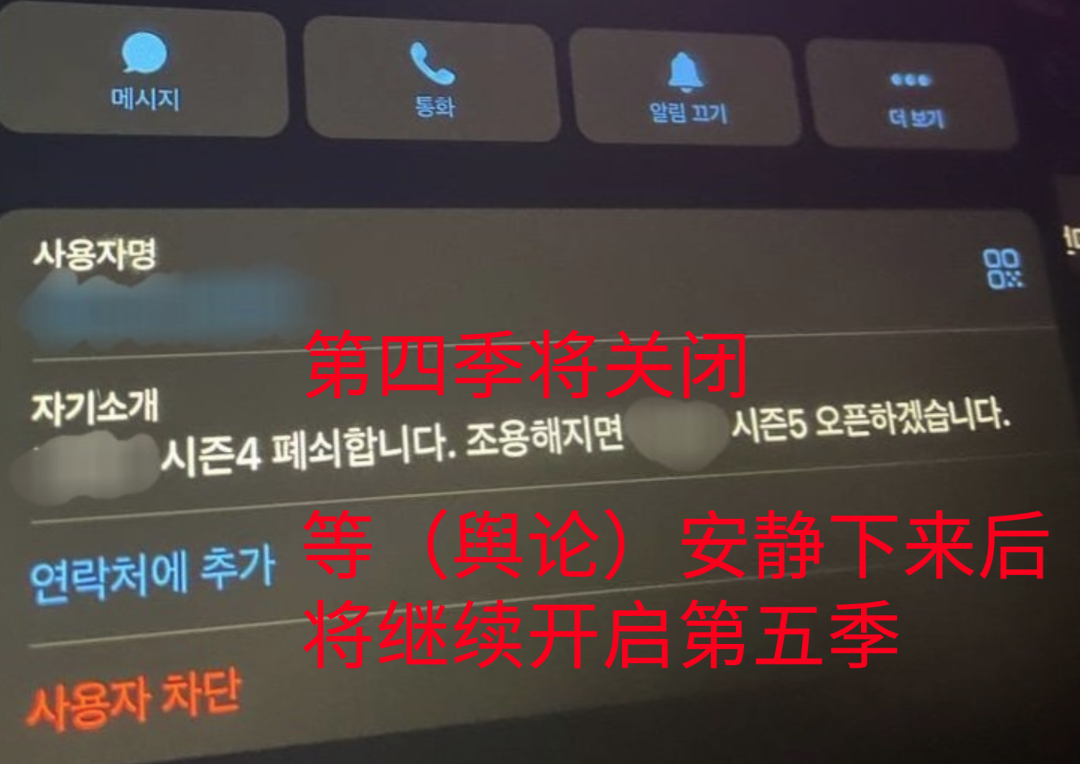

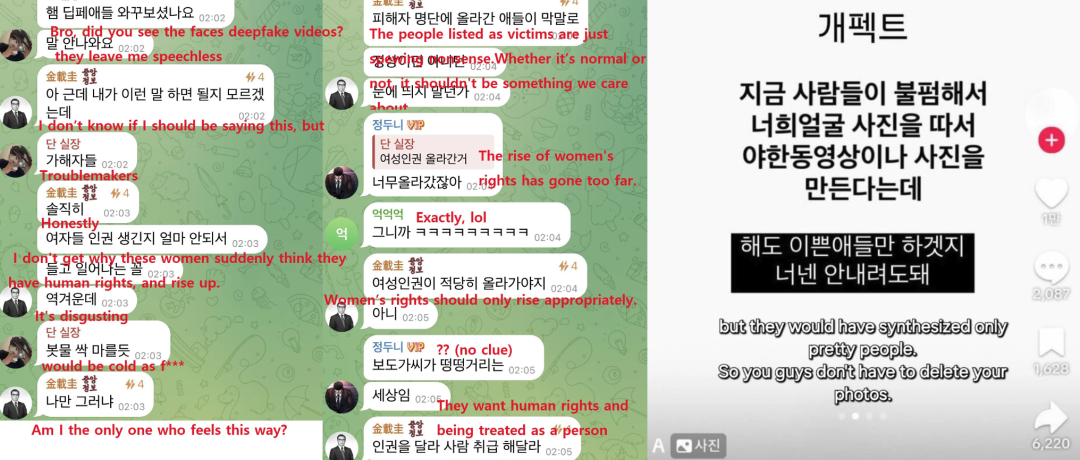

由于肇事的韩国男性(以下简称韩男)行为非常猖獗,当出现舆论苗头时,他们才会稍微“克制”一下。

一些韩国男性对这件事的态度也比较恶劣,甚至有初中男生公开写道:“不用担心,你长得不够漂亮,不会被Deepfake。”

于是,韩国女性(以下称韩女)开始进行反击。

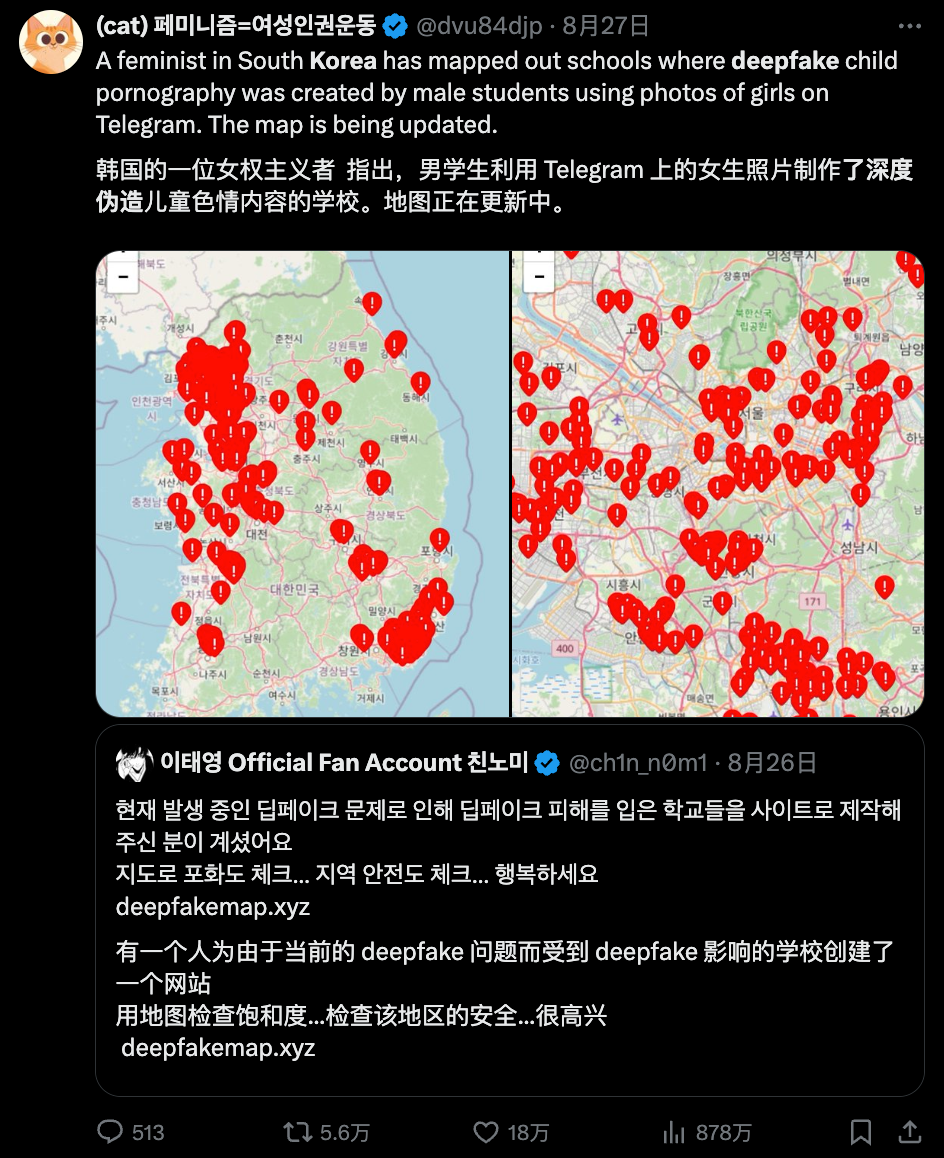

她们将“阵地”转移到韩国以外的社交媒体平台,例如在X平台上,有人发布了制作深度伪造(Deepfake)学校地图的内容。

还有韩国女性在微博上发布了“求救帖”:

随着舆论在各大社交媒体上的发酵,韩国政府也出面作出了回应:

据了解,为应对深度伪造性犯罪及其他虚假视频案件,韩国警方已经成立了特别工作组,该工作组将持续运作至明年3月31日。

实际上,最新的深度伪造(Deepfake)技术已经进化到了令人“恐惧”的阶段!

生图AI Flux 通过一组真假难辨的TED演讲照片,吸引了千万𝕏(原推特)网友在线辨真伪。(左侧为AI生成)

深夜直播的“马斯克”吸引了数万观众围观并打赏,甚至还与网友进行了连麦互动。

请注意,整场直播只需使用一张图片就能实现实时换脸。

正如网友们所说,这一切确实表明 Deepfake 技术已经将科幻变为现实。

实际上,“Deepfake”这个词最早出现在2017年,当时一位名为“Deepfakes”的Reddit用户将一些色情演员的面部替换成知名美国演员的脸,这一行为引发了巨大的争议。

这项技术可以追溯到2014年,当时Goodfellow和他的同事发表了世界上第一篇介绍GAN的科学论文。

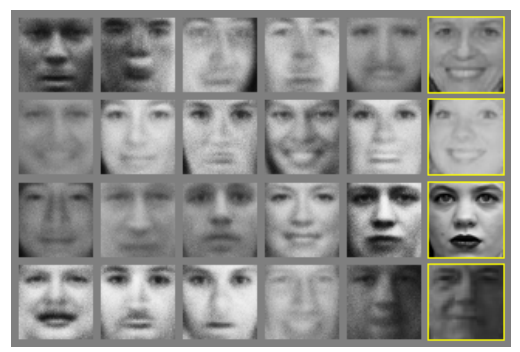

当时就有迹象显示,GAN 有可能生成极为逼真的人脸。

随着深度学习技术的发展,自动编码器、生成对抗网络等技术逐渐被应用于Deepfake中。

简单介绍一下 Deepfake 技术背后的原理。

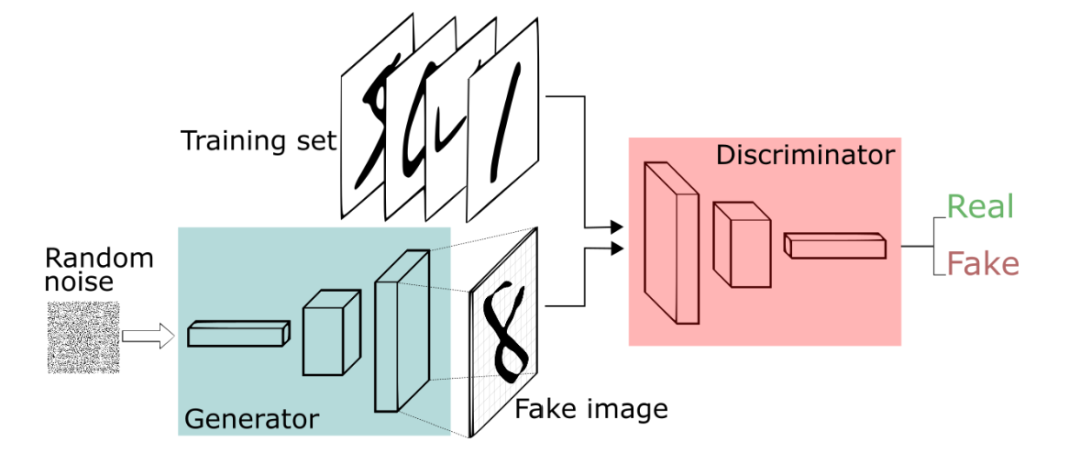

Deepfake 主要依赖于一种称为生成对抗网络(GAN,Generative Adversarial Network)的技术。这种网络由两个部分组成:生成器(Generator)和判别器(Discriminator)。生成器负责创建逼真的图像或视频,而判别器则试图区分生成的内容与真实内容。通过不断迭代训练,生成器逐渐学会生成越来越逼真的图像或视频,最终实现以假乱真的效果。

在具体应用中,Deepfake 通常涉及以下几个步骤: 1. 收集大量的目标人物的图片和视频资料。 2. 使用这些资料训练 GAN 模型,使生成器能够生成目标人物的逼真图像或视频。 3. 将生成的结果替换到另一段视频中,实现面部或动作的替换。

通过这种方式,Deepfake 可以将一个人的脸部表情、声音甚至动作转移到另一个人身上,从而产生非常逼真的伪造内容。

例如,制作一个假视频。

其核心原理是使用深度学习算法将目标对象的面部“移植”到被模仿对象上。

由于视频是由连续的图片组成的,因此只需将每一帧图片中的人脸进行替换,就能生成一个新的换脸视频。

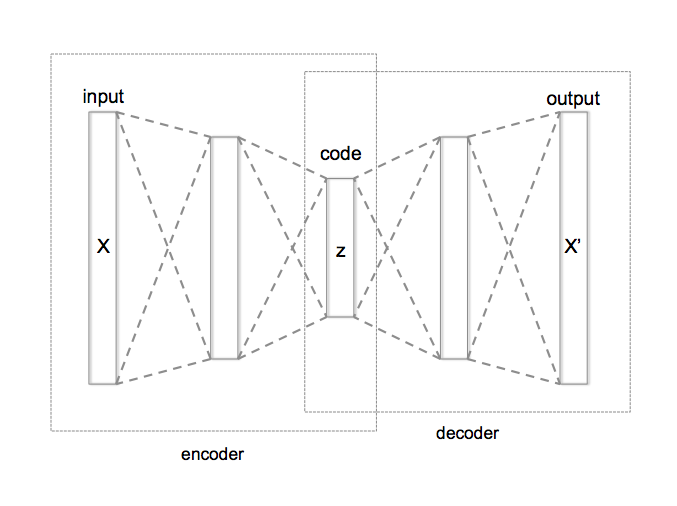

这里需要使用自动编码器,在处理 Deepfake 时,将输入的视频帧进行编码。

△ 图片来源:维基百科

它们由编码器和解码器组成,编码器将图像压缩到一个较低维度的潜空间,而解码器则从这个潜表征中重建出图像。

简单来说,编码器将一些关键特征信息(如面部特征、身体姿势)转换成低维的潜在空间表示,而解码器则将图像从这种潜在表示中还原出来,以便网络进行学习。

再比如说伪造图像。

这里主要使用生成对抗网络(GAN),这是一种非监督学习方法,通过两个神经网络相互博弈来实现学习。这种方法也可以用来制作假视频。

第一个算法被称为生成器,它接收随机噪声作为输入,并将其转换为图像。

然后,该合成图像会被添加到真实的图像序列中(比如名人的图像),这些图像随后会被输入到第二个算法(称为判别器)中。

判别器旨在识别样本是来自真实数据还是合成数据,每当发现两者之间的差异时,生成器就会进行调整,直到最终能够重现真实图像,使判别器无法分辨为止。

然而,除了在外貌上做到难以区分之外,当前的深度伪造(Deepfake)技术还在施展“组合拳”。

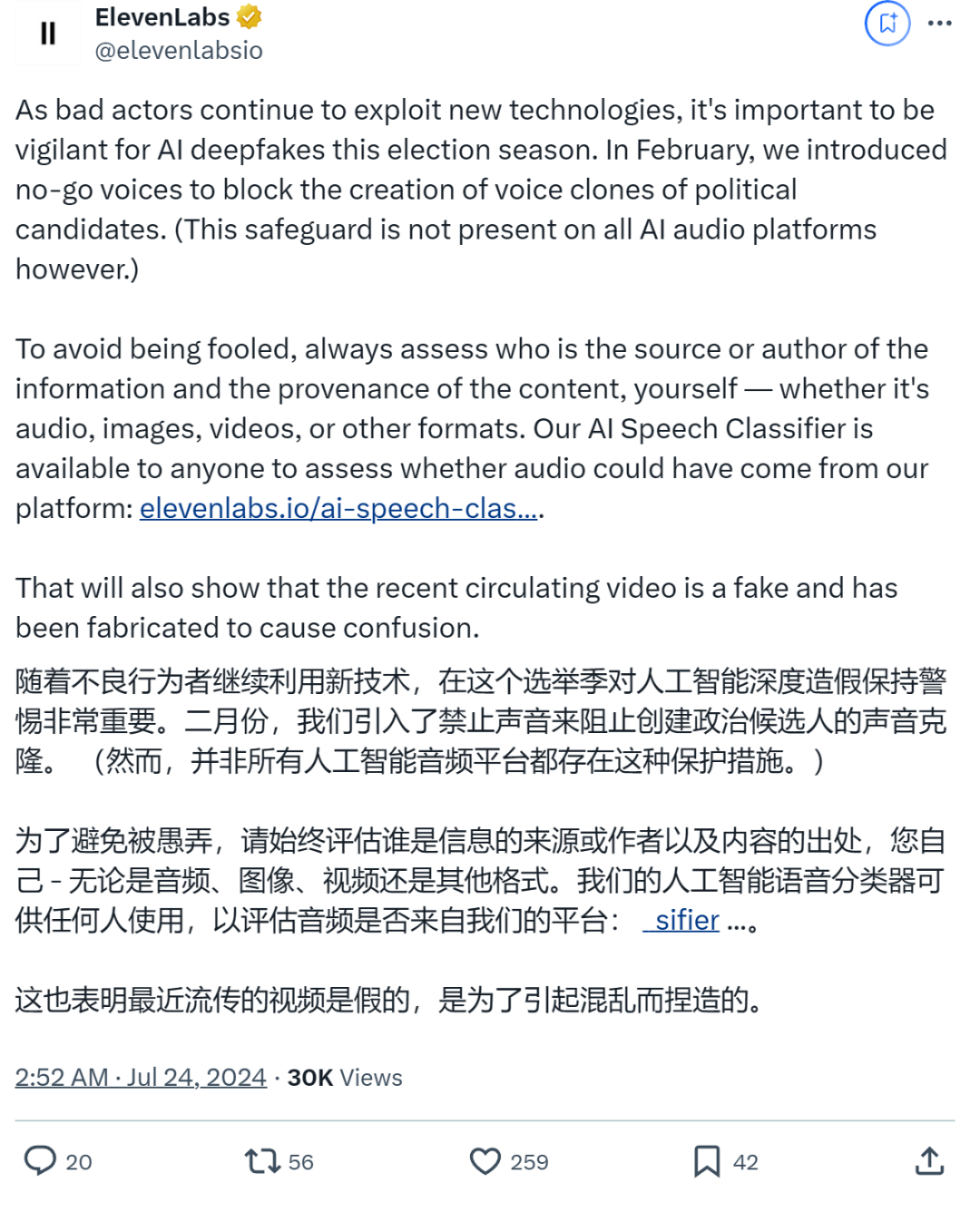

声音克隆技术也得到了升级。现在,只需找到一个AI工具,提供几秒钟的原始声音,就可以立即复制你的声音。

使用合成声音伪造名人的事件也屡见不鲜。

此外,一张图生成视频已经不再新鲜,目前的工作重点在于进一步的优化,例如使表情和姿势看起来更加自然。

其中就包括唇形同步技术(Lip syncing),比如让小李子开口说话。

尽管现在的Deepfake技术已经非常逼真,但我们仍可以掌握一些识别技巧来辨别真假。下面将为大家介绍一些这样的技巧。

目前网络上大家讨论的各种方法,总结起来就是:

嗯,列文虎克看了都直呼内行,但仅靠肉眼观察确实有点费劲了!

更高效的方法是,以魔法对抗魔法——用AI检测AI。

国内外知名科技公司均有相关举措,例如,微软开发了一种身份验证工具,能够分析图片或视频,并为其是否经过篡改提供评分。

OpenAI 之前也宣布推出一款工具,用于检测由 AI 图像生成器 DALL-E 3 创建的图像。

在内部测试中,该工具成功地在98%的情况下识别出了DALL-E 3生成的图像,并且在处理常见的修改(如压缩、裁剪和饱和度变化)时影响最小。

芯片制造商英特尔的FakeCatcher通过使用算法分析图像像素来判断真伪。

在国内,商汤的数字水印技术能够将特定信息嵌入到多种数字载体中,包括图像、视频、音频和文本等形式。官方表示,这项技术可以确保超过99%的水印提取精度,并且不会影响画质。

当然,量子位之前也介绍过一种非常流行的识别AI生成图像的方法——调整饱和度来检查人物的牙齿。

当饱和度拉满时,AI人像的牙齿会变得非常诡异,边界模糊不清。

就在昨天,Science 发表了一篇文章,对 Deepfake 进行了探讨。

注:这里“Deepfake”是一个专有名词,不需要翻译。"Science"是杂志名,也不需要翻译。此处的重写保持了原句的意思,只是稍微调整了一下句子结构。

这篇文章认为,Deepfake带来的挑战在于科学研究的完整性——科学需要信任。

具体来说,由于深度伪造(Deepfake)技术的高度逼真和难以检测的特点,进一步威胁到了对科学的信任。

面对这一挑战,《科学》杂志认为应该“两手抓”:一是制定使用深度伪造(Deepfake)技术的道德标准,二是开发精确的检测工具。

当讨论到Deepfake与教育发展的关系时,文章认为:

Deepfake未来的影响力将取决于科学和教育领域如何应对这些挑战并抓住其中的机会。

有效的错误信息检测工具、完善的伦理标准和基于研究的教育方法,可以帮助确保深度伪造(Deepfake)技术在科学领域得到增强,而非成为其发展的障碍。

总之,科技道路千条万条,安全始终是第一条。

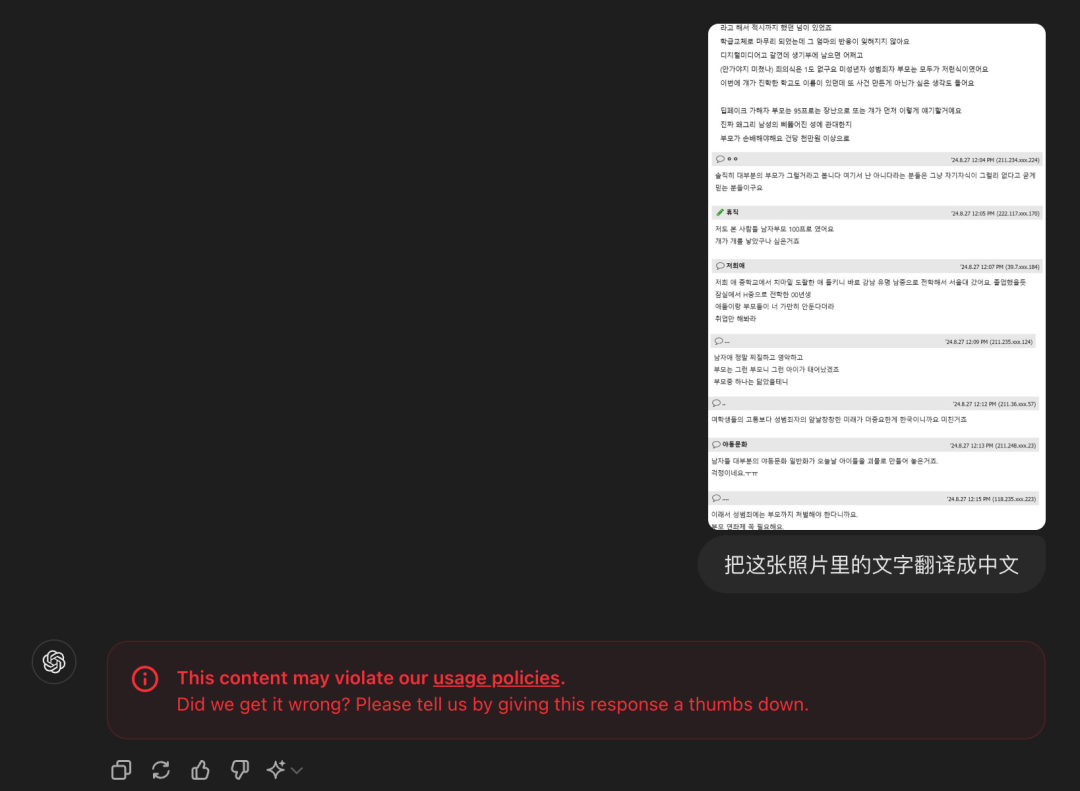

当我们让 ChatGPT 翻译相关事件的内容时,它的反应如下:

嗯,连 AI 看了都觉得不妥。

请提供需要重写的文本内容,以便我为您处理。谢谢!

本文来源于微信官方账号:量子位(ID:QbitAI),撰写者:金磊一水。

大家在看