超越GPT-4!阿里发布最强开源多模态模型Qwen2-VL,支持实时视频对话

编辑日期:2024年08月30日

还能操控手机和机械臂

全新最强开源多模态大模型登场!

阿里巴巴推出了Qwen2大模型系列中的新成员——Qwen2-VL,在图像和长视频理解任务中均取得了最佳性能(SOTA)。

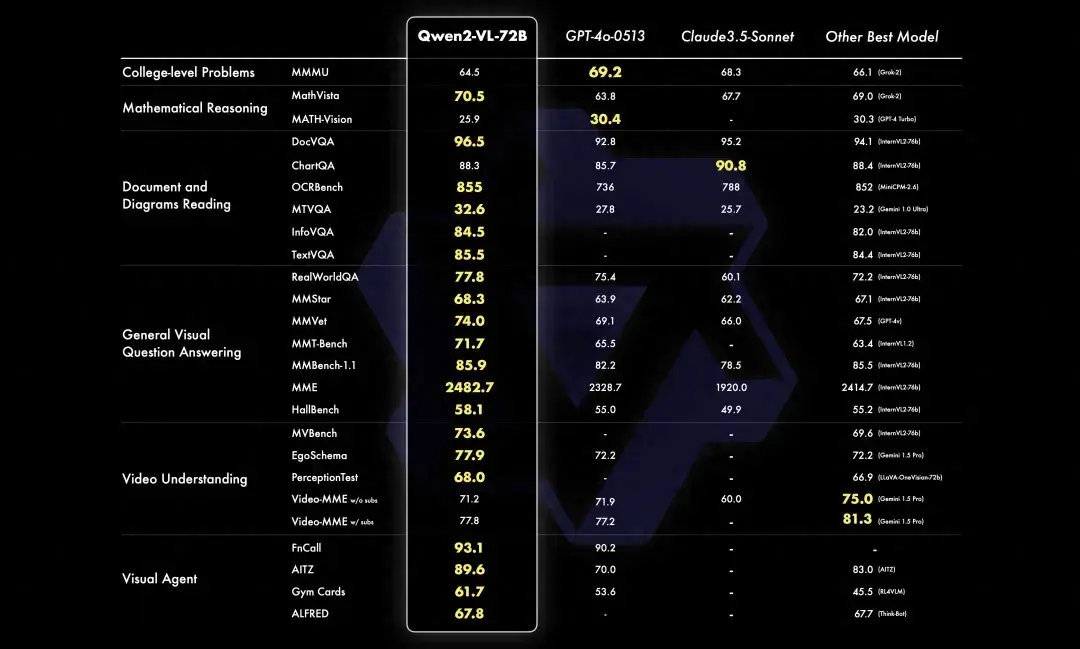

在具体子任务中,Qwen2-VL在大多数评估指标上都表现最优,甚至超过了GPT-4等闭源模型。

得益于其多模态能力,Qwen2-VL能够实时读取摄像头或电脑屏幕的内容,并以文字形式进行视频对话。

此外,它还能作为代理(Agent)与环境互动,根据任务目标自主操控手机等设备。

本次发布的Qwen2有2B、7B和72B三个版本,其中2B和7B版本现已可供下载并免费用于商业用途(Apache 2.0许可),而72B版本则通过API提供服务。

目前,开源代码已集成至Hugging Face Transformers和vLLM等第三方框架中。

许多网友纷纷呼吁一些知名的大模型推理平台如Groq和Ollama,希望它们能够尽快提供支持。

现在让我们一起来看看Qwen2-VL的精彩表现吧!

凭借其强大的多模态能力,Qwen2-VL能够控制机械臂执行物体抓取、放置等操作。

它还能成为一位扑克牌高手,根据识别到的信息和提示词描述来进行“24点”游戏,并取得胜利。

正如开头所示,Qwen2-VL可以根据屏幕上的内容,结合用户的需求,自主操作手机在网上进行信息搜索。

当然,在这些展现工具调用和代理交互能力的复杂任务背后,基础能力也同样重要。

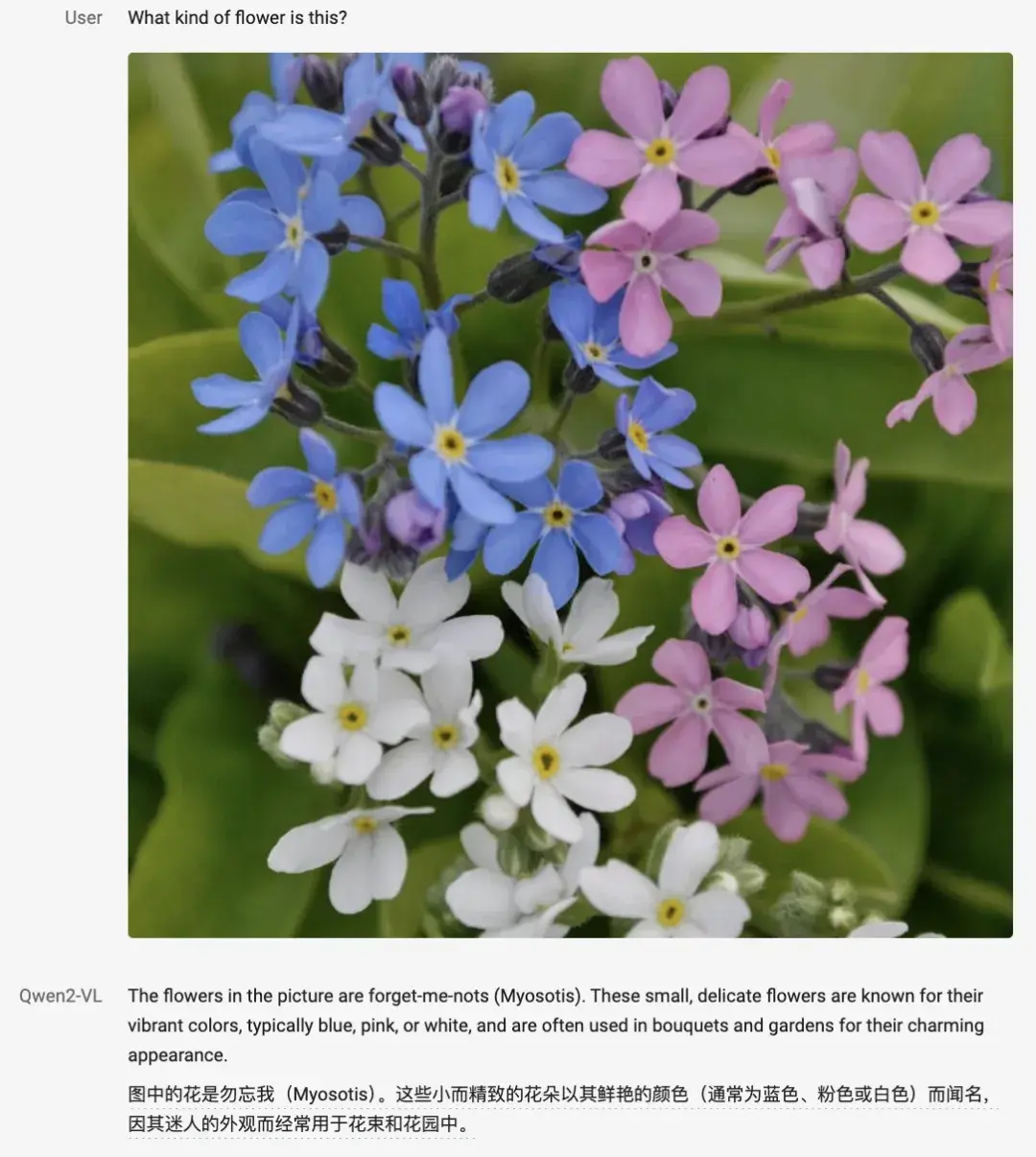

例如,在图像识别领域,Qwen2-VL能够准确识别出不同种类的花朵。如下图所示:

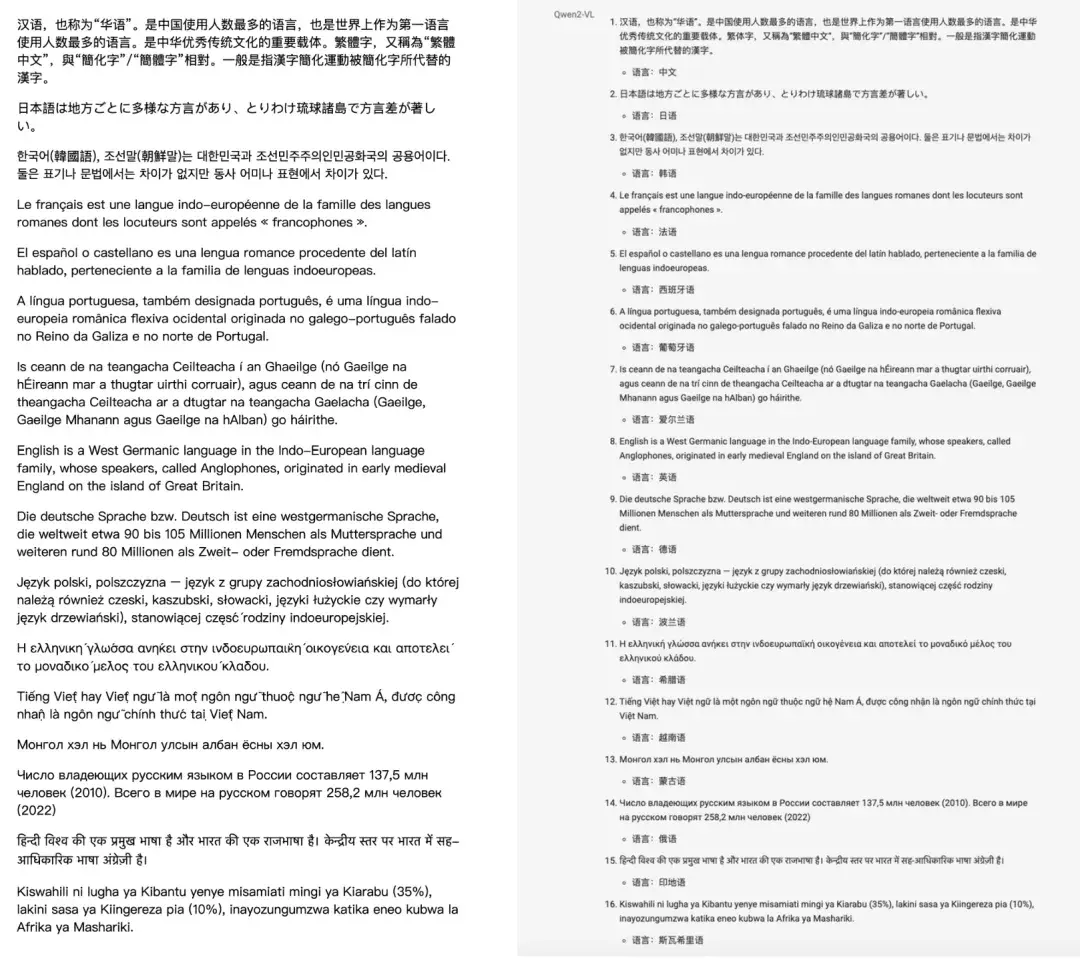

在文本识别方面,Qwen2-VL支持多种语言的文本提取。

即使将16种不同的语言混合在同一张图片中,Qwen2-VL不仅能够辨别每种语言,还能一次性提取所有文本内容。

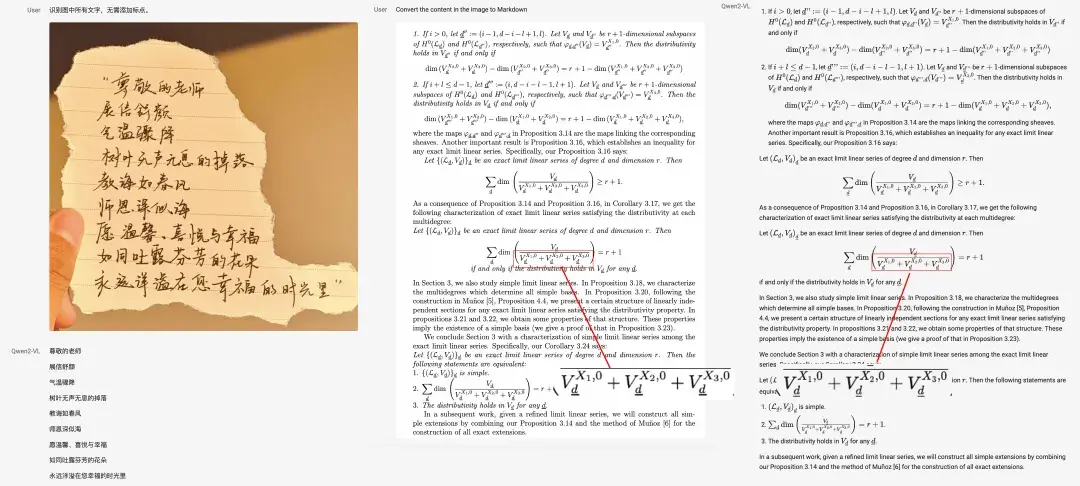

此外,它还可以识别手写字体和复杂的数学公式,并且能够精确处理上下标等细微之处。

Qwen2-VL还具备多模态推理能力,可以解决代码和数学(包括几何)类问题,只需上传一张图片即可。

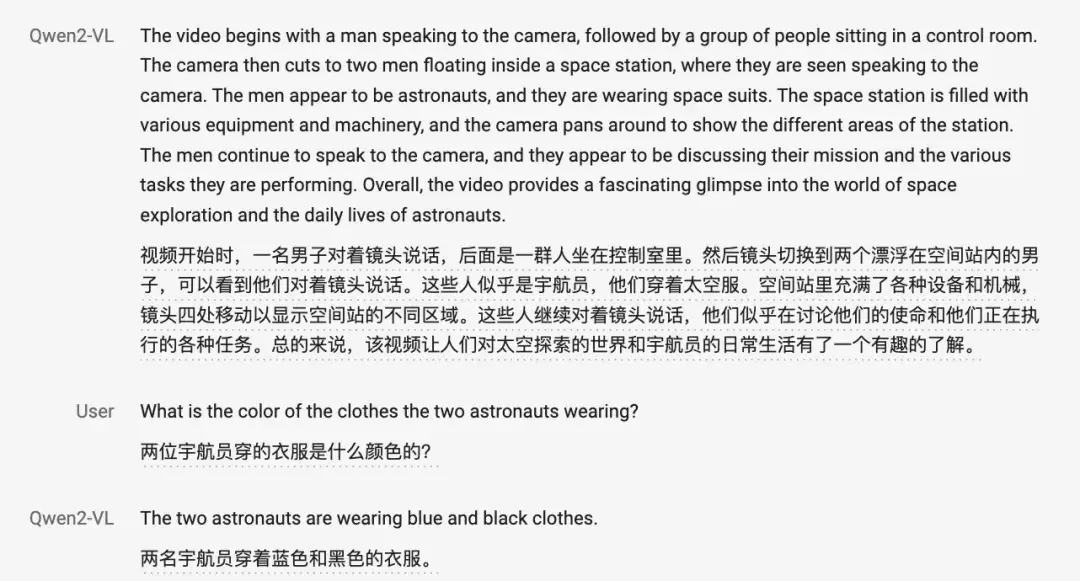

在视频处理方面,Qwen2-VL可以分析长达20分钟以上的视频内容,既能进行总结,也能回答关于细节的问题。

不过,目前它仅能分析视频画面,尚不支持音频处理。

同时,Qwen2-VL还支持实时视频文字对话,不仅可以基于摄像头进行互动,还能读取电脑屏幕上的内容作为对话的基础。

总而言之,这些任务背后体现了Qwen2-VL卓越的综合能力。

为了全面评估Qwen2-VL在各类任务中的表现,千问团队从六个方面对其视觉能力进行了测试,具体包括:

- 综合类大学试题

- 数学试题

- 文档表格理解

- 通用场景下的问答

- 视频理解

- Agent能力

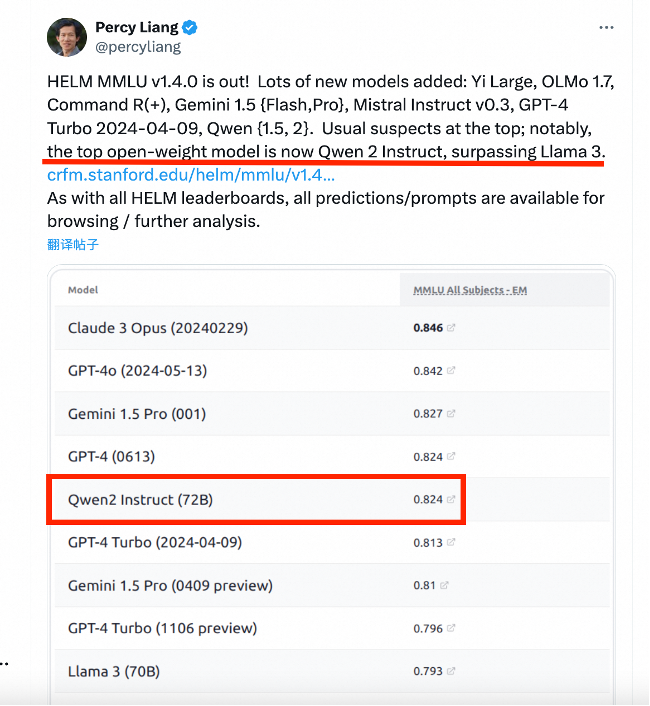

总体而言,Qwen2-72B在大多数指标上均表现优异,甚至超越了GPT-4和Claude3.5-Sonnet,尤其在文档理解方面表现出显著优势。

此外,在多语言测试中,MTVQA在9种语言中的8种上全面超越了GPT-4、Claude3-Opus和Gemini Ultra等先进的闭源模型,平均成绩也名列前茅。

7B版本同样支持图像、多图及视频输入,并达到了同等规模模型中的最先进水平。

最小的2B版本专为移动端设计,尽管体积小巧,但仍具备完整的图像和视频多语言理解能力,并在视频文档和通用场景问答方面相比同类模型具有明显优势。

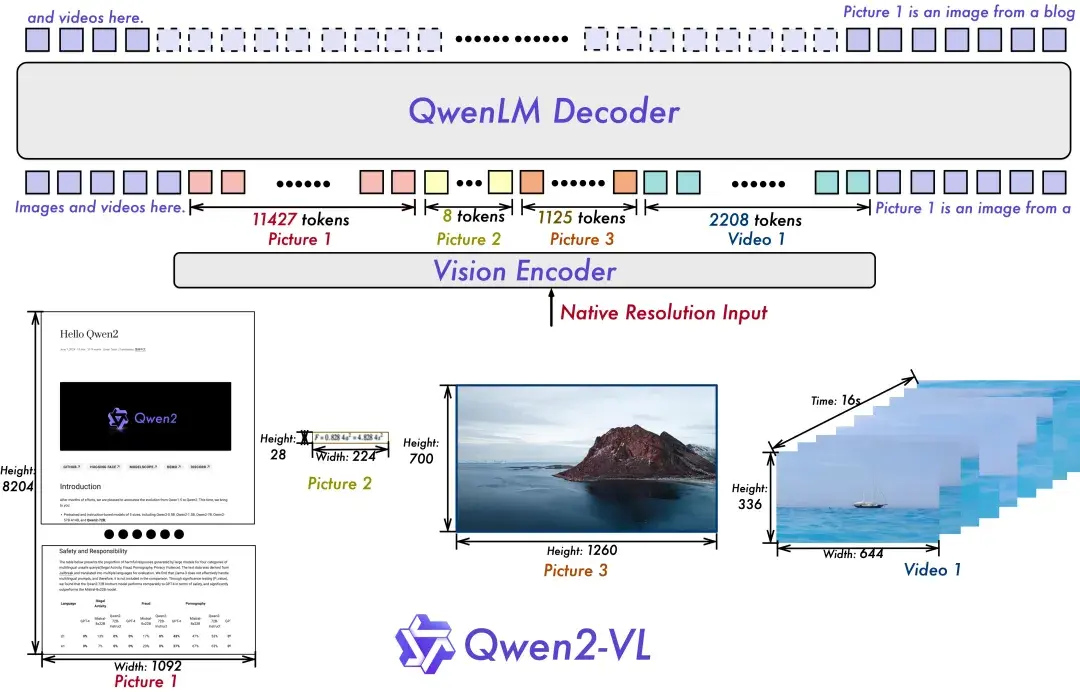

总体来说,Qwen2-VL继承了前代Qwen-VL中ViT加Qwen(2)的串联结构,在三种不同规模的模型上,Qwen2-VL均采用了600M规模的ViT,并支持图像和视频统一输入。

为了使模型更好地感知视觉信息并理解视频,Qwen2-VL新增了对原生动态分辨率的全面支持,可以处理任意分辨率的图像输入,不同大小的图片将被转换为动态数量的tokens,最少只需4个。

这种设计不仅确保了模型输入与图像原始信息之间的一致性,还模拟了人类视觉感知的自然方式,使模型在图像处理任务中更加灵活高效。

Qwen2-VL在架构上的另一项创新是引入了多模态旋转位置嵌入(M-ROPE)。传统旋转位置嵌入只能捕捉一维序列的位置信息,而M-ROPE通过将原始旋转嵌入分解成代表时间、高度和宽度的三个部分,使得大规模语言模型能够同时捕捉和整合一维文本序列、二维视觉图像以及三维视频的位置信息。这一创新有助于增强模型的多模态处理和推理能力,使其更好地理解和建模复杂的多模态数据。

DEMO:https://huggingface.co/spaces/Qwen/Qwen2-VL

项目主页:https://qwenlm.github.io/blog/qwen2-vl/

GitHub:https://github.com/QwenLM/Qwen2-VL

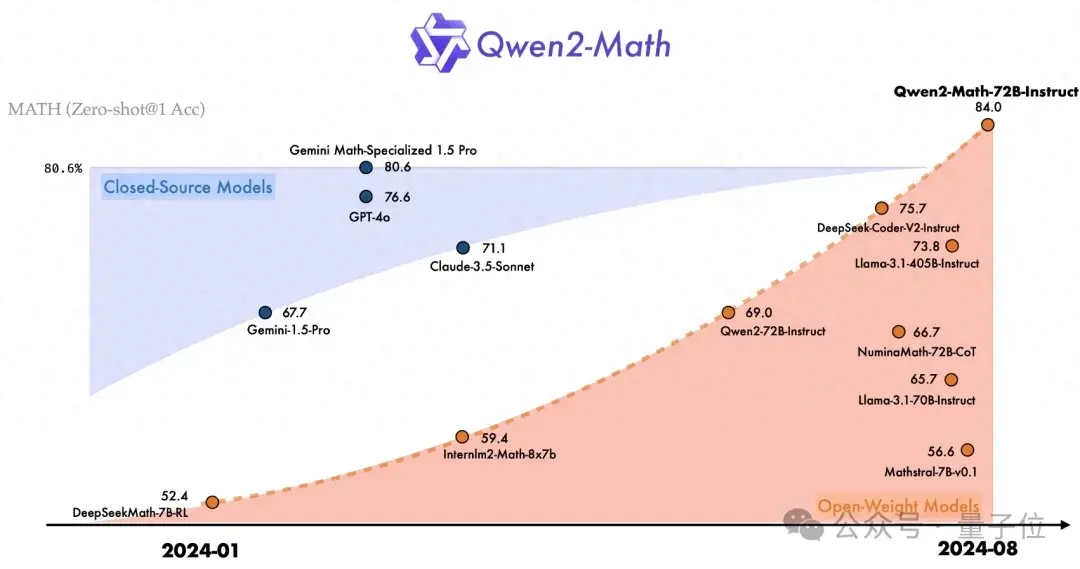

可解决简单竞赛级题目

性能超越Llama3-70B模型

仅靠提示词即可实现

超越GPT-4!阿里发布最强开源多模态模型

《多模态大语言模型综述》

行业落地“最后一公里”的问题仍然存在

理解侧与生成侧融合

大家在看