惊人突破!DeepMind的AI实现实时游戏生成,达到每秒20帧的输出,其扩散模型一夜之间引发热烈关注。

编辑日期:2024年08月30日

玩转《DOOM》

“比Sora更震撼”,AI实时生成游戏成为可能!

谷歌DeepMind推出了一款全新的全AI驱动实时游戏引擎——GameNGen。

借助单个谷歌TPU,这款引擎能够以每秒20帧的速度模拟经典射击游戏《DOOM》(毁灭战士)。

所有游戏画面都是根据玩家的操作和复杂的环境实时生成的。

这意味着,在你走进一扇门前,门后面的内容并不存在。

游戏画面的质量不亚于预先存储的画面,几乎可以以假乱真,人类评估者难以分辨。

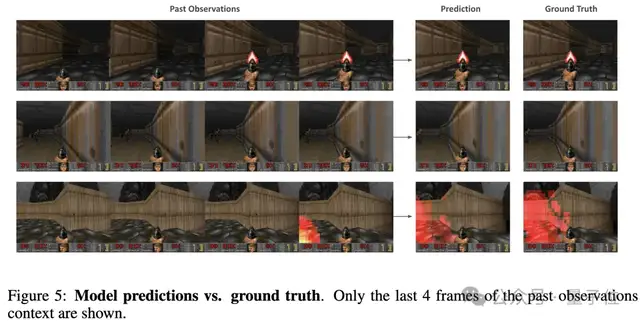

各种操作都能流畅转换:

GameNGen背后的核心技术是大家熟知的扩散模型。论文标题也重新定义了游戏引擎:扩散模型是实时游戏引擎。

这一研究成果在网上引发了热议,推特和Reddit上的相关帖子热度持续上升,转发量激增。

许多人认为这项技术开启了一条全新的路径,我觉得大家还没完全意识到这有多么颠覆性。作为一名专注于将生成式AI集成到游戏引擎中的开发者,我对这一点深有体会。

这是构建虚拟世界的基石。未来,这项技术或许能普及到所有能获取数据的视频游戏中,甚至有可能为尚未问世的游戏生成数据,创造出全新的游戏体验。

作者Shlomi Fruchter也表达了类似的观点:

这对我来说是一个个人里程碑,标志着从手动编写在GPU上运行的显式渲染代码到训练同样在GPU上运行的神经网络的完整循环,感觉非常圆满。

那么,GameNGen究竟是如何实现这一切的呢?

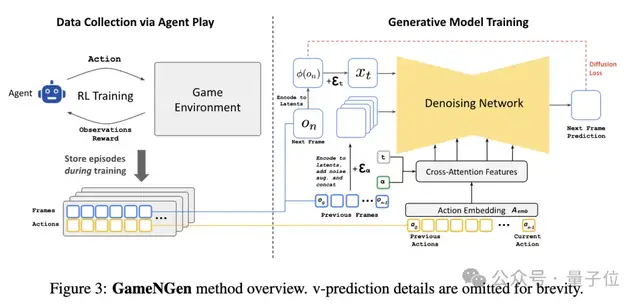

GameNGen的训练过程分为两个主要阶段。

首先,训练一个强化学习代理(Agent)来玩游戏,并记录其所有的动作、技能和观察数据。这些记录将成为第二阶段的训练数据集。

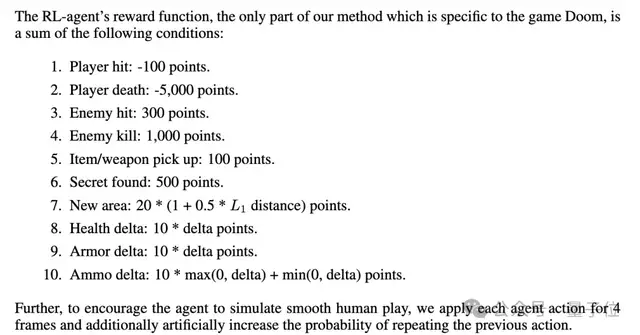

为了生成尽可能接近人类游戏行为的训练数据,研究人员设计了一个简单的环境特定奖励函数,根据一系列特定的游戏情境来分配分数。这些条件包括:

- 玩家被击中

- 敌人被消灭

- 捡起物品或武器

- 生命值变化

- 弹药变化

在第二阶段,基于预训练的Stable Diffusion v1.4来预测下一帧。模型以过去的帧序列和动作作为条件输入,并进行了一些关键修改。

具体来说,首先移除了所有文本条件,替换为动作序列。每个动作被编码为一个单一的token,并通过交叉注意力机制与模型进行交互。

历史观测(即之前的帧)被编码到潜在空间,并与当前噪声化的潜在表示在通道维度上进行拼接。

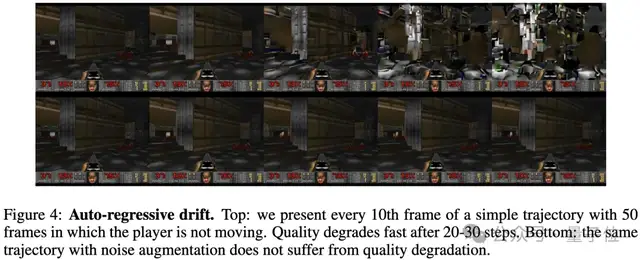

为了解决自回归生成过程中出现的误差累积问题,即自回归漂移现象,GameNGen引入了噪声增强技术。

在训练过程中,模型会对输入的历史帧添加不同程度的高斯噪声,并将噪声等级作为额外输入提供给模型。这种方法使模型能够学习如何纠正先前采样中的错误,这对于保持长时间序列中的图像质量至关重要。

此外,为了提升图像质量,特别是在细节和HUD(平视显示器)方面,研究者对Stable Diffusion的预训练自编码器的解码器部分进行了微调。这一过程利用MSE损失来优化目标帧的像素。

在推理阶段,GameNGen采用DDIM采样方法,并使用了无分类器引导技术,但仅限于对过去观测的条件。研究者发现,对过去动作条件使用引导技术并未能显著提高图像质量。

值得注意的是,模型仅需4步DDIM采样即可生成高质量结果,这大大提升了生成速度。

GameNGen在TPU-v5硬件上运行,每个去噪步骤和自编码器评估分别需要10毫秒。

通过使用4步采样和一次自编码器评估,系统可以实现每秒20帧的生成速度,足以支持实时互动游戏体验。

实验表明,在较短的时间轨迹上,人类评估者几乎无法区分模拟画面与真实游戏画面。

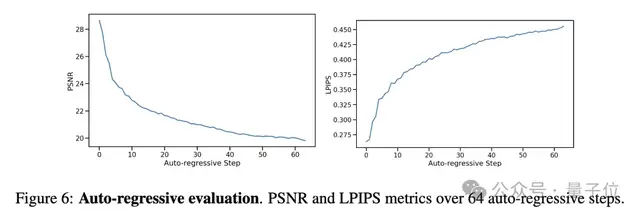

研究人员使用了两种主要的图像质量评估方法:基于感知的图像相似度度量方法LPIPS和常用的图像质量指标PSNR。

在teacher-forcing设置下,模型单帧预测的PSNR值为29.43,LPIPS值为0.249。这些PSNR值与20-30质量设置下的有损JPEG压缩相似。

换句话说,GameNGen 在模拟图像时能够保持较高的视觉质量,尽管可能会出现一些因压缩而导致的细节损失。

在视频质量方面,对于长度为16帧(0.8秒)和32帧(1.6秒)的模拟,FVD 分别为114.02和186.23。

在人类评估方面,研究人员向10名评估者展示了130个随机短片段(1.6秒和3.2秒),并将模拟结果与真实游戏画面并排展示。

结果显示,在1.6秒和3.2秒的片段中,人类只有58%和60%的概率能够正确区分真实游戏和模拟。

除了对效果感到惊艳外,许多研究者还认为这项研究并不简单,它是基于扩散模型的最新突破。

动作条件化的世界模型取得了进一步的发展!神经网络模拟在扩展实际交互数据方面具有巨大的潜力,尤其是在物理模拟器表现不佳的领域。

然而,在一片赞誉声中,也有网友指出,虽然论文非常好,但称之为“游戏引擎”可能不太准确:

希望他们能说“渲染引擎”而不是“游戏引擎”。游戏引擎是一个供团队创作的工具,并且会长期存在,尤其是与任何集成的超级AI共存。显然,今天的游戏引擎已经过时,但我们已经在开发下一代引擎了。

对于一些人评论称这些模型将取代传统游戏引擎,也有网友持有不同意见。

一位来自a16z的投资人,同时也是前Unity员工,在游戏和3D技术领域发表了他的看法:

讽刺的是,训练这些模型所需的控制器动作和输出帧数据实际上来源于传统游戏引擎。

尽管我认为这些由扩散模型实时生成的画面最终将改变我们的游戏体验方式,但我仍然认为专业开发者需要一个3D场景图来实现触觉控制和创意表达。

开发者可能会使用更传统的3D创作引擎来创建游戏的“灰盒”版本,然后通过一个图像到图像的模型实时提升其分辨率(类似于英伟达的DLSS技术)。

未来,消费者将能够体验到从文本直接创造游戏或虚拟世界的全新方式。但在我的看来,专业工作流程中仍然会有3D场景图的一席之地。

你如何看待GameNGen这项研究?它会给未来游戏行业带来何种变革?

项目主页:https://gamengen.github.io/ 论文链接:https://arxiv.org/pdf/2408.14837

参考链接: [1] https://www.reddit.com/r/singularity/comments/1f3055r/google_deepmind_we_present_gamengen_the_first/ [2] https://x.com/_akhaliq/status/1828631472632172911 [3] https://x.com/imxiaohu/status/1828732438056755383

惊人突破!DeepMind 的 AI 实现实时处理

业内首次证据证明

“OpenAI 又 Open 了”

又是扩散模型

掀起这波 AIGC 热潮

23 页 PDF 涵盖 200 页文献

作者曾是 Spotify “猜你喜欢” 模型的开发者之一

大家在看