警惕AI对你“洗脑”:MIT最新研究显示大型模型成功植入人类错误记忆

编辑日期:2024年09月07日

麻省理工学院(MIT)的最新研究模拟了犯罪目击者访谈,结果显示,大型模型能够有效地诱导“目击者”产生虚假记忆,而且其效果明显优于其他方法。

网友辛辣评论:

还有网友表示:

而马库斯的观点依然保持着一贯的悲观:

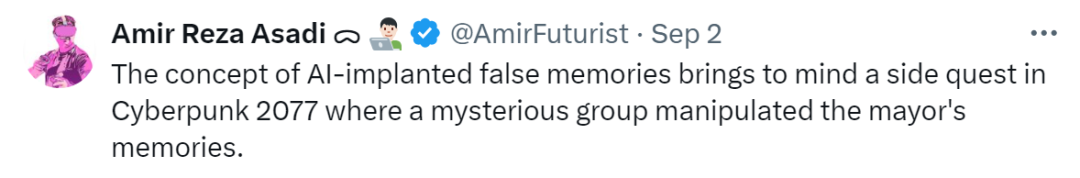

为了研究大型模型对人类记忆的影响,研究团队招募了200名志愿者,并将他们平均分为4组:

规定每组人员在观看视频后都需要回答25个问题(其中包含5个具有误导性质的问题),以此来评估他们形成正确记忆和虚假记忆的情况。

一周后,再次让这些志愿者回答相同的问题,并将两次的调查结果进行对比。

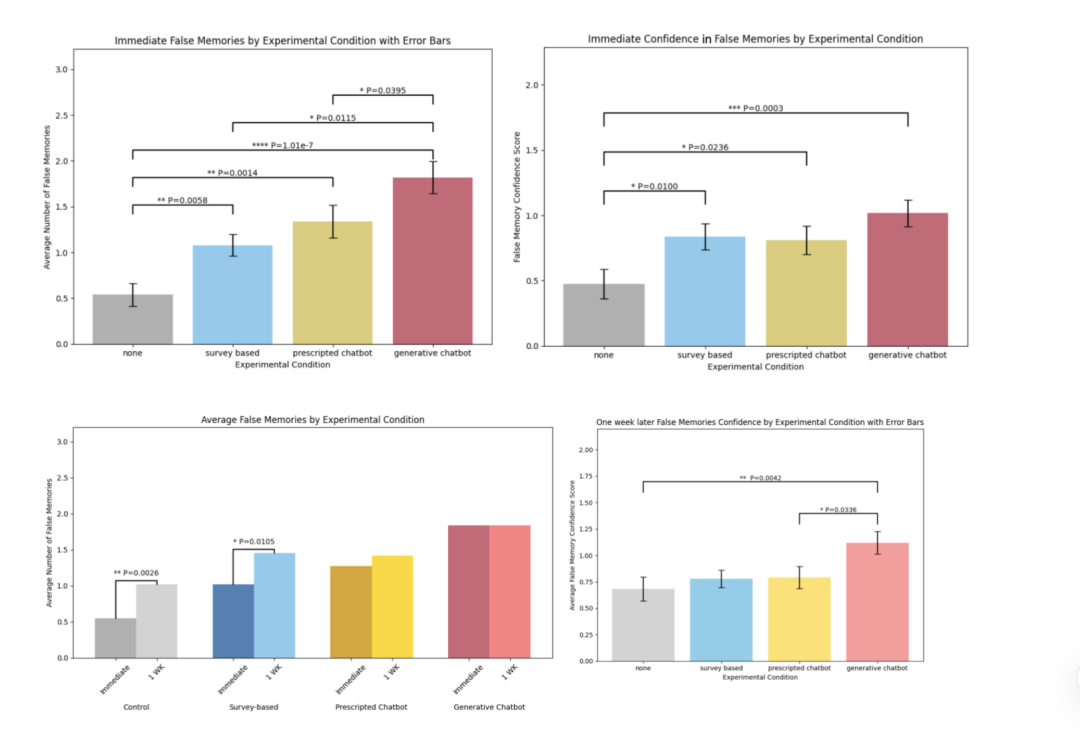

最终的对比数据显示,AI警察组的方法比其他组的方法更有效。

这一切都是因为它能够根据志愿者的回答提供即时反馈和正面强化。这种互动方式使得志愿者更易于接受错误信息,从而增强虚假记忆的形成。

例如,当志愿者错误地回答问题时,AI警察可能会确认这些错误的细节并给予正面反馈,从而进一步巩固这些错误记忆。

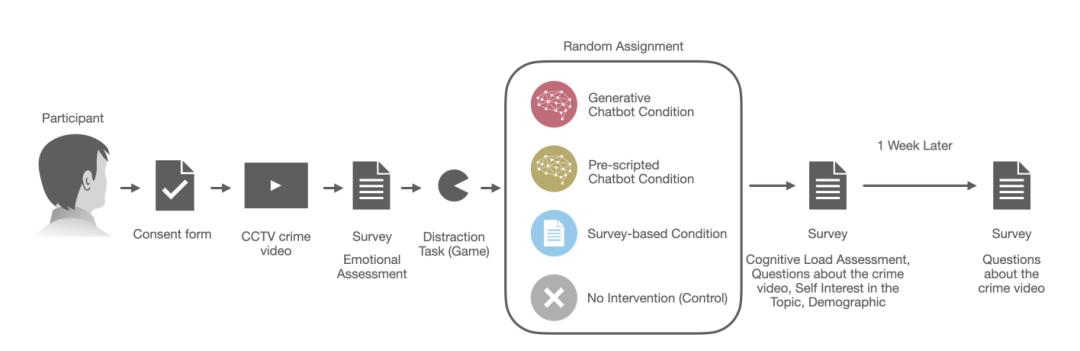

此外,AI警察还会设计具有误导性的提问,引导志愿者回忆错误的细节。

例如,AI警察可能会问“抢劫者是不是开车到商店的”,但实际上抢劫者是步行到达的。这种误导性的问题直接影响了志愿者的记忆重构过程。

在实验中,大型模型成功地“训练”了人类。

实验结果表明:AI警察组引发的虚假记忆大约是对照组的3倍,并且分别比调查问卷组和预设聊天机器人组高出了1.7倍和1.4倍。

不仅如此,AI警察与志愿者的所有互动还增强了他们对虚假记忆的信心,这一信心水平是对照组的两倍。

即使过了一周的时间,那些与AI警察交谈过的志愿者仍然对这些虚假记忆记忆犹新,说明植入的记忆具有很强的持久性。

研究人员还发现,在实验中,那些对大型模型不太熟悉但对AI技术有一定了解的志愿者,以及对犯罪调查感兴趣的志愿者,更容易受到虚假记忆的影响,这表明个体差异在虚假记忆形成过程中起着重要作用。

他们还强调,人的记忆不是一个简单的回放过程,而是一个建构过程,很容易受到外部信息的影响。

大模型通过引入错误信息,利用这一特点改变用户的记忆,植入新的记忆,从而使用户相信虚假的细节。

本文来自微信公众号“量子位”(ID:QbitAI),作者:叨乐,原标题为《当心 AI 给你“洗脑”!MIT 最新研究:大模型成功植入人类错误记忆,马库斯:太可怕》