机器人也能系鞋带了!斯坦福团队为机器人增添新技能丨代码已开源

编辑日期:2024年09月11日

网友:这小手真灵巧

斯坦福大学年初刚教会机器人炒菜,现在又开始教机器人系鞋带了!

他们还发布了全球首个机器人自主系鞋带的演示视频。

与之前的炒菜版本1.0相比,这个新版本能够完成更为精细和复杂的工作。

网友们在评论区纷纷点赞:

评论一:这小手真灵巧,它系鞋带的技术比我强多了!

评论二:OMG!真是个好东西!希望能大量生产!

评论三:太可爱了!它竟然还会打蝴蝶结!

除了系鞋带,视频中的Aloha 2机器人还能挂衣服、拧齿轮、整理厨房,甚至能为“同事”更换不同用途的配件。

我们一起来看看它的表现吧。

首先是挂衣服。在演示视频中,Aloha 2先是将衣物整理好,然后顺利地将其套在衣架上(它甚至懂得轻轻按一下以防止衣物滑落)。

即使是数据库里没有的衣服类型,它也能处理。

在拧齿轮的测试中,它同样表现出色。成功地将三个塑料齿轮插入一个带有摩擦力的插座,完美咬合。

“整理厨房”环节:Aloha 2将桌面散落的餐具整齐归位。

当需要为“同事”更换配件时,它也是一气呵成。先取下旧的配件,再拿起新的配件对准位置安装上去!

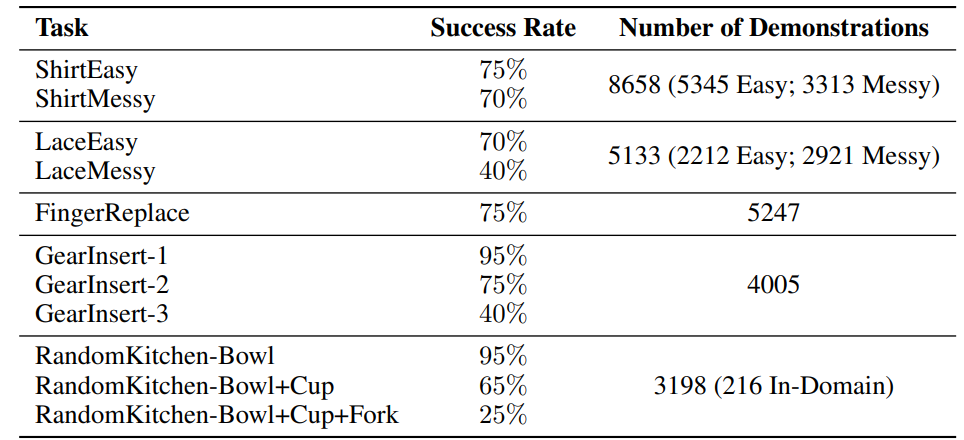

为了训练Aloha 2机器人,研究团队采用扩散策略进行了大规模训练,在五个任务中共收集了2.6万个示范数据。

值得一提的是,他们的训练仅基于模仿学习的方法,并未涉及强化学习。

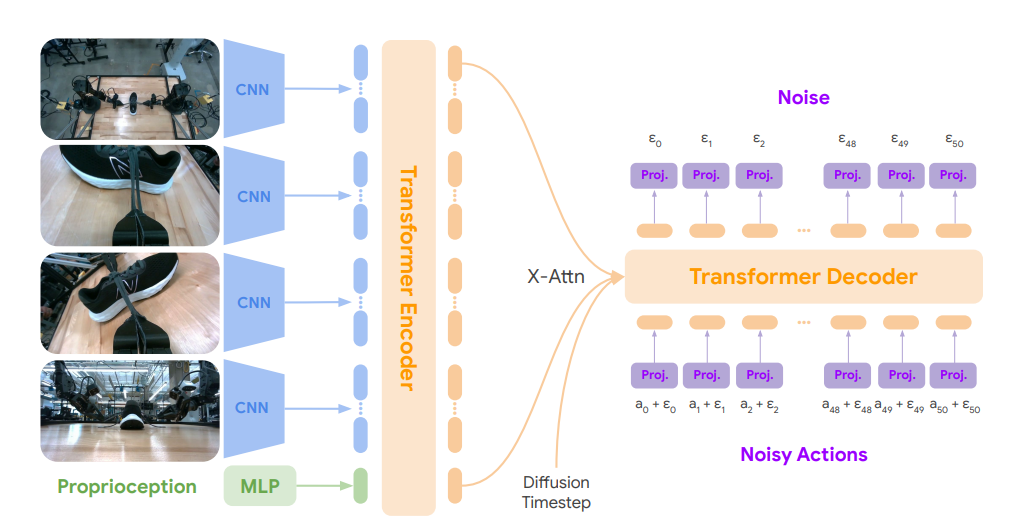

Aloha 2机器人的神经网络架构参考了ACT模型,没有使用条件VAE编码器(变分自动编码器)。

他们是这样操作的:研究人员在输入中加入位置嵌入后,将其送入一个拥有8500万个参数的Transformer编码器。随后,通过双向注意力机制进行解码,生成观察结果的潜在嵌入。

这些潜在嵌入随后传递给另一个包含5500万个参数且具备双向注意力机制的Transformer编码器。

解码器接收的是一个50×14的张量,即带有位置信息的动作噪声块。这些嵌入与来自观察编码器的潜在嵌入及时间步(以独热向量形式表示)进行交叉注意力处理。

最终,解码器输出一个50×512的向量,然后通过一个线性层映射到50×14的尺寸,这代表了对接下来50个动作的预测噪声。

基础模型总共包含了2.17亿个可学习参数。而在较小规模的模型中,研究人员使用了拥有1700万个参数的编码器和3700万个参数的解码器,总计约1.5亿个参数。

在训练过程中,研究人员基于JAX框架,在64个TPUv5e上并行训练,每批次大小为256,并进行了总计200万次迭代。

此外,他们使用了带权重衰减(0.001)的Adam优化器,并在线性学习率预热5000步后,将学习率固定为1e-4。

最终结果如下:

研究人员对最终结果非常满意,并发表感言:

实验的总体成功率非常高!模仿学习可能是一条通往99%成功率的有效路径!

Aloha 2研究团队主要由DeepMind和斯坦福大学的研究小组组成。

Aloha 2是对原始Aloha系统的改进版,旨在更好地支持双手远程操作。

与先前的版本相比,Aloha 2在硬件方面进行了多项改进,能够执行更为复杂和精细的操作。目前,研究团队已经公开了Aloha 2的所有硬件设计,并提供了详尽的教程和模拟模型,以帮助研究人员和开发者开展大规模的双臂操作研究。

“十年磨一剑”

笔刷一刷静止物体各自动

看完就明白这是一家怎样的AI公司了

任务覆盖率达100%!

普通工程师,7分钟就能上手