通用端到端OCR模型开源,拒绝多模态大型模型的降维打击

编辑日期:2024年09月11日

团队:OCR技术才刚刚起步

在AI-2.0时代,OCR模型的研究已经走到尽头了吗?! (OCR:一种将图像中的文字转换为可编辑和可搜索文本的技术)

Vary作者团队开源了首个迈向OCR-2.0的通用端到端模型GOT,用实验结果向人们证明:No~No~No~

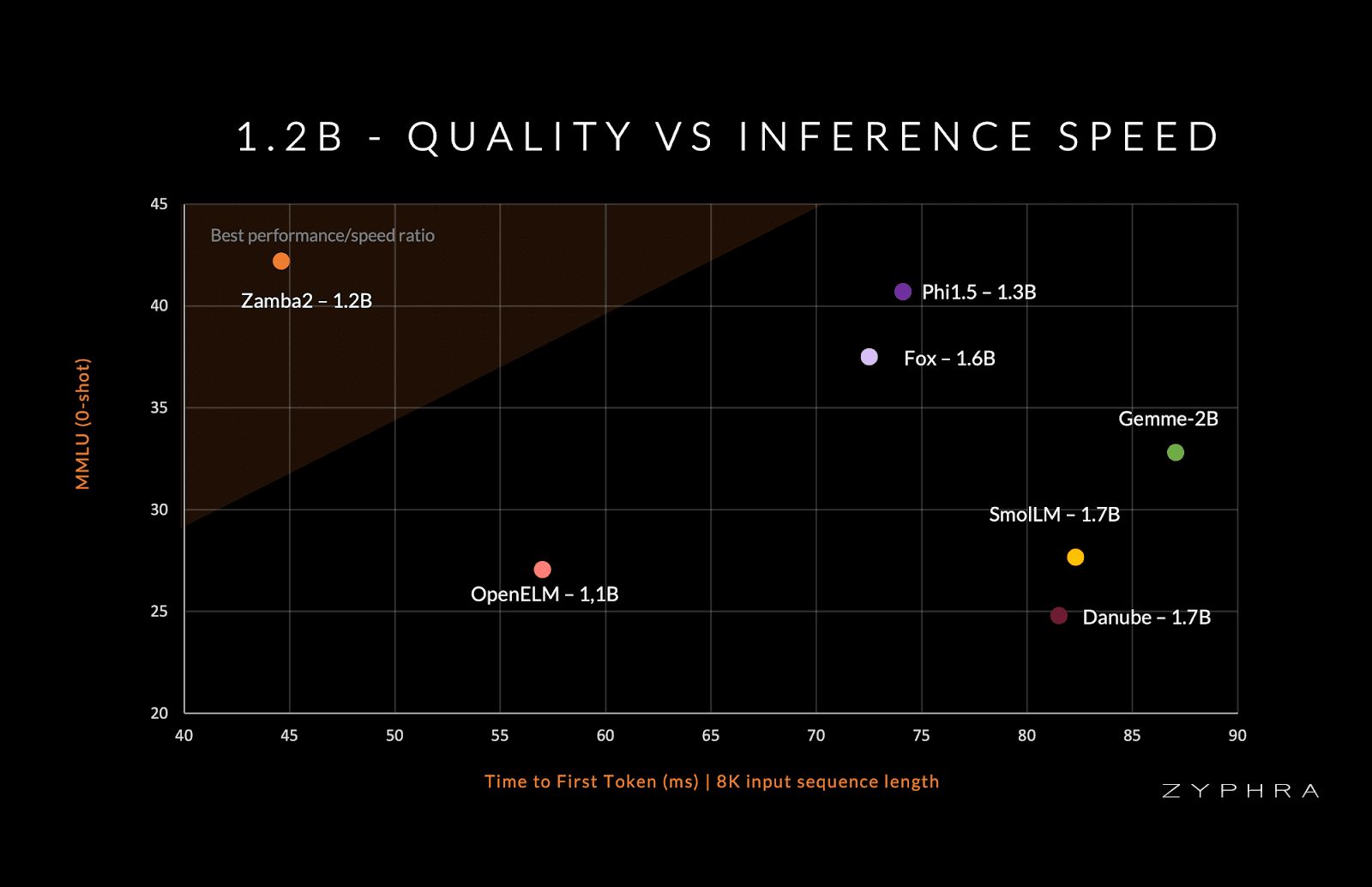

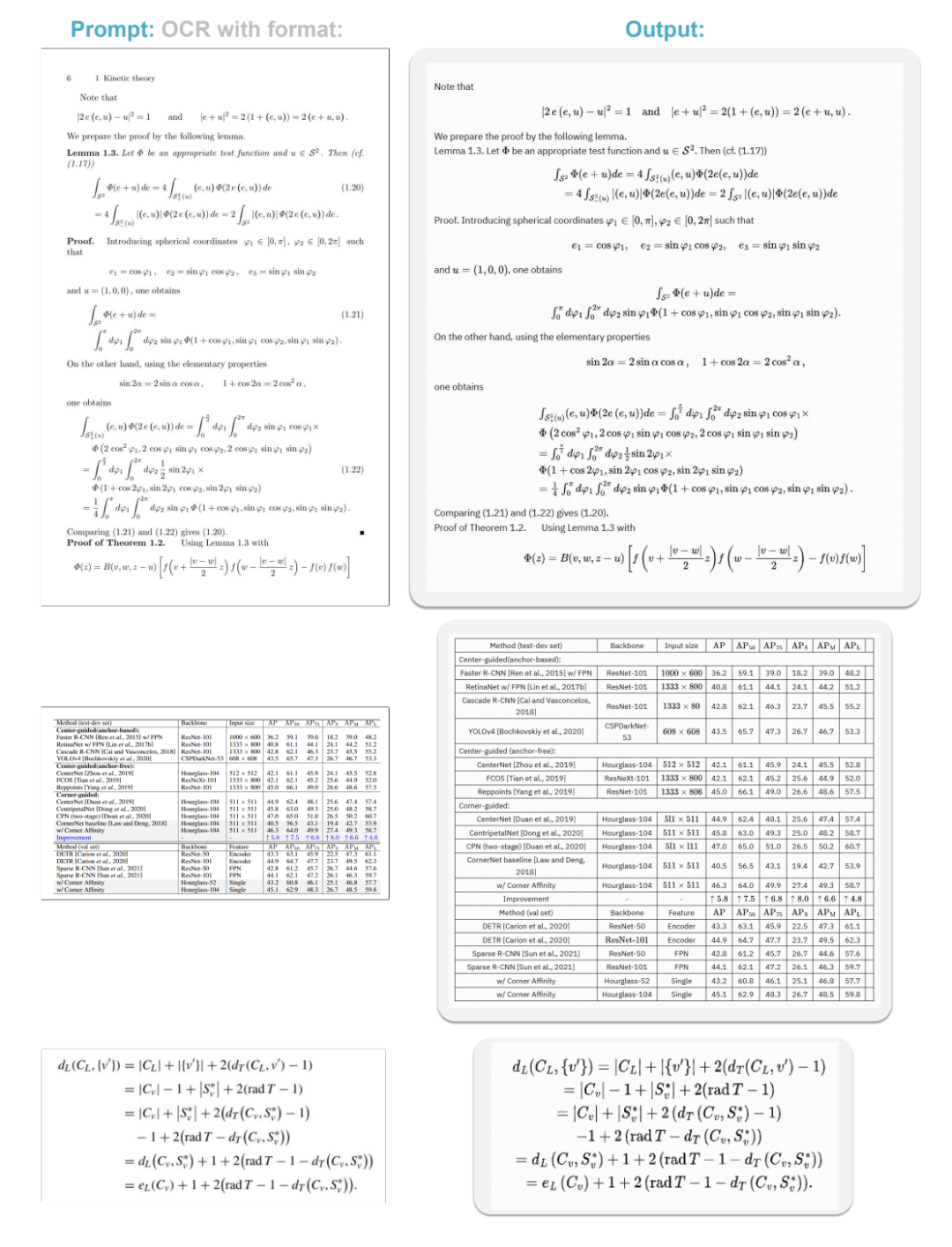

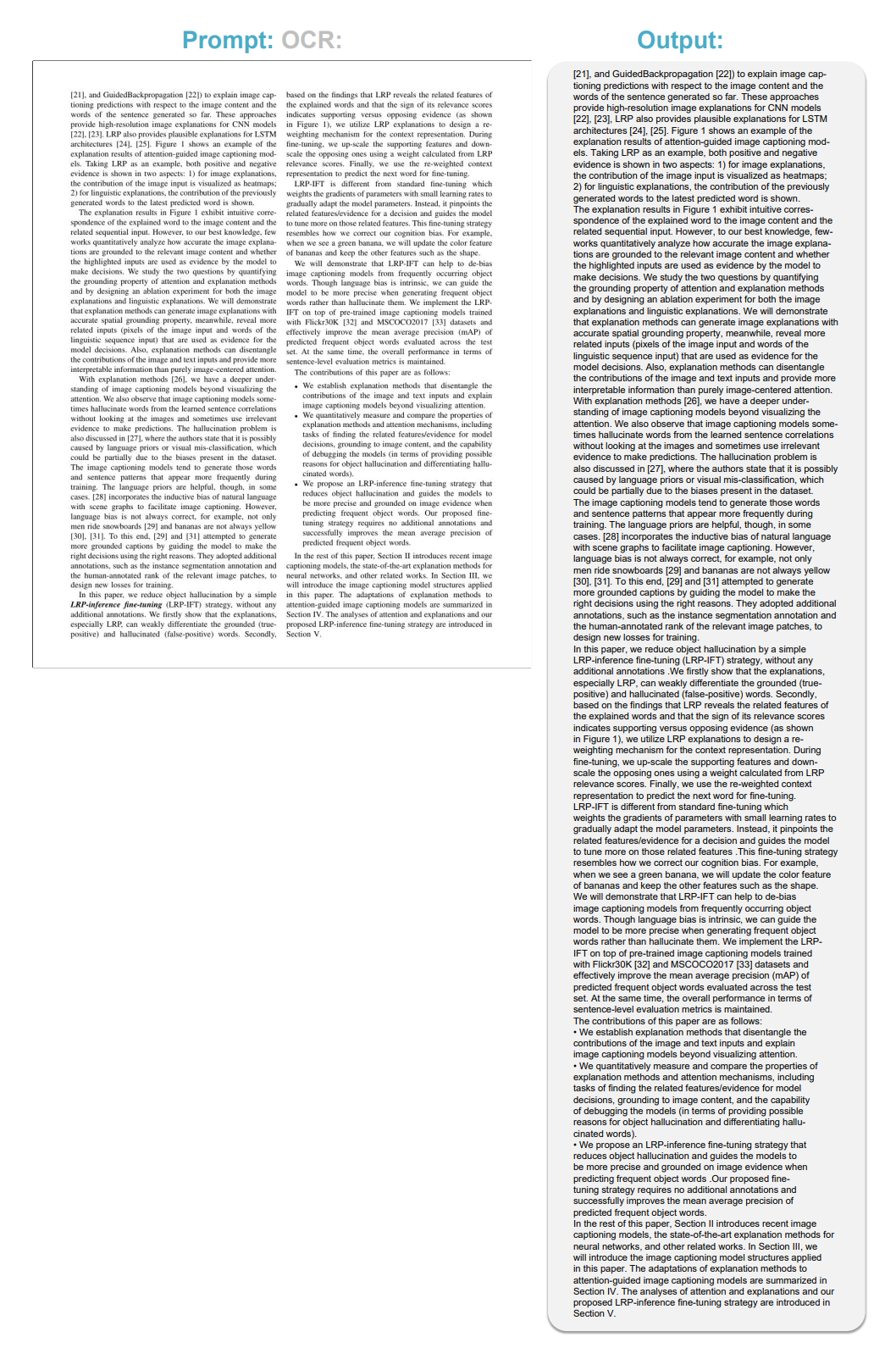

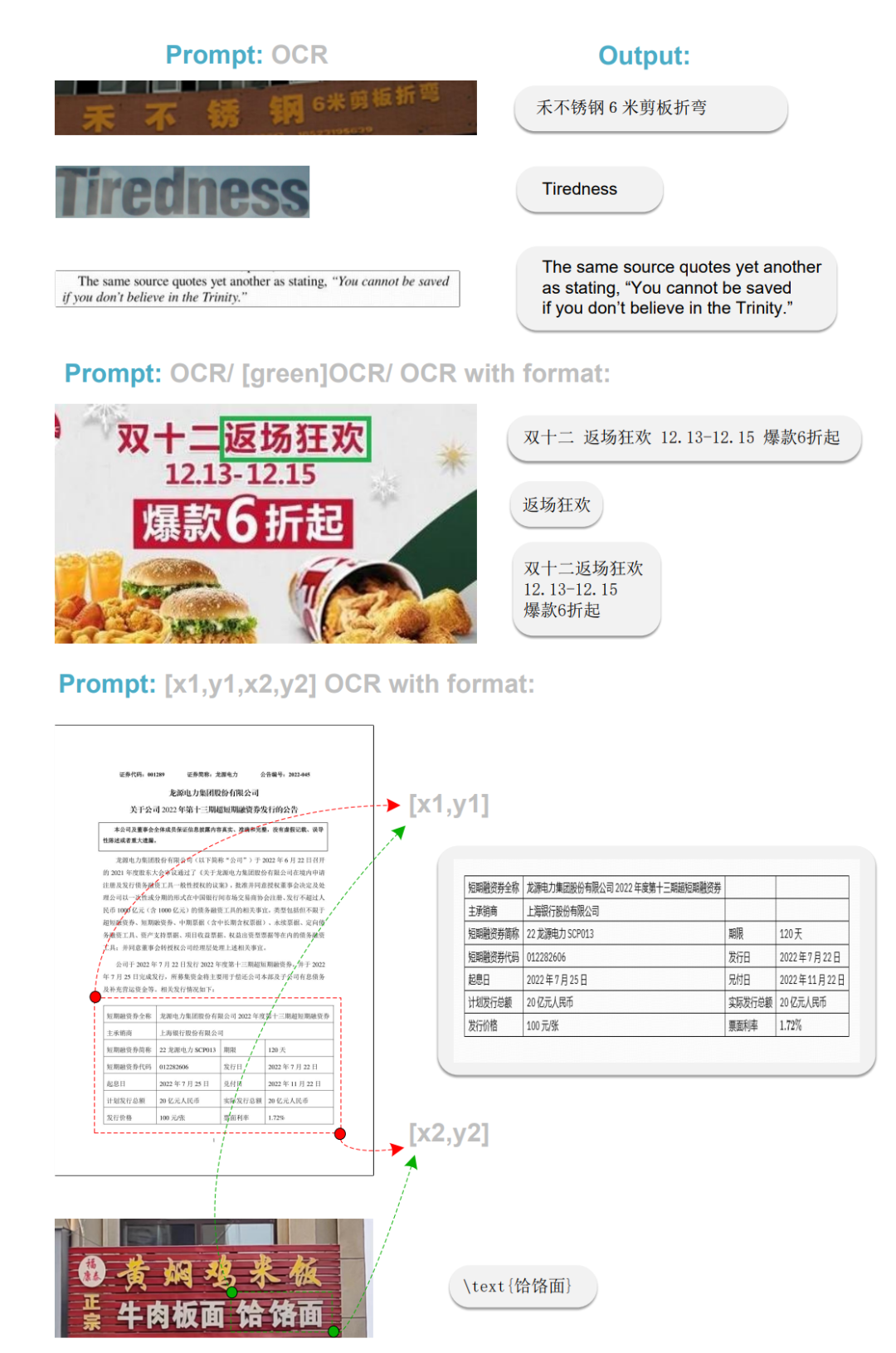

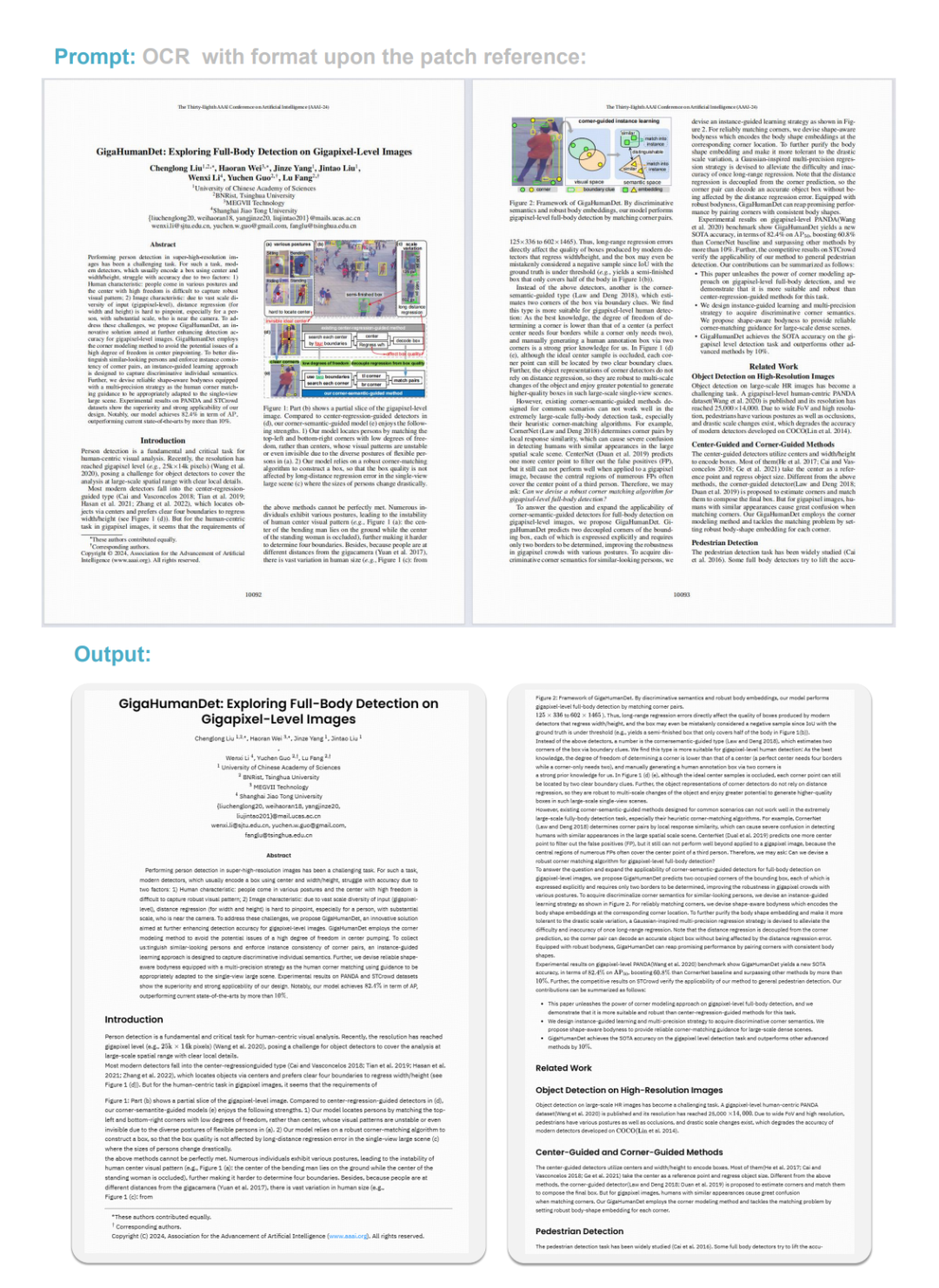

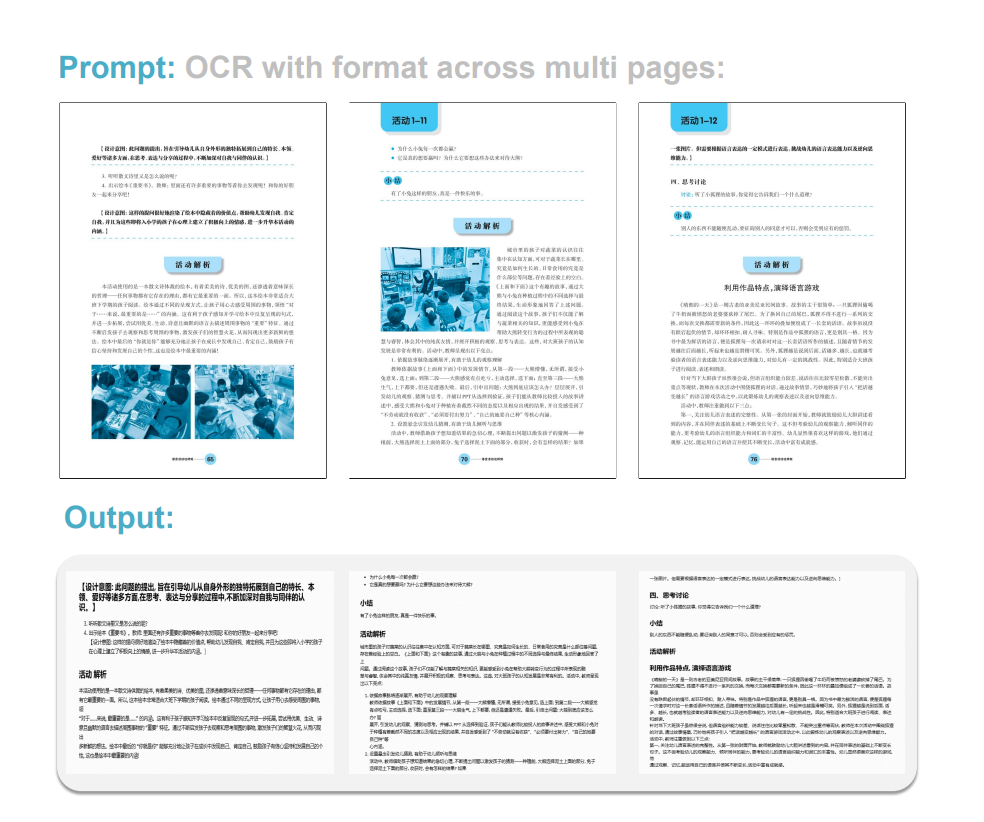

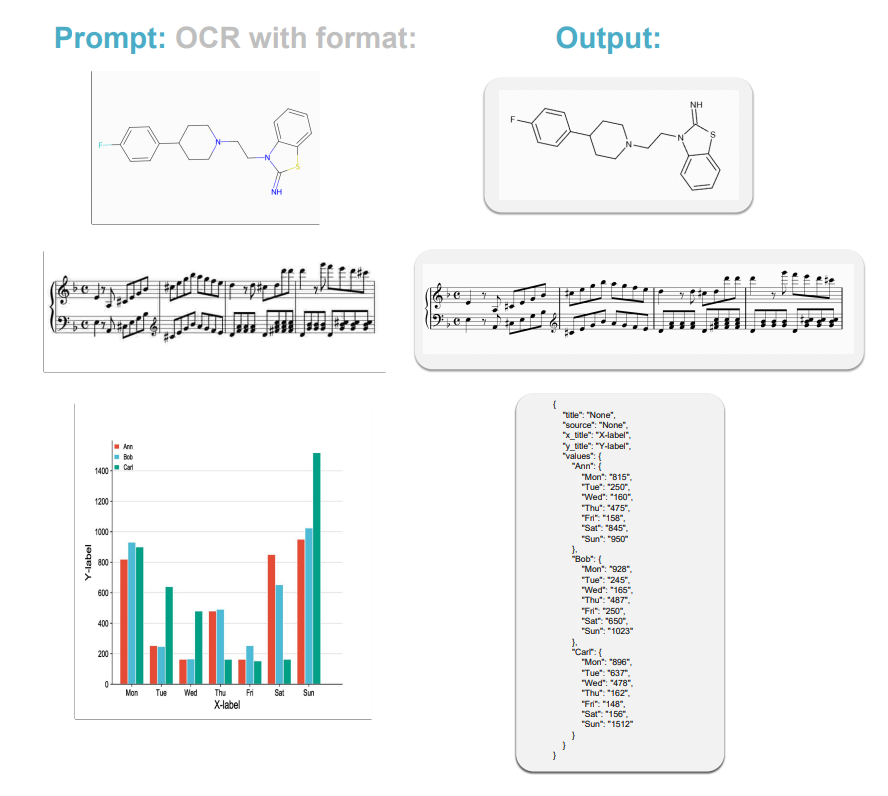

话不多说,直接上效果图:

研究团队表示,尽管GOT模型表现出色,但仍存在一些局限性,例如对更多语言的支持、更复杂的几何图形以及图表上的OCR性能。

他们认为OCR-2.0的研究还远远没有结束,GOT仍有很大的提升空间(该项目在数据和算力资源上都非常受限)。

正因为深入了解了GOT及OCR-2.0的潜力,我们希望通过开源GOT来吸引更多的参与者,促使他们放弃VQA(视觉问答),重新关注强感知技术。人们常说纯OCR技术容易受到指责,但这恰恰说明其表现还不够理想,不是吗?一个通用的OCR模型必须具备高度的通用性,这不仅体现在输入方面,也体现在输出方面。

GOT的通用性具体表现在其输入能力上:该模型能够处理多种任务,包括场景文本识别(Scene Text OCR)、文档OCR、细粒度OCR以及更广泛的OCR任务。

此外,在输出方面,该模型不仅能生成普通的纯文本,还能生成易于阅读和编辑的格式化文本,例如Markdown格式。

在模型结构与训练方法上,采用了视觉编码器+输入嵌入层+解码器的流水线方式。编码器主要基于带有局部注意力机制的VITDet架构,以避免CLIP方案中的全局注意力机制在高分辨率下消耗过大的问题,从而导致显存溢出。

编码器的最后两层则采用了变体的双卷积设计。整个编码器能够将1024x1024x3大小的图像压缩成256x1024的图像tokens,适用于A4纸级别的密集OCR任务。

研究团队将整个训练流程分为三个阶段,并且在整个过程中不锁定任何语言模型(LLM),也没有图像到文本的对齐步骤,这样避免了影响图像tokens的文字压缩效率。

这三个训练阶段分别是:

第一阶段:高效预训练编码器

在这一阶段,由于整个训练过程缺乏A100级别的显卡资源,为了节省资源,我们采用了较小的OPT-125M解码器来为编码器提供优化方向,并快速输入大量数据。

第二阶段:联合训练编码器-解码器

在此阶段,GOT的基础架构已经建立起来,其中包括了上一阶段预训练好的编码器以及Qwen团队预训练好的Qwen0.5B模型。研究团队稍微增大了解码器的规模,因为这一阶段需要输入大量的OCR 2.0知识。不少数据(例如化学公式的OCR)实际上也包含了一些推理成分,但团队并未敢尝试更小的解码器。

第三阶段:锁定编码器,增强解码器以适应更多OCR应用场景

在这个阶段,编码器被锁定,解码器得到强化以适应更多OCR应用场景,例如支持坐标或颜色引导的细粒度OCR(适用于点读笔),支持动态分辨率OCR技术(适用于超高分辨率图像),以及多页OCR技术。这些功能旨在让后续的研究者能够更好地处理类似Arxiv这样的数据集,实现多页PDF文档的直接训练,无需再为.tex文件的分页问题烦恼。

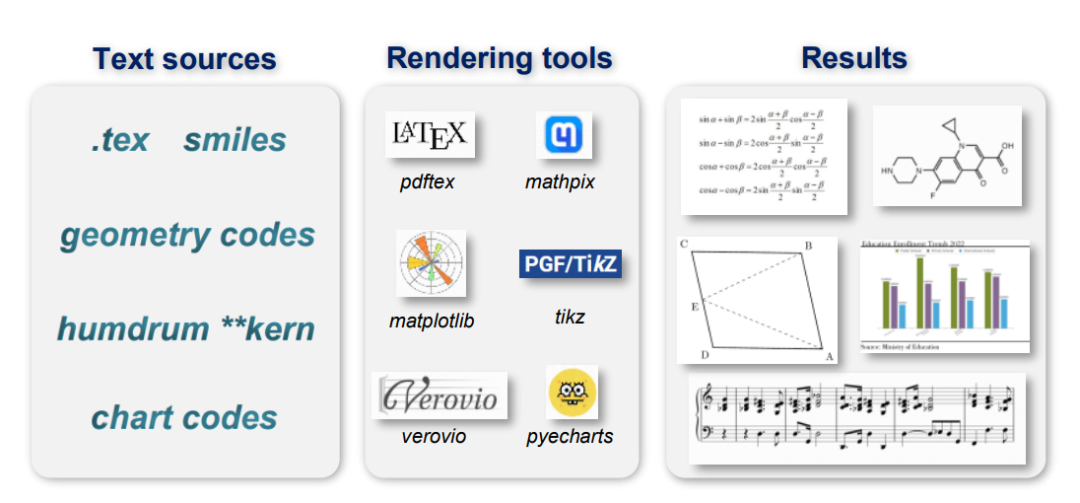

面对整个GOT模型设计中最复杂的环节——数据工程,研究团队不仅构建了多样化的数据集,还学习了多种数据渲染工具,包括LaTeX、Mathpix-markdown-it、Matplotlib、TikZ、Verovio和Pyecharts等。

为何在大模型竞争激烈的时代继续研究OCR?

研究团队有自己的理由:

OCR一直是距离实际应用最近的研究领域之一,是AI-1.0时代的标志性技术。进入以大型语言模型(LVLM)为核心的AI-2.0时代后,OCR成为了多模态大模型的一项基本能力,各大模型纷纷投入大量资源进行研发。尽管多模态大模型作为通用模型在某种程度上显得有些“降维打击”,但OCR仍然是不可或缺的关键技术。

纯OCR研究真的走到尽头了吗?当然没有!或许这才刚刚开始。首先,让我们来看看AI-1.0 OCR系统和LVLM OCR的一些不足之处:

首先是AI-1.0流水线式的OCR系统,其缺点显而易见:各模块较为独立,只能达到局部最优解,并且维护成本较高。

更重要的是,这种系统不够通用,针对不同的OCR任务需要调用不同的模型,使用起来并不方便。

那么,多模态大模型在纯OCR任务上有哪些缺陷呢?我们认为主要有以下两点:

- 为了提高推理(Reasoning,类似于VQA)能力,必然会增加图像token的数量,从而在纯OCR任务上形成瓶颈。推理能力主要依赖于大语言模型(LLM,即解码器)。为了提升VQA性能(至少在某些评分标准上),必须充分利用LLM,这意味着图像token需要尽可能接近文本token(至少在高维表示上),以便LLM更好地处理。想象一下,100个文本token可以编码多少信息?那么一页PDF文档需要多少token呢?不难发现,追求VQA能力会导致在进行OCR任务时,特别是在密集OCR任务中,模型变得非常复杂。

例如,一张A4纸大小的PDF图片,许多LVLM模型都需要将其切割成数千个图像token来进行OCR处理。如果面对多页PDF文档拼接的情况,该如何应对呢?我们认为,OCR模型并不需要如此多的token。

- 直观的一点是,模型规模过大,难以迭代更新。引入新的OCR特性,如支持一种新的语言,并不是简单的微调(SFT)就能实现的,通常需要重新预训练或后训练视觉编码器,这将消耗大量资源。

对于OCR任务而言,这是极大的浪费。

有人可能会问,小型模型能够胜任这么多OCR任务吗?

我们的回答是肯定的,而且甚至可能表现得更好。

优图OCR技术持续突破,从识别到内容理解,跨越多种技术障碍。

从OCR技术入手,助力企业的AI应用实现实际场景落地。

令人意想不到的是,企业一直追求的理想工具,竟然是一款输入法。

这背后,究竟是愚笨之举还是智慧之选?

此外,这一工具还能够进行通用的目标检测。

(注:提供的链接图片实际内容未能查看,上述信息基于文本描述重写,如需更准确重写,请提供具体信息或描述)

大家在看