由于类人通用推理能力和可能被用于制造生物武器的风险因素,OpenAI o1 AI 模型被归类为“中等风险”。

编辑日期:2024年09月13日

据报道,2023年12月,OpenAI成立了新的“防备”团队,并提出了“防备框架”指导方针。

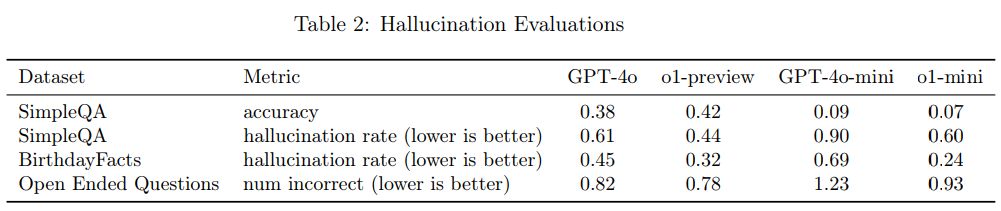

防御团队将对 OpenAI 最先进且尚未发布的 AI 模型进行多次评估,并根据不同类型的感知风险将其分为四个等级,由低到高分别为“低”、“中”、“高”和“严重”。根据新的指导方针,OpenAI 仅会发布评级为“低”和“中”的模型。

OpenAI公司在其官方新闻稿中表示,最终确定o1模型被归类为“中等风险”的主要原因有两个:

人类般的推理能力

O1模型展示了类似人类的推理能力,并且能够在相关主题上生成与人类编写的一样具有说服力的论点。

这种说服力并非仅限于o1,先前的AI模型也展现出了这种能力,有时甚至超过了人类的表现。

可以协助制造生物武器

评估表明,O1模型能够辅助专家复制已知的生物武器威胁。

OpenAI 宣称,其 o1 模型在数学和科学领域的能力有了显著提升。

注:原文中的“o1模型”可能是特定的上下文或命名,这里直接保留了原文表述。如果“o1”有具体的名称或其他细节信息,请提供以便更准确地重写。

例如,在美国数学奥林匹克竞赛(USA Mathematical Olympiad,简称USAMO)的预选赛中,新模型的表现可以跻身美国前500名学生的行列,并且在物理、生物和化学问题的基准测试中,其准确度超过了人类博士水平。

OpenAI 首次将其模型在化学、生物、放射性和核武器(CBRN)风险方面的评级定为“中性”。这些模型在发布时附带了多次对其潜在危险的警告。