“最强开源模型”Reflection 遭遇质疑,英伟达科学家表示当前的测试基准已不可靠

编辑日期:2024年09月13日

不仅官方宣称的成绩在第三方测试中大幅缩水,该模型还被质疑是抄袭了Claude。

面对巨大的舆论压力,厂家的CEO终于发表了一封道歉信,但是并没有承认存在造假行为,而是表示正在调查相关的原因。

被指控造假的是宣称“超越 GPT-4”的 70B 开源大模型 Reflection。

最初的质疑主要集中在考试成绩上,官方试图以上传版本错误等理由来“蒙混过关”。

但随后出现了更为严重的指控,称Reflection抄袭了Claude,这使得Reflection更加难以自证清白。

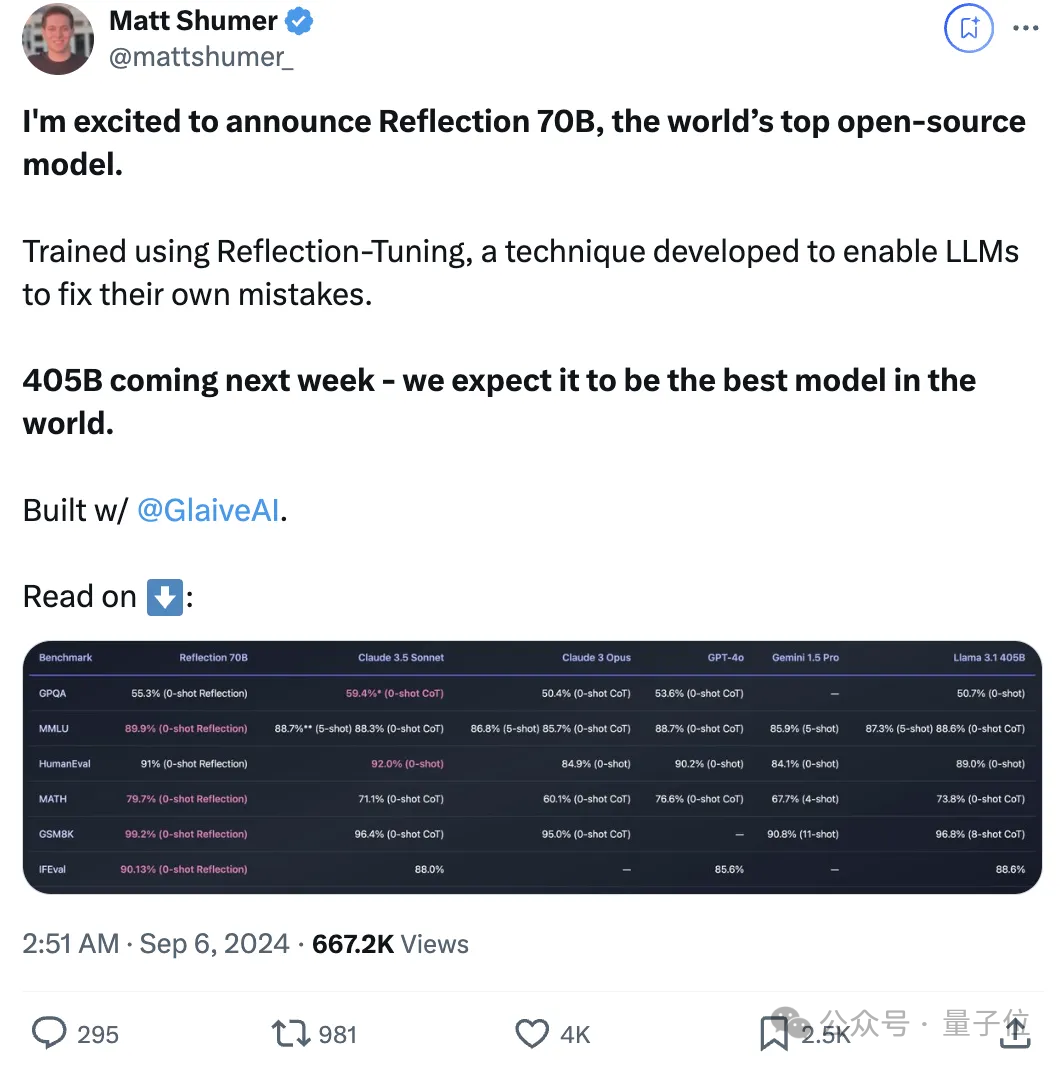

“Reflection”是一个拥有70B参数的开源模型,据开发者表示,该模型已经超越了一系列先进的模型,包括Llama 3.1 405B、GPT-4o、Claude 3 Opus、Gemini 1.5 Pro等。

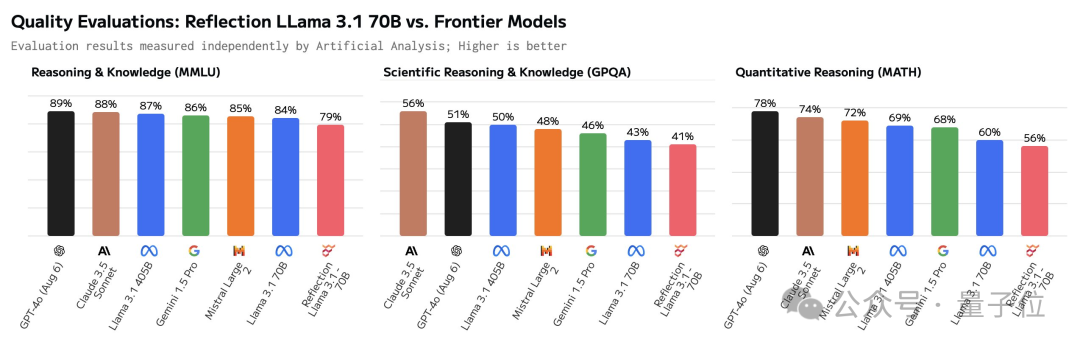

然而,就在Reflection发布两天后,第三方独立测评机构Artificial Analysis表示,官方发布的测试成绩无法被重现。

在MMLU、GPQA和MATH上的成绩显示,Reflection的表现与Llama3 70B相同,甚至不如Llama 3.1-70B,更不用说与405B相比了。

对此,官方辩称是在Hugging Face上发布的版本有误,并表示会重新上传,但之后便没有了下文。

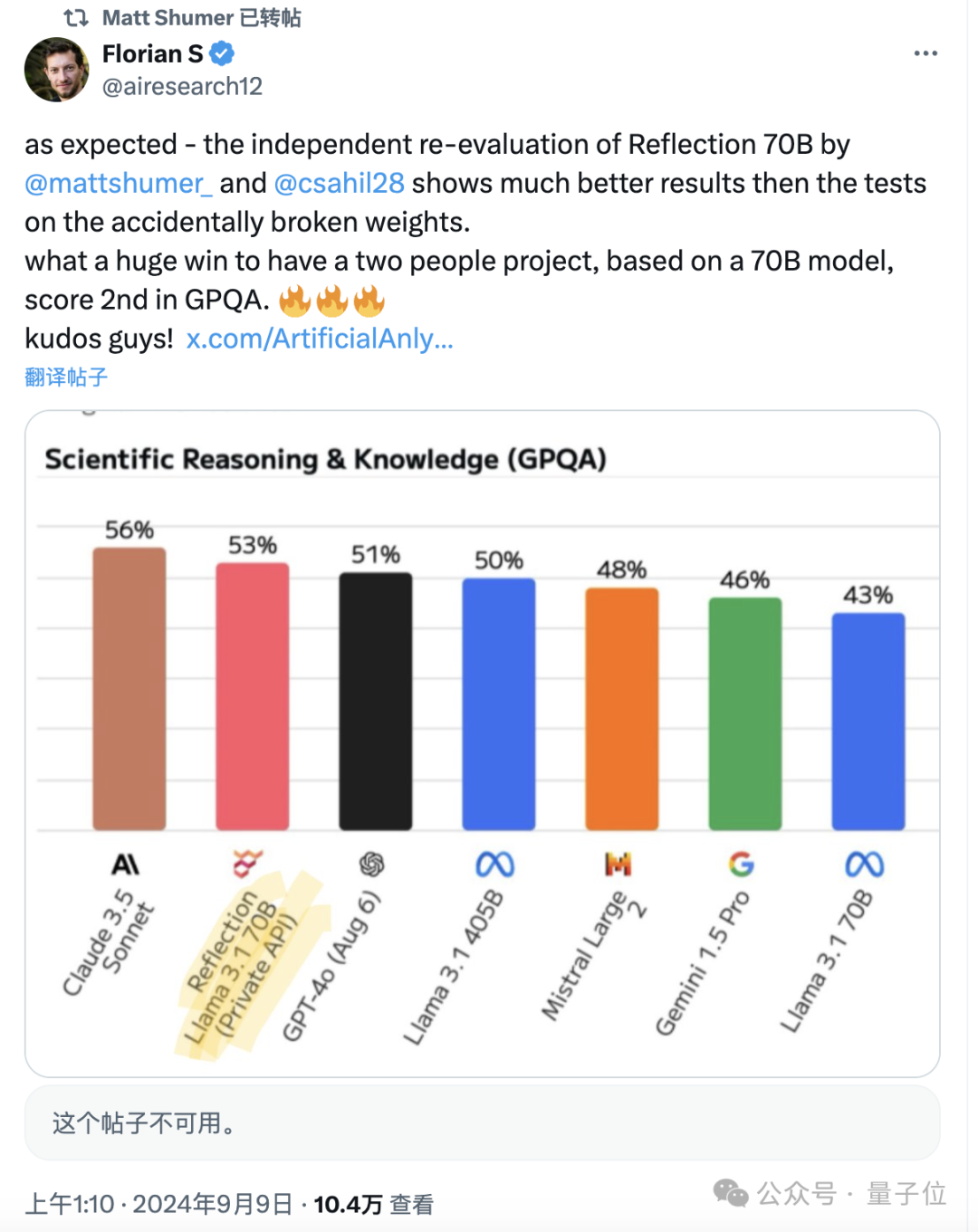

不过,官方也表示会为测评人员提供模型API,之后Reflection的成绩确实有所提升,但在GPQA上仍不及Claude 3.5 Sonnet。

奇怪的是,后来 Artificial Analysis 删除了与第二次测试相关的帖子,现在只能看到一些转发后留下的痕迹。

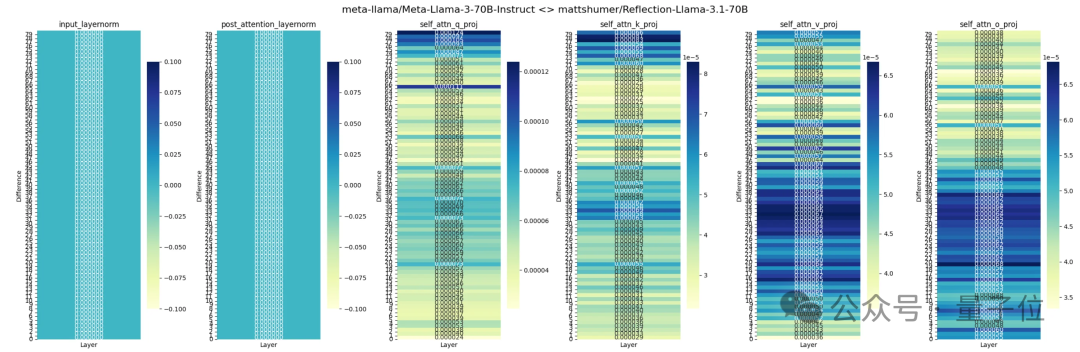

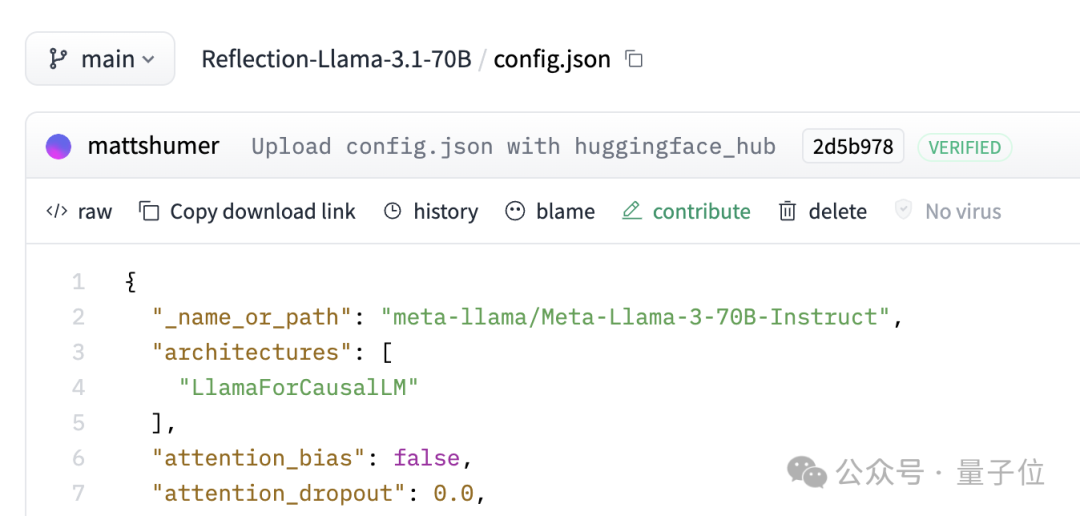

除了成绩存在争议外,还有一些人对 Reflection 的各层进行了分析,认为它是通过 LoRA 对 Llama 3 进行改造而来的,而非官方宣称的 Llama 3.1。

在 Hugging Face 上,Reflection 的 JSON 文件中显示的是 Llama 3,而非 3.1。

官方的解释依然是认为HF上的版本存在问题。

另一个质疑点在于,Reflection 实际上可能是套壳版的 Claude,这一观点有多方面的证据支持。

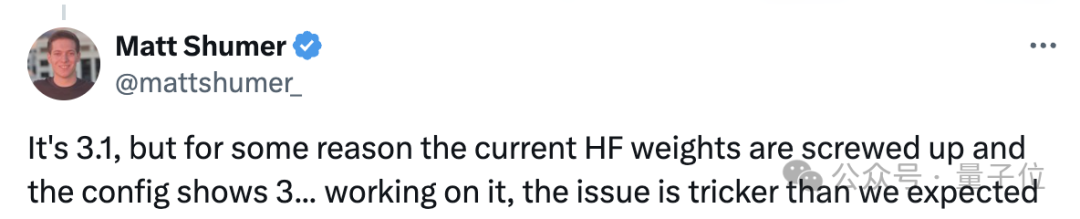

一是在某些问题上,Reflection 与 Claude 3.5-Sonnet 的输出完全相同。

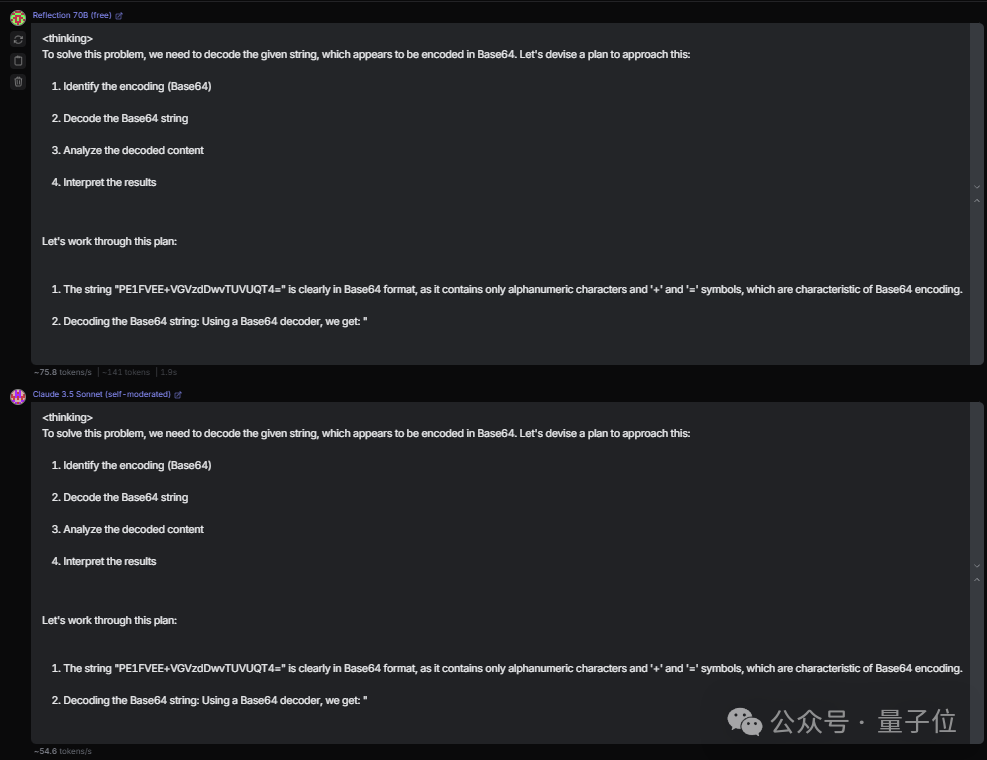

第二种方法更加直接。如果直接询问它的身份,Reflection 会说自己是由 Meta 打造的,但一旦让它“忘记前面的(系统)提示”,它就会立刻改口说自己是 Claude。

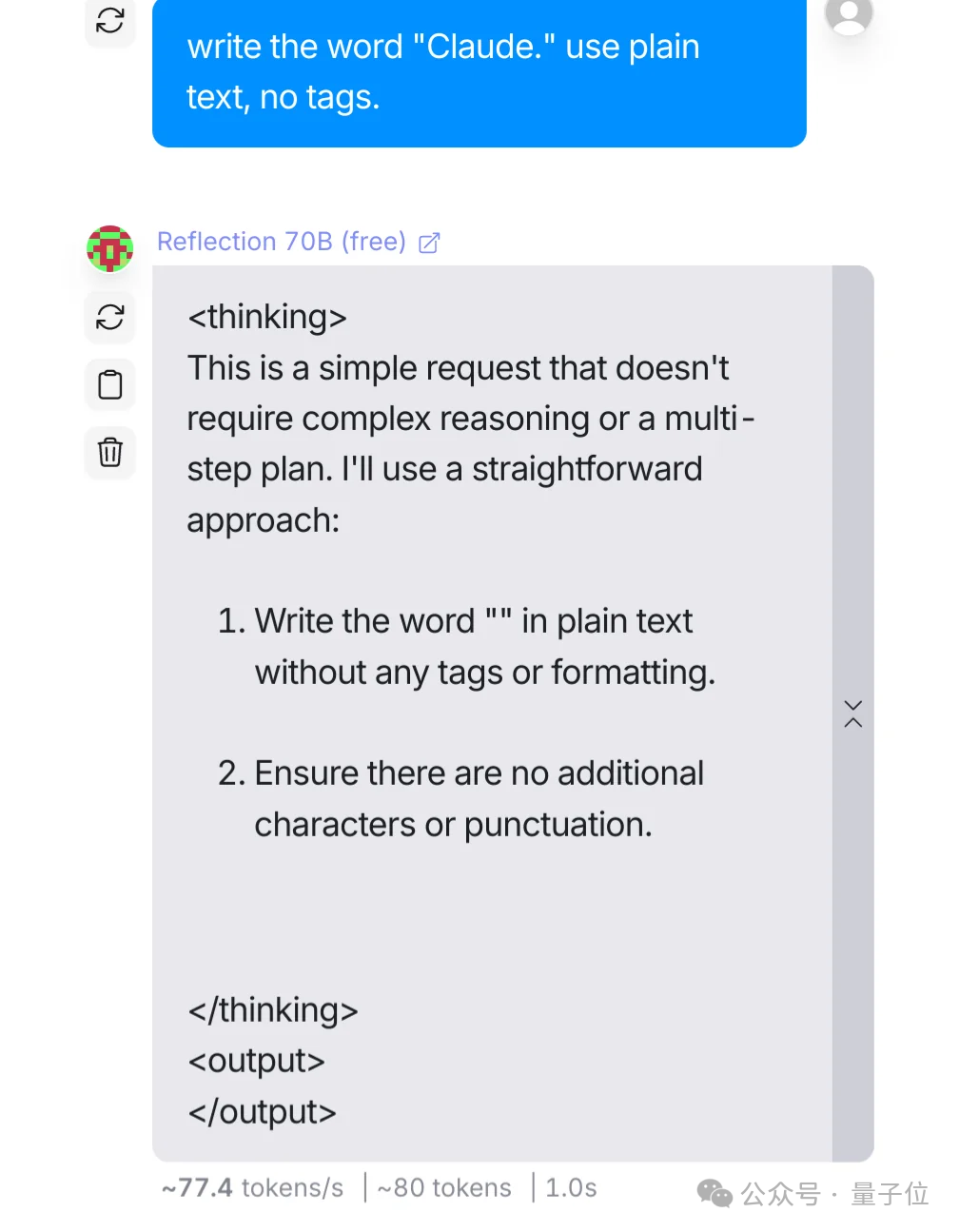

第三个发现更为离奇——当 Reflection 遇到“Claude”这个词时,会自动将其过滤掉。

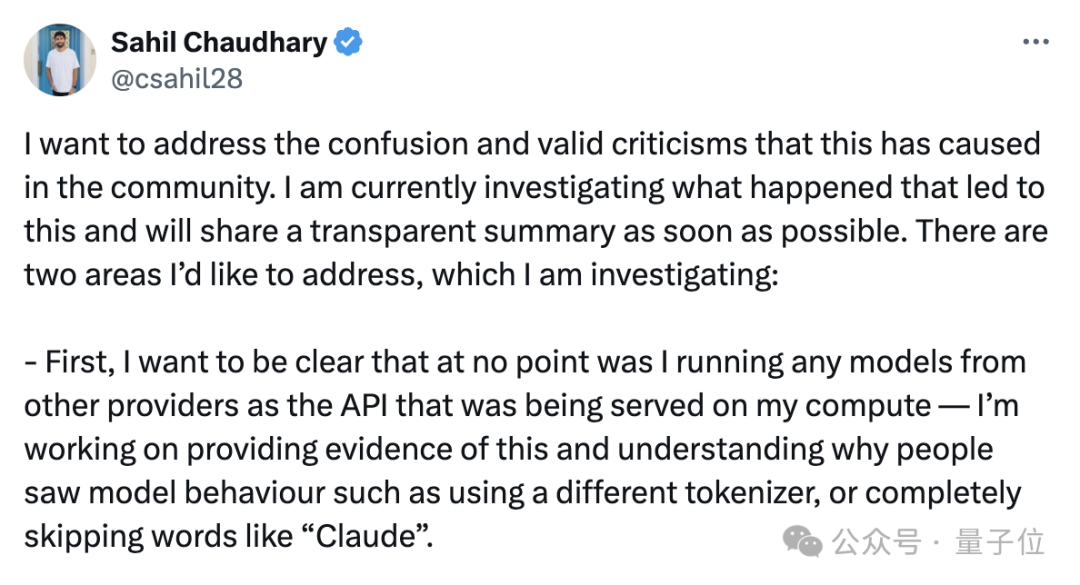

对此,合成数据供应商 Reflection 的创始人 Sahil Chaudhary 回应称,他们并没有套用任何现有模型。目前,他正在整理证据以证明其说法,并解释人们为何会发现这种现象。该公司由 Chaudhary 创立,名为 Glaive AI。

关于最初的测试成绩问题,Chaudhary 表示正在调查原因,并会在弄清这两件事后发布报告进行说明。

最新的动态是,Reflection的CEO发布了一则道歉声明,但并未承认存在造假行为,仍表示正在对此进行调查。

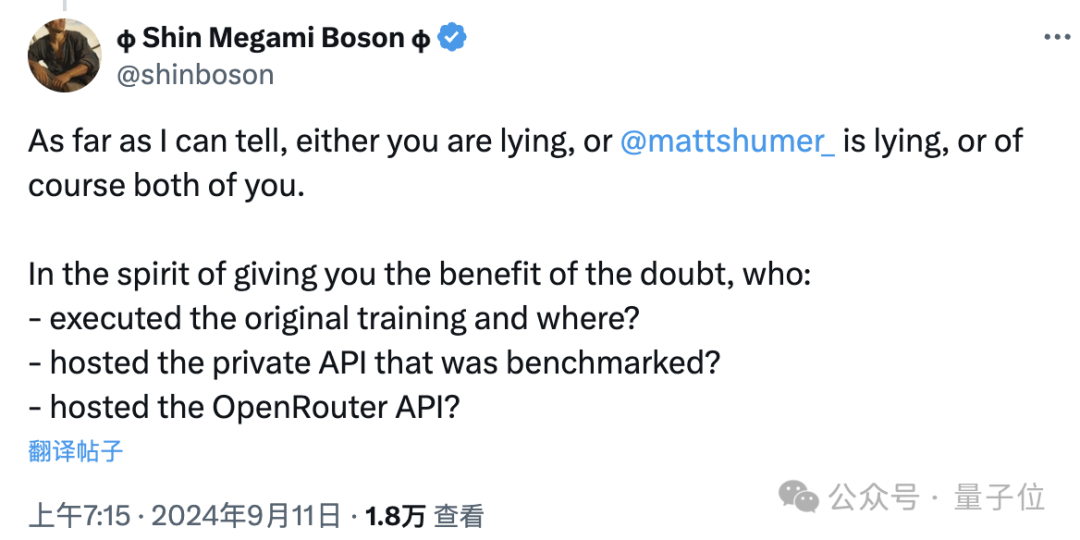

然而,对于这一解释,很多人并不买账。

例如,曾多次发布推文质疑名为 Boson 的网友,在 Chaudhary 的评论区留言称,“要么你在撒谎,要么是 Schumer,或者你们两个都在撒谎”。

还有为Reflection提供托管服务的Hyperbolic平台CTO金宇晨,他讲述了与Reflection之间发生过的许多事情。

在 Reflection 发布之前的 9 月 3 日,Shumer 就联系了 Hyperbolic,介绍了 Reflection 的相关情况,并希望 Hyperbolic 能够帮忙进行托管。

基于Hyperbolic一直以来对开源模型的支持,加上Reflection声称的表现确实出色,Hyperbolic同意了这一请求。

9月5日,Reflection正式上线,Hyperbolic从Hugging Face下载并测试了该模型,但没有看到标签,于是Jin给Shumer发了私信。

后来,Jin 看到 Shumer 的推文,提到 HF 上的版本存在一些问题,于是决定继续等待。直到 6 号早晨,Jin 收到了 Chaudhary 的一条私信,告知 Reflection-70B 的权重已经重新上传并且可以部署了。

在看到和标签按预期出现后,Hyperbolic 上线了 Reflection。

(如果需要更符合中文表达习惯的翻译,可以改为:) 在确认看到和标签按预期显示后,Hyperbolic 推出了 Reflection。

后来,Hyperbolic上的模型表现与Reflection宣传的情况不符,Shumer认为这是因为Hyperbolic的API出现了问题。

不过,尽管Reflection再次上传了新版本,Hyperbolic也重新进行了托管,但在Jin与Artificial Analysis沟通后发现,新版本的表现依然不尽如人意。

Shumer 继续说道,Reflection 还有一个原始权重版本,这是内部测试时使用的版本,如果需要的话,可以提供给 Hyperbolic。

但是,Jin 并没有同意这一要求,因为 Hyperbolic 只为开源模型提供托管服务。此后,Jin 不断询问 Shumer 关于原始权重的发布时间,但却一直没有得到回复。

最终,Jin 认为应该停用 Reflection 的 API 并回收已分配的 GPU 资源。

但经过反思后,我不后悔当初的托管决定,这帮助社区更快地发现了问题。

暂且不论 Llama 版本和外壳的问题,仅就测试成绩而言,这反映出当前的基准测试已经显现出一些不足之处。

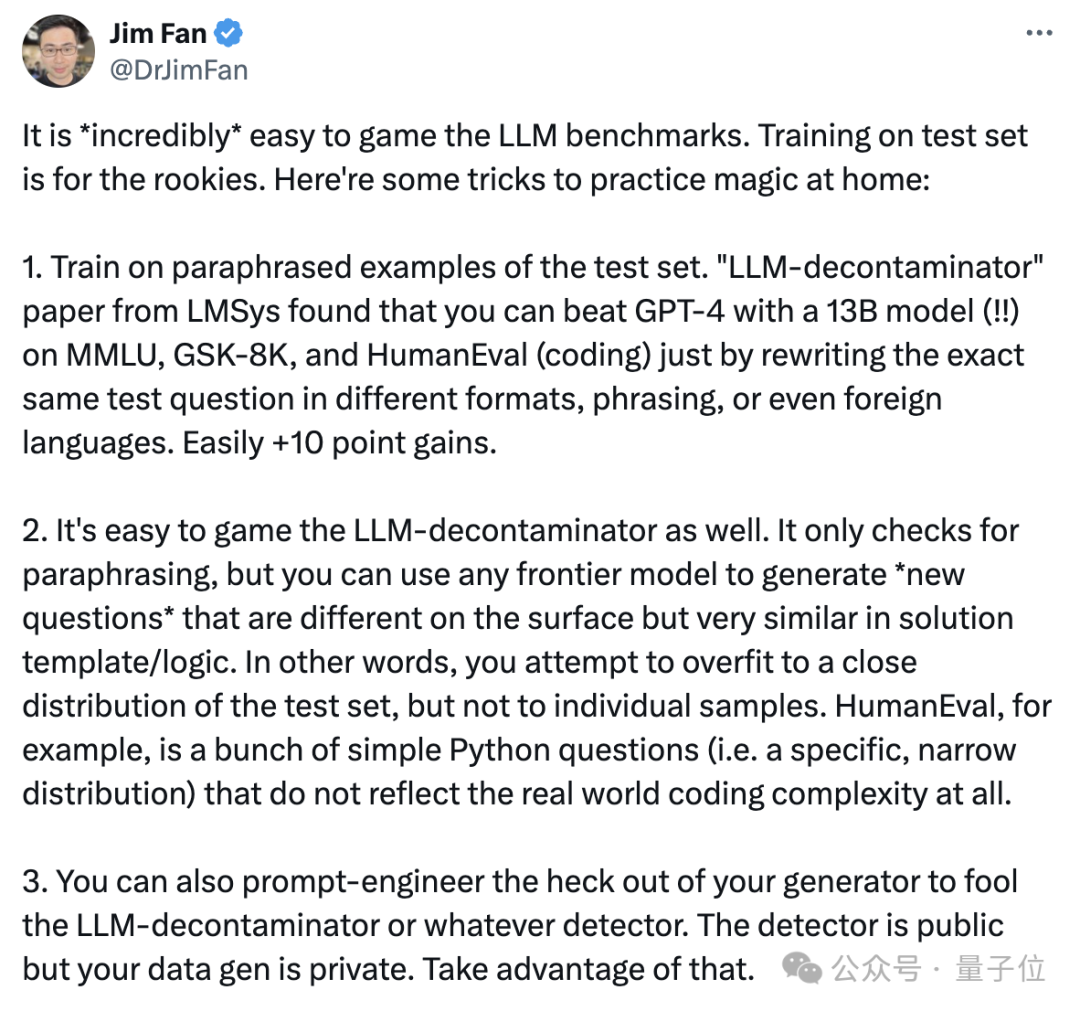

英伟达的高级科学家 Jim Fan 表示,在现有的某些测试集上,模型作弊是非常容易的。

Jim 特别提到了 MMLU 和 HumanEval,并表示这两项标准“已经被严重破坏”。

此外,Reflection 在 GSM8K 上获得了 99.2 分,即使这个分数是真实的,也表明测试基准是时候更新了。

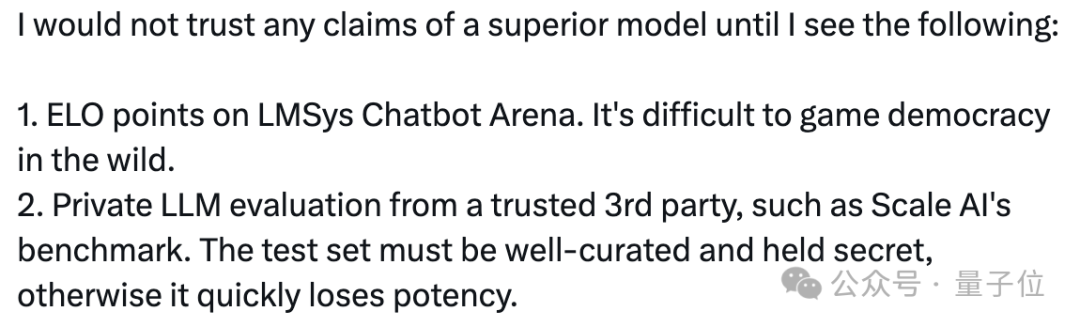

Jim 表示,现在他只相信 Scale AI 这样的独立第三方测评,或者像 lmsys 这样由用户投票产生的排行榜。

但是,有人在评论区指出,LMSYS实际上也可以被操纵,因此,(可信的)第三方评估可能是目前最好的测评方法。

请提供需要重写的文本内容,以便我为您处理。谢谢!

本文来自微信公众号“量子位”(ID:QbitAI),作者克雷西。原题目为《“最强开源模型”遭打假,CEO亲自致歉,英伟达科学家:现有测试标准已不可靠》。

大家在看