字节AI版的小李子一开口就说:“黄风岭,八百里。”

编辑日期:2024年09月13日

数字人技术已愈发逼真

字节跳动与浙江大学联合研发的项目Loopy引起了广泛关注!

仅需一张图片和一段音频,就能生成一段非常自然流畅的视频!

研究团队还发布了Loopy与其他类似应用的对比视频:

网友们纷纷点赞:

Loopy背后的技术真是厉害!感觉互动媒体将迎来新的未来!

前景无限好啊!

真的这么神奇?我们一起来看看!

研究团队发布了一些DEMO视频,内容创意十足!

例如,让莱昂纳多·迪卡普里奥演唱《黑神话》中灵吉菩萨的陕北说书(高音时还会皱眉):

让兵马俑用英伦口音讲话:

让蒙娜丽莎开口说话:

梅梅自带背景音乐讲古装台词(甚至还有挑眉的小动作):

即使是休·杰克曼侧面照片也能生成视频:

连叹息声这样的细节都能处理得当:

真人肖像的生成效果也非常自然(甚至连说话时的眼神转动都表现得十分真实):

看完这些毫无违和感的DEMO视频后,让我们了解一下Loopy是如何生成此类视频的:

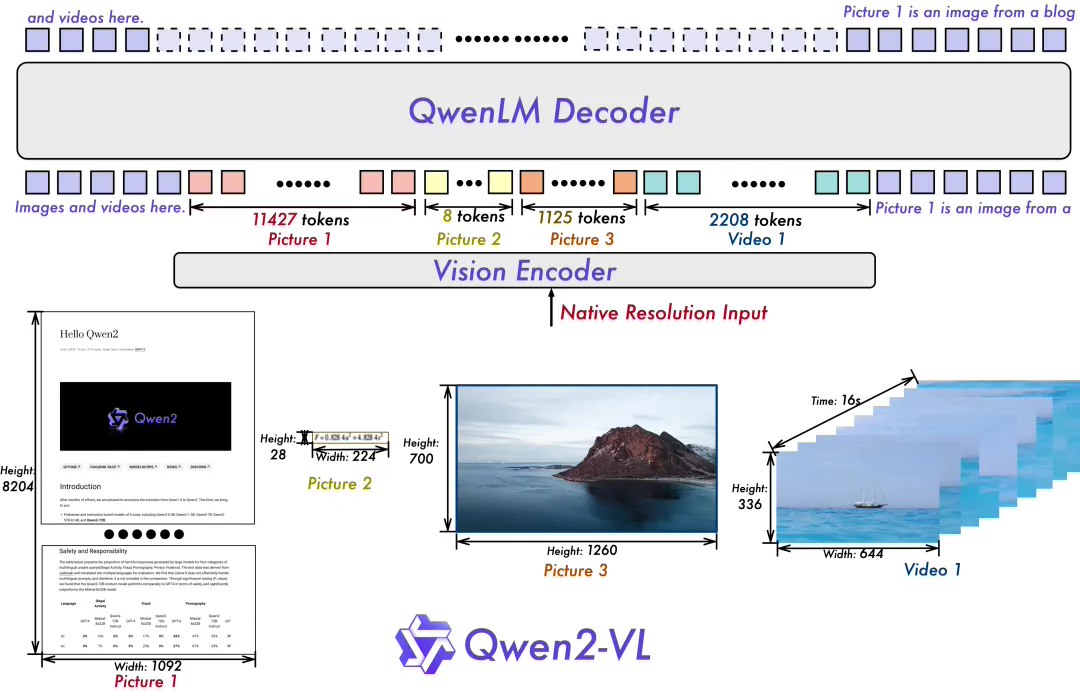

总体来说,Loopy是一个端到端的音频驱动视频生成模型。其框架由以下四部分组成:

- ReferenceNet:一个额外的网络模块,复制了原始SD U-Net的结构,以参考图像的潜在表示作为输入,提取参考图像的特征。

- DenoisingNet:一个去噪的U-Net,负责从噪声输入生成最终的视频帧。在DenoisingNet的空间注意力层中,ReferenceNet提取的参考图像特征会与DenoisingNet的特征在token维度上进行拼接。

这样做是为了让DenoisingNet能够有选择地吸收来自ReferenceNet的与当前特征相关的图像信息,从而在生成过程中保持图像的视觉一致性。简言之,通过融合两个网络的特征,DenoisingNet能更有效地利用参考图像中的细节,提升生成结果的质量和连贯性。

Loopy的外观模块主要负责接收参考图像和运动帧图像,并将其压缩为特殊的数字编码(即潜在向量)。

运动帧的潜在向量经过“时间序列模块”的处理后,与参考图像的潜在向量进行拼接,从而融合了参考信息和动作信息。

随后,这些拼接后的潜在向量被输入到ReferenceNet模块中,生成一张包含重要视觉信息的特征图,以便后续的去噪模块使用。

Loopy的音频模块则先使用Wav2Vec网络提取音频特征,并将各层特征连接起来,形成多尺度音频特征。

对于每一帧视频,将前两帧和后两帧的音频特征连接,形成一个包含五帧音频特征的序列,作为当前帧的音频信息。

最后,在每个残差块中,使用“交叉注意力”机制,将音频特征与视觉特征相结合,计算出一个关注的音频特征,并将其与视觉特征相加,生成新的特征。

此外,模型中还有一个Audio2Latent模块,该模块可将音频信息映射到共享的运动潜在空间,进一步帮助模型理解音频与视频中人物动作之间的关系。

研究团队的实验结果如下:

字节AI版的小李子一开口就说:“黄风岭,

值得一提的是,在Loopy出现之前,字节跳动与浙江大学就已经共同研发了一个类似的项目——CyberHost。

但与Loopy不同的是,CyberHost是一个端到端音频驱动的人类动画模型。

斯坦福教授花费了十年时间对其进行训练,

Time AI 100

“AI界的iPhone时刻确实已经到来。”

请机器来寻找“异父异母的亲兄弟”。