OpenAI 的 o1 非 GPT-4 模型是在成本和性能之间做出妥协的直接进化。

编辑日期:2024年09月14日

- 锻炼思维链

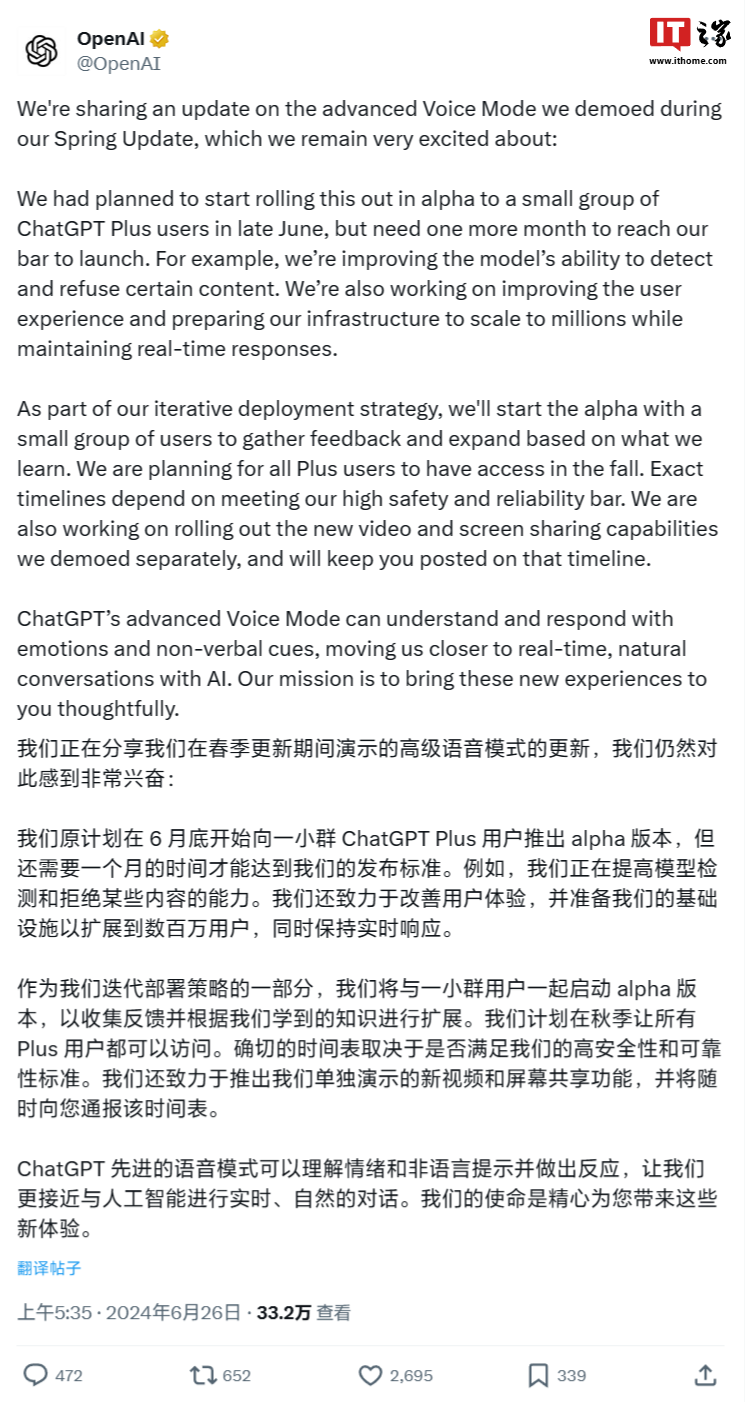

OpenAI 的声明是一个很好的起点:“我们开发了一种新的系列人工智能模型,目的是让它们在做出回应之前花更多的时间进行思考。”

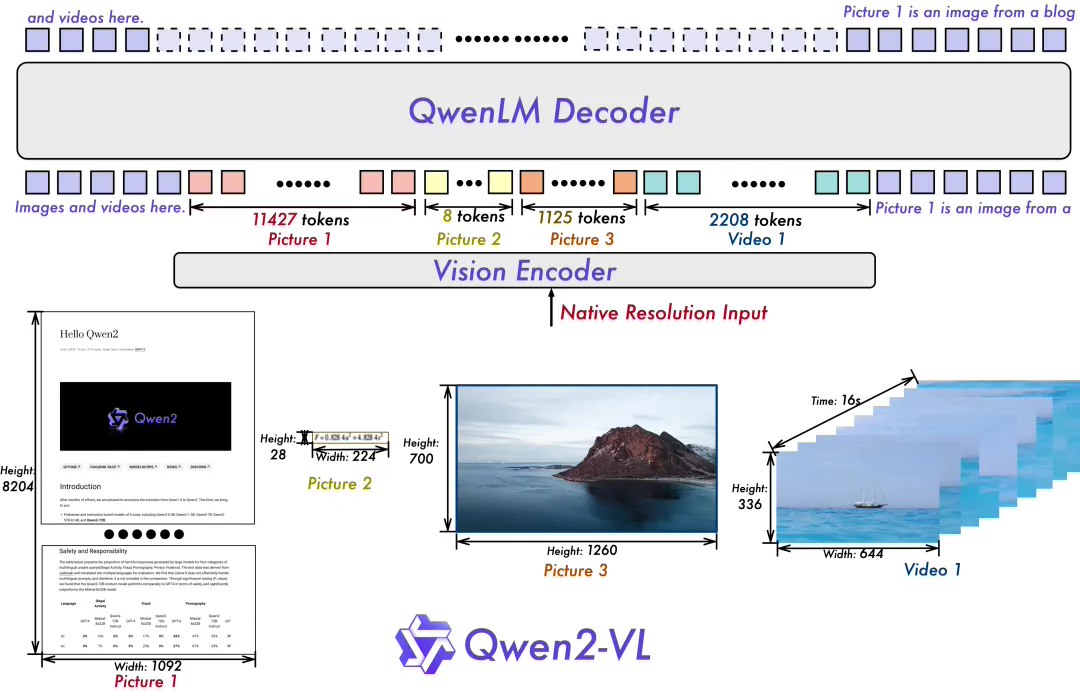

这些新模型可以看作是思维链提示策略的深入扩展,体现了“分步思维”策略的具体应用。事实上,人工智能社区在此领域已经探索了多年。这一策略最早出现在2022年5月发表的论文《大语言模型是零样本推理器》中。

OpenAI 发布的《与大型语言模型共同学习推理》(Learning to Reason with LLMs)一文详细介绍了新模型的训练方法,揭示了其能力提升的背后原因。文中指出:

我们的大规模强化学习算法经过精心设计,优化了训练流程,使模型在高效利用数据的同时,能够熟练运用思维链进行深度思考。我们发现,随着强化学习训练时间的增加以及模型在测试时分配更多思考时间,o1 的性能持续显著提升。值得注意的是,这种扩展方法面临的限制与大型语言模型预训练中的挑战有很大不同,我们正在继续深入探索这些新的边界。

通过强化学习的训练,o1 不仅学会了优化其思维链的使用,还掌握了自我提升的关键技能。它能够识别并纠正错误,将复杂的问题分解成一系列更容易处理的子任务。当现有的方法行不通时,o1 会尝试不同的策略,直到找到最佳解决方案。这一过程极大地提升了模型的推理能力。

实际上,这标志着模型在处理复杂提示方面实现了质的飞跃。面对需要回溯和深入“思考”的任务时,模型展现出了更出色的能力,而不再仅仅依赖于下一个 Token 的预测。

威利森指出,尽管他对“推理”一词在大型语言模型中的定义有所保留,但由于OpenAI已明确采用这一术语,并成功表达了新模型所致力于解决的核心问题,因此他认为在这种情况下,这种表述是恰当且有效的。

- 来自 API 文档的底层详情

关于新模型及其设计权衡,OpenAI 在其 API 文档中提供了许多有趣的细节:

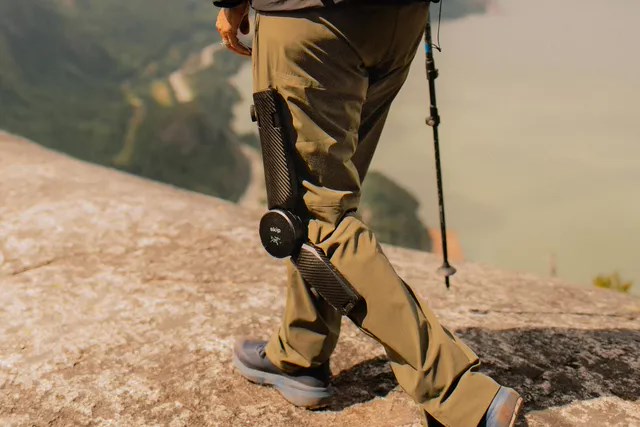

对于依赖图像输入、函数调用或需要即时响应的应用场景,GPT-4o 及其简化版 GPT-4o mini 仍然是理想选择。然而,如果您的项目需要深度推理能力,并且可以接受较长的响应时间,那么 o1 模型无疑是更好的选择。

威利森从OpenAI的文档中摘取了几个关键点:

API 访问权限:目前,只有五级账户用户可以访问 o1-preview 和 o1-mini,并且需要累计 API 积分达到至少 1,000 美元才能解锁。

系统提示限制:当前模型集成了现有的聊天完成API,仅支持用户与助手之间的消息互动,不支持系统提示功能。

其他功能限制:当前模型不支持流处理、工具集成、批处理调用或图像输入。

响应时间:由于模型解决不同问题所需的推理量不同,处理请求的时间可能在几秒到几分钟之间。

特别引人注目的是“推理 Token”的引入。这些 Token 在 API 响应中不可见,但扮演着至关重要的角色,是推动新模型能力的核心,并且作为输出 Token 进行计费和计数。由于推理 Token 的重要性,OpenAI 建议在充分利用新模型时预留大约 25,000 个推理 Token 的预算。

因此,输出令牌的配额显著提高:o1-preview 的配额增加到 32,768 个,而 o1-mini 的配额则达到 65,536 个。与 GPT-4o 及其 mini 版本(两者配额均为 16,384 个)相比,这一调整为用户提供了更多的资源。

API 文档还提出了一种新颖且关键的优化建议,旨在改进检索增强生成(RAG)效果:在整合附加的上下文或文档时,应严格筛选,只保留最相关的信息,以避免模型生成过于复杂的回应。这一方法与传统的 RAG 方法大相径庭,因为传统方法往往会将大量可能相关的文档纳入提示中。

- 隐藏的推理令牌

遗憾的是,推理 Token 在 API 调用过程中是隐藏的。用户虽然需要为这些 Token 付费,但却无法了解其具体内容。对此,OpenAI 的解释是:

隐藏思维链的初衷是为了保证模型“思考”过程的独立性和表达自由,防止外部干预或操控其推理逻辑。展示模型的完整思维链可能会暴露不一致性,从而影响用户体验。

这项决策基于多方面的考虑:一方面是为了确保安全性和遵守相关策略,另一方面是为了保持技术竞争优势,防止竞争对手利用推理成果进行训练。

作为对大型语言模型发展持保留态度的一方,威利森对这一决定表示不满。他认为,在追求技术创新的同时,保持可解释性和透明度至关重要。隐藏关键细节意味着削弱透明度,这感觉像是一个倒退的举措。

- 示例解释

(注:由于原句较为简略,根据上下文推测其意并适当扩展。若需更精确的翻译或改写,请提供更多的背景信息或具体语境。)

OpenAI 在“思维链”部分提供了许多示例,包括生成 Bash 脚本、解答填字游戏和计算化学溶液的 pH 值等,初步展示了这些模型在 ChatGPT 用户界面下的思维链能力。然而,它并没有直接展示原始的推理 Token,而是通过一种优化机制,将复杂的推理步骤简化成易于理解的摘要。

OpenAI 还提供了两份附加文档,展示了更为复杂的应用实例。其中,“使用推理进行数据验证”这一案例中,o1-preview 展示了如何在包含 11 列的 CSV 文件中生成示例,并通过多种策略确保数据的准确性。而在“使用推理生成例程”的案例中,则介绍了如何将知识库文章转换为大型语言模型可以理解和执行的标准化操作流程。

威利森还在社交媒体上收集了许多GPT-4未能成功应对但在O1-preview上表现优异的提示案例。其中有两个特别引人注目:

字数统计挑战:“你对这个提示的回答有多少字?”在给出“这个句子里有七个词”之前,o1-preview模型耗时约十秒,并经历了五次推理过程。

幽默解析:让我们来解释这个笑话——“两头牛站在田地里,其中一头牛问另一头牛:‘你怎么看待疯牛病?’ 另一头牛回答说:‘我无所谓,我是直升机。’” o1-preview 对这个笑话做出了合理且详细的解释,而其他模型则无法解答。

尽管如此,高质量的例子仍然不多。OpenAI 研究员 Jason Wei 指出,虽然 o1 在 AIME 和 GPQA 测试中的表现非常出色,但这种效果并不总是显而易见。找到让 GPT-4o 拗手而 o1 能够大放异彩的提示并非易事,但一旦找到了,o1 的表现确实令人惊叹。大家还需要继续寻找更具挑战性的提示。

另一方面,沃顿商学院的管理学教授及人工智能专家伊森·莫里克(Ethan Mollick)在进行了几周的预览体验后,对 o1 提出了初步的评价。他特别提到了一个填字游戏的例子,在这个例子中,o1-preview 模型展示了清晰的推理步骤,比如指出 1 Across 和 1 Down 的首字母不匹配,并主动建议替换答案以确保一致性。

- 推理模型的未来发展

这一新的人工智能进展带来了许多待解之谜和潜在机遇,社区正在逐步探索这些模型的最佳应用场景。在此过程中,威尔森预计GPT-4(及Claude 3.5 Sonnet等模型)将继续发挥重要作用。同时,我们也将见证这些推理模型如何拓展我们的思维模式,解决更多前所未有的任务。

此外,威利森希望其他人工智能实验室,特别是开放模型权重社区,能够积极跟进,利用各自独特的模型版本来重现并进一步深化这些思维链推理的成果。