元象发布中国最大的开源MoE模型,拥有255B参数,并且无条件免费商用。

编辑日期:2024年09月14日

元象XVERSE发布了中国最大的MoE(Mixture of Experts)开源模型——XVERSE-MoE-A36B。该模型拥有总计255B个参数,激活参数为36B,并实现了相对于100B模型的“跨级别”性能飞跃。相比之前,训练时间减少了30%,推理性能提升了100%,从而大幅降低了每token的成本。

在多项权威评估中,元象的MoE模型表现出色,超越了多个同类模型,包括国内的千亿参数模型Skywork-MoE、传统的MoE霸主Mixtral-8x22B,以及拥有3140亿参数的开源模型Grok-1-A86B。

MoE是一种前沿的混合专家模型架构,通过组合多个细分领域的专家模型,打破了传统扩展定律(Scaling Law)的限制,在扩大模型规模的同时,不会显著增加训练和推理的计算成本,从而保持模型性能的最大化。因此,许多行业领先的模型,如谷歌的Gemini-1.5、OpenAI的GPT-4以及马斯克旗下xAI公司的Grok,都采用了MoE架构。

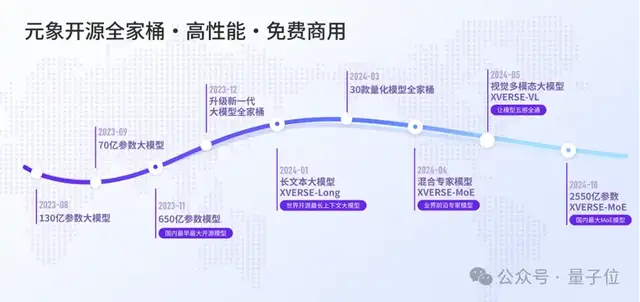

值得一提的是,元象的“高性能全家桶”系列全部开源,免费商用,让广大中小企业、研究者和开发者能够根据需求自由选择。

今年4月,元象推出了XVERSE-MoE-A4.2B。与传统MoE(如Mixtral 8x7B)将每个专家的大小等同于标准FFN不同,元象采用了更细粒度的专家设计,每个专家的大小仅为标准FFN的四分之一,提高了模型的灵活性和性能;此外,还引入了共享专家(Shared Expert)和非共享专家(Non-shared Expert)两种类型。

共享专家在整个计算过程中始终处于激活状态,而非共享专家则根据需求进行选择性激活。这种设计有助于将通用知识集中压缩到共享专家的参数中,减少非共享专家参数之间的知识冗余。

此次发布的XVERSE-MoE-A36B,在MoE的效率和效果上进行了技术创新。

(1)在效率方面

-

MoE架构与4D拓扑设计:MoE架构的核心是多个专家组成的系统。由于专家之间需要大量信息交换,通信负担较重。为解决这一问题,我们采用了4D拓扑架构来平衡通信、显存及计算资源的分配。该设计优化了计算节点间的通信路径,提升了整体计算效率。

-

专家路由与预丢弃策略:MoE的一个重要特性是“专家路由机制”,即对不同输入进行分配,并丢弃超出专家计算容量的冗余数据。为此,我们设计了一套预丢弃策略以减少不必要的计算和数据传输。此外,在计算过程中实现了高效的算子融合,进一步提升了模型训练性能。

-

通信与计算重叠:鉴于MoE架构中专家间需要大量通信,这可能影响整体计算效率。因此,我们设计了“多维度通信与计算重叠”机制,即在进行参数通信的同时,尽可能多地并行执行计算任务,以此减少通信等待时间。

(2)在效果方面

- 专家权重:在MoE模型中,共有N位专家,每个token会选择topK个专家参与后续计算。由于专家容量有限,每个token实际选择的专家数为M,其中M≤K<N。被选中的专家完成计算后,通过加权平均的方式汇总出每个token的结果。专家权重的设定是一个关键问题,我们通过对比实验来确定最佳配置。

根据对比实验的结果,我们选择了实验2的设置进行正式实验。

实验结果如下:

元象发布了中国规模最大的开源MoE模型,该模型拥有2个专家集。假设N=8,K=4,M=3(其中第2个专家集中的token被丢弃),不同专家权重的计算结果如下图所示:

数据动态切换:传统的开源模型通常在训练开始前就固定了训练数据集,并在整个训练过程中保持不变。这种方法虽然简单,但却受限于初始数据的质量和覆盖面。本次发布的MoE模型借鉴了“课程学习”的概念,在训练过程中实现了数据集的动态切换,即在不同阶段引入新的高质量数据,并动态调整数据采样比例。

这使得模型不再受限于初始语料集,而能够不断学习新引入的高质量数据,从而扩大语料覆盖面并提高泛化能力。此外,通过调整采样比例,还能帮助平衡不同数据源对模型性能的影响。

学习率调度策略(LR Scheduler):尽管动态切换数据集有助于持续引入新知识,但也为模型带来了新的适应挑战。为了确保模型能够迅速且充分地学习新数据,研究团队优化了学习率调度器,在每次数据切换时依据模型的收敛状态相应调整学习率。实验结果显示,这一策略显著提高了模型在数据切换后的学习速度和整体训练效果。

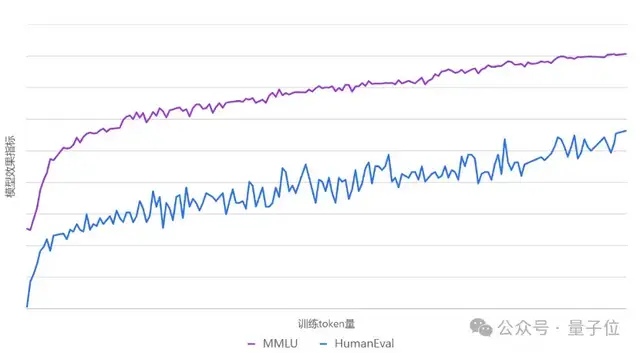

下图展示了整个训练过程中MMLU和HumanEval两个评测数据集的效果曲线图。

在训练过程中,MMLU和HumanEval的性能曲线持续上升。

经过设计与优化,元象的MoE模型相较于其Dense模型XVERSE-65B-2,训练时间减少了30%,推理性能提升了100%,模型效果更优,达到了业界领先水平。

值得一提的是,这并非元象首次进行开源工作。

元象发布中国最大的开源MoE模型,拥有2

2023年11月,此前国内大多数开源模型的参数规模大多在7B到13B之间。业界普遍认为,只有当模型参数达到50B到60B时,才能实现真正的“智能涌现”。在生态系统急需更大规模模型的时候,元象率先开源了XVERSE-65B,这是当时中国参数规模最大的开源模型。

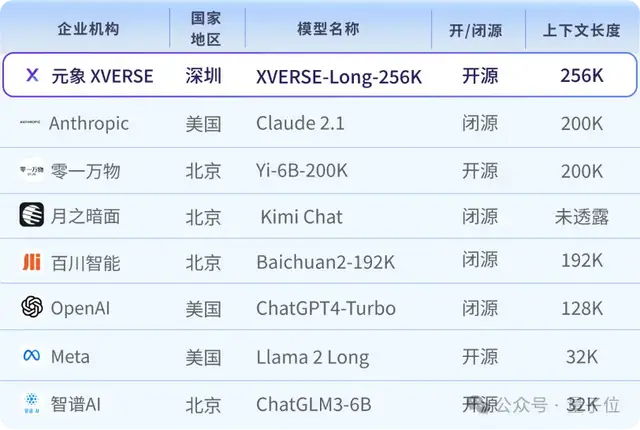

2024年1月,元象再次开源了一款具备全球最长上下文窗口的大模型,支持输入25万汉字,并附带详细的训练教程,使大模型的应用进入了“长文本时代”。

此次发布的国内最大参数MoE开源模型,为生态系统贡献了一个推动低成本AI应用的强大工具。

元象基于MoE模型自主研发的AI角色扮演与互动网文APP “Saylo”,凭借逼真的AI角色扮演和有趣的开放剧情,在港台地区大受欢迎,下载量在中国台湾和香港的娱乐榜单中分别位居第一和第三。

MoE训练范式具有“更高性能、更低成本”的优势。元象在通用预训练的基础上,使用海量剧本数据进行“继续预训练”(Continue Pre-training),并不同于传统的SFT(监督微调)或RLHF(基于人类反馈的强化学习),而是采用大规模语料知识注入的方式,使得模型不仅保持了强大的通用语言理解能力,还在特定应用领域如“剧本”方面大幅提升了表现。

在此之前,借助其在AI和3D领域的客户积累,元象迅速将大模型推向商用市场。

2023年11月,元象成为全国首批、广东省前五家获得《生成式人工智能服务管理暂行办法》国家备案的大模型之一,具备向全社会开放的产品能力。而在同年10月,元象与腾讯音乐联手推出了LyraXVERSE加速大模型,并借助这一技术全面升级了音乐助手“AI小琴”的问答、聊天与创作功能,使其情商和智商兼备,为用户提供更加个性化、深入且富有陪伴感的音乐互动体验。

元象大模型还陆续与QQ音乐、虎牙直播、全民K歌、腾讯云等平台展开深度合作与应用探索,为文化、娱乐、旅游和金融等领域打造创新领先的用户体验。

此外,元象还发布了更轻量级的9B版本模型,该模型完全不使用注意力机制,并同步上线了13B对话模型。以下是相关图片链接:

- 元象发布中国最大的开源MoE模型

- 元象发布中国最大的开源MoE模型

- 元象发布中国最大的开源MoE模型

- 元象发布中国最大的开源MoE模型

- 元象发布中国最大的开源MoE模型

- 元象发布中国最大的开源MoE模型

大家在看

<a href="/ai-install" class="card card-1">

<img src="https://chat-ex.com/assets/2326231.png" alt="图标描述" style="transform: scale(0.7);">

<div class="card-content">

<span>AI安装教程</span>

<div class="tooltip">AI本地安装教程</div>

</div>