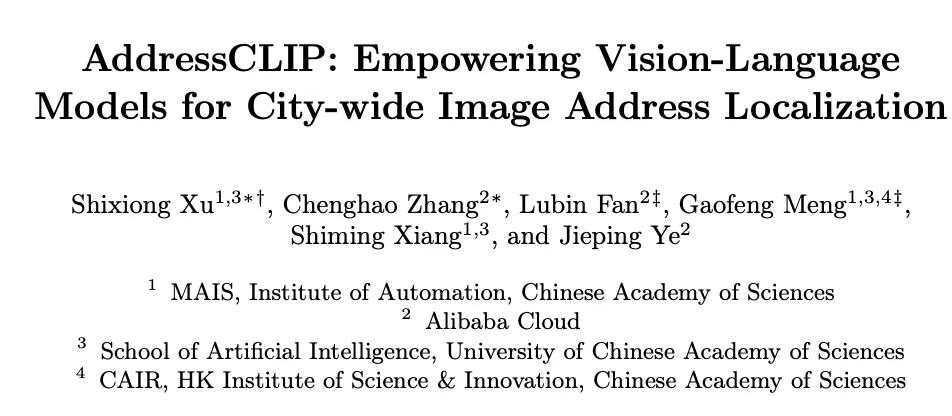

一张图实现街道级定位:端到端图像地理定位大模型 AddressCLIP 登上 ECCV 2024

编辑日期:2024年09月14日

拔草星人的好消息来了!

中国科学院自动化研究所与阿里云联合推出了一款街景定位大模型——AddressCLIP。只需一张照片,就能实现街道级别的精准定位。

有了这款模型的帮助,再也不怕遇到种草的“谜语人”了。

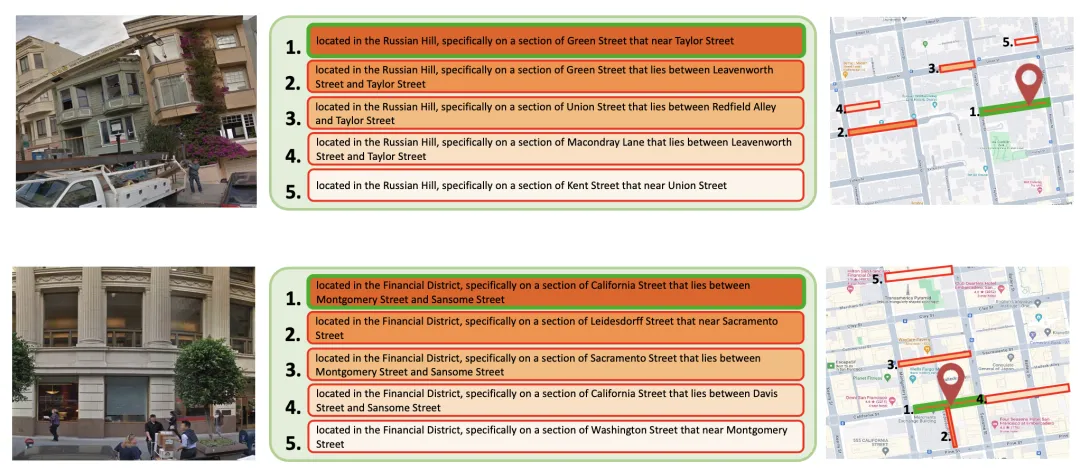

例如,给模型一张旧金山的街景照片后,它不仅能给出具体的拍摄位置,还能列出附近的多个候选地址。

该模型名为AddressCLIP,基于CLIP改造而来。相关论文《AddressCLIP: Empowering Vision-Language Models for City-wide Image Address Localization》已被选入顶级会议ECCV 2024。

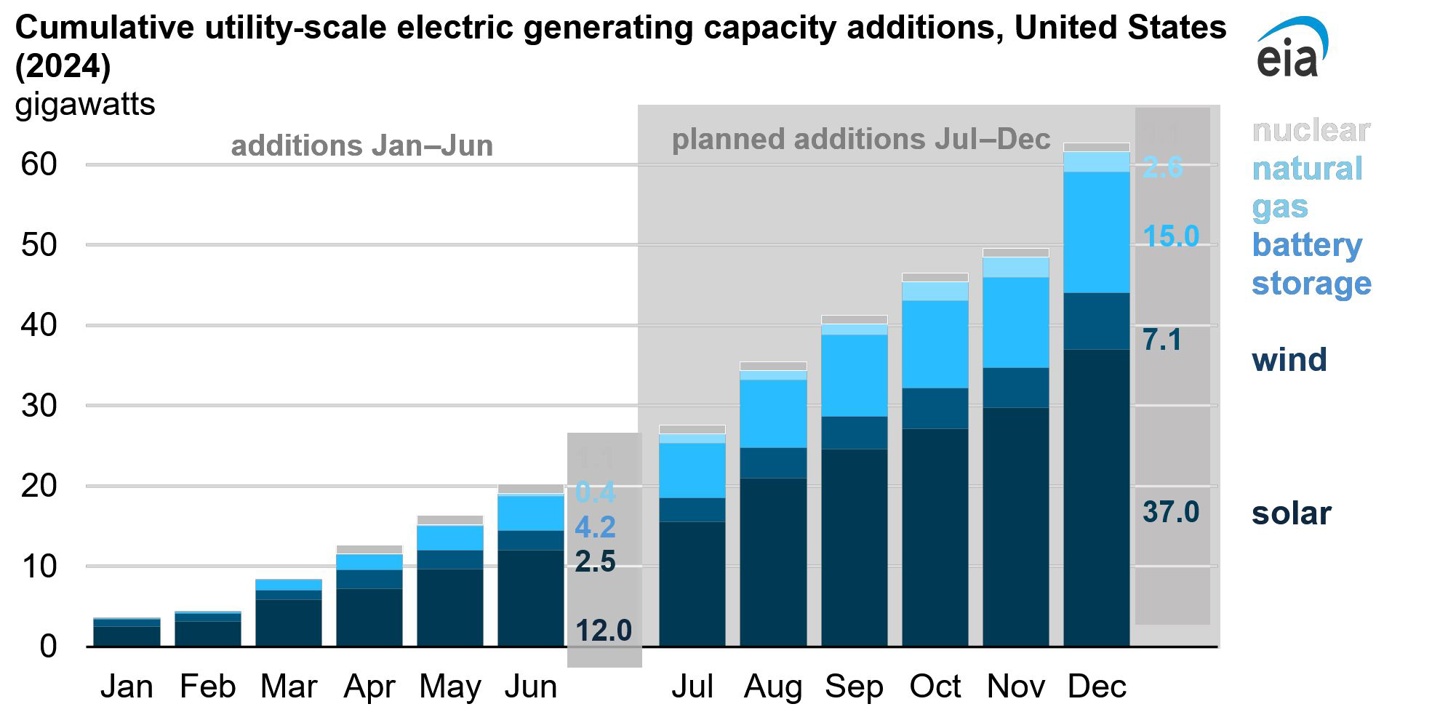

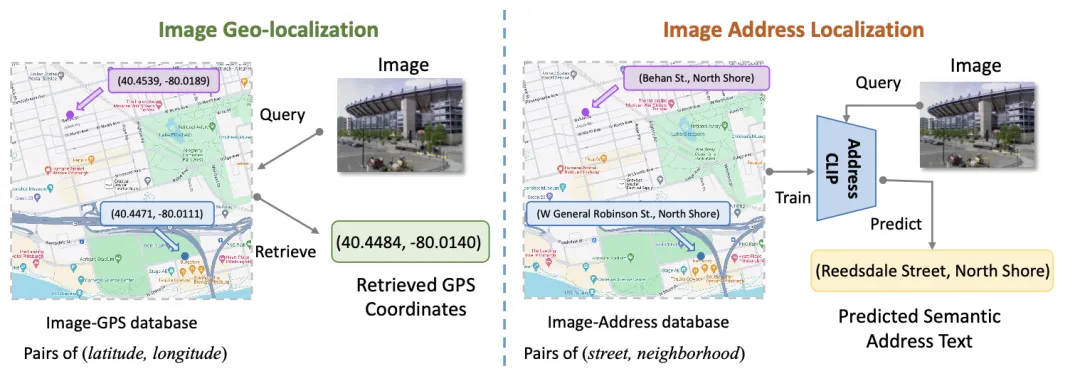

传统的图像位置识别通常通过图像检索来确定图像的GPS坐标,这种方法被称为图像地理定位。然而,GPS坐标对普通人来说难以理解,而且图像检索需要维护一个庞大的数据库,难以在本地部署。

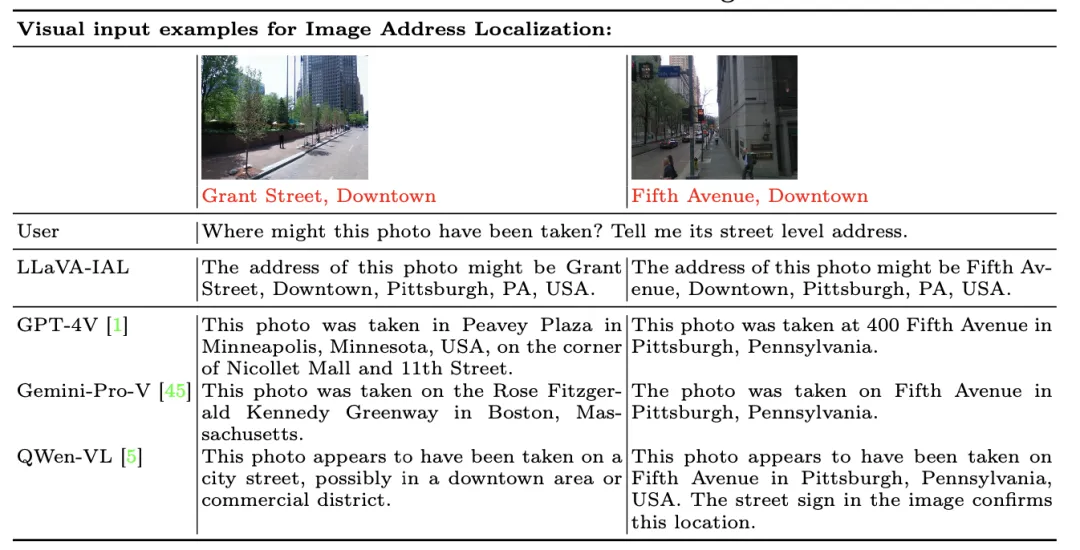

本项工作提出了一种更用户友好的端到端图像地理定位方法。以下是两种方法的对比示意图:

为实现这一目标,研究人员主要从数据集构建和定制化模型训练两个方面进行了研究。

图像地址定位本质上需要将街景图像与地址文本进行图文模态的对齐。因此,首先需要收集大量图像-地址对。由于现有用于多模态训练的图文数据中包含地址信息的比例过低,研究人员选择基于图像地理定位中的图像-GPS数据对来构建数据集。

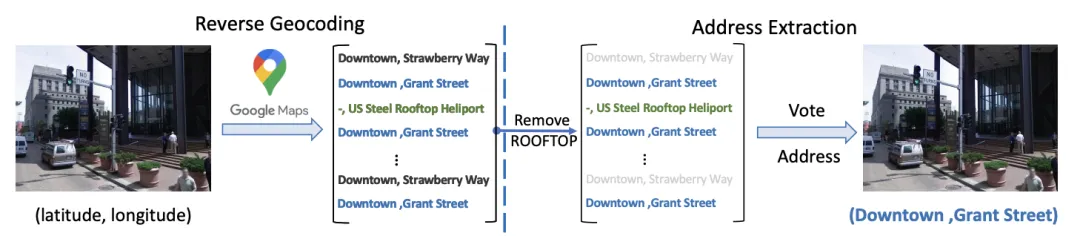

具体而言,通过使用地图中的 Reverse Geocoding API,可以将一个 GPS 查询结果转换为一系列接近的实际地址。然后,通过筛选和投票等数据清洗方法,可以过滤出每个图像对应的街道级地址文本。

这一过程如以下示意图所示:

然而,由于街道长度存在显著差异,这种分布极其不均衡,并且街道级定位的精度仍显粗糙。

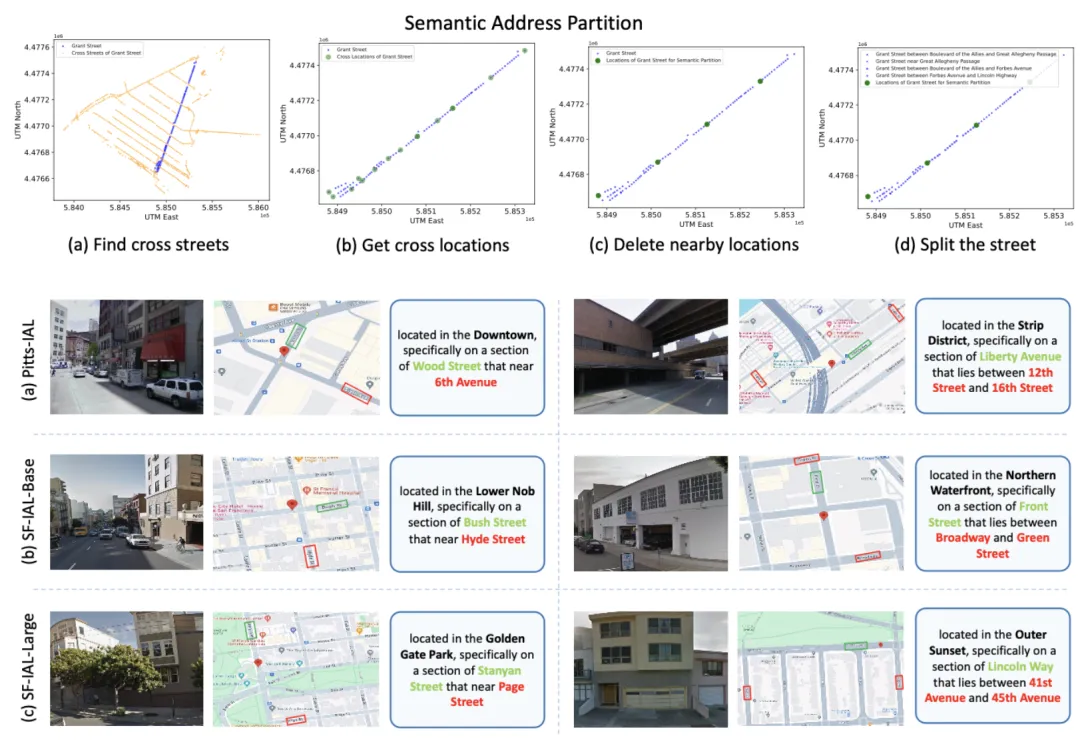

因此,研究人员模仿人类描述位置的习惯,对街道级地址进行了进一步的语义划分。这一过程利用了道路交叉口等信息来增强地址信息,具体步骤及最终形成的地址文本描述如下:

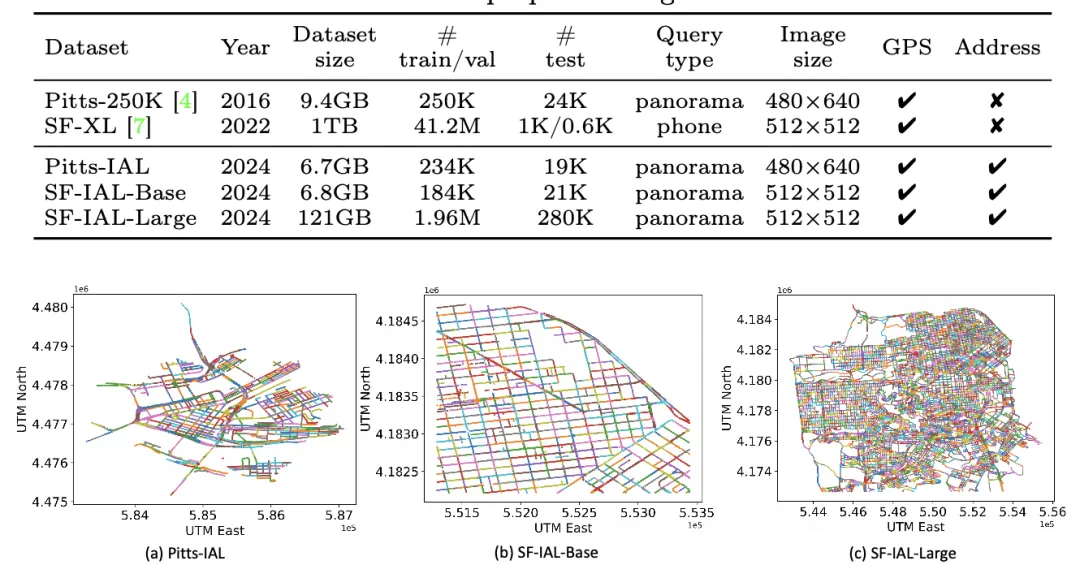

最终,研究者构建了两个城市中三种不同尺度的数据集,相关数据信息如下:

有了这些街景-地址文本的数据准备后,似乎可以直接模仿 CLIP 的方式进行对比学习的微调。但由于本任务中的图像-文本数据对之间的语义关联非常微弱,与 CLIP 预训练数据存在较大差异。

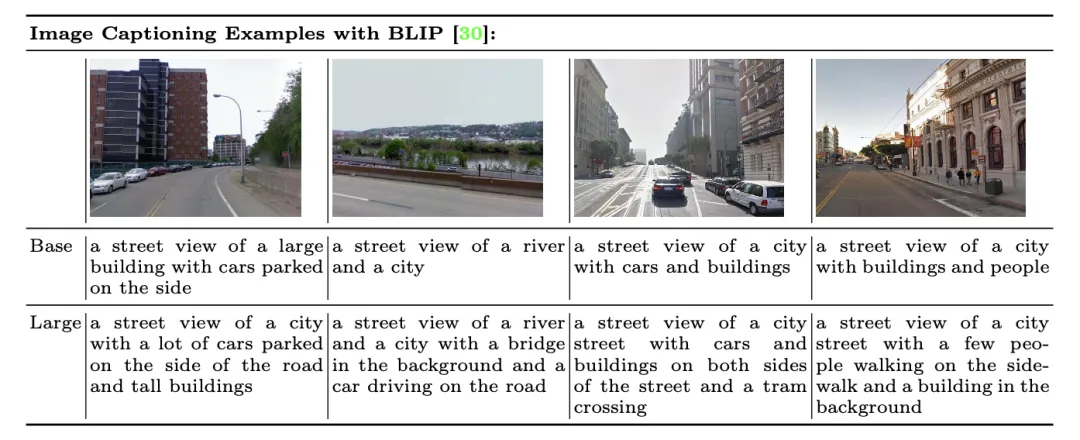

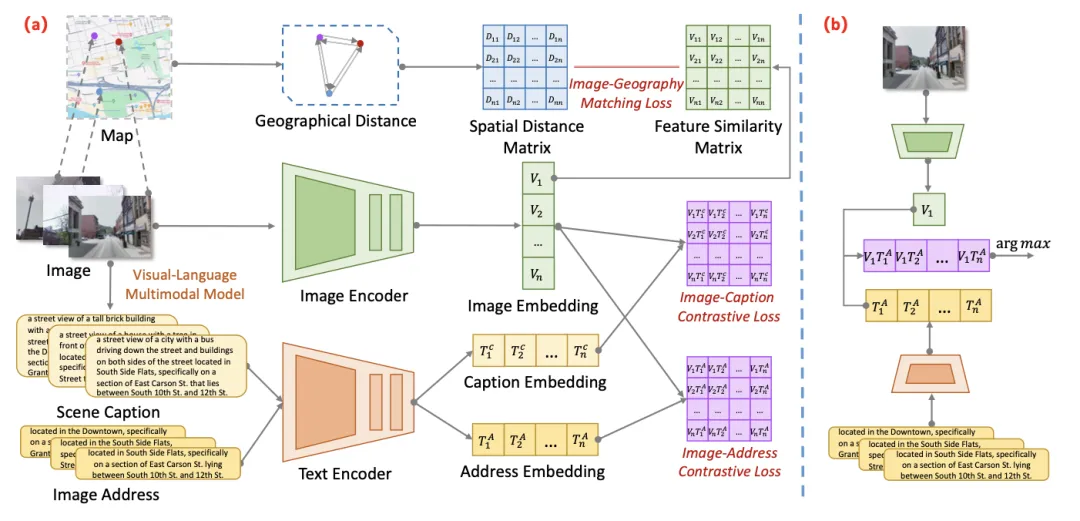

因此,研究人员首先在数据和损失函数层面对 CLIP 原始训练框架进行了改进。具体来说,借助 BLIP 等多模态生成模型的图像标注能力,研究人员对训练数据中的每个街景图像进行了自动化的语义文本标注。

然后,作者根据一定的规则将语义文本与地址文本直接拼接起来,明确地弥补了当前任务与CLIP预训练任务之间的差异。这使得微调过程更容易优化,并且通过语义信息增强了地址文本的辨别能力。

同时,考虑到图像特征与地址文本特征在预训练特征空间中的分布可能极不均匀。

受流形学习的启发,作者认为图像-地址文本的理想特征应该位于一个与实际环境相匹配的低维流形上。

具体来说,研究者引入了这样一种假设:在真实地理环境中距离相近的两个点,其地址和图像特征在特征空间中也应接近,反之亦然。

他们利用图像间的实际地理距离(经过归一化处理)来监督这些图像在特征空间中的距离,从而实现了图像特征与真实地理环境在距离层面的匹配,使模型学习到的特征空间更加均匀。

因此,AddressCLIP优化了传统的CLIP损失函数,将其转变为图像-地址文本对比损失、图像-语义对比损失以及图像-地理匹配损失,最终实现了图像与地址文本之间准确而均匀的对齐。

完成上述训练后,AddressCLIP可以通过给定候选地址集来进行推理。值得注意的是,由于模型在图像与各种地址之间建立了良好的对齐关系,推理时使用的候选文本可以非常灵活多样,而不必严格遵循训练集中的书写规则。

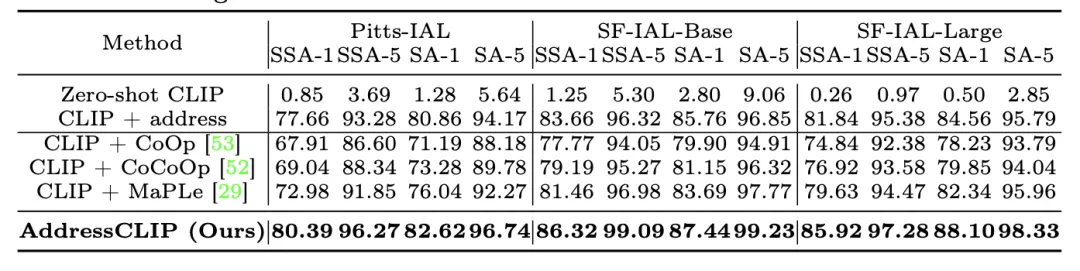

在定量实验结果中,团队主要将模型与zero-shot CLIP、直接对齐地址的CLIP以及各种CLIP微调策略进行了对比。结果显示,AddressCLIP在不同数据集和不同评价指标上均优于所有对比方法。

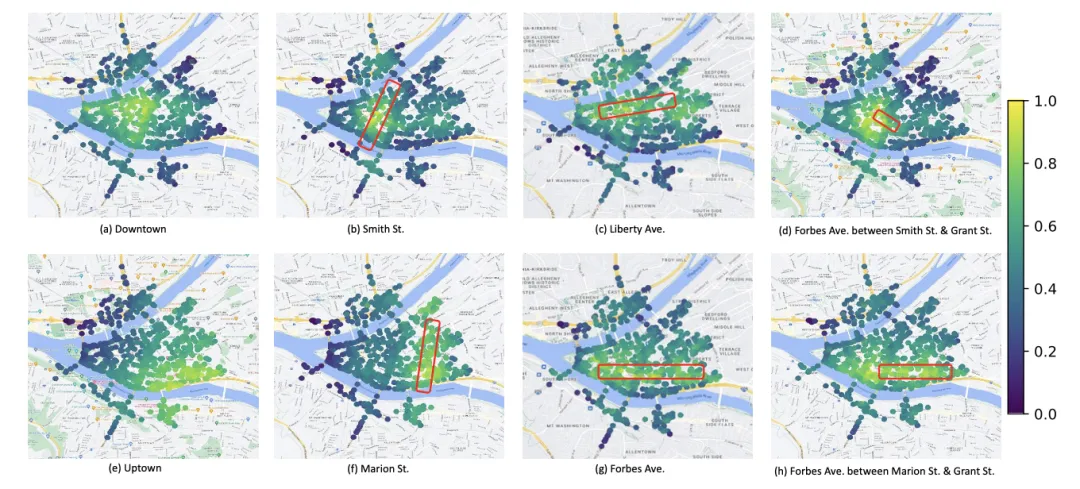

在定性实验中,论文主要展示了AddressCLIP在推理形式上的灵活性与泛化能力。

通过提供不同精细程度的地址文本查询(如街区、街道、子街道),模型能够在测试集图像上展示出与其实际地理分布相符的激活结果。

此外,研究人员还设想了将这一任务和数据集与多模态大模型相结合的应用场景。

通过将数据集构造成地址问答的多轮对话形式,研究团队对 LLaVA-1.5-vicuna 进行了视觉指令微调,实现了图像地址的生成式识别。

在与前沿多模态模型的对比中,该方法表现出显著优势,尤其是在处理图像中没有明显地标或线索的情况下。

作者预计,未来这一技术可以进一步应用于社交媒体中的基于位置的个性化推荐,或者与多模态大模型结合,以提供更加丰富的地址和地理信息相关的问答服务,从而打造更加智能的城市和地理助手。

论文地址:

https://arxiv.org/abs/2407.08156

项目主页:

https://addressclip.github.io

GitHub:

https://github.com/xsx1001/AddressCLIP

“比ChatGPT更接近AGI”

从浅层对齐到深度融合

自动驾驶新解法

三天内训练完成130亿参数的通用VLM

三天内训练完成130亿参数的通用VLM

从“A股AI视觉第一股”到“多模态应用先行者”

模型权重已开源