Qwen2.5 登上全球开源榜首!72B 超越 Llama3 405B,轻松胜过 GPT-4-o-mini。

编辑日期:2024年09月20日

在指令跟踪、长文本生成、结构化数据理解及结构化输出生成等方面,Qwen2.5均有显著提升。

击败Llama3!Qwen2.5登顶全球开源榜首。

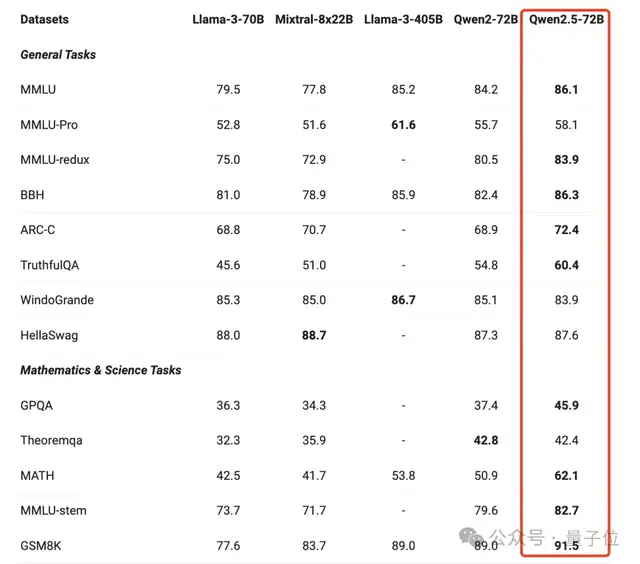

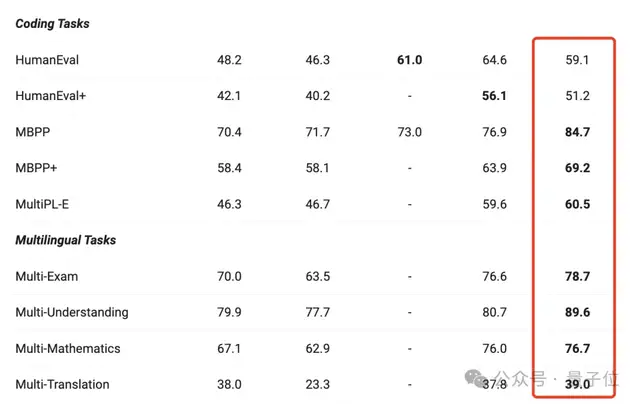

尽管参数规模仅为Llama3的五分之一,Qwen2.5在多项任务中的表现已超越Llama3 405B。

Qwen2.5在各类任务上的表现远超同类模型。

与前一代相比,它在各方面几乎实现了全面提升,尤其是在通用任务、数学和编程方面表现出色。

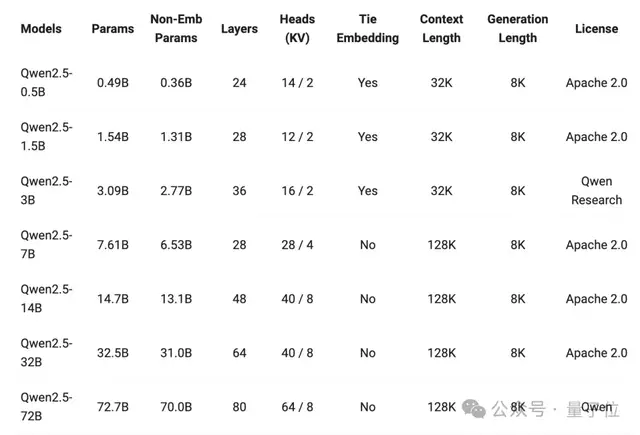

值得注意的是,此次Qwen的开源规模空前,基础模型直接发布了7种不同参数的版本,其中包括多个数学和代码模型。

例如,14B、32B以及轻量级Turbo模型的表现超过了GPT-4o-mini。除了3B和72B模型之外,所有开源模型均采用Apache 2.0许可。

不少网友已经开始使用Qwen2.5,并对其性能赞不绝口。

相较于Qwen2系列,Qwen2.5系列的主要升级包括:

- 全面开源。 研究发现,用户对适用于生产环境的10B至30B参数范围的模型及适用于移动应用的3B规模模型非常感兴趣。

因此,在原有的0.5/1.5/7/72B参数模型基础上,新增了14B、32B及3B模型。

此外,通义还推出了Qwen-Plus和Qwen-Turbo版本,用户可通过阿里云大模型服务平台的API进行体验。

显示,超过一半的模型支持128K的上下文,并且最多可以生成8K的上下文。

显示,超过一半的模型支持128K的上下文,并且最多可以生成8K的上下文。

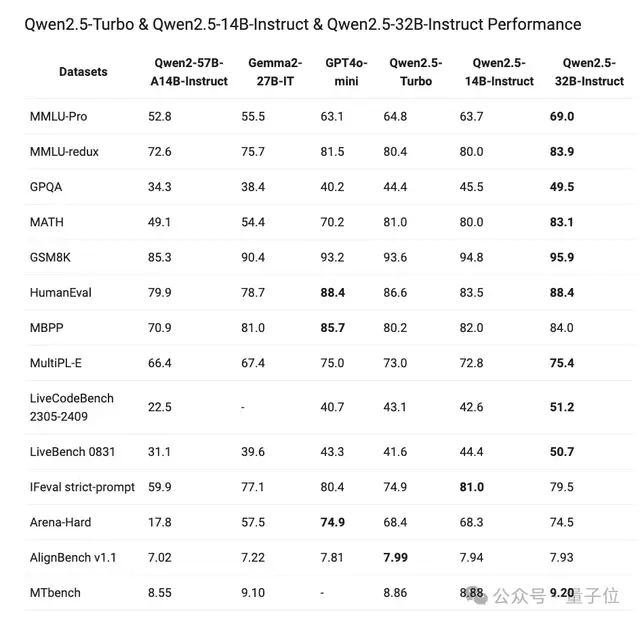

在综合评测中,所有模型相较于上一代实现了显著的能力提升。例如,Qwen2.5-32B的表现优于Qwen2-72B,而Qwen2.5-14B则超过了Qwen2-57B-A14B。

此外,预训练数据集也变得更加庞大且高质量,从原来的7万亿个token扩大到了最多18万亿个token。

这些模型在多个方面的能力得到了增强,包括获取更多知识、提高数学编码能力以及更好地符合人类偏好。

同时,在指令跟踪、长文本生成(从1k增加到8K以上token)、结构化数据理解(如表格)以及结构化输出生成(特别是JSON格式)等方面也有显著提升。

让我们来看一下实际效果。

表格理解

生成JSON输出

Qwen2.5模型总体上具有更强的系统提示多样性的适应能力,增强了聊天机器人的角色扮演实现和条件设定能力。

具体来看一下各模型的能力表现。

旗舰模型在前文已经展示,它在各项任务中都有明显进步。

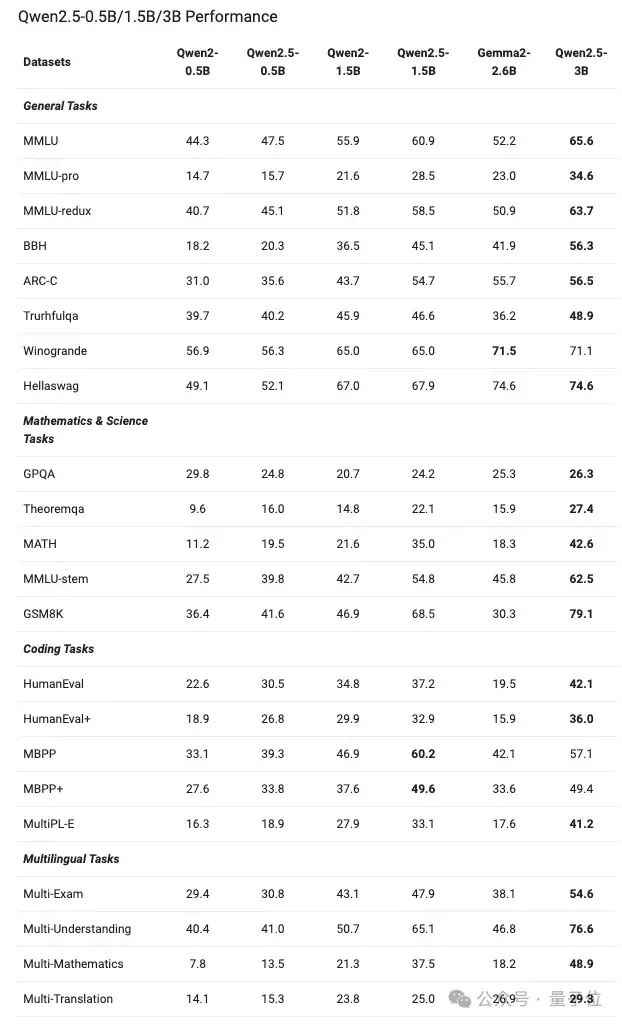

对于较小的模型,如0.5B、1.5B和3B,其性能如下所示:

值得一提的是,Qwen2.5-0.5B在各种数学和编码任务中的表现优于Gemma2-2.6B。

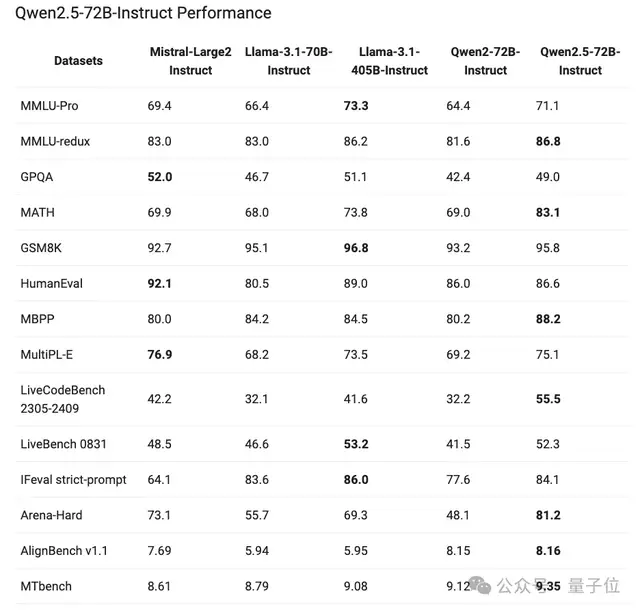

除此之外,Qwen2.5展示了指令调优后的模型性能提升,其中72B-Instruct在几项关键任务中超越了更大的Llama-3.1-405B,特别是在数学(MATH:83.1)、编码(LiveCodeBench:55.5)和聊天(Arena-Hard:81.2)方面表现突出。

此外,32B-Instruct、14B-Instruct以及Qwen2.5-Turbo也展示了与GPT-4o-mini相当的能力。

除了基础模型外,此次Qwen还发布了代码和数学专业模型。

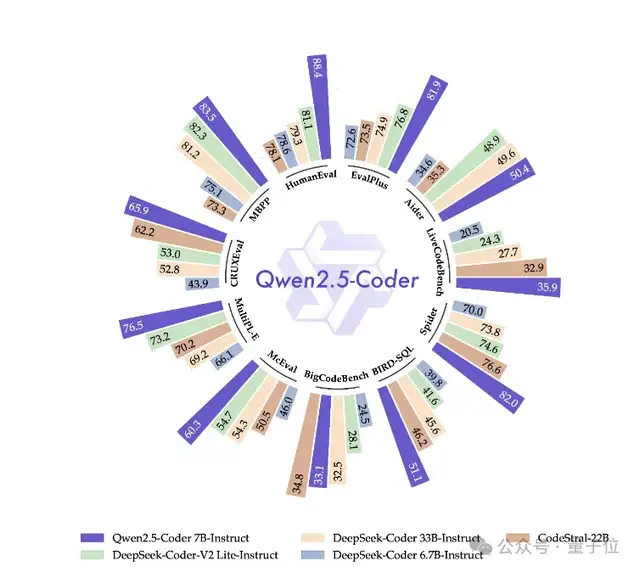

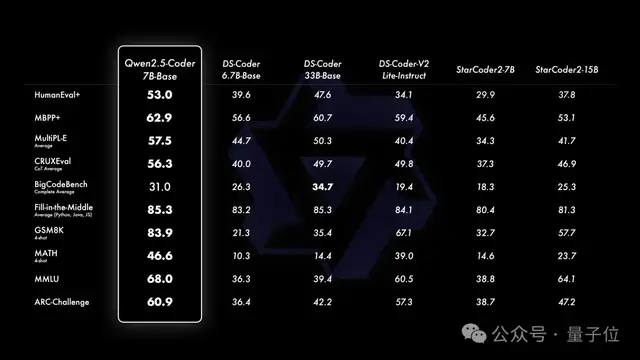

Qwen2.5-Coder提供了三种不同规模的模型:1.5B、7B和32B版本(即将推出)。

其主要改进在于扩大了代码训练数据规模,并增强了编码能力。Qwen2.5-Coder在大规模的代码数据集上进行了训练,包括源代码、文本代码基础数据和合成数据,总共有5.5万亿个token。

该模型支持128K上下文,涵盖92种编程语言。开源的7B版本甚至超越了DeepSeek-Coder-V2-Lite和Codestral等更大型的模型,成为当前最强大的基础代码模型之一。

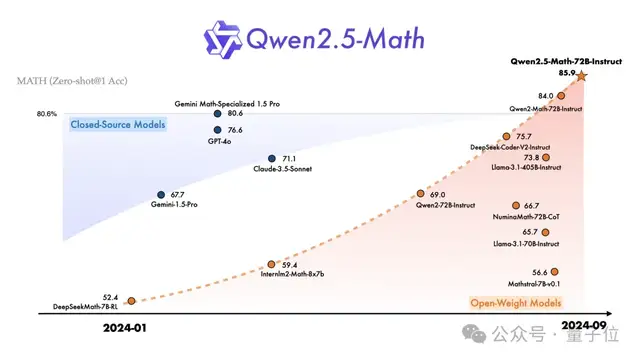

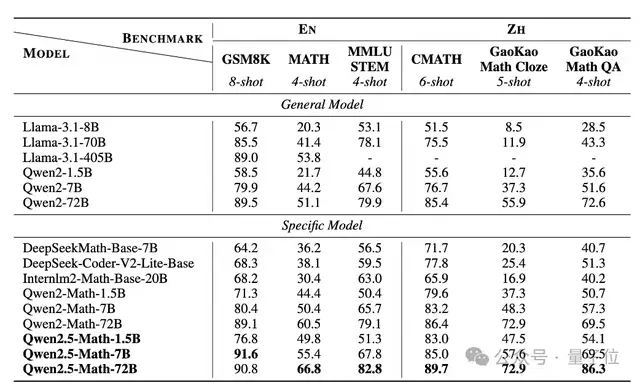

而在数学模型方面,Qwen2.5-Math主要支持通过CoT和TIR解决英文和中文数学问题。目前不建议将此系列模型用于其他任务。

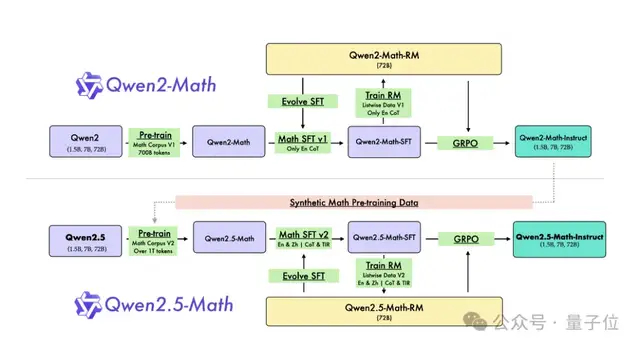

Qwen2.5-Math 系列包括基础模型 Qwen2.5-Math-1.5B/7B/72B、指令调优模型 Qwen2.5-Math-1.5B/7B/72B-Instruct 以及数学奖励模型 Qwen2.5-Math-RM-72B。与 Qwen2-Math 系列仅能用思维链(CoT)解决英文数学问题不同,Qwen2.5-Math 系列不仅支持思维链,还支持工具集成推理(TIR),能够解决中英文数学问题。

与前一版本相比,Qwen2.5-Math 主要通过以下三项改进实现了基础模型的升级:

- 利用 Qwen2-Math-72B-Instruct 模型合成额外的高质量数学预训练数据。

- 从网络资源、书籍和代码中收集更多高质量的数学数据,特别是中文数据,并覆盖多个时间段。

- 使用 Qwen2.5 系列基础模型进行参数初始化,从而增强语言理解、代码生成和文本推理能力。

这些改进使得 1.5B、7B 和 72B 模型在高考数学问答中的表现分别提高了 3.4 分、12.2 分和 19.8 分。

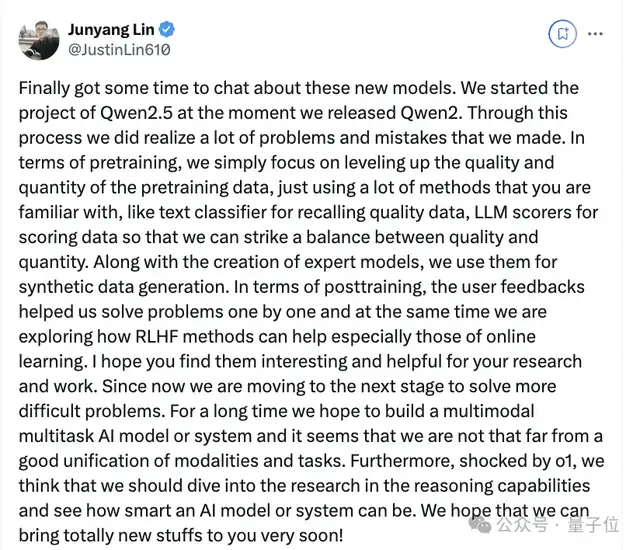

至此,Qwen2.5 系列完成了堪称“史上最大规模”的开源。阿里巴巴通义开源负责人林俊旸也分享了一些背后的细节。

他表示,自 Qwen2 开源之日起,Qwen2.5 项目就已经启动。

在这个过程中,他们发现了许多问题和错误。例如,在预训练阶段,他们只专注于提高预训练数据的质量和数量,并采用了大家熟知的多种方法,如使用文本分类器来召回高质量数据,以及利用LLM评分器对数据进行评分,从而在质量和数量之间找到平衡。

此外,在创建专家模型的同时,团队还利用这些模型生成了合成数据。在后期训练中,用户反馈帮助他们逐一解决问题,同时他们也在探索RLHF方法,特别是在线学习方法。

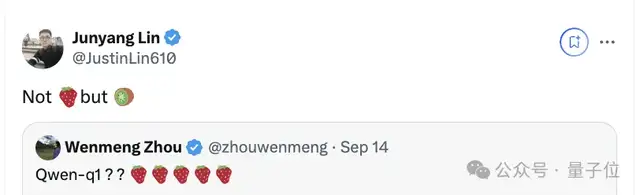

对于未来的升级和更新,他们表示受到o1的启发,认为应深入研究推理能力。值得一提的是,在Qwen2.5预热期间,团队透露该版本不叫草莓,而是称为猕猴桃。

现在,猕猴桃可以迅速投入使用了。

参考链接: [1] https://x.com/JustinLin610/status/1836461575965938104 [2] https://x.com/Alibaba_Qwen/status/1836449414220779584 [3] https://qwenlm.github.io/blog/qwen2.5/ [4] https://qwenlm.github.io/blog/qwen2.5-llm/ [5] https://qwenlm.github.io/blog/qwen2.5-coder/ [6] https://qwenlm.github.io/blog/qwen2.5-math/

大家在看