开源版《Her》现已发布,技术报告也已公开!大师Karpathy点评:它极具个性

编辑日期:2024年09月20日

实时语音模型 Moshi

知名专家Karpathy大力推荐,开源版「Her」Moshi再度引发关注!

Moshi的性格十分有趣,它有时会间歇性地中断,偶尔还会无缘无故地陷入沉默……

据悉,Moshi是由法国创业团队Kyutai在今年7月初推出的一款端到端实时音频模型。发布之后,所有人都可以免费使用,并且Kyutai刚刚公开了Moshi的代码和技术报告。

这一消息令人惊喜。谷歌DeepMind的研究员、ViT作者Lucas Beyer闻讯而来:

(正好)我最近就想了解这个问题

开源工程师Sebastian Rojo立即进入学习状态:

是时候开始学习了!

当然,一向行动迟缓的OpenAI再次被“公开批评”。(其高级语言模型在7月底上线后,依然仅对少数人开放)

令人惊叹的是,当我们还在等待OpenAI的高级语音模型时,大家已经可以开始使用Moshi并着手开发了。

废话不多说,我们来看看Kyutai此次公开了哪些内容。

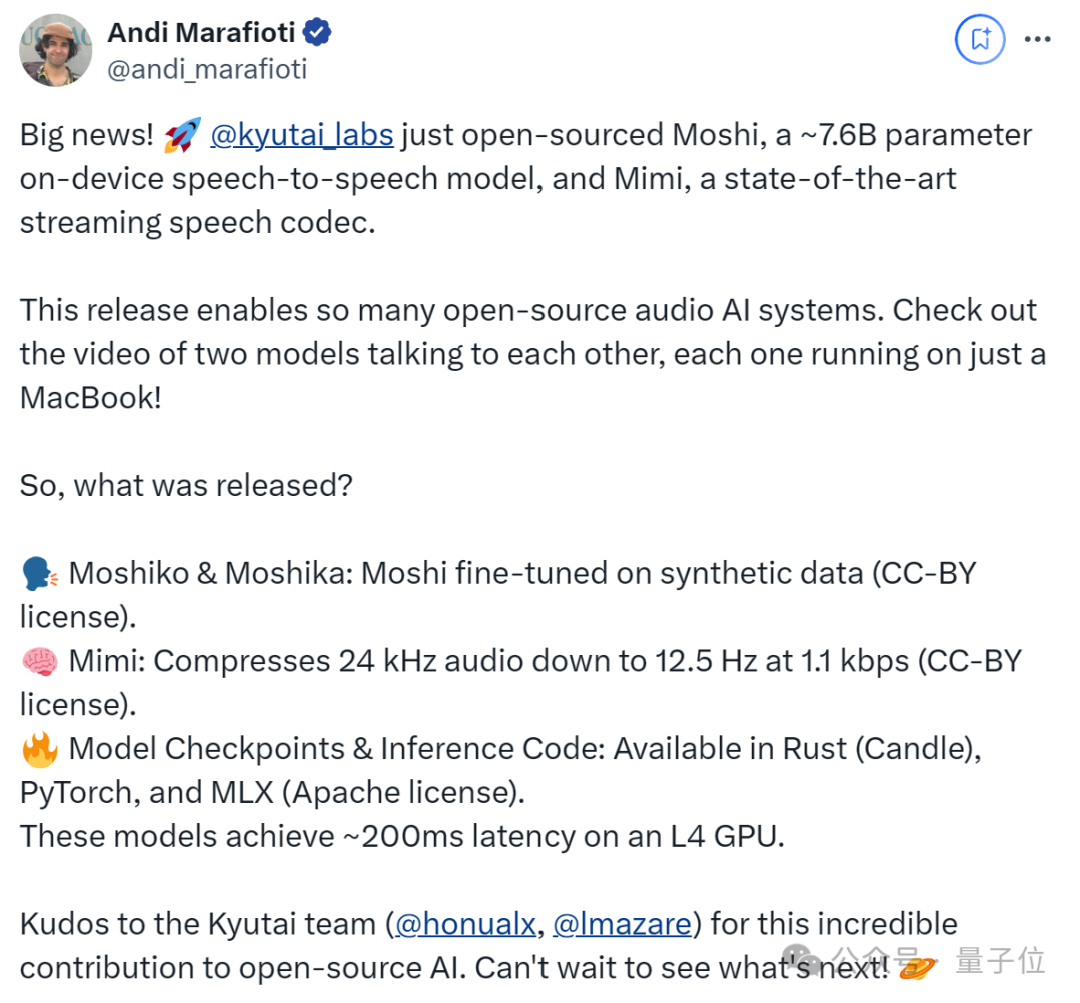

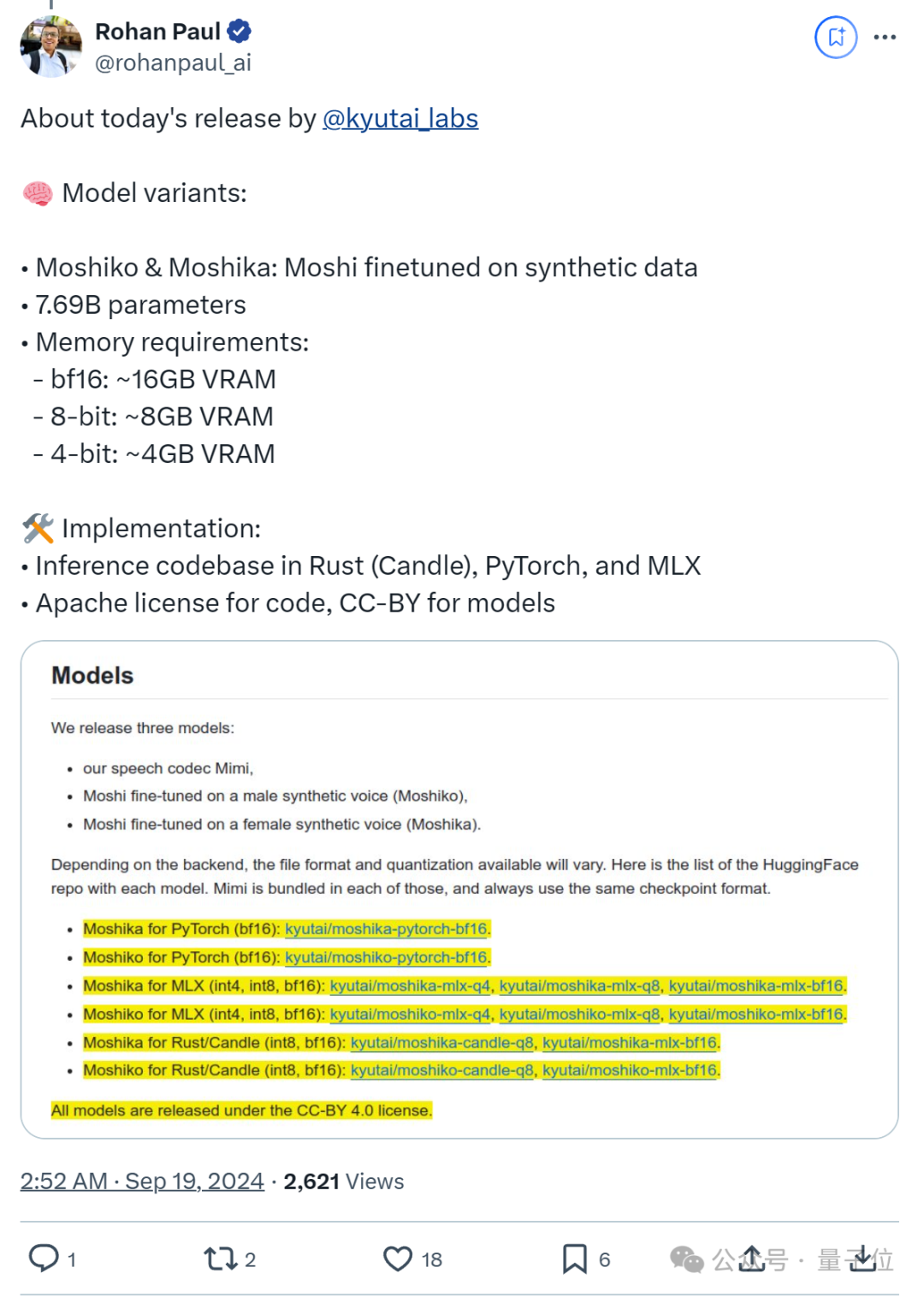

首先,我们来看看模型部分。本次Kyutai发布了三款模型:Moshiko、Moshika 以及 Mimi 流语音编解码器。Moshi 模型的参数量约为 7.69B,而 Moshiko 和 Moshika 则是基于 Moshi 对合成数据进行微调后得到的变体,分别对应男声和女声。

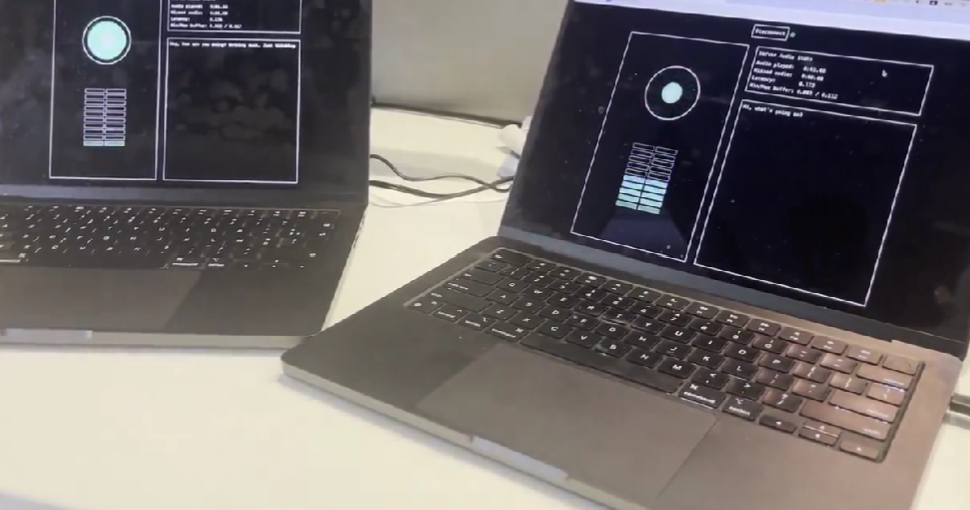

这三款模型还能够实现自我对话,例如:

从图中可以看到,这些模型能够在一台 Macbook 上运行,并且据称在 L4 GPU 上实现了大约 200 毫秒的延迟。

关于变体的内存需求,当使用 bf16、8 位和 4 位精度时,所需的内存分别为 16GB、8GB 和 4GB VRAM。

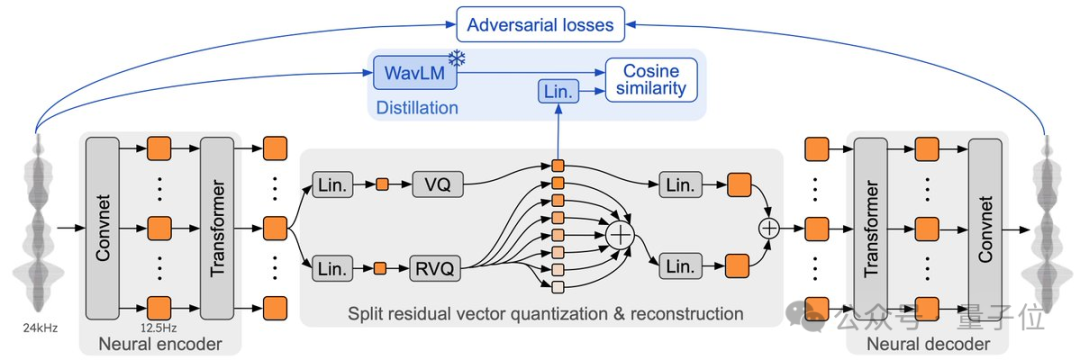

此外,Moshi 使用了一种名为 Mimi 的流式神经音频编解码器,能够处理 24 kHz 的音频(以 1.1 kbps 的速度将 24 kHz 音频压缩到 12.5 Hz),并支持多种预训练模型。

Mimi 受 SpeechTokenizer 启发,通过蒸馏技术联合建模语义和声学信息,并通过对抗性训练提升了性能,专门用于与大型语言模型协同工作。

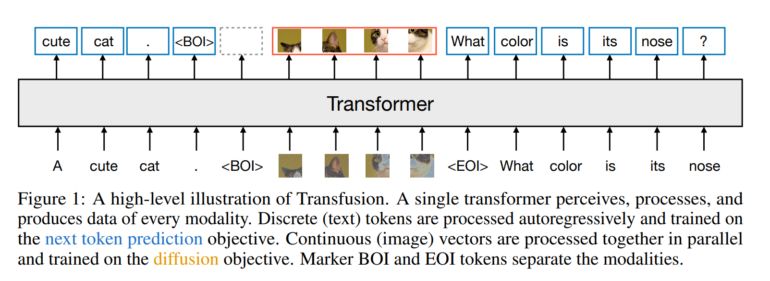

根据官方公布的技术细节,Moshi 项目主要由以下三个组件构成:

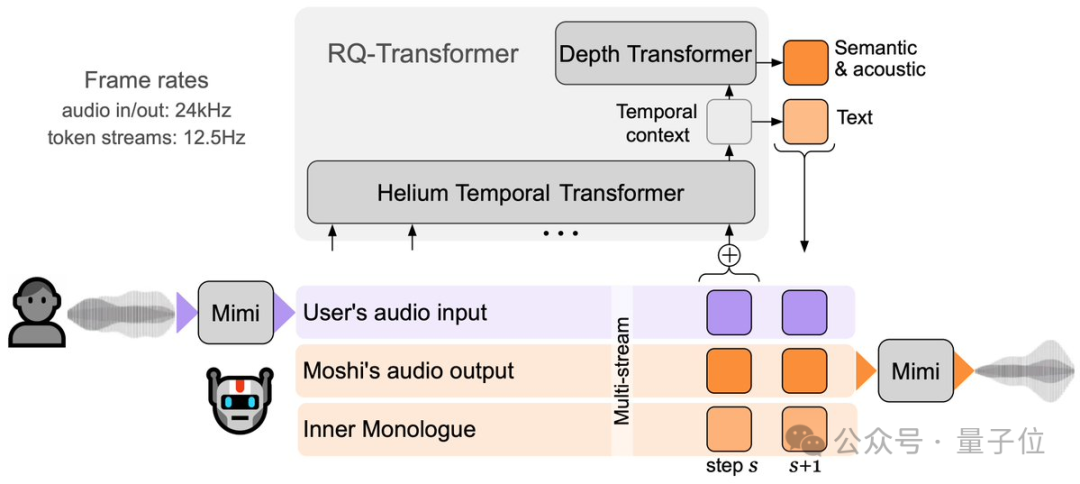

具体来说,Moshi团队对Helium进行了改进,采用了RQ-Transformer的变体架构,这使得Helium可以在不增加序列长度的情况下建模语义和声学标记的层次结构。官方表示,他们在生成音频方面的主要贡献在于多流建模技术(multi-stream modeling)。

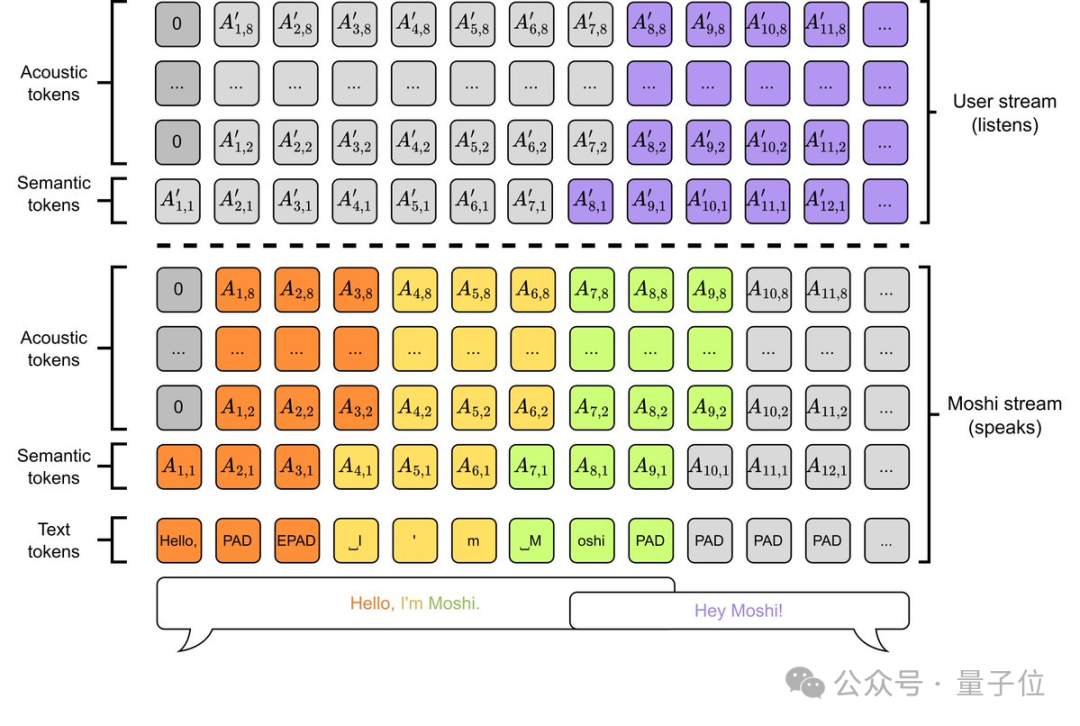

该技术允许在每个时间步骤中堆叠Moshi和用户的tokens,从而模拟全双工对话中的动态变化,包括重叠、反向通道和中断等情况。

此外,还包括一种名为“内心独白”(Inner Monologue)的技术,它通过预测时间对齐的文本进一步提高了生成语音的质量,增强了Moshi的智能性,并保持与流媒体的兼容性。

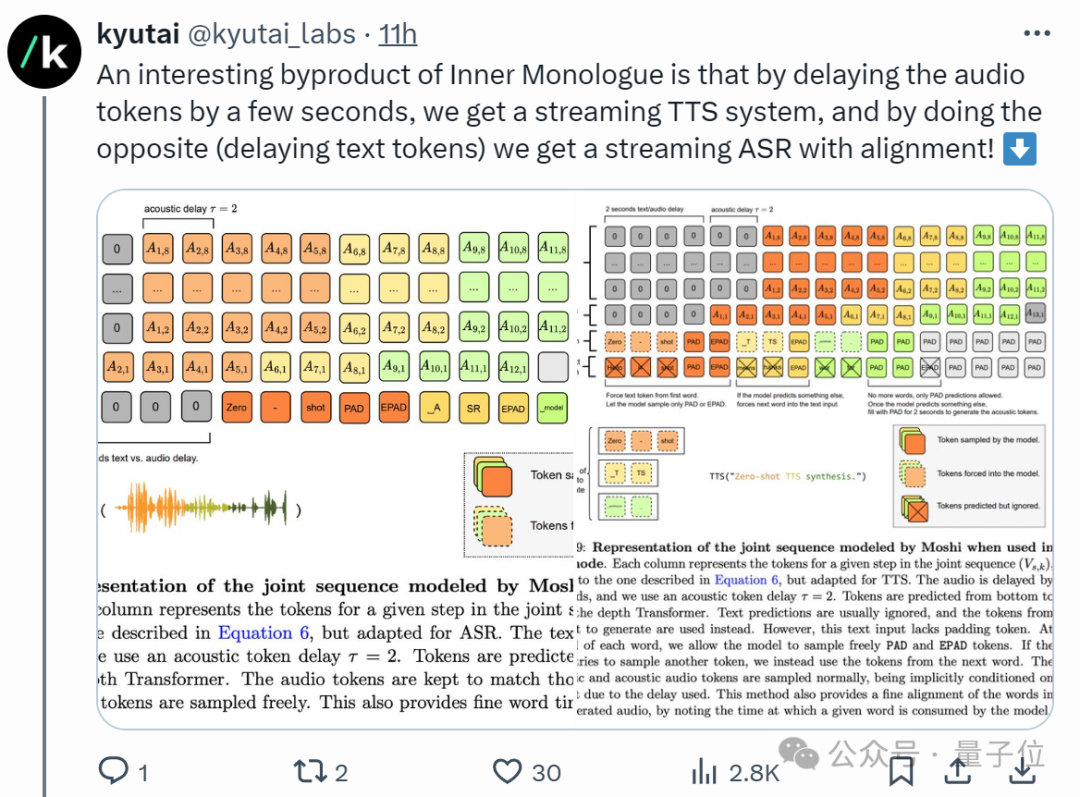

“内心独白”的另一扩展功能是:通过调整音频和文本标记的延迟,Moshi能够实现流式TTS(文本转语音)和ASR(自动语音识别)功能。

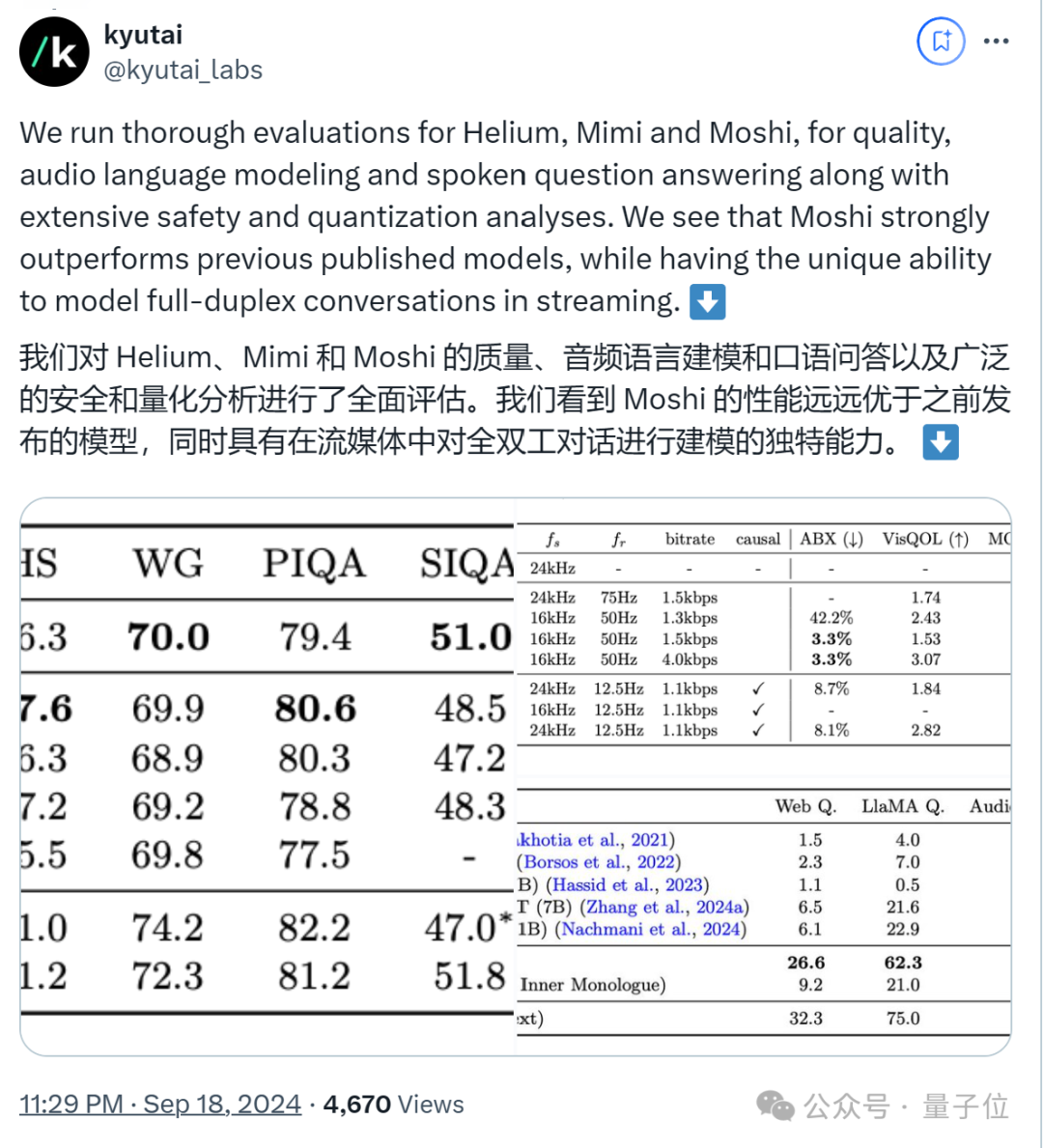

经过大规模音频预训练后,官方利用其模型生成了20,000小时的合成对话数据,用以评估Moshi在质量、音频语言建模和口语问答方面的表现,并进行了安全性和量化分析。

评估结果表明,Moshi的表现优于此前发布的模型。

看到Moshi此次的大规模公开,许多网友不禁想起了OpenAI。

今年7月底,OpenAI推出了高级语音模式,并面向部分Plus用户开放,一些试用示例也随之流出……

例如,让ChatGPT用中文讲话,那浓浓的“外国腔”是怎么回事呢?

再比如,让它尝试一段绕口令,围观的网友都被逗乐了。

一番体验之后,网友们对其充满了期待。

然而,OpenAI的动作似乎有些迟缓,原本计划在秋季时让所有Plus用户都能够使用高级语音模式。但至今仍未有进一步的消息,在相关话题的讨论区里,到处都是用户的抱怨声。

尽管如此,当Moshi发布时,还是有网友调侃道:“开源总是胜利!”

不过,也有消息称OpenAI可能将在9月24日推出高级语音模式。让我们拭目以待吧!

值得一提的是,该项目在GitHub上已经获得了7,600颗星,并且登上了热门榜单的第一位。首次参赛便夺得了冠军。

(注:原文中的图片链接可能无法直接访问,因此未对图片内容进行翻译。)