单图解锁全景视角!北京大学/香港中文大学/腾讯等推出ViewCrafter | 已开源

编辑日期:2024年09月20日

还支持文本生成3D和图像生成3D。

随便给一张图就能从多个角度查看全景?!

不多说,先看看效果。单视角输入的效果如下:

难度升级,接下来是双视角输入,过渡也非常流畅。

以上效果来自ViewCrafter,这是由北京大学、香港中文大学和腾讯等机构的研究人员提出的模型,可以从单张或少量输入图像生成精确且可控制相机视角的新视角视频。

该模型还支持场景级别的文本生成3D、图像生成3D以及稀疏视角重建等多种应用。

目前论文和代码均已开源,并提供了在线Huggingface demo供用户使用。

传统的视角生成方法,如NeRF和3D-GS等技术,有一个共同的问题:

依赖于大量的多视角训练数据。

这限制了它们在只有少量输入图像(无法提供完整的视角或详尽的场景信息)甚至单张输入图像情况下的应用。

同时,传统方法对训练资源的需求较高,并且缺乏泛化能力,这限制了它们在训练资源受限场景下的应用。因此,ViewCrafter的目标是:

从稀疏视角图像甚至单张输入图像中生成任意规模场景的新视角。

这要求模型具备对3D物理世界的全面理解。

接下来,我们来看看具体的实现方法。

总体来说,ViewCrafter是一种基于点云先验的可控视角视频生成方法。

首先,随着快速多视图/单视图立体匹配技术的进步,现在可以从单张或稀疏图像中快速重建点云表征。

点云表征可以提供3D场景的粗略信息,支持精确的相机位置控制,从而实现自由视角渲染。

然而,由于点云的表示能力有限,加上极其稀疏的输入图像只能提供有限的3D线索,导致重建出的点云存在大面积的遮挡和缺失区域,并且可能会遇到几何形变和点云噪声问题。

这些问题限制了其在新视角合成中的应用。

另一方面,在大规模视频数据集上训练的视频扩散模型能够深入理解3D物理世界,支持从单张图像或文本提示中生成符合物理规律和现实世界规则的视频内容。

但是,现有的视频扩散模型缺乏显式的场景3D信息,因此在视频生成过程中难以实现精确的相机视角控制。

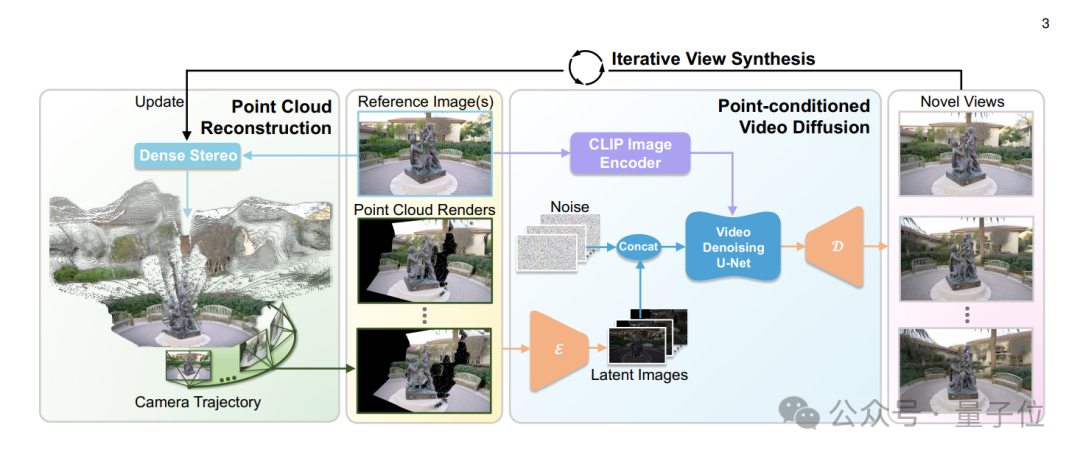

为了解决这些问题,研究团队提出了将视频扩散模型的生成能力与点云表征提供的显式3D先验相结合的方法,以实现高保真度、相机精准可控的新视角视频生成。

具体而言,给定单张或稀疏视角输入图像,团队首先使用快速多视图立体匹配方法构建其点云表征,从而实现精准的相机移动和自由视角渲染。

为了改善点云渲染结果中的大面积缺失、几何失真及点云伪影等问题,研究团队训练了一个以点云渲染结果为引导的视频扩散模型作为增强渲染器。该渲染器可以在粗糙的点云渲染基础上进一步生成高保真度和三维一致的新视角图像。

通过结合点云提供的显式三维信息和视频扩散模型的强大生成能力,此方法能够在视频生成过程中实现六自由度(6DoF)精确的摄像机姿态控制,并生成高保真的新视角视频。

然而,现有的视频扩散模型在生成长视频时面临巨大计算开销的问题,难以处理长视频的生成。为解决这一难题,研究团队采用了一种迭代式的新视角生成策略,并提出了一种内容自适应的摄像机轨迹规划算法,逐步扩展新视角所覆盖的区域及重建的点云。

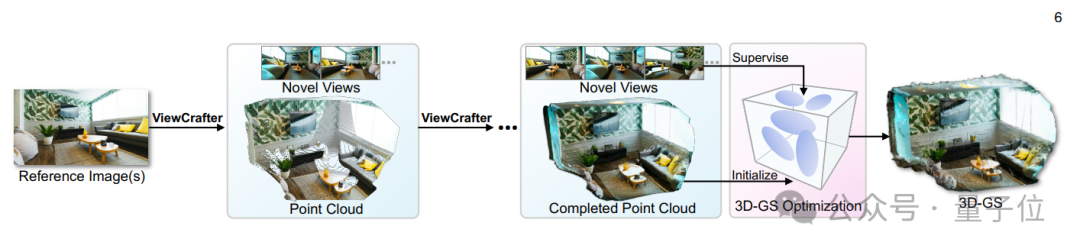

具体而言,从由初始输入图像构建的点云开始,团队首先使用摄像机轨迹规划算法,依据当前点云预测出一段摄像机轨迹,以有效地揭示遮挡和缺失区域。然后,根据预测的轨迹对点云进行渲染,并利用ViewCrafter生成高质量的新视角图像。接下来,用生成的新视角更新点云,以扩展全局点云表示。通过反复执行这些步骤,最终能够获得覆盖广泛视场范围并扩展了点云的高保真新视角图像,并且支持诸如高斯重建等下游任务。

在实际应用方面,借助ViewCrafter和迭代式新视角生成算法,可以从单一图像、稀疏视角甚至一段文本描述中进行三维高斯重建,从而支持实时渲染和沉浸式三维体验。

研究团队还从多个角度对新方法进行了对比分析。在Tanks-and-Temples、CO3D和RealEstate10K三个真实世界数据集上,与现有最佳技术(SOTA)方法进行了定量和定性比较。实验结果表明,ViewCrafter在摄像机姿态控制精度以及生成新视角的视觉质量上均优于对比方法。

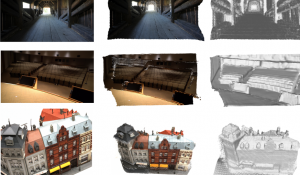

在场景重建领域,研究团队使用Tanks-and-Temples数据集对ViewCrafter与现有稀疏视角重建方法进行了定量和定性的对比分析。

结果显示,ViewCrafter不仅在3D高斯重建中表现优异,在渲染新视角的视觉质量方面也超越了其他方法。

以下是部分3D生成的结果展示。左侧展示了文本提示及对应的图像生成效果,右侧则是最终的3D效果。

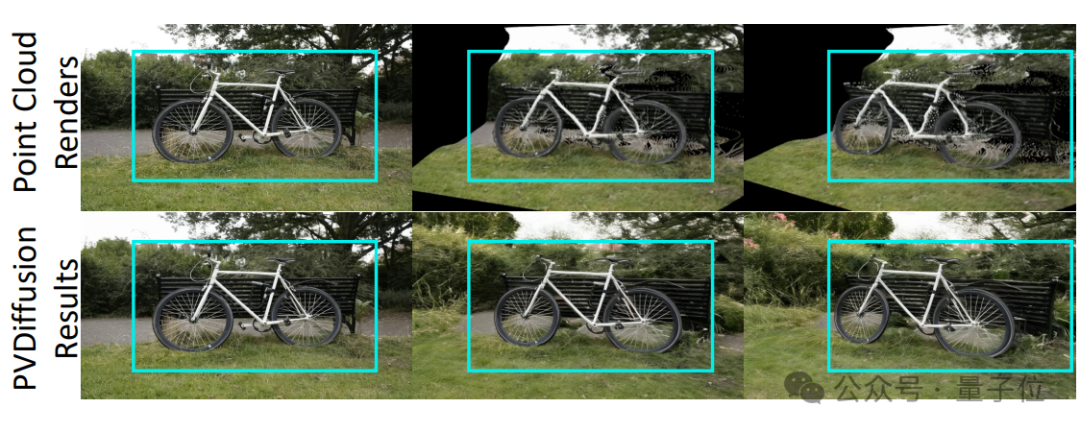

此外,团队还进行了多项消融实验,例如验证点云先验信息作为视频扩散模型控制信号的有效性。相比之下,一些相关工作采用了普吕克坐标作为视频生成模型的控制信号来实现可控的新视角生成。为了验证点云控制信号的优势,团队训练了一个以普吕克坐标为控制信号的新视角生成模型,并确保除控制信号外,该模型的其余结构与ViewCrafter保持一致,进行了控制变量实验。下图展示了两种模型在新视角生成任务上的对比结果。

请注意,原文中的图片链接可能无法直接查看,需要访问指定网址查看完整内容。

实验结果表明,无论是在新视角生成的质量还是在相机控制的精度方面,该团队采用的基于点云的控制信号都优于基于普吕克坐标的控制信号。

此外,该团队还验证了其模型在处理粗糙点云时的鲁棒性。如图所示,即使点云作为控制信号时存在严重的几何变形,模型仍然能够有效地进行几何纠错和空洞修补,证明了新方法在点云控制信号方面的鲁棒性。

总的来说,该团队验证了ViewCrafter在静态场景中新视角生成的强大能力。下一步,团队计划将其与单目视频深度估计方法相结合,实现单目动态视频的新视角生成及4D重建。更多细节请参阅原论文。

即使是无重叠场景也不受影响。

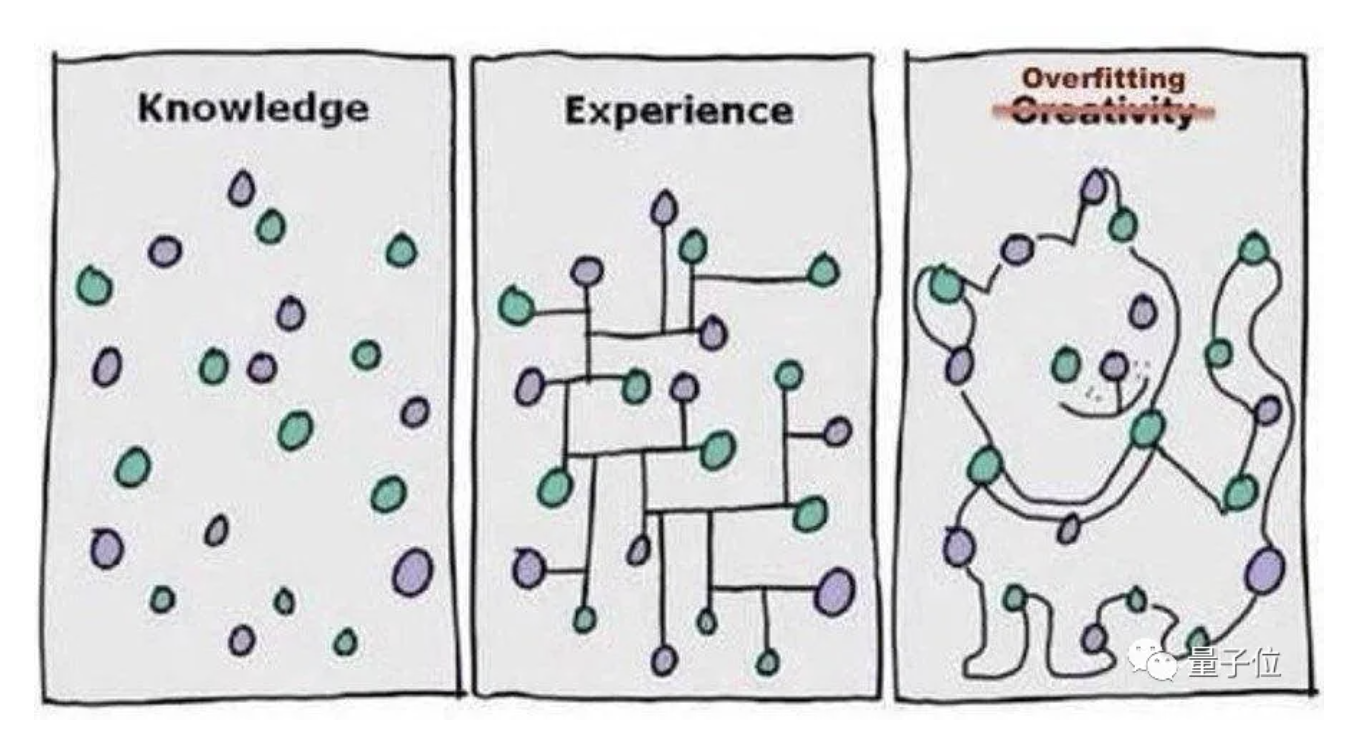

多伦多大学和麦吉尔大学的一项最新研究显示,过拟合在某些情况下也有其独特优势,特别是在重建3D物体外观时,过拟合神经网络表现出色。

这一技术适用于无人驾驶汽车和机器人等多种应用场景。

可直接应用于电影、游戏和VR生产领域。

可直接应用于电影、游戏和VR生产领域。