车圈最大AI“黑马”吉利:自研语音大模型登顶,性能超越SOTA 10%

编辑日期:2024年09月24日

车端拥有8亿参数的语音模型,复刻声音仅需3秒钟的样本。

在语音合成大模型领域,一夜之间出现了新的王者。

最新的HAM-TTS大模型,在发音准确性、自然度和说话人相似度方面,相较于之前的顶级成果VALL-E,实现了显著提升。

而这一突破背后的科研团队,成为了今年LLM赛道上的一匹“黑马”:

吉利汽车。

没错,这并非一家AI原生公司,也不是传统的科技巨头,而是以汽车闻名但在硬科技领域不断展现实力的吉利。

吉利自主研发的语音大模型HAM-TTS,其全称是:

Hierarchical Acoustic Modeling for Token-Based Zero-Shot Text-to-Speech,即基于token的零样本文字转语音分层声学建模。它是星睿AI大模型体系中的重要组成部分。

顾名思义,这项技术对智能座舱体验至关重要,尤其是在“发音”这一关键交互环节。

语音助手的表现通常通过以下几个指标来评价:

- 发音准确度:通过Character Error Rate(CER)评估,具体由知名的端到端语音模型平台ESPNet打分。

- 说话风格的一致性(NMOS)、音调一致性(SMOS)及整体得分(MOS):由研究团队招募的60人团队进行主观评分。

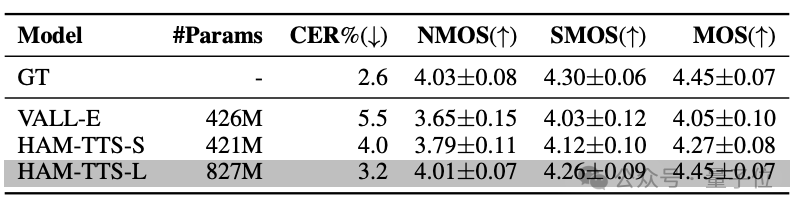

总体而言,在约4亿参数规模下,HAM-TTS模型相比VALL-E模型,字符错误率降低了约1.5%。

完全体8亿参数的HAM-TTS模型,字符错误率则降低了2.3%。

在风格一致性、音调一致性和整体得分方面,HAM-TTS模型提升了大约10%。

吉利:车圈最大AI“黑马” 自研语音大模型

在智能座舱的各种交互场景中,例如联动虚拟形象、自定义人设、语音导航、新闻播报、绘本朗读、讲故事、直播等,这些功能的背后都离不开星睿语音大模型的强大技术支持。

星睿语音大模型具备出色的辨识能力,能够保持说话人的音色稳定性和连贯性,避免音色突变。无论是专业的新闻播报、轻松的段子讲述,还是温馨的绘本阅读,它都能根据特定场景需求,智能调节语气、语调、停顿和情感等多维度参数,为用户提供更加沉浸式、自然且生动的个性化语音交互体验。

此外,该模型支持跨语种无缝切换,无论用户使用何种语言或方言,都能在保持音色一致的前提下,流畅地进行中文或英文的语音合成。系统可以将方言输入直接转换为普通话输出,甚至转换为其他不同方言的输出。目前,星睿语音大模型已支持四川话、粤语、东北话等多种方言合成,并且还支持日韩及东南亚地区的跨语种语音合成。

更重要的是,星睿语音模型在声音复刻方面取得了重大突破,只需3秒钟的样本输入即可完成复刻,远超行业普遍所需的10秒样本要求。这一技术进步极大地提升了用户体验,并展示了其在学术上的重要价值——通过创新的声音合成技术和数据增强策略,显著改善了TTS(Text-to-Speech)模型的性能和训练成本。

TTS模型广泛应用于各种文字转语音的交互应用中,通常遵循“文本处理—提取声学特征—语音合成”的三步流程。前两个步骤采用标准算法,而在语音合成阶段则应用神经网络。例如,VALL-E作为语音合成模型的开山之作,虽然只用了16块V100 GPU进行训练,但其规模约为4亿参数,已经相当可观。

将输入文本直接与语音 token 拼接作为大模型的输入时,由于缺乏足够的语义信息来引导模型,或者说是文本与语音之间未能有效“对齐”,这会导致传统 TTS(Text-to-Speech)模型出现发音准确率低、说话风格和音色不一致等问题。尽管可以通过引入大量的多样化训练数据来解决这些问题,但这会增加研发周期和成本。

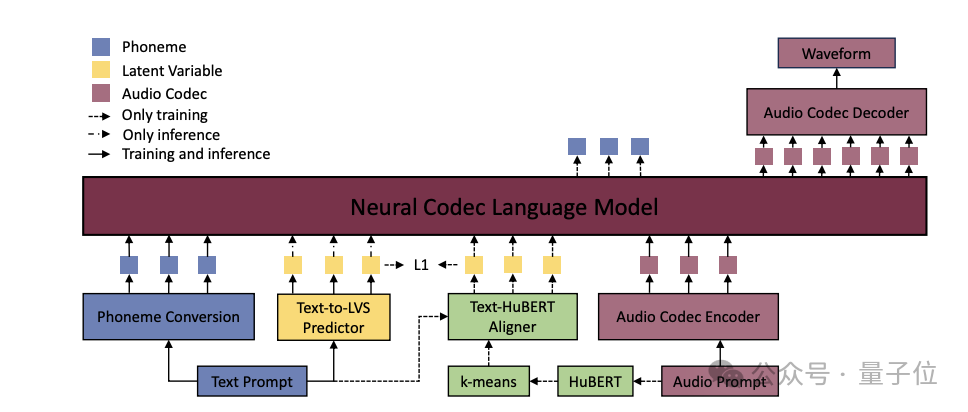

吉利为了解决这个问题,在传统的 TTS 模型结构中引入了一种分层声学建模方法:

具体来说,他们引入了一个 Text-to-LVS predictor(文本到隐空间变量序列预测器),即通过文本预测出包含重要声学信息和语义信息的隐变量,并将其作为补充信息。在推理阶段,这些隐变量信息与文本提示信息一同作为大模型的输入。

这种方法显著改善了合成语音中的发音错误和风格突变问题。此外,在训练过程中,通过替换和复制数据片段,提高了音色的一致性。

在训练阶段,模型中还引入了一个对齐器(Text-HuBERT Aligner),用于生成监督 LVS(Latent Variable Sequence),辅助 Text-to-LVS predictor 的训练。该对齐器将文本(音素)序列与语音的 HuBERT 特征对齐,生成与音素序列长度相同的监督 LVS 序列。

在提取音频特征之后,还引入了 K-means 聚类处理,目的是去除原始音频特征中的说话人个性化信息,使模型更关注语音的共性特征,从而提高模型的泛化能力和合成语音的音色一致性。

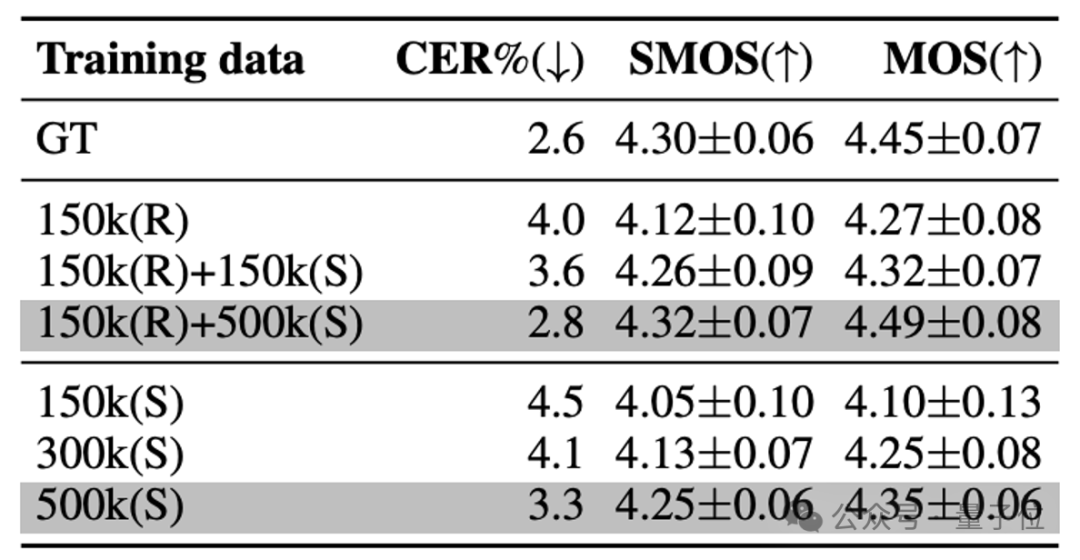

在提高语音合成准确性的同时,团队还采用基于 UNet 架构的声音转换预训练模型,生成大量具有不同音色但内容相同的合成语音数据,以此增加训练数据的多样性和数量,从而提升 TTS 模型的性能和泛化能力。

首先,我们从语音数据中提取HuBERT特征和基频(F0),并将这些特征输入至ResNet模型进行处理。接下来,数据经过编码下采样及解码上采样的过程,最终还原为音频信号。在解码器上采样的每个步骤中,加入目标说话人的嵌入(embedding)特征,从而实现变换说话人的音色而不改变其内容的效果。这种方法一举解决了三个问题:一是缓解了实际数据不足的情况;二是避免了版权和隐私的风险;三是有效地应对了数据稀疏问题(例如罕见的发音、特定口音或语调)。

通过使用不同比例的实际(Real)与合成(Synthetic)数据来训练HAM-TTS模型,实验结果表明,结合实际和合成数据进行训练能够显著提高模型性能。

此前,智能座舱中的corner case(边缘情况)往往被各大厂商忽视,而吉利正通过算法能力提出解决方案,从而提升了智能汽车的“最后一公里”体验。

这一部分的研发工作不仅耗时耗力,而且对技术水平要求极高:

不仅要理解最先进的模型的优势所在,还需要明确其不足之处,并针对这些不足提出改进措施。

对于大多数汽车制造商来说,AI大模型的书可能仅翻开“前言”就感到头疼,而吉利不仅深入研究,还做了“批注”。

更重要的是,论文的主要作者确确实实是吉利的研究人员——星睿语音大模型的“归属权”毋庸置疑。

在“自研”概念不断被重新定义的汽车行业,吉利无疑是一股清流。

沿着这条思路继续探索,可以发现类似的例子还有很多。

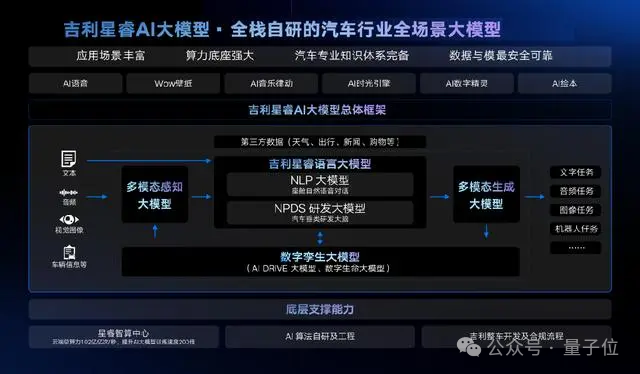

例如,吉利的星睿AI大模型体系包括语言大模型、多模态大模型和数字孪生大模型三大基础模型,进而衍生出NLP语言大模型、NPDS研发大模型、多模态感知大模型、多模态生成大模型、AI DRIVE大模型和数字生命大模型等,构建了整个智能汽车的AI技术基础。

在算力方面,睿智计算中心的云总算力已从去年的每秒81亿亿次提升至每秒102亿亿次。

星睿语音大模型的背后展现了吉利的技术爆发:其算法能力、大规模模型体系能力和数据处理能力均处于行业领先地位,并为行业提供了新的解决方案。

继在电动化领域取得成功后,吉利在智能化领域的这一突破同样令人瞩目。

然而,对于吉利来说,整体布局远不止于此。近年来,除了在汽车业务相关的核心技术上持续投入外,吉利还在更广泛的底层科技领域展现出领军者的风范,尤其是在卫星、芯片和操作系统等核心技术方面的突破,吉利的实力愈发凸显。

是时候重新认识吉利了。

论文地址:https://arxiv.org/abs/2403.05989

大家在看