在北大AI奥数评估中,o1-mini的得分超过了o1-preview。

编辑日期:2024年09月24日

传统数学基准测试已经显得力不从心。

OpenAI 的 o1 系列一经推出,传统的数学评测基准便显得捉襟见肘。

例如,在 MATH-500 数据集上,全功能版的 o1 模型轻松取得了 94.8 分的成绩。

而在更具挑战性的 2024 年美国数学邀请赛 AIME 中,o1 也获得了 83.3% 的准确率。

随着现有数学评测集逐渐被攻克,人们开始好奇:大规模模型是否能够应对更加复杂的数学竞赛,甚至是奥林匹克数学竞赛?

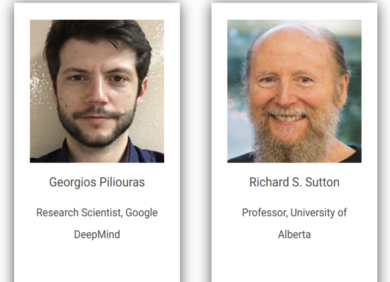

为了解答这一疑问,北京大学与阿里巴巴的研究团队联合开发了一套专门用于数学竞赛的奥林匹克评测基准——Omni-MATH。

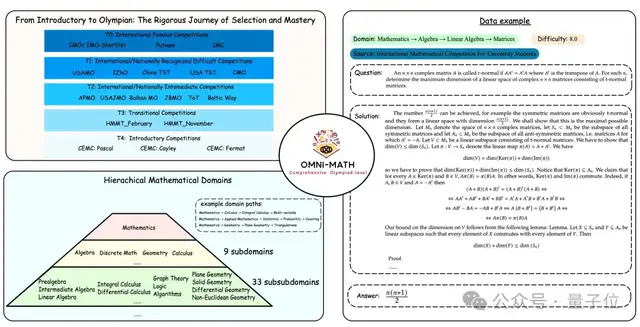

Omni-MATH 专门用于评估大型语言模型在奥林匹克水平的数学推理能力。该评测集收录了 4428 道竞赛级别的题目,这些题目经过精心分类,涵盖了 33 个(或更多)子领域,并分为 10 个不同的难度级别,从而能够对模型在不同数学学科和复杂程度上的表现进行全面分析。

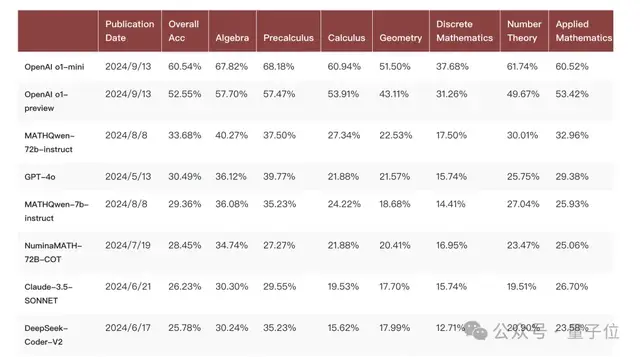

最新排行榜显示,竞争异常激烈:

除了全功能版的 o1 尚未开放 API 外,小型模型 o1-mini 的表现最佳,平均分比 o1-preview 高出约 8%。

开源模型中表现最好的是 Qwen2-MATH-72b,其成绩甚至超过了 GPT-4o。

总体而言,o1-mini 这种专注于少数特定能力、放弃存储广泛世界知识的策略再次得到了验证。

Omni-MATH 作为数学奥林匹克评测基准,具有以下三个特点:

- 人工验证答案的可靠性:4428 道评测题目来源于不同的数学竞赛和论坛数据,人工参与验证答案的准确性;同时,考虑到奥赛题目答案的多样性,提供了基于 GPT4o 和评测模型的评价方式,便于一键启动评测。

清晰合理的难度分级:评测集整体具有较高的挑战性,并且难度跨度很大,涵盖了从奥林匹克预备级别(T4)的CEMC竞赛到最高级别的奥林匹克数学竞赛(T0),如IMO、IMC以及普特南竞赛等。这些比赛不仅要求参赛者具备坚实的数学基础,还需要极强的逻辑推理能力和创造力。数据显示,只有极少数智商接近顶尖的人才能在这些比赛中取得优异成绩。题目类型非常广泛,涵盖了超过33个子领域的数学问题。根据数学领域的特点,团队设计了一个树状的领域分类系统,每个题目涉及一个或多个领域,即多条树的路径,这使我们能够详细分析模型在各种数学学科和难度水平上的表现。

研究团队首先对国内外基本的奥林匹克数学竞赛进行了详细的调研。从中了解到,一个学生从竞赛预备阶段到顶级竞赛,需要经历层层选拔。例如,在英国体系中,学生需要通过JMC → IMC → SMC → BMO 1 → BMO 2 → IMO这一系列选拔(这里的IMC指的是Intermediate Mathematical Challenge,而非国际大学生数学竞赛IMC)。而在美国体系中,则需经过AMC 8 → AMC 10 → AMC 12 → AIME → USA(J)MO → IMO这一整套选拔体系。

这启发了团队是否也能为模型评测设置类似的难度层级。因此,研究团队调研了世界范围内不同难度层级的比赛,确保Omni-MATH在奥林匹克级别的数学测试中,依然保持多样化的难度层次。

在奥林匹克级别的数学测试中,实际上涉及的数学领域非常广泛。研究团队在模型训练过程中,考虑了不同领域数据之间可能产生的协同效应,例如领域A的数据是否能够帮助模型在领域B上的表现提升。这种跨领域的数据工程具有重要意义。为此,研究人员参照了相关的竞赛辅导书籍,对评测集中的数据进行了详细的领域划分,从大的数学类别如数论、代数、几何等,细化到具体的子领域或知识点。

评测集数据主要来源于两方面:一是各类比赛的题目及其解答;二是著名的数学网站Art of Problem Solving (AoPS)。对于所需的比赛,优先从题解中获取答案。如果所需比赛未公开题解,则从AoPS网站的论坛上抓取用户的回复。由于这些回复由真实用户撰写,可能存在错误,因此需要严格筛选。研究团队选择了AoPS网站上候选题目中答案规整且数量超过3个的题目,并进一步选取了3个答案完全一致的题目作为最终标准。在筛选过程中采用了人工审核,以确保准确性。

数据处理方面:

在获取到PDF格式的题解后,开发人员使用Mathpix将其转换为LaTeX格式。对于论坛上的答案,首先通过GPT-4进行格式化处理,然后手动检查其与原问题答案的一致性。对于这两类来源的数据,团队成员最终都进行了人工核对,确保信息准确无误。

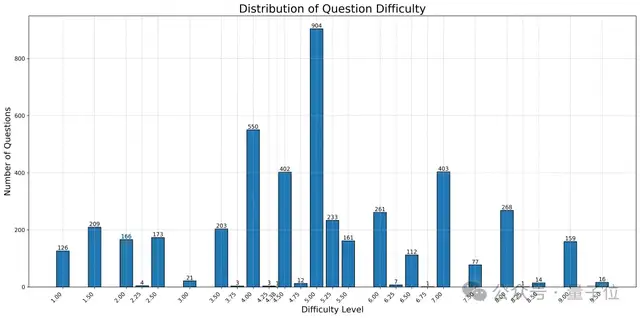

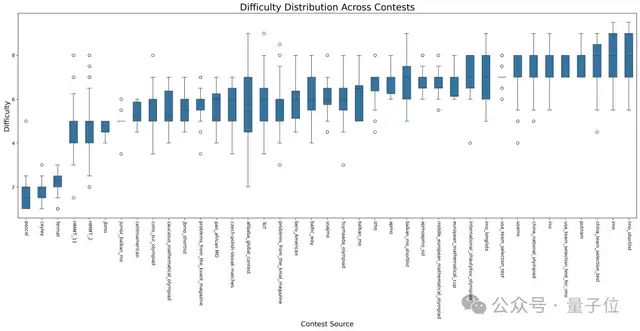

难度分类方面:

参考了AoPS网站上的题目难度分类。具体来说,不同级别的比赛题目难度差异显著,例如CEMC和IMO之间的题目难度相差很大。即使在同一场比赛中,不同题目的难度也有所不同,如一次IMO比赛中既包含简单题也包含难题。因此,评测集的难度分类严格按照AoPS网站上提供的每道题的难度系数(通常在1到10之间,多数为整数,少数为.5或.25)。

对于网站上未涵盖的内容,团队成员将网页上的信息整理成 few-shot prompt,并使用 GPT-4 进行了题目难度标注。整体难度分布及不同比赛题目的分布如下图所示:

领域分类

与传统数学测试基准分类不同,奥数题目在这一难度级别上涉及的领域更多,知识面更广。

为了更好地组织和统一奥数题目,并进一步探索数学领域之间的数据关系,团队构建了一个更为全面的树状分类体系。研究团队参考了相关竞赛教辅书,将奥数相关领域分为几何、代数、数论、应用数学等,并从这些领域出发,进一步细分出各个子领域和具体知识点。

这种树状分类体系有助于理解不同题目之间的关系,以及模型在不同领域上的表现。团队将这一树状分类体系作为模板,并结合竞赛辅导书中的实例,构建了 few-shot 的提示(具体的树状结构和提示内容可参考文章末尾的代码仓库)。

随后,团队利用 GPT-4 给每道题目分类到一个或多个类别中。

开源的答案验证器

Omni-Judge 是通过微调 Llama3-Instruct 得到的验证器,用于验证待测答案与给定答案的一致性。由于数学奥赛级别的题目回答种类非常丰富,用规则进行评测实际上非常困难。在获得模型预测后,需要判断模型的输出是否与标准答案一致。除了使用 GPT-4 评测外,我们还提供了一种更简便的评测方法,利用 GPT-4 评测模型时生成的 COT 数据微调 Llama3-Instruct,得到了一个开源的验证器,其评测一致性高达 95%。

参考链接

(请补充具体链接)

项目页面:https://omni-math.github.io/ GitHub:https://github.com/KbsdJames/Omni-MATH/ 数据集:https://huggingface.co/datasets/KbsdJames/Omni-MATH/ Omni-Judge:https://huggingface.co/KbsdJames/Omni-Judge/

在北大AI奥数评估中,o1-mini的成绩如下:

- 史上第四位获此殊荣的华人数学家

- 还构建了专有的检索数据集

- 论机器人想在杭州当志愿者的努力程度

- 最新高校就业报告出炉

- 一箪食、一瓢饮,也可以成为大神

- 仅靠提示词即可实现

(注:原文中的图片链接似乎重复了,这里只保留了一次描述。)