Meta版慢思考来了!田渊栋团队将快慢思考结合,实现了走迷宫和推箱子的功能。

编辑日期:2024年10月17日

性能提升但推理成本更低

Meta 版慢思考也来了。

田渊栋团队带来了新作 Dualformer,将快慢思考无缝结合,不仅提升了性能,还降低了成本。

该模型能够解决迷宫、推箱子等复杂问题。

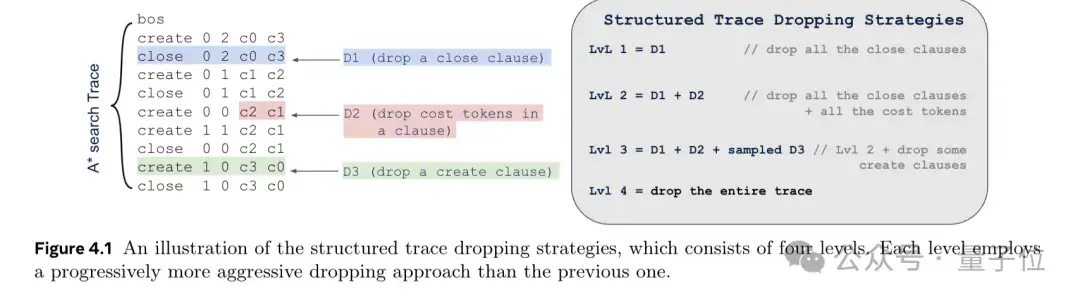

通过让模型在推理轨迹和最终答案上进行训练,再基于特定策略丢弃部分轨迹,Dualformer 模型能够在模仿慢思考的同时,像快思考一样走捷径。

这样可以形成更简洁的思维链(CoT)。

从结果来看,在慢思考模式下,Dualformer 的最优解率达到 97.6%,推理步骤减少了 45.5%。

在自动切换快慢思考模式下,最优解率也达到了 96.6%,且推理步骤减少了 59.9%。

O1 带火了系统 2(慢思考),使大模型的推理能力大幅提升。

然而,随之而来的计算成本更高。

Dualformer 能很好地结合快慢思考,从而缓解这一问题。

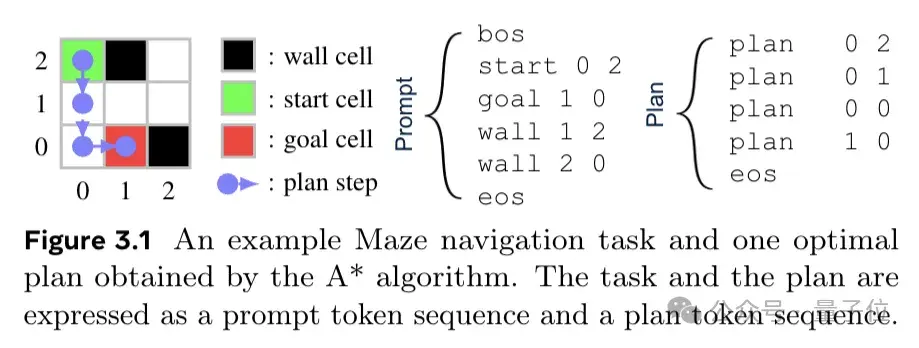

它建立在 Searchformer 这项工作的基础上。Searchformer 是一个可以解决复杂推理任务的模型,基于 A* 搜索算法生成的路径进行训练,在路径规划任务(如迷宫、推箱子游戏)上表现出色,能够以更高的效率找到最优解。

研究发现,人类在思考过程中倾向于寻找捷径。为了更好地模拟人类,Dualformer 在随机推理轨迹数据上进行训练,并在训练过程中根据定制的丢弃策略丢弃部分结构。

例如,在处理路径规划任务时,根据搜索轨迹中的不同子句(如 close 子句、子句中的 cost tokens、create 子句等)设计了四个级别的丢弃策略,从只丢弃 close 子句到丢弃整个轨迹,并在训练时随机选择应用这些策略。

基于这些策略,Dualformer 能够学习更加简洁有效的搜索和推理过程。

在推理阶段,Dualformer 可以配置为快速模式(仅输出解决方案)、慢速模式(输出推理链和最终解决方案)或自动模式(自行决定推理模式)。

这种灵活的推理模式设计使模型能够根据不同任务需求和场景进行自适应调整,类似于人类在不同情况下做出决策的方式。

在具体任务中,研究人员设置了迷宫(Maze)和推箱子游戏(Sokoban),让模型进行路径规划,以及数学推理任务。

对比来看,在迷宫任务中,o1-preview 和 o1-mini 模型输出的路径效果不佳,会出现“穿墙”的情况。

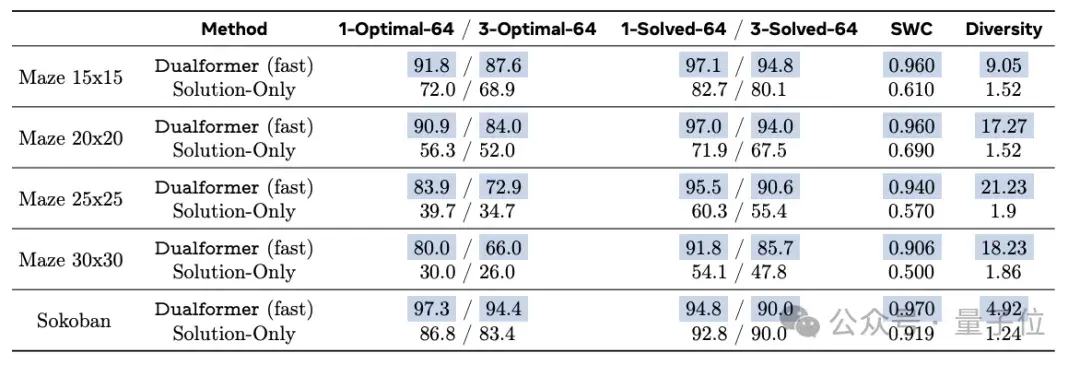

在快思考模式下,Dualformer 的表现如下:

Dualformer 以 80% 的最优率完成了这些任务,显著优于仅基于解决方案数据训练的 Solution-Only 模型,后者的最优率仅为 30%。

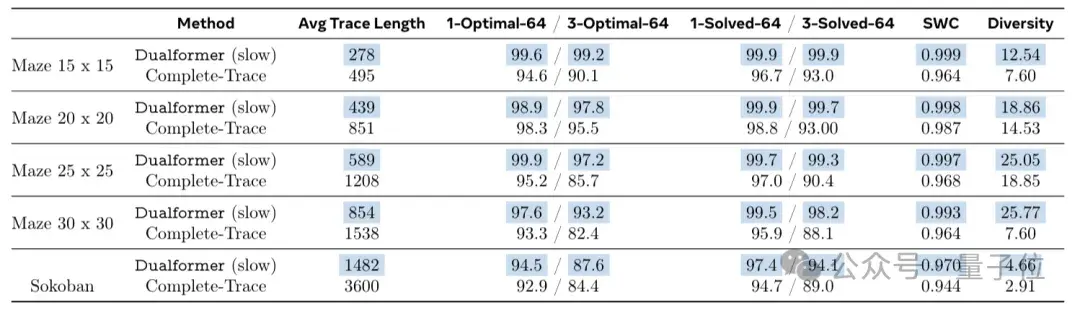

在慢思考模式下,Dualformer 的表现如下:

在 30×30 迷宫任务中,Dualformer 在 97.6% 的情况下达到了最优解,同时推理步骤减少了 45.5%。

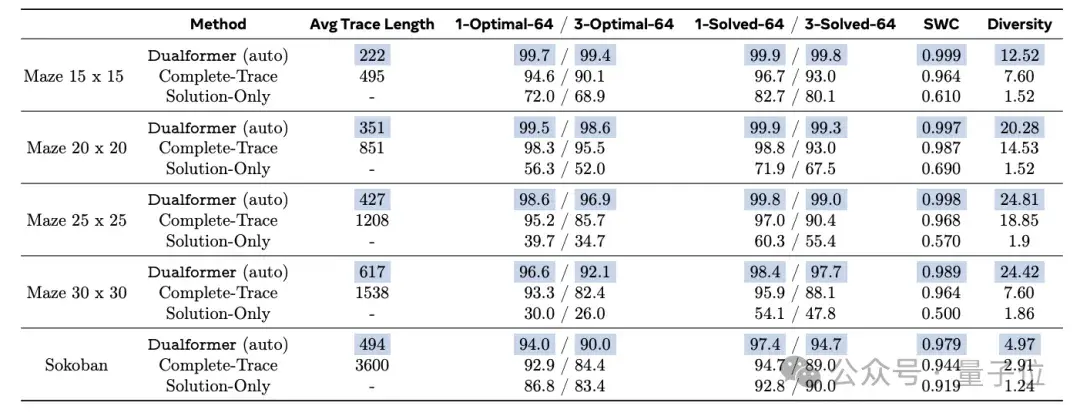

在自动切换快慢思考模式下,Dualformer 的最优率达到 96.6%,与 Searchformer 相比,推理步骤减少了 59.9%。

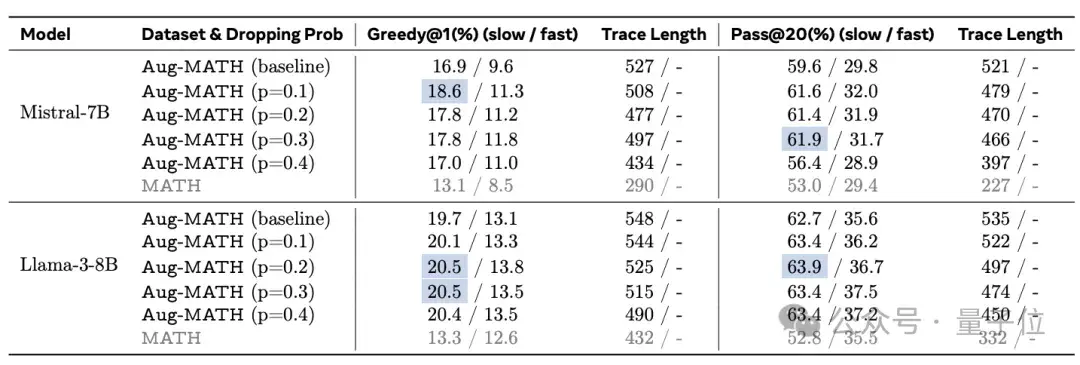

该方法被应用于Mistral-7B和Llama3-8B模型上,在Aug-MATH数据集上的表现均有提升。

该方法被应用于Mistral-7B和Llama3-8B模型上,在Aug-MATH数据集上的表现均有提升。

例如,在Mistral-7B模型中,当p值为0.1、0.2和0.3时,Pass@20指标的基线模型绝对正确率提升至61.9%。

接下来,让我们看看研究团队的阵容。

这项研究由田渊栋等人主导。

田渊栋目前是Meta FAIR的研究科学家主任,领导着大型语言模型(LLM)推理、规划与决策小组。

秦晴郑是FAIR的一名工程师,专注于生成模型和强化学习的研究。她本科毕业于浙江大学,并在芝加哥大学攻读博士学位。2017年至2019年间,她在Facebook担任研究科学家,协助构建了Facebook广告推荐模型的分布式训练系统。

萨因巴亚尔·苏赫巴塔尔是FAIR的研究科学家,主要研究大型模型的推理和记忆。他曾先后在谷歌、DeepMind和Meta工作。

迈克尔·拉巴特是FAIR的创始成员之一。加入Meta之前,他是麦吉尔大学计算机工程系的教授,研究领域涵盖机器学习、分布式算法和信号处理等。

以下是根据提供的内容重新编写的中文文本:

Meta版慢思考来了!田渊栋团队将快慢思维引入AI

论文地址:https://arxiv.org/pdf/2410.09918

该研究包含了数十种不同的角色设定,旨在探索不同思维模式下的AI表现。项目所使用的计算资源总计相当于60万块NVIDIA H100 GPU的算力。

今天是10月11日星期二,该项目已上线在线演示版本,供公众体验和测试。

此外,该项目的管理委员会成员包括Meta、AMD、AWS、谷歌云、微软和英伟达等科技巨头。同时,还有两个相关的AI项目正在取得进展。

希望这个版本能够满足您的需求。如果有任何进一步的修改或补充,请随时告知!