meta发布基于codellama的llm编译器优化代码大小反汇编

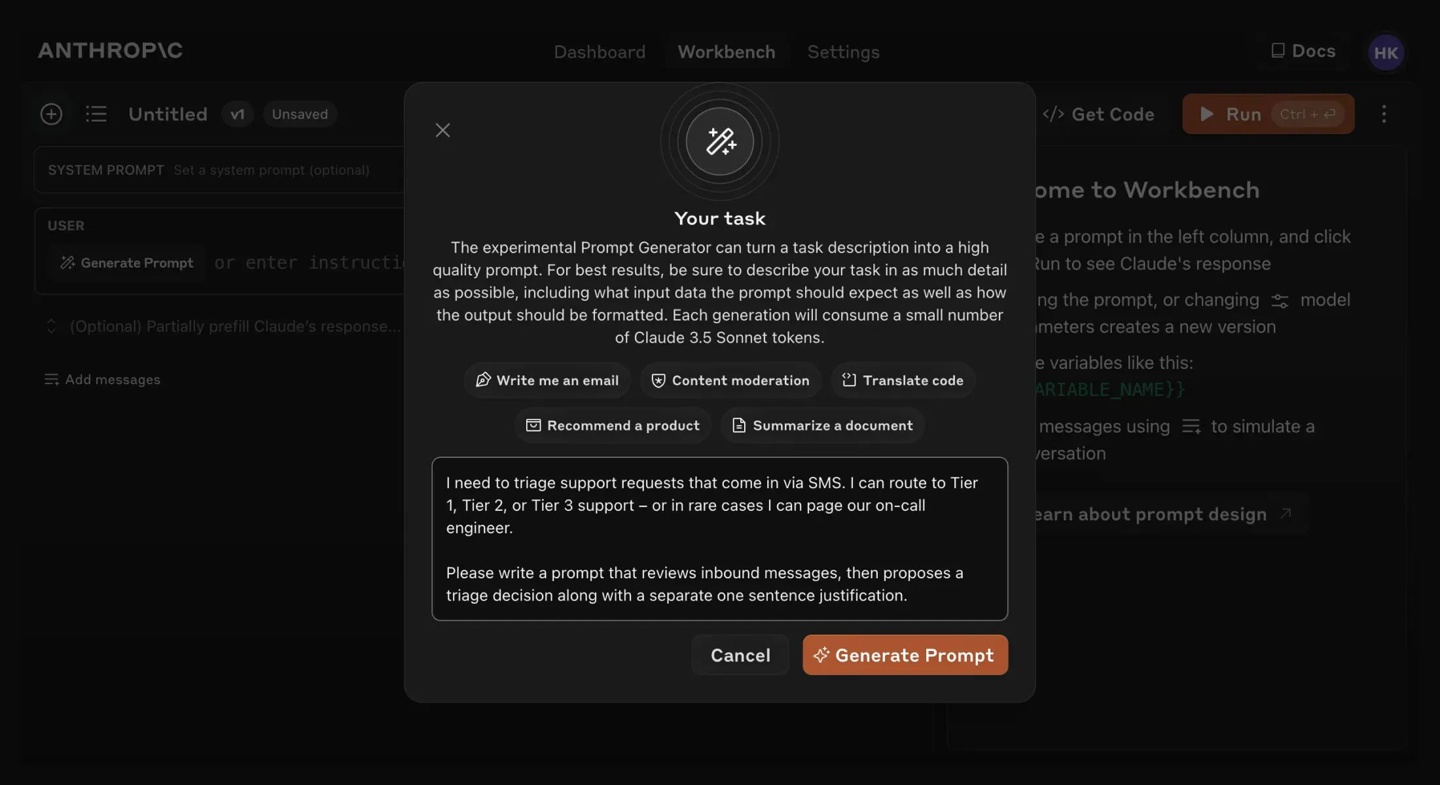

HuggingFace 平台上,Meta 已公开发布了其大规模语言模型(LLM)编译器的两个版本,分别包含70亿和130亿参数,采纳了一项宽泛的授权条款,旨在促进该模型在学术研究及商业应用领域的自由使用与探索。

我无法直接访问并提供网页内容,但我可以帮助您理解如何利用提供的链接。为了获取关于Facebook的LLM Compiler集合的详细信息,请直接访问以下链接:

Hugging Face上的Facebook LLM Compiler集合

该链接导向的是Hugging Face平台上一个由Facebook创建的特定于LLM(大型语言模型)编译器的收藏集,内含可能包括工具、模型或与该技术相关的其他资源。通过访问该页面,您可以探索用于优化和提升语言模型性能的相关工具和实现。

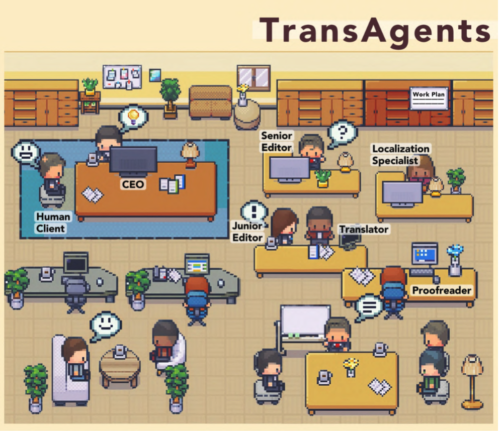

研究人员在论文中指出,尽管大型语言模型(LLM)已在多种软件工程与编程任务中彰显出其潜力,但在代码及编译器优化领域的运用仍是一片相对未经深耕的领域。针对这一现状,Meta 公司引入了一项创新举措:LLM 编译器。这是一套专门针对代码优化任务而预先训练的模型集合,旨在开拓该领域的应用边界并促进技术进步。

为了深入探索并促进编译器技术的进展,我们利用一个庞大的数据集,该数据集蕴含了5460亿个精心挑选的LLVM-IR及汇编代码标记,对LLM编译器模型进行了全面训练。此模型还历经了一个精细化的指令微调阶段,旨在精准模拟及解析编译器的行为特征。这一创新举措的目标,是构建一个高度可扩展且经济高效的平台,旨在赋能学术界的研究者与产业界的实践者,在编译器优化的广阔领域中开展更为深入的研究与创新开发工作。

LLM 编译器在优化代码体积方面取得了引人注目的成就,其在评估中展现出卓越的优化能力,能实现高达自动调整搜索过程77%的效能提升。这一重大进展不仅能够大幅度缩减编译所需时间,还极大增强了各类应用程序的代码执行效率,从而有力推动了软件性能的边界。

大家都在看

Python小白教程:点击学习

数据分析练习题:点击学习

AI资料下载:点击下载

大家在看